卷积神经网络发展演进(一)

今天,我来给大家介绍一下,六种卷积神经网络,分别是:LeNet5、AlexNet、VGG、GooLeNet、ResNet和DenseNet,它们是从初期依次向前发展,它们其中一些获得ImageNet挑战赛的冠亚军。

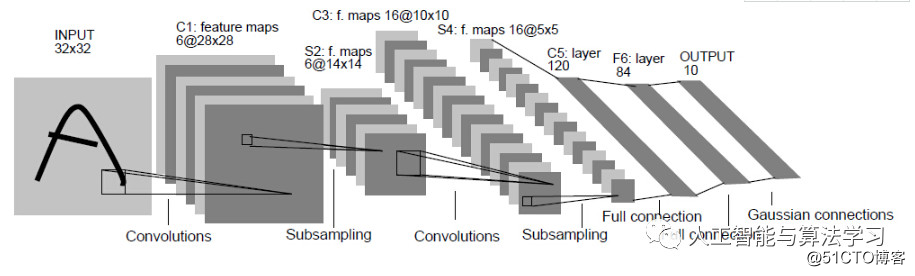

如图所示,LeNet的网络结构

LeNet最早是由深度学习之父Yann LeCun提出的,它是由输入层、卷积层、激活层、下采样层、全连接层组成的,主要用于解决手写数字识别视觉任务。

以上图为例,对经典的LeNet-5做深入分析:

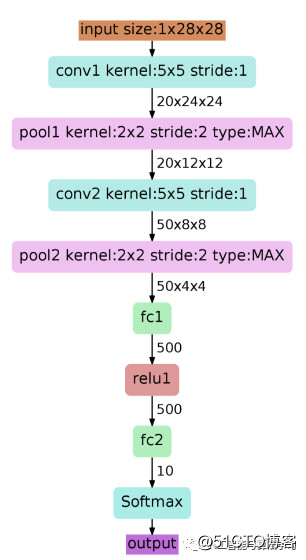

首先输入图像是单通道的28*28大小的图像,用矩阵表示就是[1,28,28]

第一个卷积层conv1所用的卷积核尺寸为5*5,滑动步长为1,卷积核数目为20,那么经过该层后图像尺寸变为24,28-5+1=24,输出矩阵为[20,24,24]。

第一个池化层pool核尺寸为2*2,步长2,这是没有重叠的max pooling,池化操作后,图像尺寸减半,变为12×12,输出矩阵为[20,12,12]。

第二个卷积层conv2的卷积核尺寸为5*5,步长1,卷积核数目为50,卷积后图像尺寸变为8,这是因为12-5+1=8,输出矩阵为[50,8,8].

第二个池化层pool2核尺寸为2*2,步长2,这是没有重叠的max pooling,池化操作后,图像尺寸减半,变为4×4,输出矩阵为[50,4,4]。

pool2后面接全连接层fc1,神经元数目为500,再接relu激活函数。

再接fc2,神经元个数为10,得到10维的特征向量,用于10个数字的分类训练,送入softmaxt分类,得到分类结果的概率output。

此后CNN没有新的突破,沉寂十多年,直到2012年在ImageNet 挑战赛上,AlexNet获得当年的冠军。

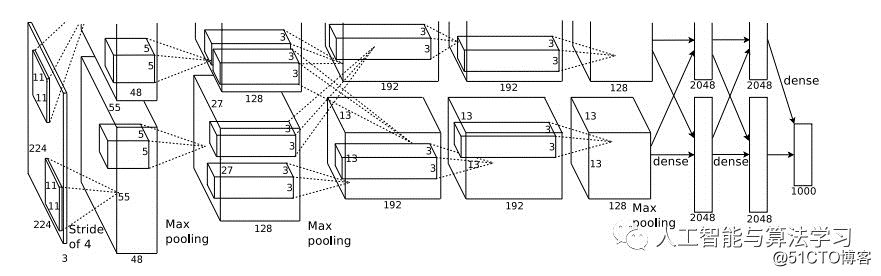

AlexNet的网络结构,如图所示:

相比原来它的优点:

使用ReLU非线性激活函数:克服梯度消失,提高训练的速度。

局部相应归一化LRN:提高精度。

数据增益和dropout:减少过拟合。

什么是梯度消失?

在神经网络中,当前面隐藏层的学习速率低于后面隐藏层的学习速率,即随着隐藏层数目的增加,分类准确率反而下降了。

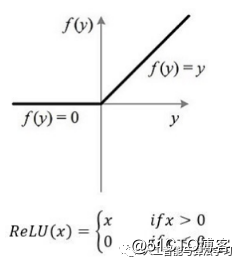

关于Relu的图像,relu函数表达式是f(x)=max(x,0)

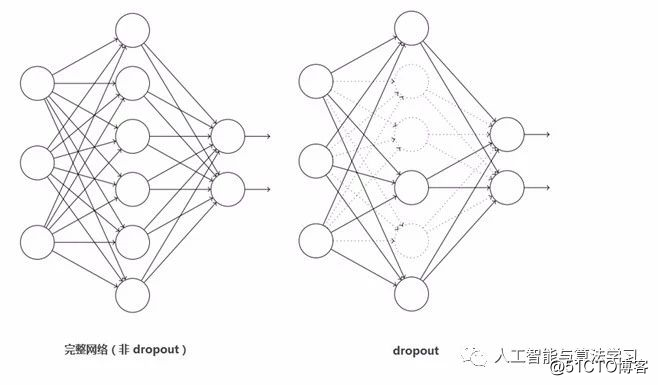

关于Dropout是怎样减少过拟合的?

它的做法是在训练过程中按一定比例(比例参数可设置)随机忽略或屏蔽一些神经元。这些神经元被随机“抛弃”,也就是说它们正向传播过程中对于对于下游神经元的贡献效果暂时消失了,反向传播时该神经元也不会有任何权重的更新。

喜欢记得来一个