- 《Deep Face Recognition with Center Invariant Loss》

2017,Yue Wu et al. Center Invariant Loss

引言:

在大多数人脸数据集中,大部分人脸图像很少,只有少数人经常出现更多的面部图像。人脸图像越多,对特征学习的影响就越大。这种不均衡的分布导致很难训练一个CNN模型来表示每个人的特征,而不是主要针对拥有大量人脸图像的人。

为了解决这一挑战,我们提出了一个center invariant loss,它使每个人的中心对齐,以强制学习到的特征具有针对所有人的一般表示。center invariant loss惩罚每个类中心之间的差异。利用center invariant loss,我们可以训练一个鲁棒的CNN,它平等地对待每个类,而不管类样本的数量如何。大量实验证明了该方法的有效性。并在LFW和YTF数据集上取得了最先进的结果。

下图为:训练数据的长尾分布(long-tail):

(a)为CASIA-WebFace数据的分布情况

(b)在训练数据较为平衡的情况下,分类器学习的决策边界

©在训练数据不平衡的情况下,分类器学习的决策边界

中心不变损失:惩罚每个类中心的L2范数和所有中心的平均L2范数之间的差。

本文的主要贡献:

1.本文提出了一种新的损失函数,即中心不变损失函数(center invariant loss),通过惩罚大类与小类之间的差异来提高深层学习特征的泛化能力。

2.我们验证中心不变性损失可以帮助深度学习的特征在训练数据极不平衡的情况下对所有类别均等地分离特征空间,提高分类性能。

3.我们的结果表明,用CASIAWebFace训练的单个模型达到最新的性能,LFW达到99.12%,YTF达到93.88%。

Imbalanced Data Phenomenon:

首先证明了训练样本多的类别,Softmax训练后特征区域会更大,这就是训练集类别不均衡导致的分类倾向问题。

center invariant loss:

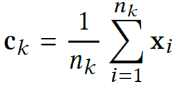

式中,m代表类别数;k表示第k个类别(

),

代表样本数;

表示第i类的特征。

则,第k类的特征中心为

:

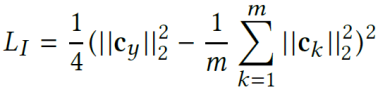

标签为y的第i个样本的Center invariant loss为:

这个公式惩罚了每个类中心之间的差异。中心在特征空间中的不同位置分布。中心不变损失的目的是使这些中心具有相同的欧氏范数。

中心不变损失的2D图解:

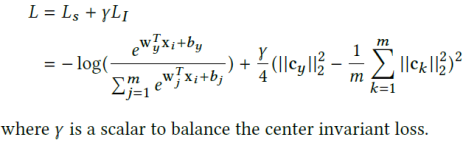

Softmax loss和center invariant loss的联合表示为:

softmax loss产生鉴别特征,center invariant loss迫使特征空间统一分离,具有良好的泛化能力。

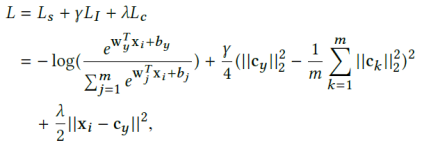

Center Loss和center invariant loss的联合表示为:

除了Center loss每个类都拉向类别中心,额外约束每个类的类别中心都拉向一个固定半径的超球上,这个半径是所有类别中心的模均值,减轻类别不均衡带来的特征区域差异。

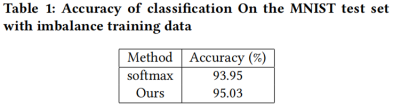

实验结果:

1.在MNIST数据集

Center Invariant Loss训练后的特征分布情况:

减轻类别不均衡带来的特征区域差异

2.在LFW 和YTF 数据集

baseline A :仅使用softmax loss

baseline B :使用softmax loss+center loss 联合约束

总结:

本文首先证明了训练样本多的类别,Softmax训练后特征区域会更大,这就是训练集类别不均衡导致的分类倾向问题,并提出了Center invariant loss,来联合Softmax + Center loss一起使用,减轻类别不均衡带来的特征区域差异。