EKL 基于filebeat搭建日志管理平台(一)

EKL=elasticsearch+logstash+kibana 由三个中间件组成,这篇文章主要讲的是搭建和应用,其他背景和理论放到别的篇幅再讲

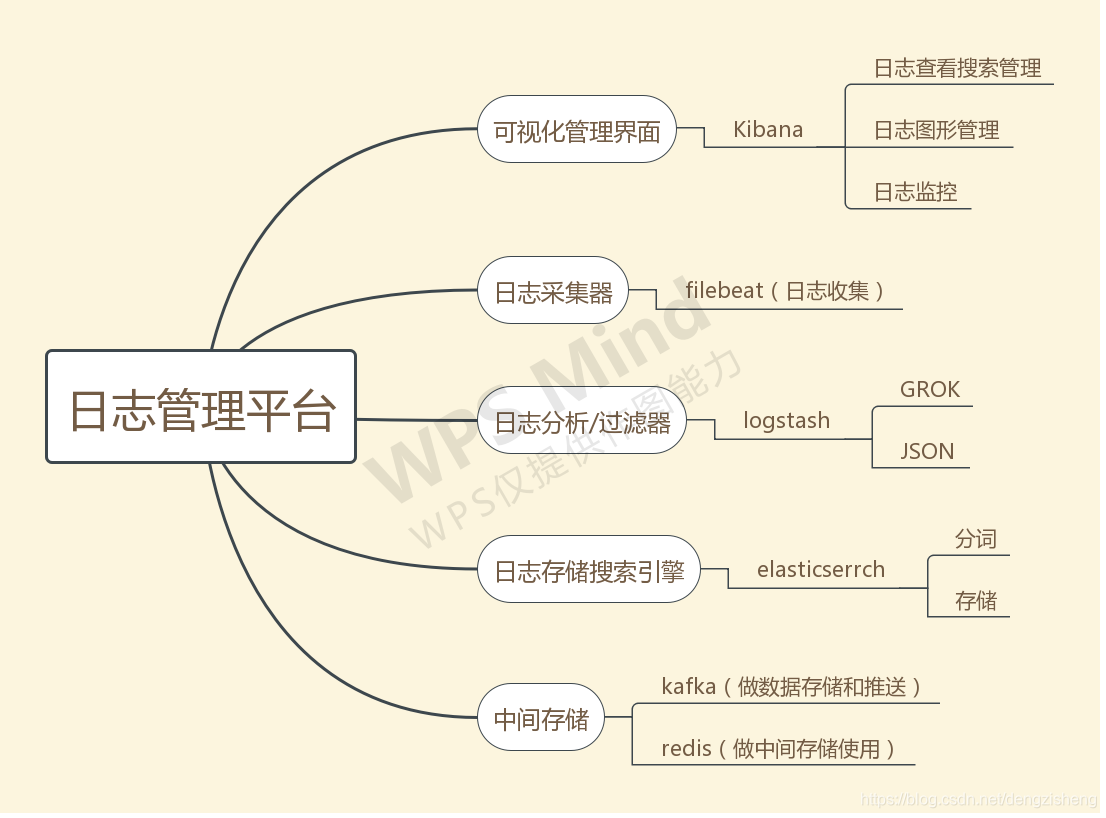

思维脑图

从思维导图我们很容易清楚的知道,如果我们想要一个可以统一管理不同机器的不同类型日志的平台,我们需要哪些准备和工具。

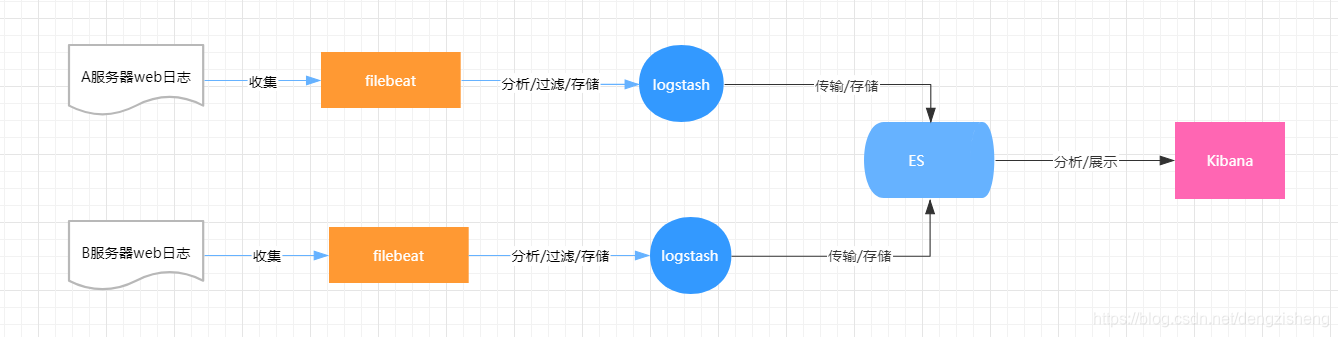

搭建架构图

比较简单的架构图:这边所有的日志都会通过filebeat收集传输到logstash做分析过滤,在传输到ES;这边会有一个问题,如果采集的日志非常大,类型非常多,有可能造成日志丢失或者混乱,对服务器的性能影响会很大。

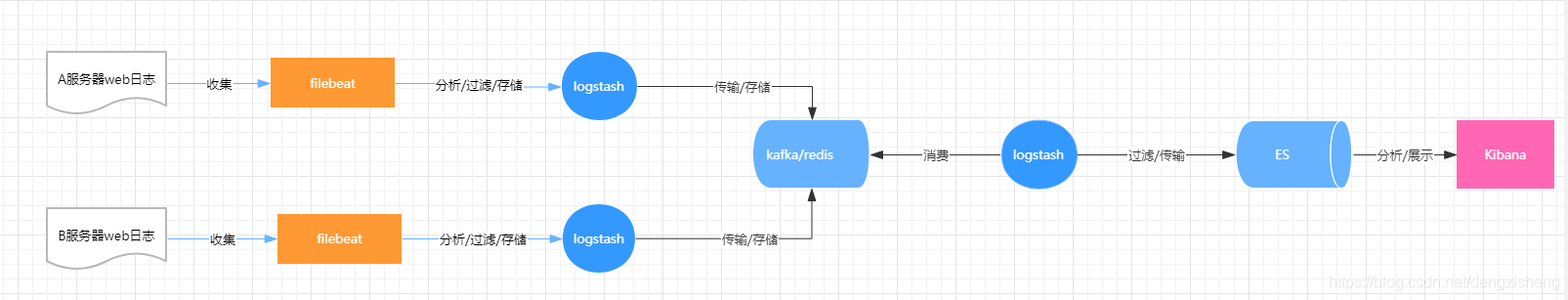

比较完整可靠的架构图:这边解决的问题就是:logstash收集日志后使用kafka或者redis做数据缓冲存储,再增加一个logstash做kafka的消费者用,负责日志的过滤和分析。这样不仅解决了性能上的问题,还很好的降低了耦合,遇到性能瓶颈问题的时候,可以再不同节点做弹性扩展。

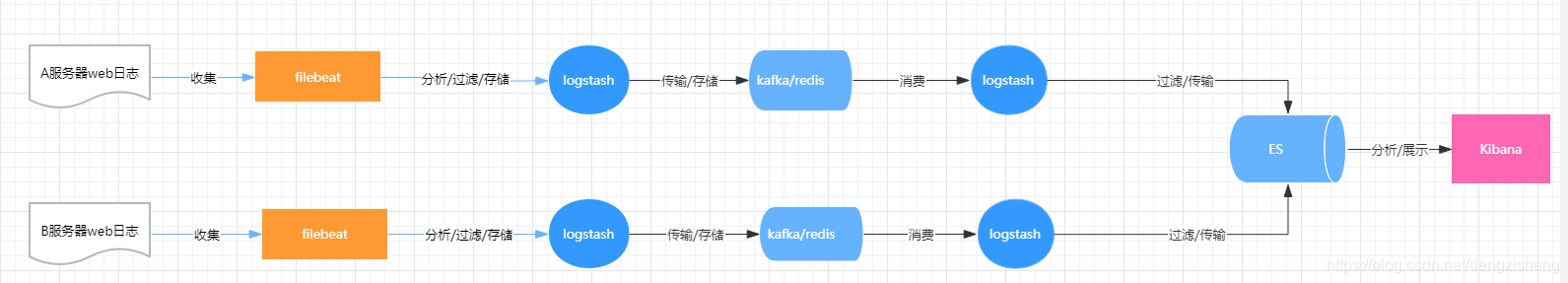

针对更复杂数据更加庞大对性能要求更高的场景,亦可以对上面的架构做进一步的优化:这边扩展了kafka/redis的节点,保证了kafka/redis的高可用和服务能力。

总结:我们通过logstah提供大强大语法(GORK),可以定义出我们实际的业务产景需要的日志。Kibana不仅提供了极其友好的可视化界面和快速查询,我们还可以学习ES的查询语法,来自定义查询,对排查线上问题和日志分析具有很大的意义。

下章将会介绍具体的安装和实践。