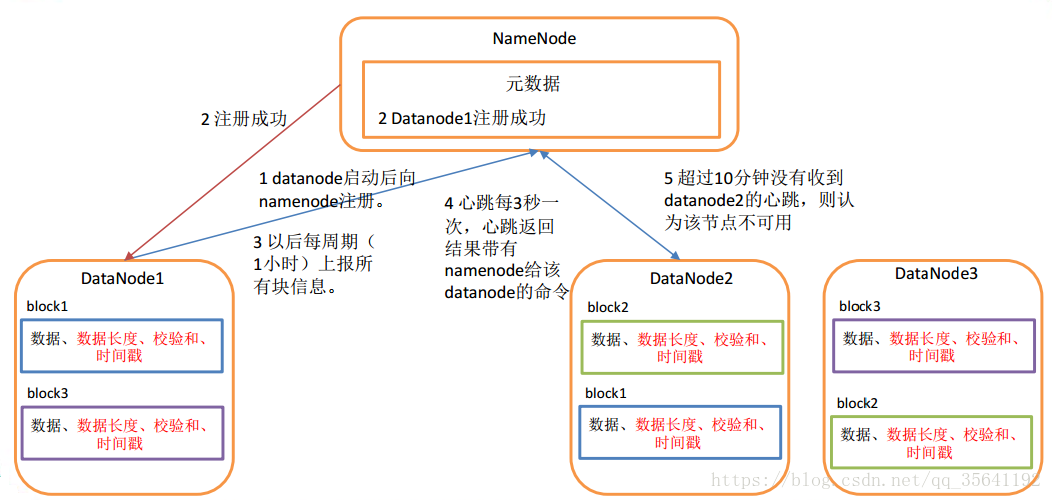

1.DataNode工作机制

1.一个数据块在DataNode上以文件形式存储在磁盘上,包括两个文件,一个是数据本身,一个是元数据包括数据块的长度,块数据的效验和,以及时间戳;

2.DataNode启动后向NameNode注册,通过后,周期性的向NameNode上报所有的块信息;

3.心跳是每三秒一次,心跳返回结果带有NameNode给该DataNode的命令如复制块数据到另一台机器,或删除某个数据块。如果超过10分钟没有收到某个DataNode的心跳,则认为该节点不可用;

4.集群运行中可以安全加入和退出一些机器;

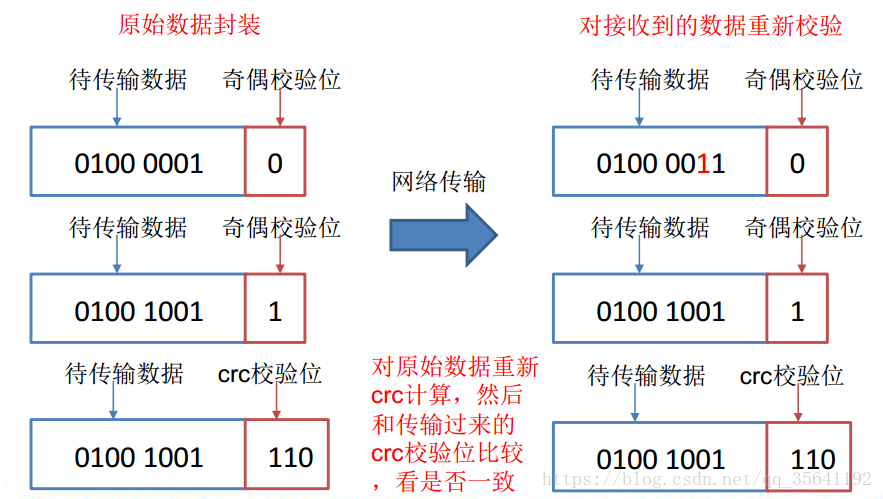

2.数据完整性

1.当DataNode读取block的时候,它会计算checksum;

2.如果计算后的checksum,与block创建时值不一样,说明block已经损坏;

3.client读取其他DataNode上的block;

4.DataNode在其文件创建后周期验证checksum;

3.掉线时限参数设置

DataNode进程死亡或者网络故障造成DataNode无法与NameNode通信,NameNode不会立即把该节点判定为死亡,要进过一段时间,这段时间暂称作超时时长。HDFS默认的超时时长为10分钟+30秒。如果定义超时时间为timeout,则超时时长的计算公式为:

timeout = 2 * dfs.namenode.heartbeat.recheck-interval + 10 * dfs.heartbeat.interval。

而默认的dfs.namenode.heartbeat.recheck-interval大小为五分钟,dfs.heartbeat.interval默认为三秒;

需要注意的是hdfs-site.xml配置文件的heartbeat.recheck.interval的单位为毫秒,dfs.heartbeat.interval的单位为秒;

<property>

<name>dfs.namenode.heartbeat.recheck-interval</name>

<value>300000</value>

</property>

<property>

<name> dfs.heartbeat.interval </name>

<value>3</value>

</property>

4.服役新数据节点

随着公司业务的增长,数据量越来越大,原有的数据节点的容量已经不能满足存储数据的需求,需要在原有的集群基础上添加新的数据节点;

4.1 环境准备

4.1.1 克隆一台虚拟机

4.1.2 修改ip地址和主机名称

4.1.3 修改xcall和xsync文件,增加新增节点的同步ssh

4.1.4 删除原来HDFS文件系统留存的文件/opt/module/hadoop/data

4.1.5 服役新节点具体步骤

(1) 在NameNode的/opt/module/hadoop/etc/hadoop目录下创建dfs.hosts文件,内容如下:

#添加如下主机名称(包含新服役的节点)

hadoop102

hadoop103

hadoop104

hadoop105

(2) 在NameNode的hdfs-site.xml配置文件中增加dfs.hosts属性

<property>

<name>dfs.hosts</name>

<value>/opt/module/hadoop/etc/hadoop/dfs.hosts</value>

</property>

(3)刷新NameNode

hdfs dfsadmin -refreshNodes

(4) 更新resourcemanager节点

yarn rmadmin -refreshNodes

(5) 在NameNode的/opt/module/hadoop/etc/hadoop目录下的slaves文件中增加新主机名称

#增加 105

hadoop102

hadoop103

hadoop104

hadoop105

分发给其他集群

./xsync xsync

./xsync /opt/module/hadoop/etc/hadoop/

(6)单独命令启动新的数据节点和节点管理器

hadoop-daemon.sh start datanode

yarn-daemon.sh start nodemanager

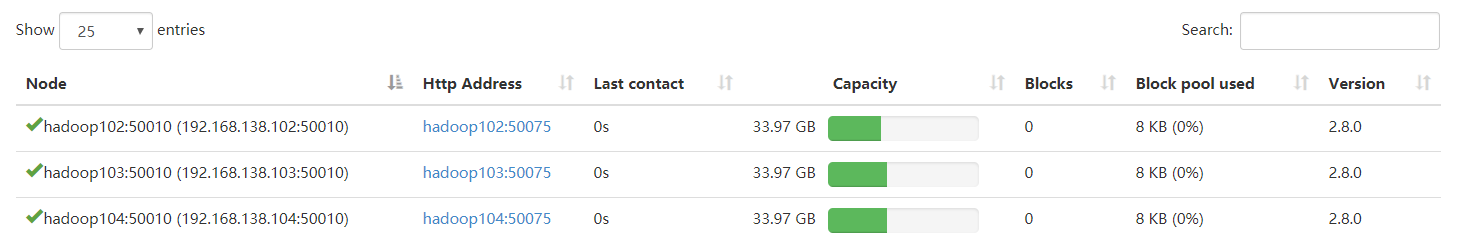

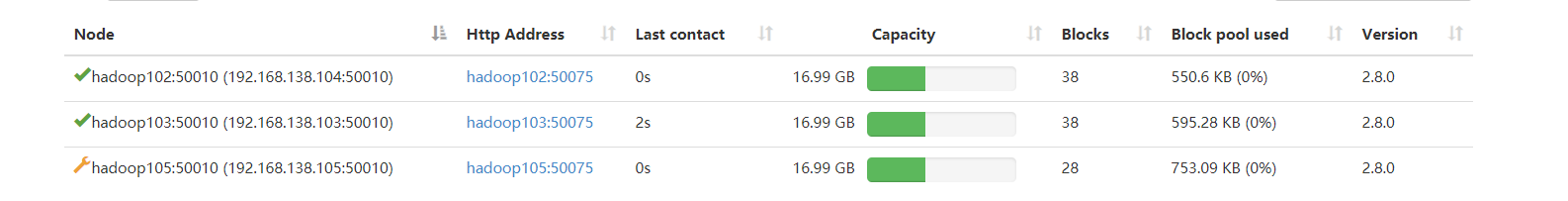

(7) 在web浏览器上检查是否OK

(8) 如果数据不均衡,可以用命令实现集群的在平衡

./start-balancer.sh

5.服役旧数据节点

5.1 添加白名单

添加到白名单的主节点,都允许犯法NameNode,不在白名单的主机节点,都会被退出;

5.1.1 在NameNode的/opt/module/hadoop/etc/hadoop目录下创建whitelist文件

5.1.2 在NameNode的hdfs-site.xml配置文件中增加dfs.hosts属性

<property>

<name>dfs.hosts</name>

<value>/opt/module/hadoop/etc/hadoop/whitelist</value>

</property>

5.1.3 刷新NameNode,刷新resourcemanager

hdfs dfsadmin -refreshNodes

yarn rmadmin -refreshNodes

在启动白名单的时候,黑名单中的主机自动删除了,挂掉了;

5.2 添加黑名单

在黑名单上面的主机都会被强制退出

5.2.1 在NameNode的/opt/module/hadoop/etc/hadoop目录下创建blacklist文件

5.2.2 在NameNode的hdfs-site.xml配置文件中增加dfs.hosts.exclude属性

<property>

<name>dfs.hosts.exclude</name>

<value>/opt/module/hadoop/etc/hadoop/blacklist</value>

</property>

5.2.3 刷新NameNode,刷新resourcemanager

hdfs dfsadmin -refreshNodes

yarn rmadmin -refreshNodes

6.DataNode多目录

6.1 DataNode也可以配置成多个目录,每个目录存储的数据不一样;即:数据不是副本;

6.2 配置如下【hdfs-site.xml】

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///${hadoop.tmp.dir}/dfs/data1,file:///${hadoop.tmp.dir}/dfs/data2</value>

</property>