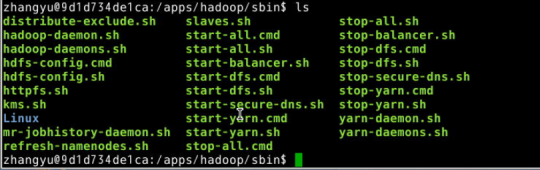

1.Hadoop/sbin下服务进程管理命令说明

1、sbin/start-all.sh 启动所有的Hadoop守护进程。包括NameNode、 Secondary NameNode、DataNode、ResourceManager、NodeManager

2、sbin/stop-all.sh 停止所有的Hadoop守护进程。包括NameNode、 Secondary NameNode、DataNode、ResourceManager、NodeManager

3、sbin/start-dfs.sh 一键启动Hadoop HDFS守护进程NameNode、SecondaryNameNode、DataNode

4、sbin/stop-dfs.sh 一键停止Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNode

5、sbin/hadoop-daemons.sh start namenode 单独启动所有节点NameNode守护进程

6、sbin/hadoop-daemons.sh stop namenode 单独停止所有节点NameNode守护进程

7、sbin/hadoop-daemons.sh start datanode 单独启动所有节点DataNode守护进程

8、sbin/hadoop-daemons.sh stop datanode 单独停止所有节点DataNode守护进程

9、sbin/hadoop-daemon.sh start namenode 单独启动某个节点NameNode守护进程

10、sbin/hadoop-daemons.sh start secondarynamenode 单独启动SecondaryNameNode守护进程

11、sbin/hadoop-daemons.sh stop secondarynamenode 单独停止SecondaryNameNode守护进程

12、sbin/start-yarn.sh 启动ResourceManager、NodeManager

13、sbin/stop-yarn.sh 停止ResourceManager、NodeManager

14、sbin/yarn-daemon.sh start resourcemanager 单独启动ResourceManager

15、sbin/yarn-daemons.sh start nodemanager 单独启动NodeManager

16、sbin/yarn-daemon.sh stop resourcemanager 单独停止ResourceManager

17、sbin/yarn-daemons.sh stop nodemanager 单独停止NodeManager

18、sbin/mr-jobhistory-daemon.sh start historyserver 手动启动jobhistory

19、sbin/mr-jobhistory-daemon.sh stop historyserver 手动停止jobhistory

2.集群启动命令

sbin/start-dfs.sh

sbin/start-yarn.sh

sbin/mr-jobhistory-daemon.sh start historyserver

或者

sbin/start-all.sh

3.查看web界面的3个端口

1、http://hadoop01:50070/ 查看hdfs

2、http://hadoop01:8088/cluster 查看yarn集群;包括查看、管理当前MapReduce任务

3、http://hadoop01:19888/jobhistory 查看历史完成的任务

4.hadoop/bin下hadoop操作命令总结

5.start-all.sh

echo "This script is Deprecated. Instead use start-dfs.sh and start-yarn.sh"

bin=`dirname "${BASH_SOURCE-$0}"`

bin=`cd "$bin"; pwd`

DEFAULT_LIBEXEC_DIR="$bin"/../libexec

HADOOP_LIBEXEC_DIR=${HADOOP_LIBEXEC_DIR:-$DEFAULT_LIBEXEC_DIR}

. $HADOOP_LIBEXEC_DIR/hadoop-config.sh

# start hdfs daemons if hdfs is present

if [ -f "${HADOOP_HDFS_HOME}"/sbin/start-dfs.sh ]; then

"${HADOOP_HDFS_HOME}"/sbin/start-dfs.sh --config $HADOOP_CONF_DIR

fi

# start yarn daemons if yarn is present

if [ -f "${HADOOP_YARN_HOME}"/sbin/start-yarn.sh ]; then

"${HADOOP_YARN_HOME}"/sbin/start-yarn.sh --config $HADOOP_CONF_DIR

fi

群起。