MR的Job提交源码

刨析一遍切片原理

以源码角度,来深刻理解MR工作原理。

MR源码分析:(wordCount案例)–入口类

问题:

MR中的Job,是如何提交的

首先:

DeBug流程走一波。

进入提交作业方法:

它这里做了一件事,获取了配置信息,思考题:什么配置信息?不会可以留言

通过YarnClientProtocolProvider | LocalClientProtocolProvider 根据配置文件的参数信息

获取当前job需要执行到本地还是Yarn

最终:LocalClientProtocolProvider ==> LocalJobRunner

然后我们出来,再看一下下图这个方法。

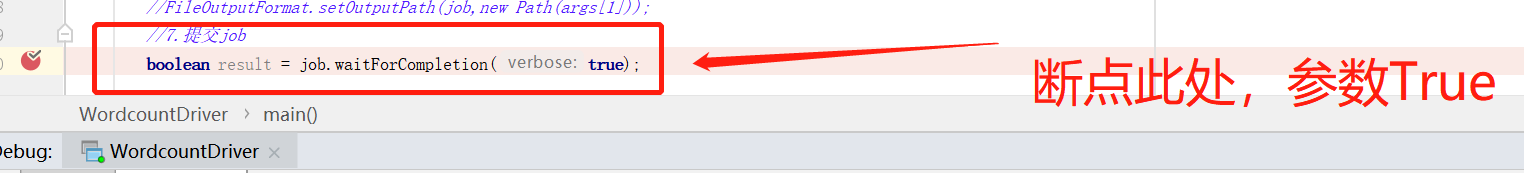

之前我们设定参数为True,这里用Verbose这个来接收,传True代表将参数进行打印,重点是submit,进入submit,走一遍提交流程。

这个方法内部又返回了一个方法:submitJobInternal(),我们继续深入。打开submitJobInternal(),方法如下:

<1> . checkSpecs(job); 检查job的输出路径。

<2> . Path jobStagingArea = JobSubmissionFiles.getStagingDir(cluster, conf);

生成Job提交的临时目录

D:\tmp\hadoop\mapred\staging\Administrator1777320722.staging

<3> . JobID jobId = submitClient.getNewJobID(); 为当前Job生成Id

<4> . Path submitJobDir = new Path(jobStagingArea, jobId.toString()); Job的提交路径

d:/tmp/hadoop/mapred/staging/Administrator1777320722/.staging/job_local1777320722_0001

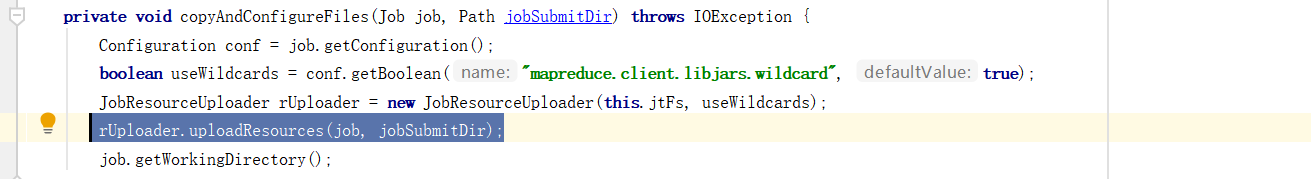

<5> . 下面有个:copyAndConfigureFiles(job, submitJobDir);我们点进去

DeBug到这里,才是创建Job的提交路径

我们再返回去

<6> . int maps = writeSplits(job, submitJobDir); //生成切片信息 ,并返回切片的个数

<7> . conf.setInt(MRJobConfig.NUM_MAPS, maps); //通过切片的个数设置MapTask的个数

<8> . writeConf(conf, submitJobFile); //将当前Job相关的配置信息写到job提交路径下

路径下: job.split job.splitmetainfo job.xml xxx.jar

<9> .status = submitClient.submitJob(jobId,submitJobDir.toString(),job.getCredentials()); //到了这里,才是真正提交Job

<10> . jtFs.delete(submitJobDir, true); //等job执行完成后,删除Job的临时工作目录的内容