本文首发于微信公众号 CVHub,不得以任何形式转载到其它平台,仅供学习交流,违者必究!

Title: <InstructPix2Pix: Learning to Follow Image Editing Instructions>

Paper: https://arxiv.org/abs/2211.09800

Github: comming soon _

导读

本文提出了一种新的图像编辑方法,它可以通过语言指导快速编辑图像。为了获得这个问题的训练数据,作者结合了两个大型预训练模型的知识——语言模型和文本到图像模型——生成了大量的图像编辑示例数据集。通过在这些数据上进行训练,并在推理时能够适用于真实图像和用户编写的指令。它可以在几秒钟内快速编辑图像,并且不需要每个例子的微调或反演。作者展示了多种输入图像和指令所结合的图像,效果还是非常惊艳的。

方法

本文提出了一种教会生成模型遵循人类书面指令进行图像编辑的方法。由于此任务的训练数据难以大规模获取,作者提出了一种生成配对数据集的方法,该方法结合了预训练的多个大模型:大语言模型(GPT-3)和文本到图像模型(Stable Diffusion)。

这两个模型捕捉了语言和图像的互补知识,可以结合起来创建跨越多个模态的任务的配对训练数据。使用生成的配对数据,作者训练了一个条件扩散模型,该模型给定输入图像和关于如何编辑它的文本指令,生成编辑后的图像。该模型可以直接在前向传递中执行图像编辑,不需要任何其他示例图像、输入/输出图像的完整描述或每个例子的微调。尽管完全在合成示例(即生成的书面说明和生成的图像)上进行训练,但模型也实现了对任意真实图像和自然人类书面指令的零点推广。

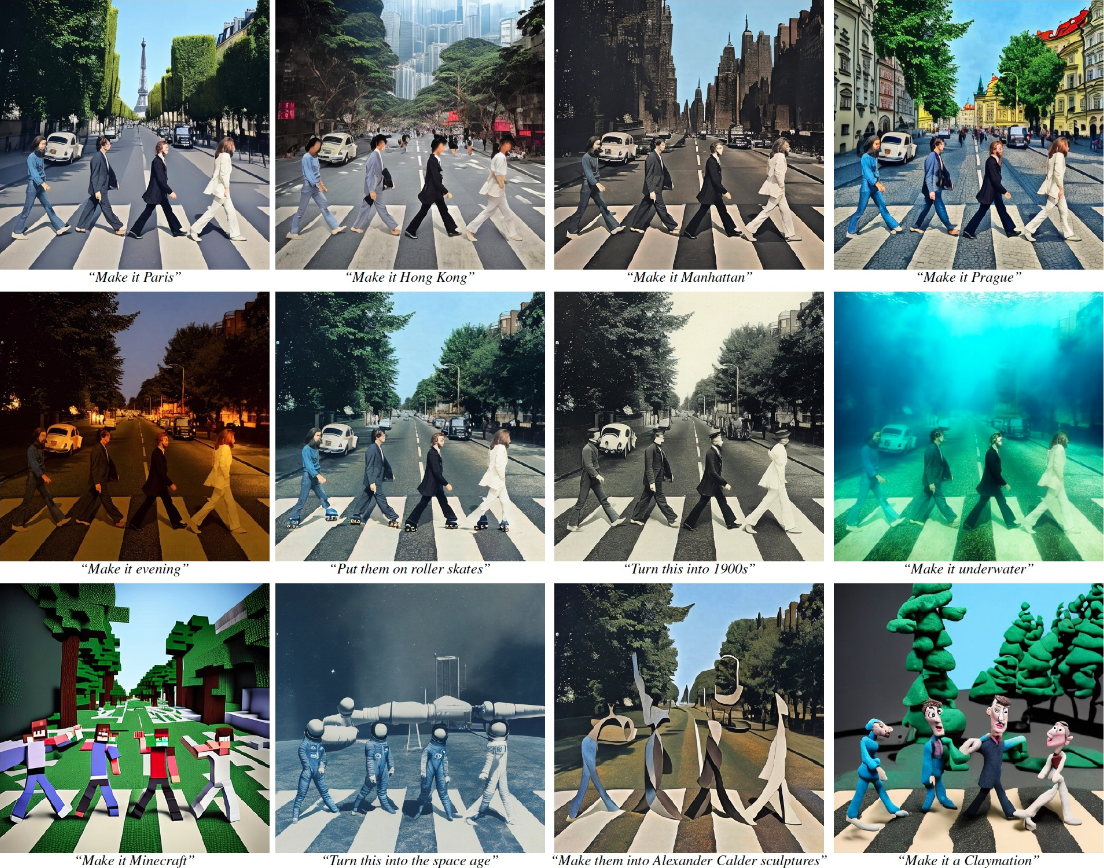

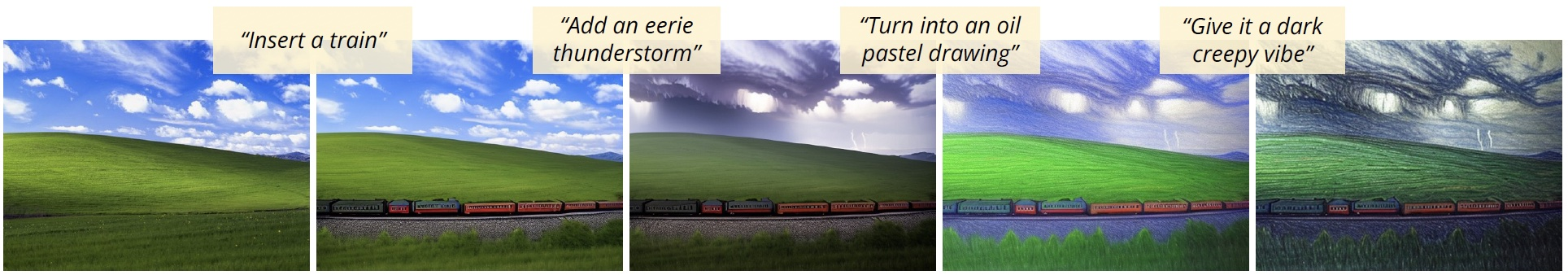

本文提出的模型能够实现直观的图像编辑,可以遵循人类指令执行多种编辑,包括替换对象,改变图像的风格,改变环境,艺术媒介等,如上图所示。

效果

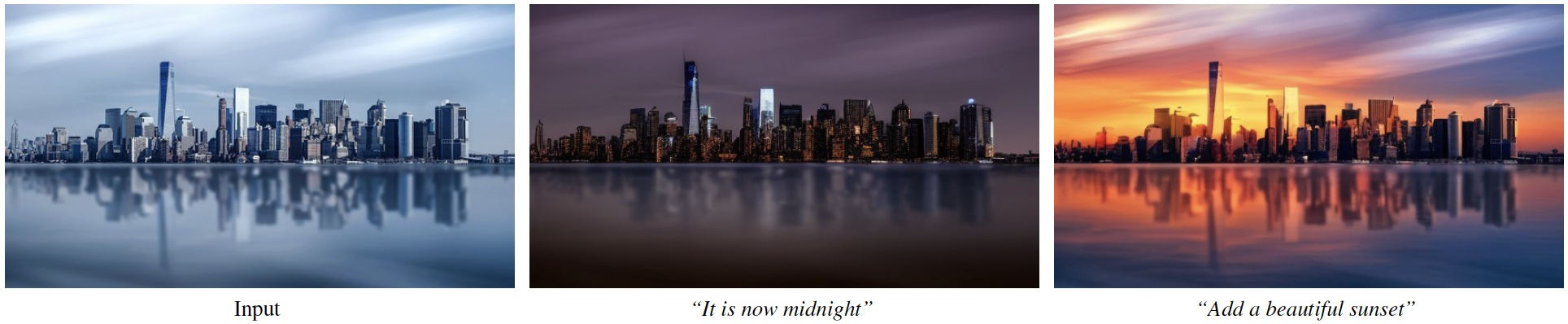

从上面这张图我们可以看到,独立的变化也会带来相应的上下文影响,例如添加的船也会在水中产生风涟漪,添加的城市天际线也会反射在湖面上。

局限性

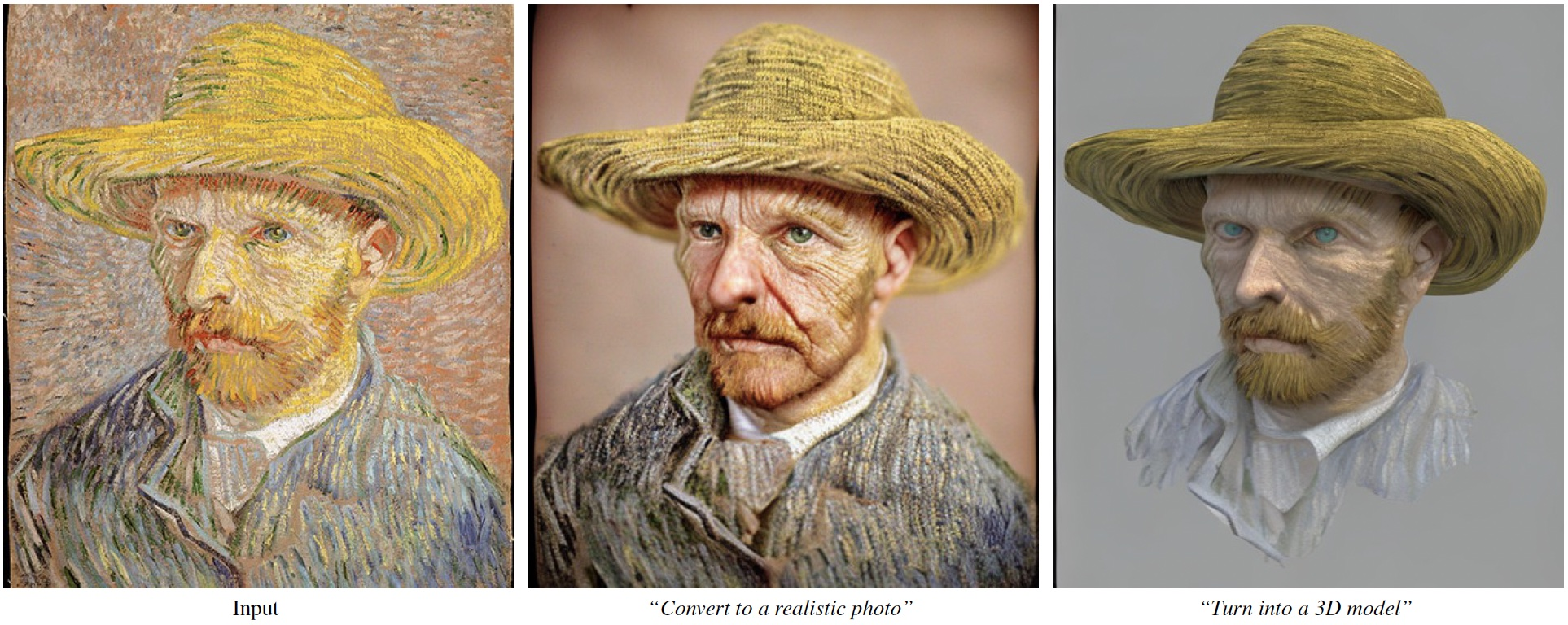

上图反映了该方法基于的数据和模型的偏差,例如职业与性别之间的相关性。

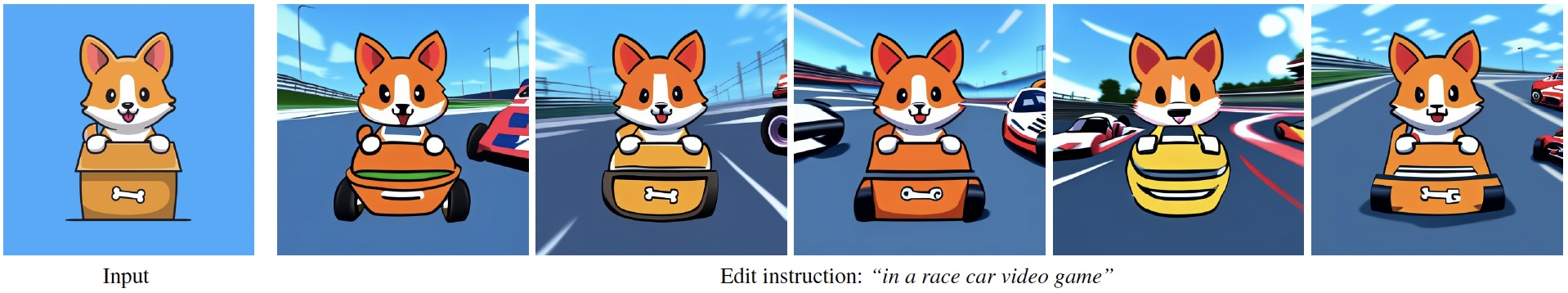

大家从左到右可以发现,该模型无法执行视点更改,可能会对图像进行不必要的过度更改,有时无法隔离指定的对象,并且很难重新组织或交换对象。

结论

本文演示了一种结合两个大型预训练模型(一个大型语言模型和一个文本到图像模型)生成用于训练扩散模型的数据集,以便跟随书面图像编辑指令的方法。虽然该方法能够产生各种各样的令人信服的图像编辑,包括风格、媒介和其他上下文变化,但仍然存在许多限制。

首先,该方法受生成数据的视觉质量的限制,因此会受到生成图像的扩散模型的限制。

其次,该方法在推广新的编辑并在视觉变化和文本指令之间建立正确联系方面的能力受到用于调整GPT-3的人类书面指令的限制,受到GPT-3创建指令和修改标题的能力以及Prompt-to-Prompt修改生成图像的能力的限制。特别是,该模型在计数物品数量和空间推理(例如,将其移到图像的左侧,交换它们的位置或将两个杯子放在桌子上,一个放在椅子上)方面存在困难,就像稳定扩散和提示到提示一样。

最后,本文方法所基于的数据和预训练模型中有着众所周知的偏差,因此该方法生成的编辑图像可能继承这些偏差或引入其他偏差(参考上面那张图)。

不过,除了缓解上述限制外,这篇工作还开启了许多有趣的问题,例如:如何遵循空间推理的指令,如何将指令与其他调节模态(如用户交互)结合起来,以及如何评估基于指令的图像编辑。将人类反馈纳入模型的改进是未来工作的另一个重要领域,策略(如人在循环中的强化学习)可以应用于改善模型与人类意图的一致性。

写在最后

如果您也对人工智能和计算机视觉全栈领域感兴趣,强烈推荐您关注有料、有趣、有爱的公众号『CVHub』,每日为大家带来精品原创、多领域、有深度的前沿科技论文解读及工业成熟解决方案!欢迎添加小编微信号:cv_huber,一起探讨更多有趣的话题!