提出了一种使用低成本无人机实时生成探索地图的解决方案。这依赖于Tello Edu(https://www.ryzerobotics.com/tello-edu于 2021 年 12月16日访问)无人机提供的信息,该无人机将图像流式传输到外部笔记本电脑上以进行实时处理。该解决方案运行单目视觉 SLAM来注册图像并创建未缩放的环境地图。

然而,这些信息不足以估计场景的规模,并且不能提供环境的密集重建。为了解决这些问题,SLAM 算法随后与基于CNN(卷积神经网络)的方法集成,利用单图像深度估计(SIDE)算法来估计环境的规模并从一组视频帧中对环境的3D重建进行致密化。最终融合这些信息以生成探索地图并实时定义环境的体积。这种方法的目标是提供快速的3D地图,以支持 FR在搜索和救援行动期间探索未知的室内环境。

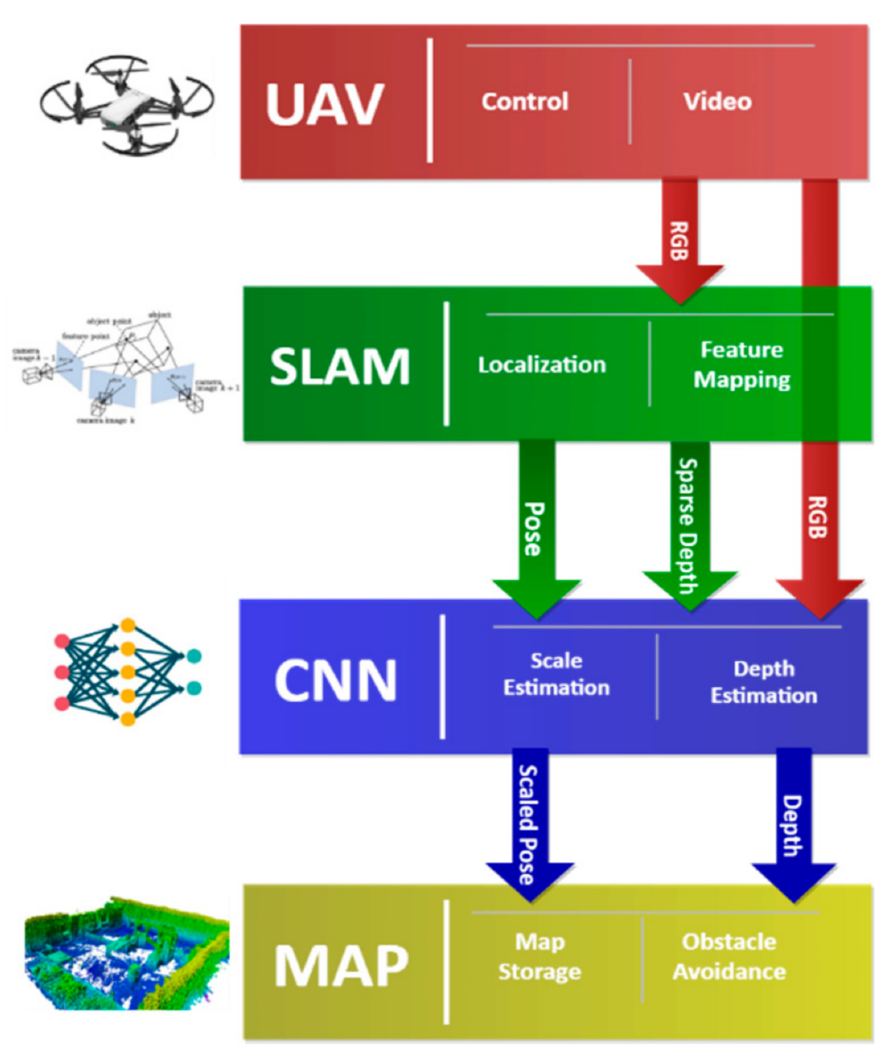

所提出的方法旨在使用飞行期间从无人机流式传输的图像实时生成探索地图。该解决方案可分为四个主要步骤,如图1所示: (i) 无人机数据采集和流式传输;(ii) SLAM算法;(iii) 致密化和缩放;(iv) 探索地图生成。这些步骤嵌入在ROS(机器人操作系统)中,以实现不同组件之间的高效通信:(ii) 中的算法在CPU上运行,而 (iii) 和 (iv) 中的算法都利用了用过的电脑。由于SLAM系统是基于特征的,因此地图由稀疏的三角化3D特征点组成,但没有为我们提供正确的比例尺。CNN处理在飞行过程中获取的RGB 图像(只有几个关键帧)以检索比例并创建密集的深度图。然后将SLAM和CNN 算法产生的信息结合起来生成3D占用图。

图1 所提出解决方案的主要步骤概述

无人机和数据流

Tello EDU已被用于数据采集和流式传输(表1)。该平台相对易于使用,规模有限,其成本保证了高可复制性,从而满足了急救人员的需求。WIFI通信允许在笔记本电脑上流式传输图像,而可用的 SDK保证遥测的接收和与平台的连接。虽然无人机有一个板载IMU,但它的SDK不允许读取原始传感器数据。

表 1 Tello Edu无人机的技术规格

基于 CNN 的密集化和缩放

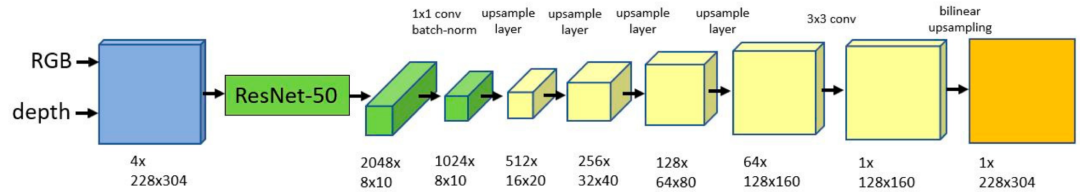

已经开发了单图像深度估计(SIDE) 网络来估计对象空间中每个图像像素的距离。在使用具有真实距离的深度图像进行训练后,它已被开发为在消费类笔记本电脑上实时运行。这有双重动机:(i)在对象空间中扩展 SLAM 提供的重建;(ii) 通过将SLAM生成的稀疏深度图与CNN融合来致密化3D重建。与许多SIDE算法不同,SLAM定义的稀疏深度样本作为附加约束添加到输入中的RGB 图像中,以细化深度估计。所开发的方法基于,它结合这些输入来预测详细的深度图像(图2)。该架构具有编码器-解码器结构,编码器处理输入信息并将其转换为特征图。然后将这些映射堆叠在一起以产生解码器的输出。

图2 使用的CNN架构。绿色框描述编码层,而黄色框是解码层。请注意,图像和深度图最初都是下采样的

探索地图

神经网络的深度估计通常在对应于深度不连续性(所谓的“混合像素”)和图像边界上提供不准确的重建,尤其是在低纹理区域的对应中(图3)。这些伪影会降低点云的质量,尤其是当融合不同的深度图以生成完整的3D重建时。

图3 ( a ) 深度过滤示例:蓝点被保留,而红点被认为是混合像素并被丢弃。( b ) 凸包选择区域示例:仅使用红线内的区域进行深度估计,剩余的外围区域被丢弃。

依次应用两种不同的方法来限制受错误重建影响的区域。混合像素通过计算有效的异常值去除进行过滤。所有点最初都存储在 KD树中,并确定每个点到其邻居的平均距离(即30个点)。然后为整个点云计算这些距离的平均值和标准偏差。然后删除距离高于某个阈值的点(图3a中的红点)。仅考虑由图像中的SLAM特征定义的凸包并排除该区域之外的3D重建,就可以去除图像边界上的低纹理区域(参见图3b)。

测试环境的 3D 重建——初步结果

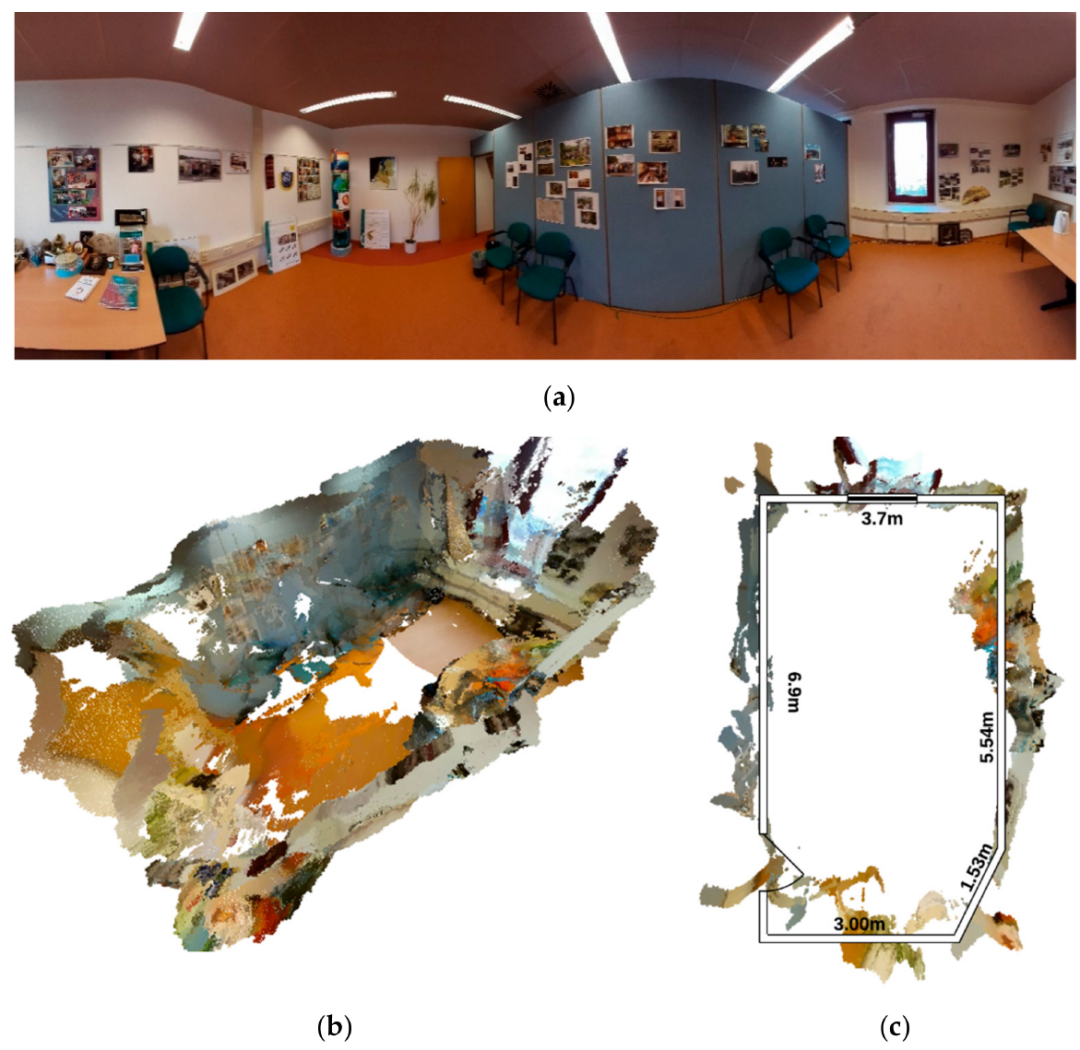

第一次测试采集持续了大约 70 秒,它是通过在房间内移动无人机进行的。实时生成的3D重建如图4所示。

图4 ( a ) 测试环境全景图;( b ) 生成点云的透视图;( c ) 与地板的参考平面测量进行比较

在点云中仍然可以看到一些残余变形,影响其质量。正如预期的那样,在眼镜(b中场景的上部)和低纹理区域(c中的下部)的对应中,噪声水平会增加。房间的入口也是重建的关键部分(c中的左下部分)。然而,估计的比例是准确的,提供了现实的测量,同时根据 FR 的需要保留了场景的整体几何形状。

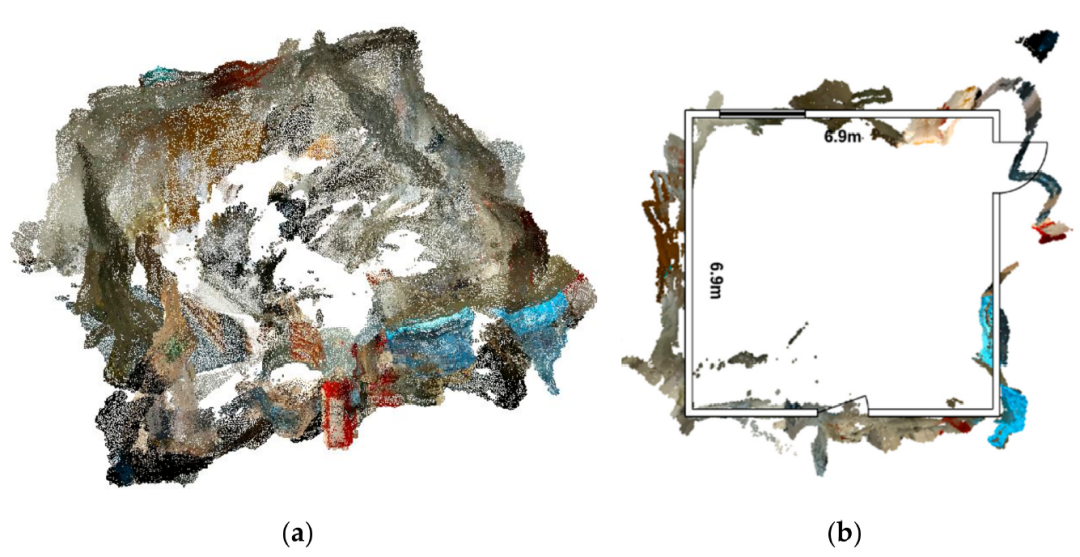

第二次测试是在一个方形房间里进行的,持续了大约50秒。与前一种情况一样,SIDE 重建的噪声无法完全去除,在场景中产生了一些伪影(图5)。然而,房间的规模和形状都被保留了下来。玻璃和反射面强烈影响重建,如房间右侧所示,并在重建中产生重大错误。

图5 ( a ) 测试环境生成点云透视图;( b ) 与地板的参考平面测量进行比较

呈现的结果表明仍有很大的改进空间:未来的测试将使用更高质量的PC来运行更深的网络,并评估这是否允许更好的3D重建。训练数据集并不理想,因为Kinect提供的深度图质量低,并且需要使数据适应无人机的相机参数。在这方面,一个新的专用数据集将允许更好地训练网络并改进重建。

源自:Drones 2022, 6, 79. https://doi.org/10.3390/drones6030079