可解释学习

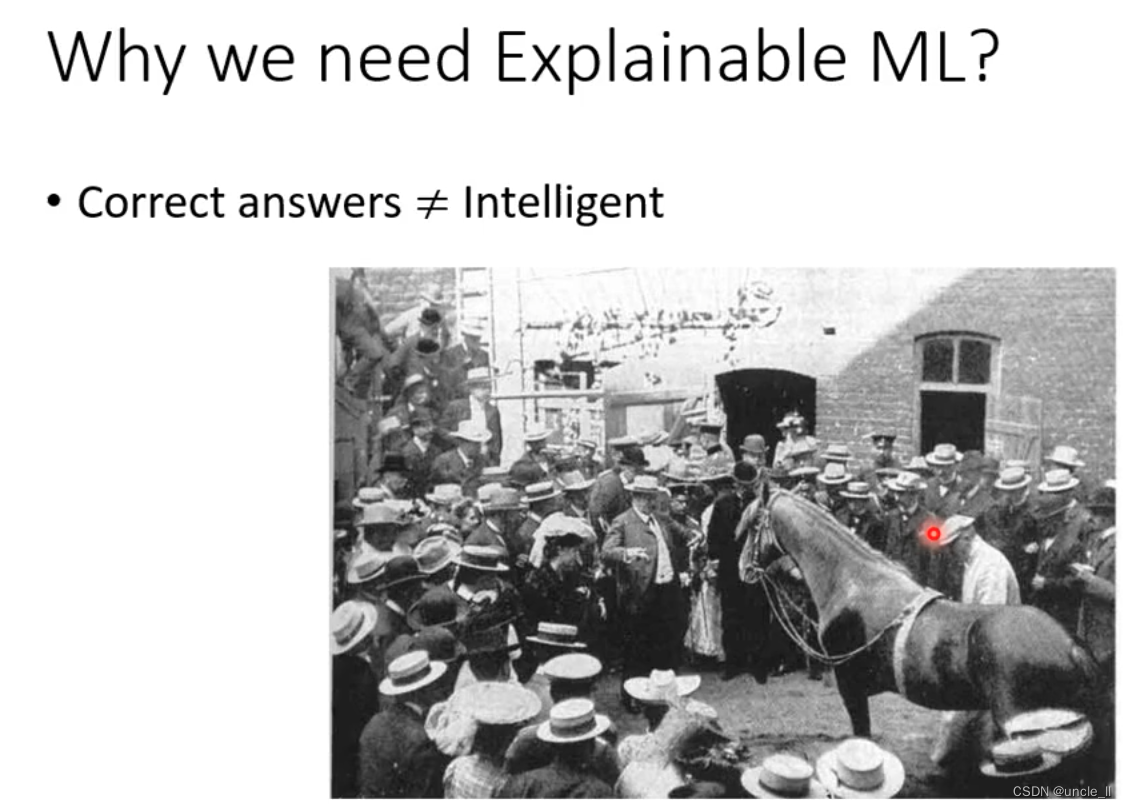

神马汉斯,只有在有人看的时候能够答对。

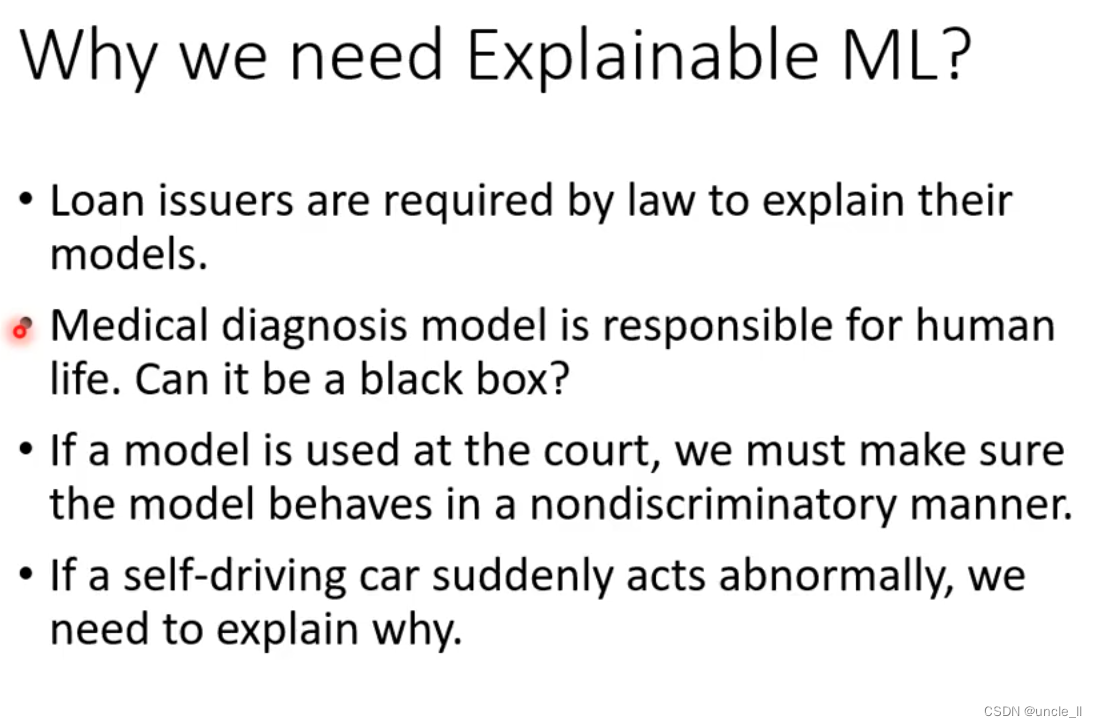

为什么需要可解释机器学习

贷款,医疗需要给出理由,让人们相信该算法的预测结果。

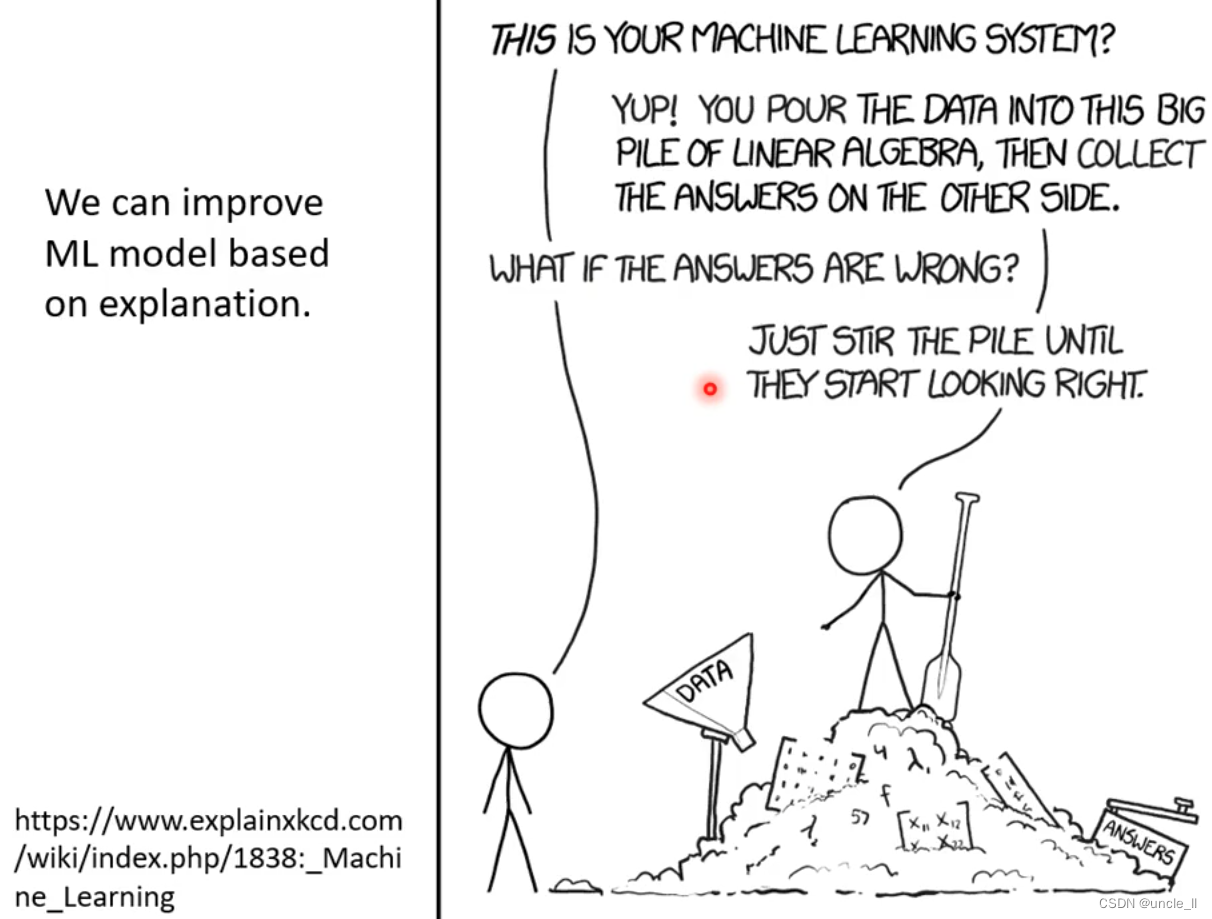

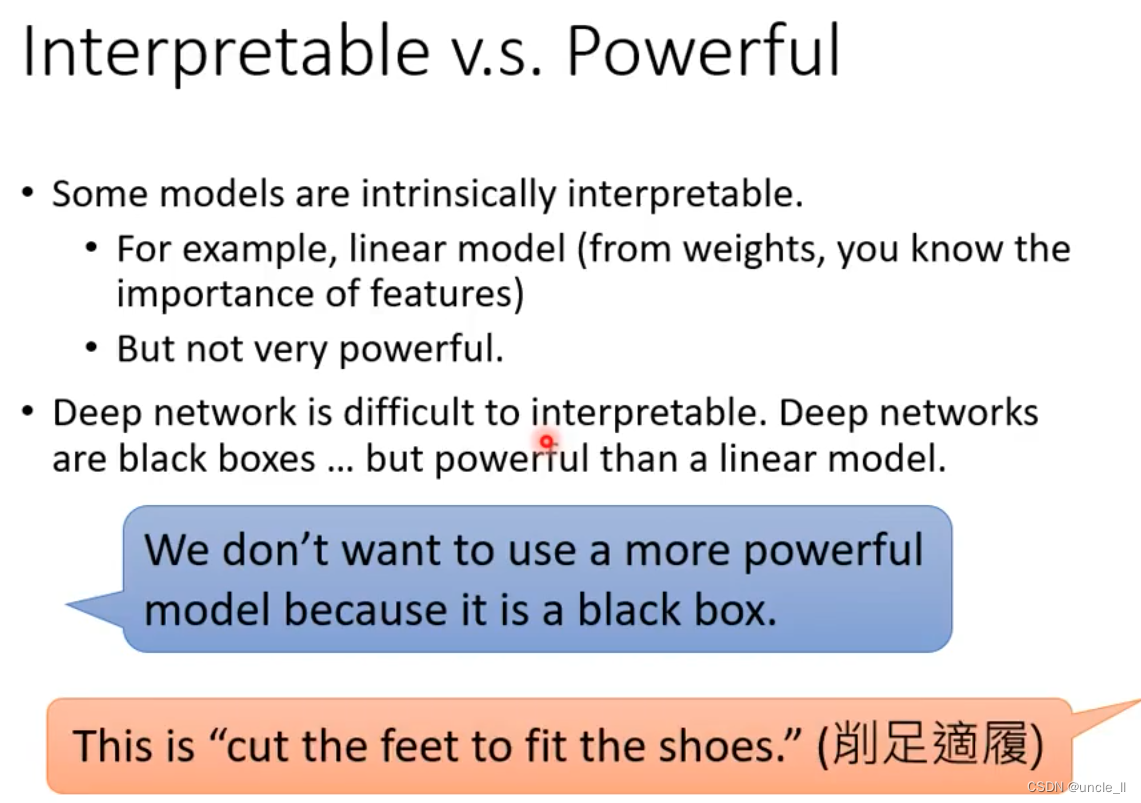

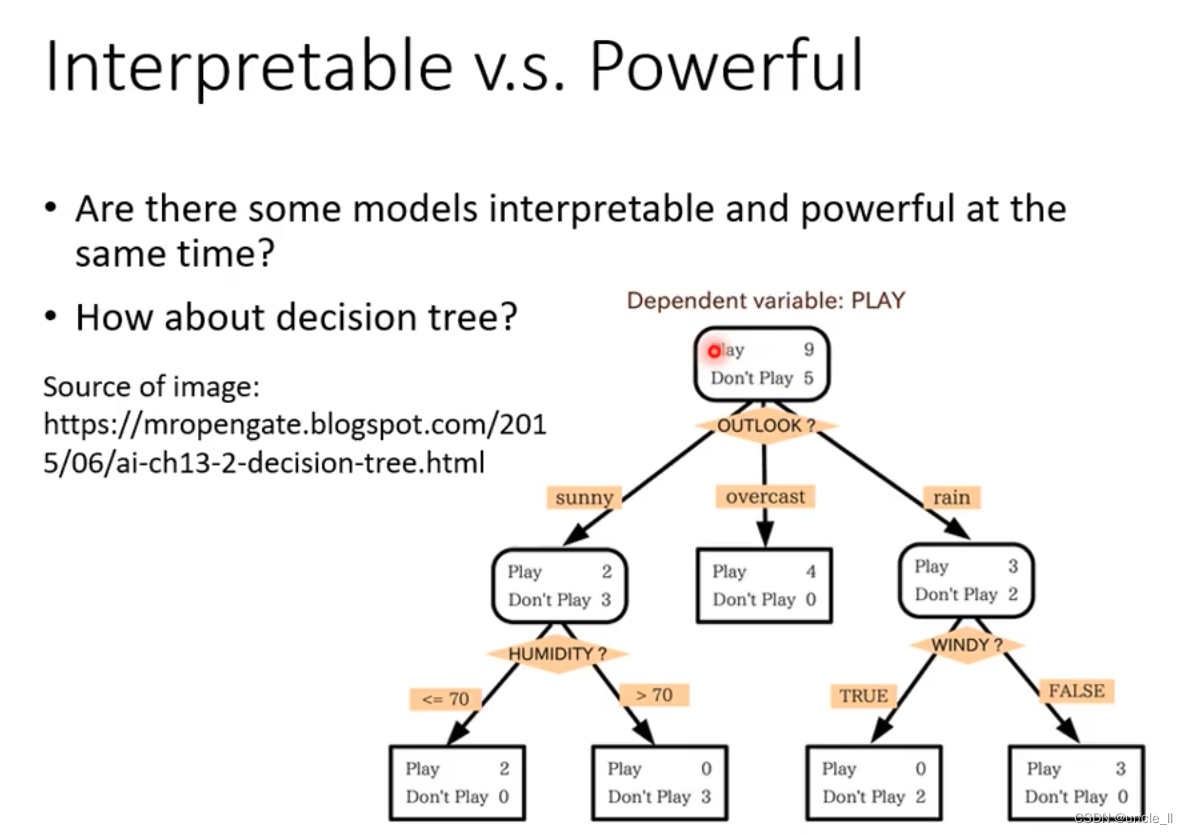

可解释还是强模型

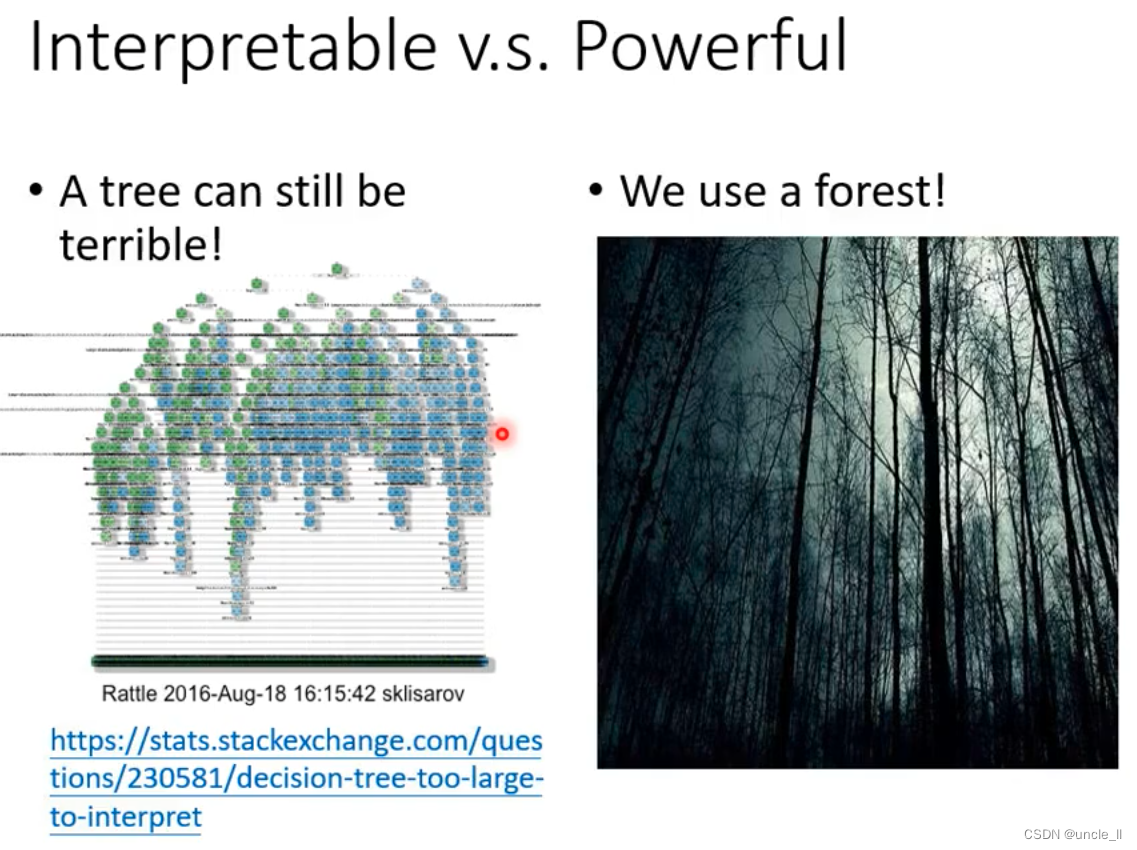

决策树是有比较好的解释性的。

随机森林作出的判断也无法明确指出是什么原因得到的答案。

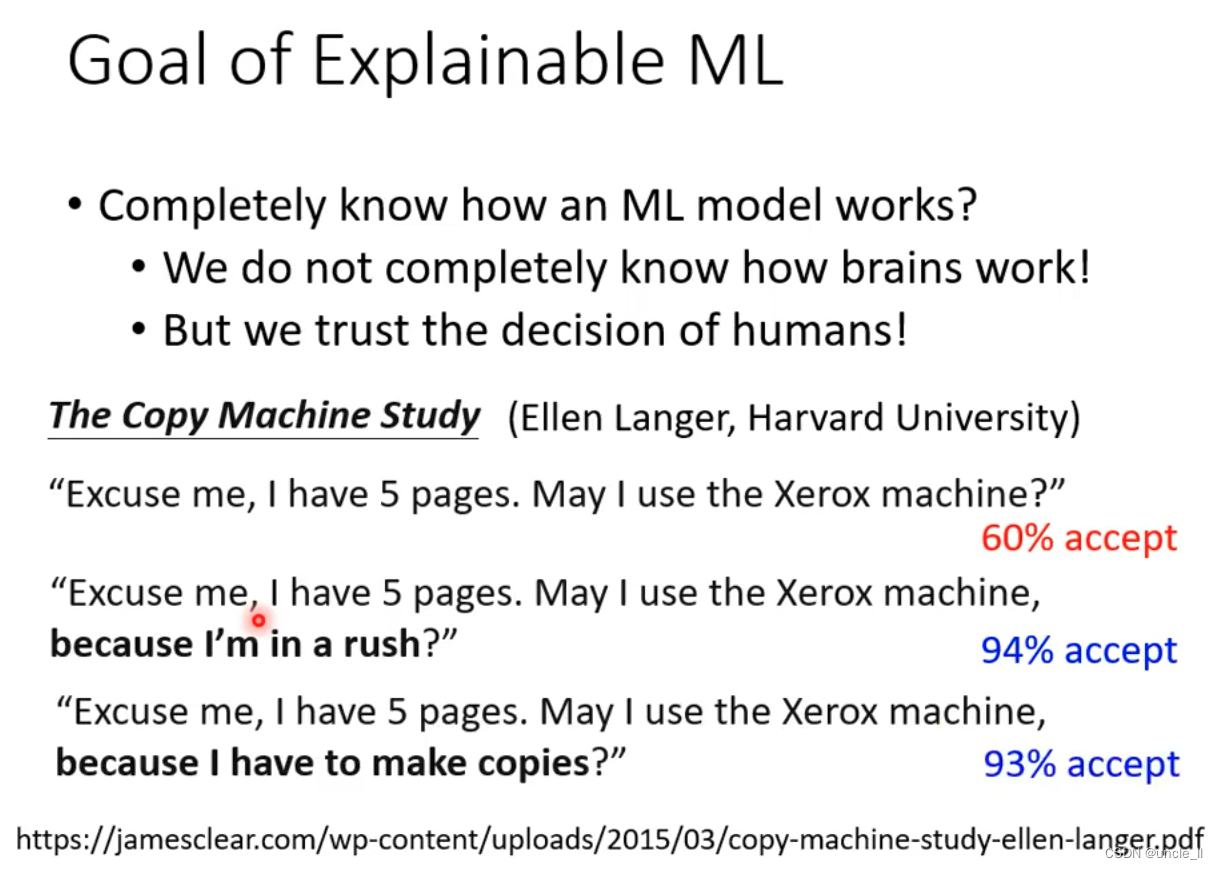

可解释学习的目标

人需要一个理由,才会被说服去做什么事。

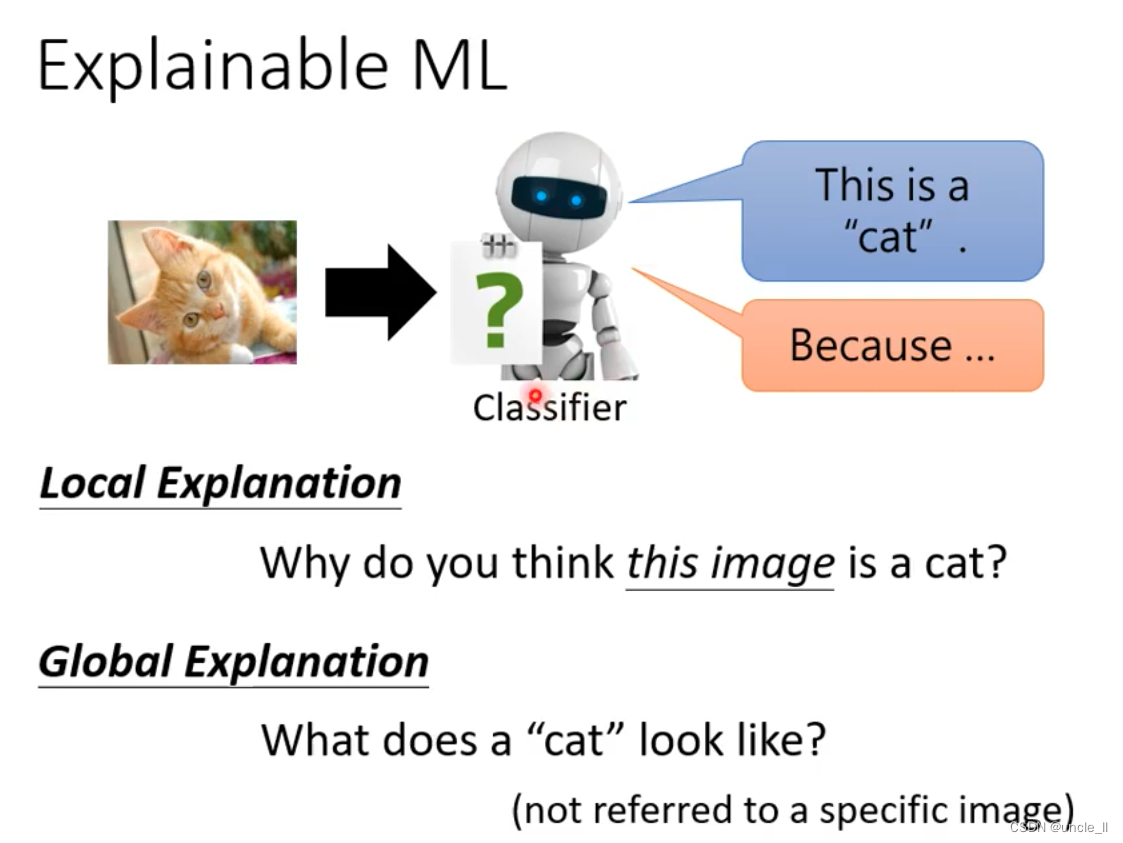

可解释机器学习

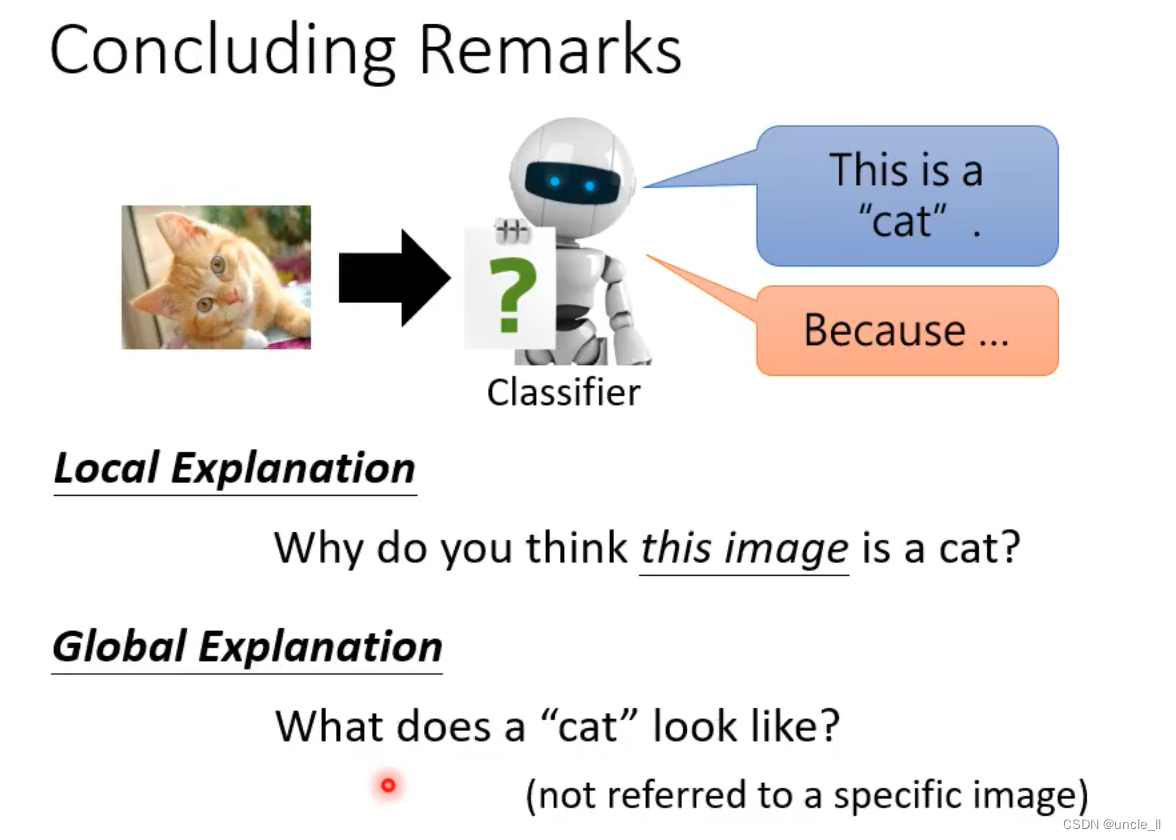

两大类,局部可解释,全局可解释

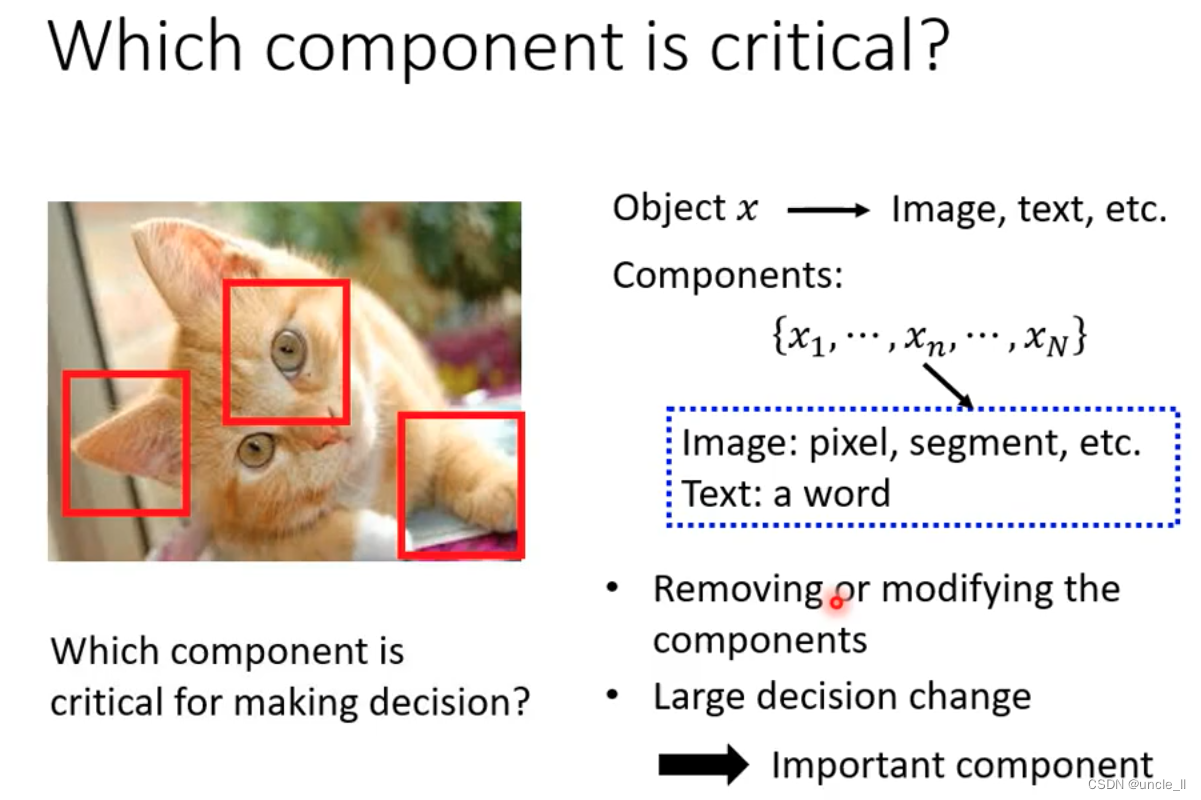

Local Explanation

移除某一部分导致发生大的判断改变,这一部分就是关键部分。

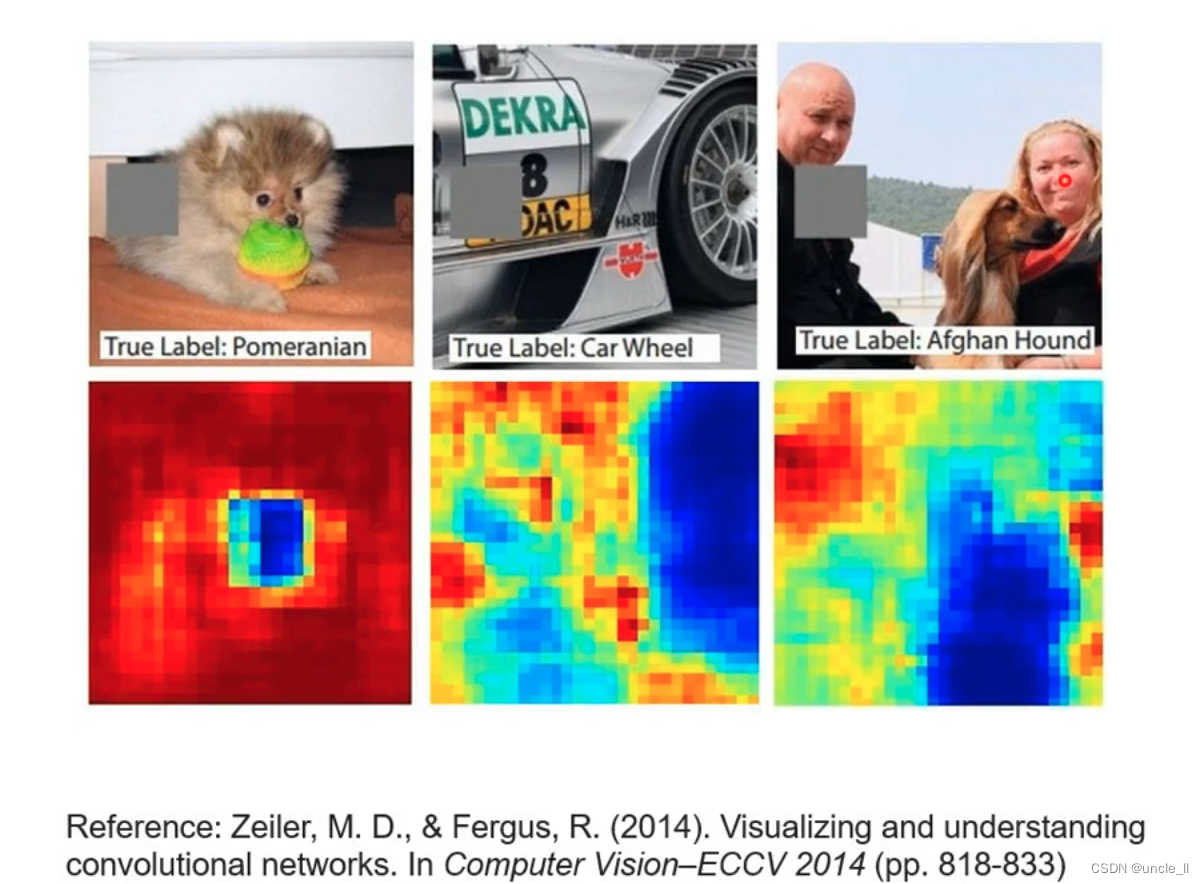

用黑色方块移动遮盖区域,再看算法是否能正确得到预测结果,如果不能,说明是重要部分,蓝色区域就是重要部分。

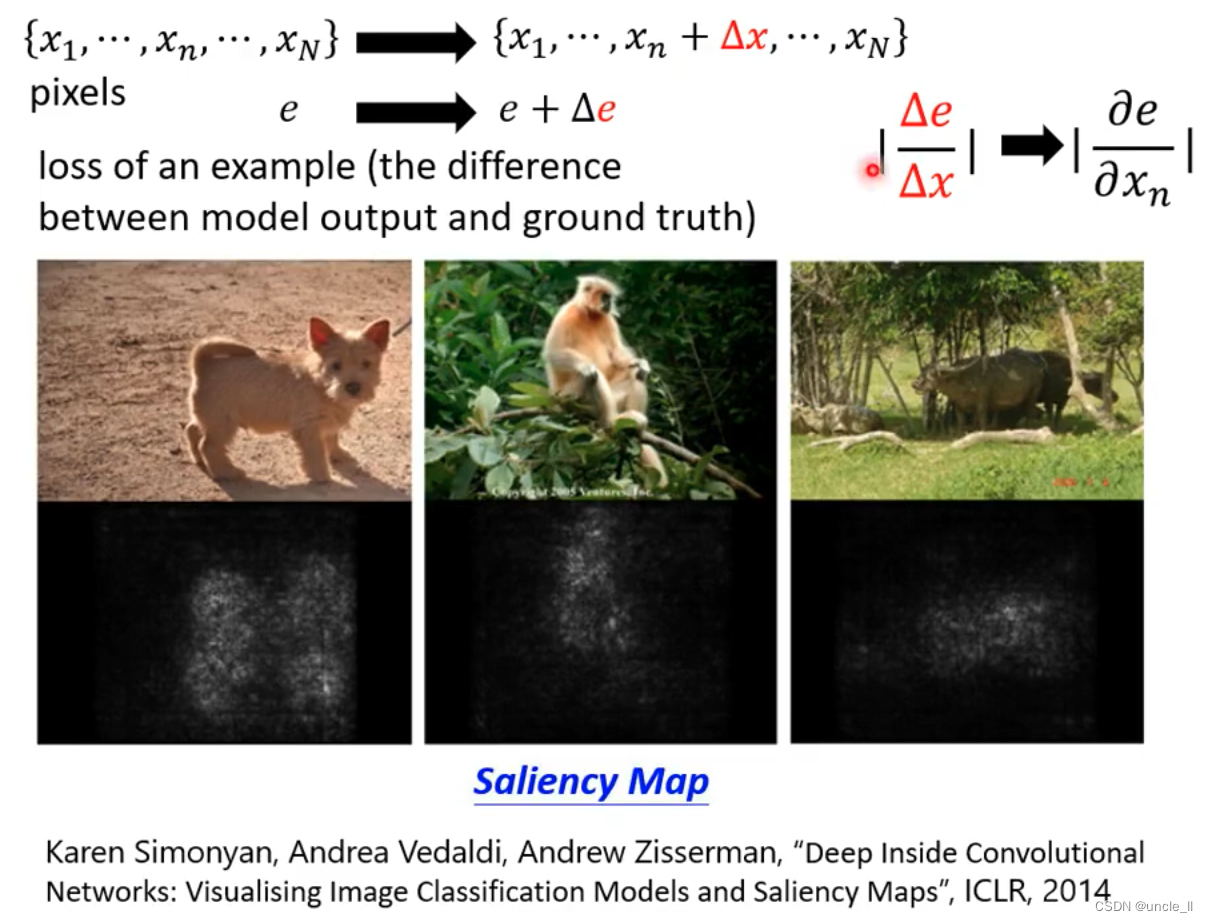

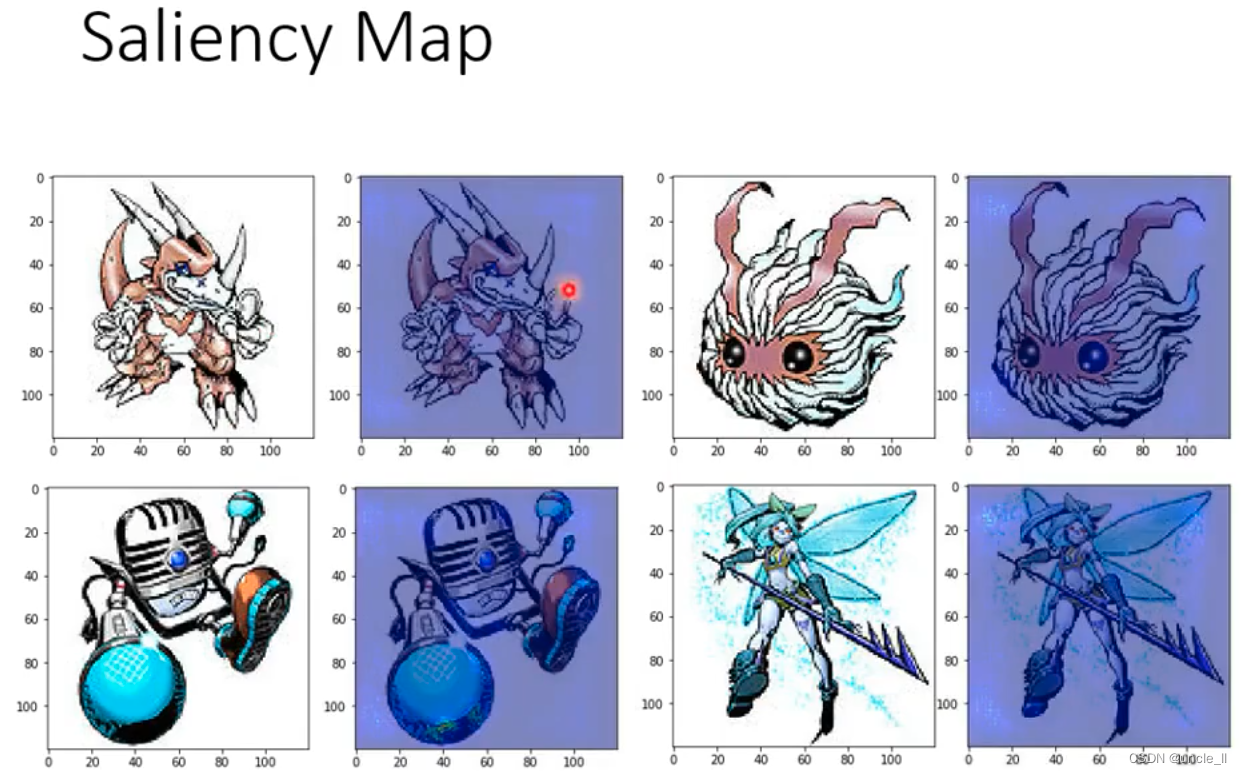

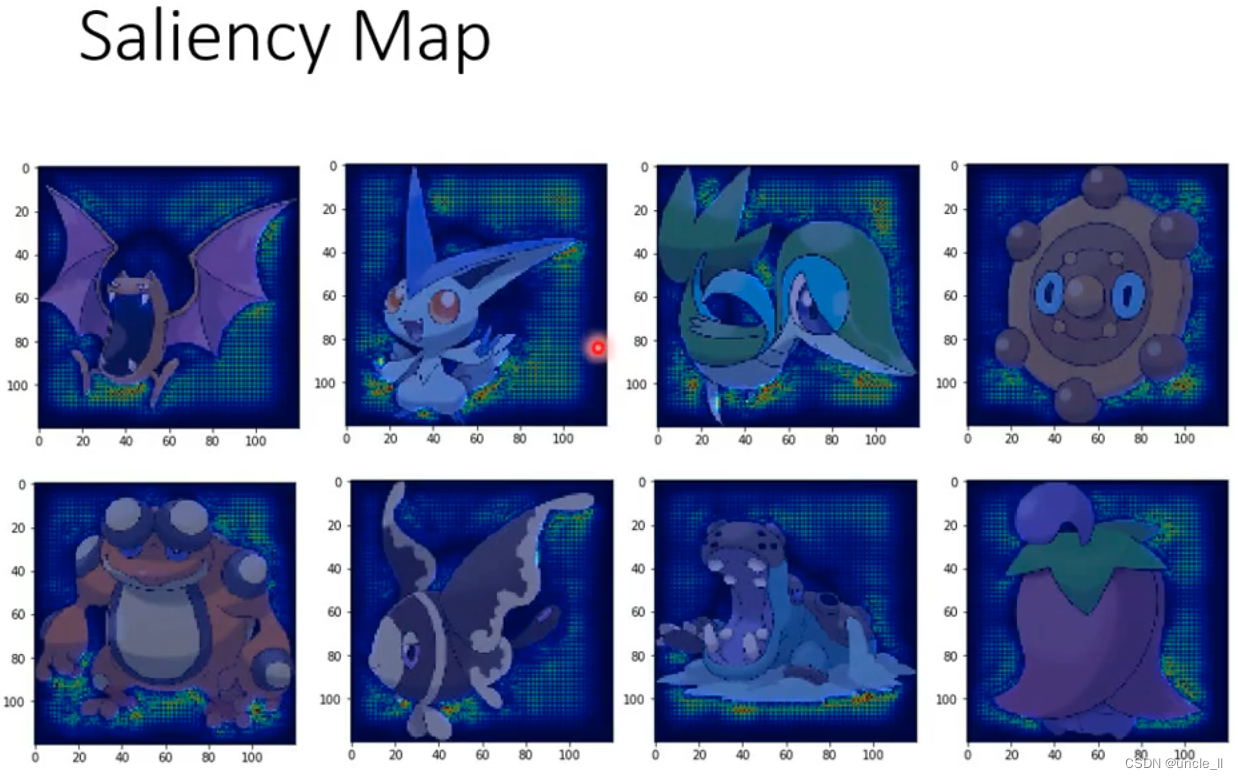

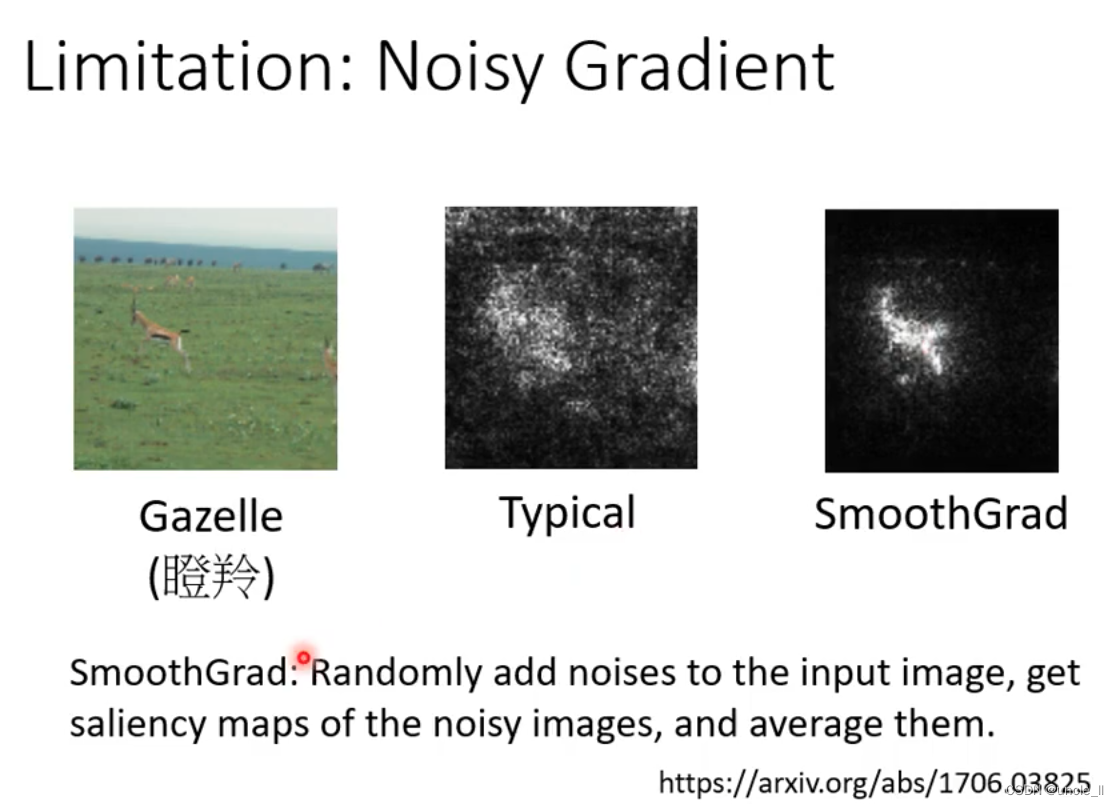

saliency map,白色区域说明值越大,表明像素值重要。

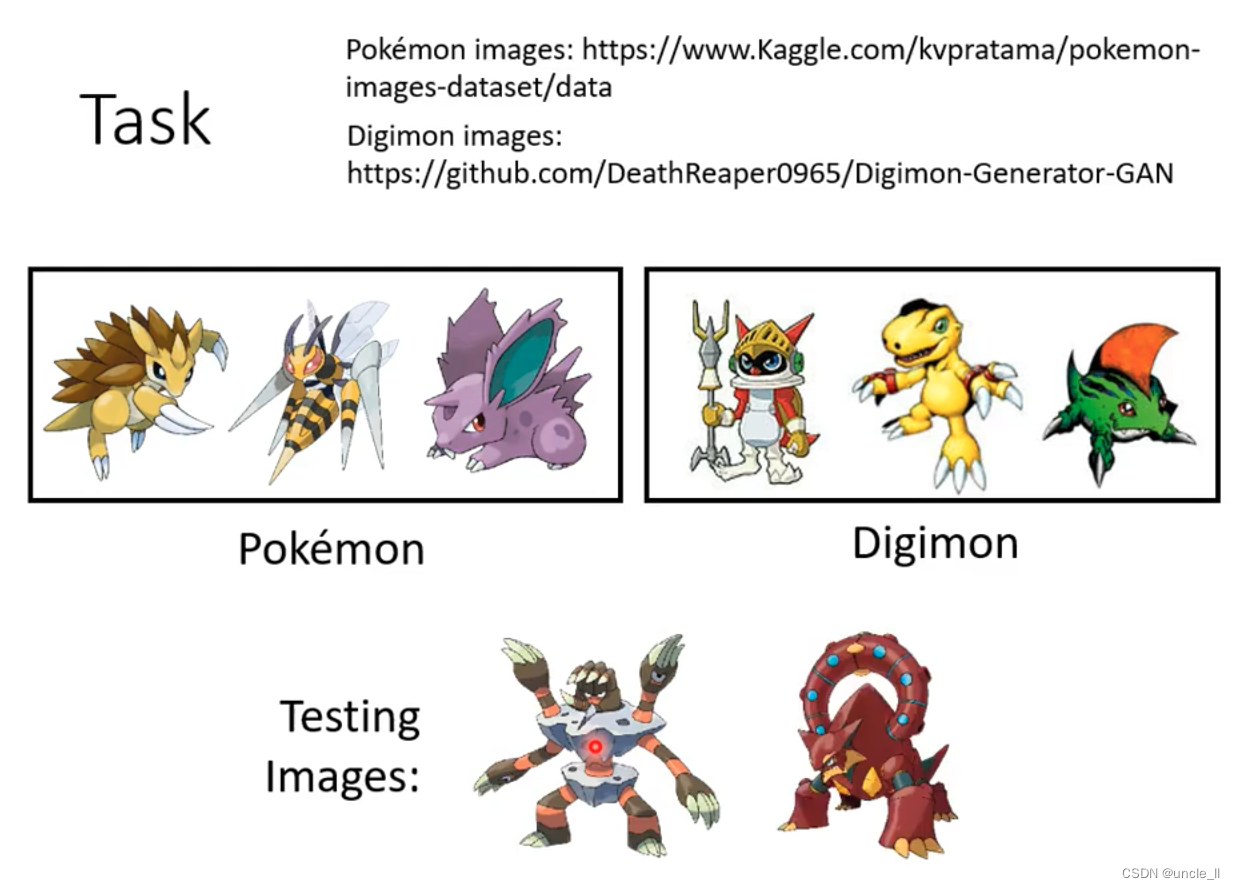

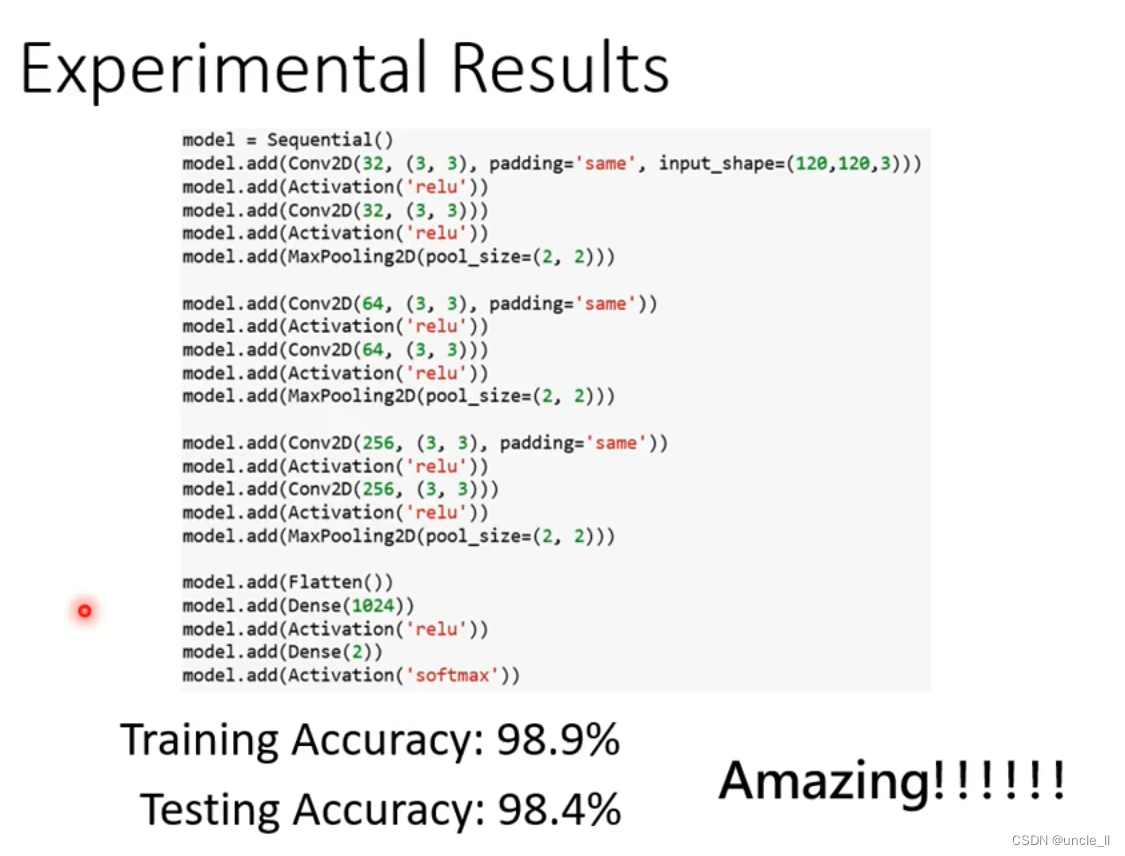

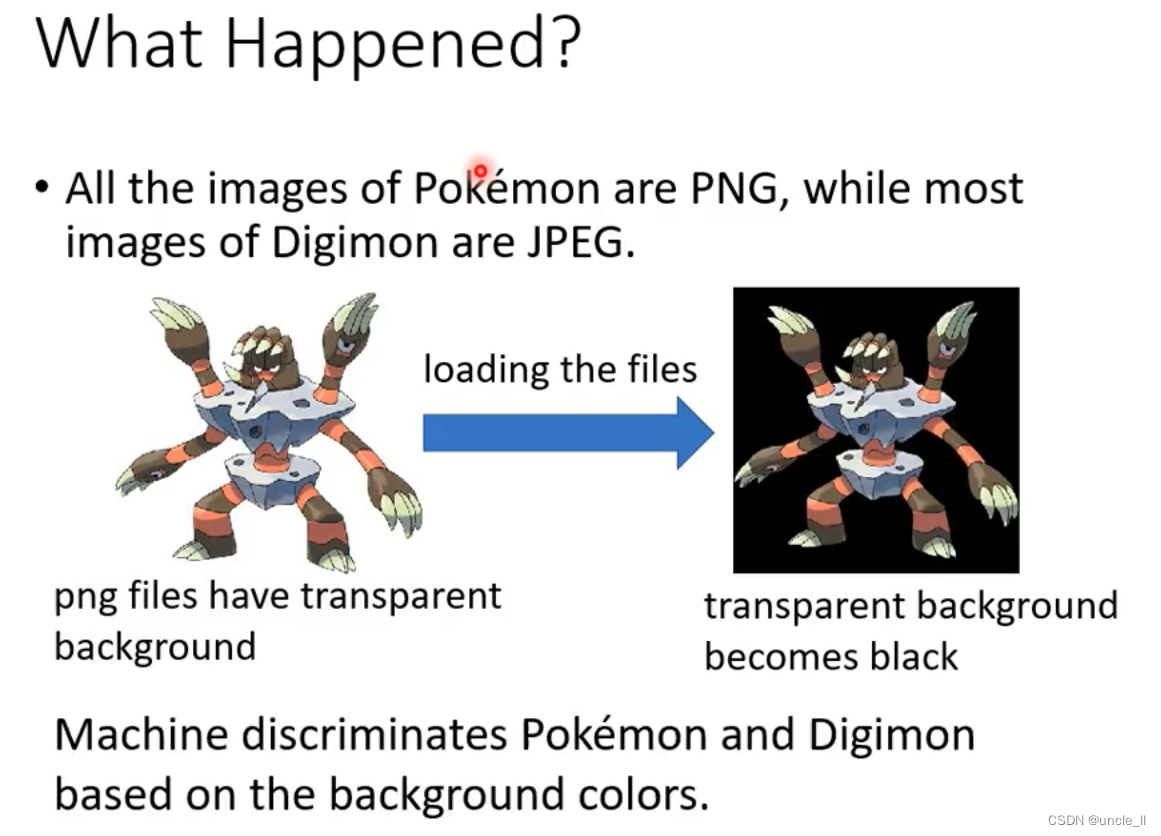

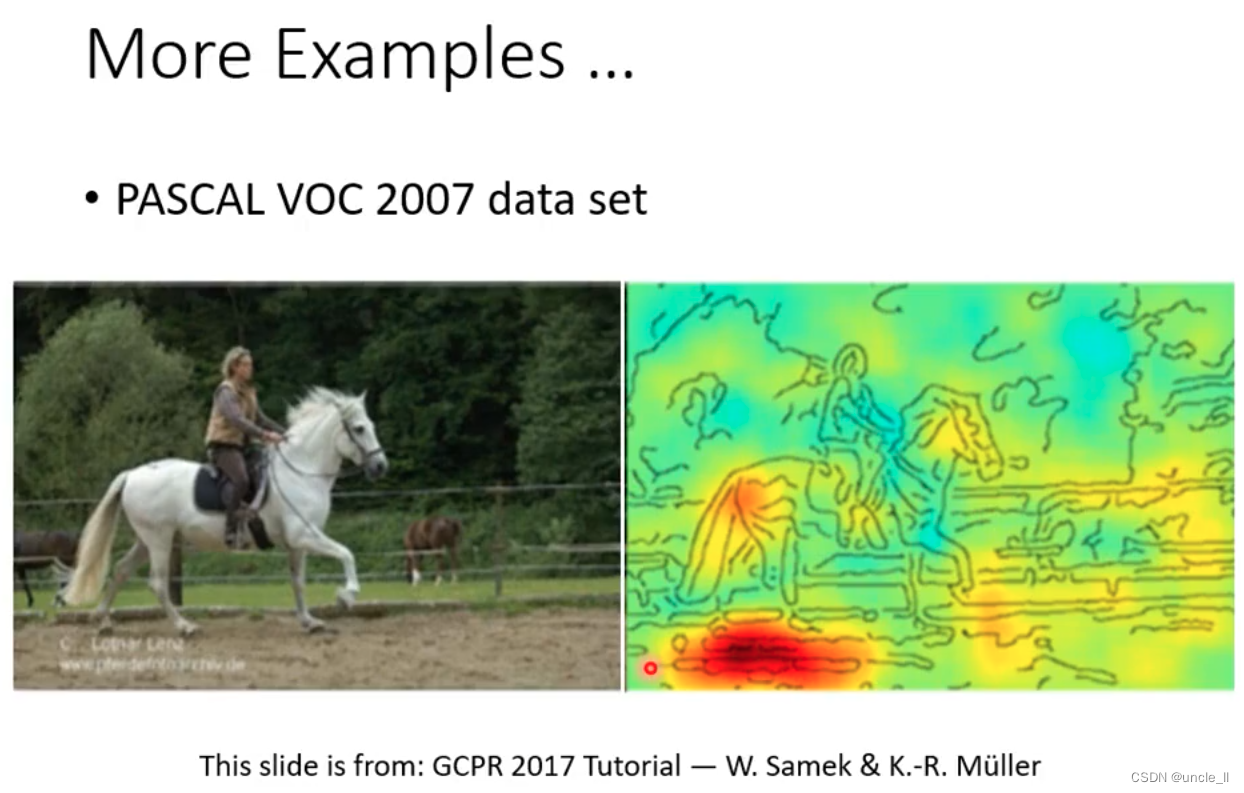

结果是图片格式导致的这种准确率,而不是真的学到了相关特征判断。

这个是学错了,觉得左下角的文字是更重要,只要有文字就判断为马。

SmoothGrad:加噪音并平均下来的结果,比原来的结果好。

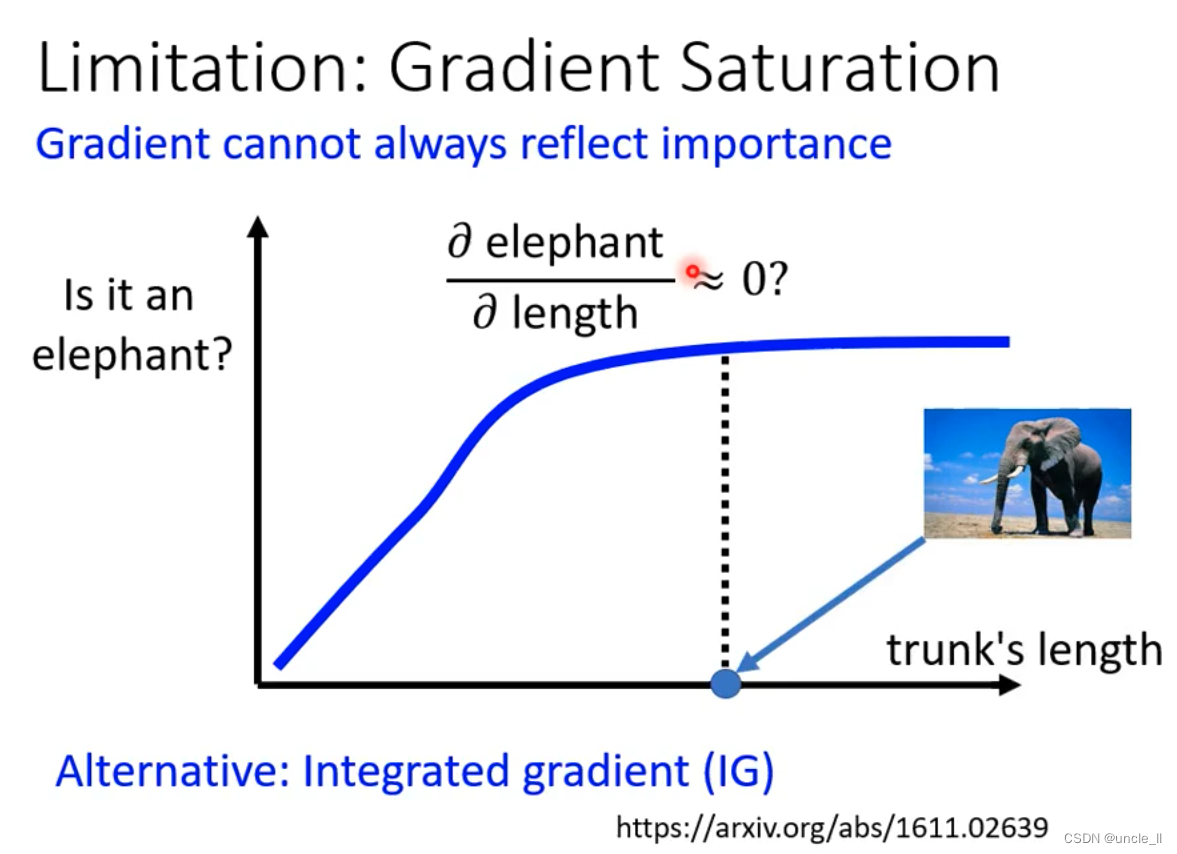

梯度色度的局限性

鼻子变长,越来越长也不会让人们觉得变得更像大象,只看偏微分的结果不足以告诉我们。

直接拿网络的输出可以明确的区分开来。

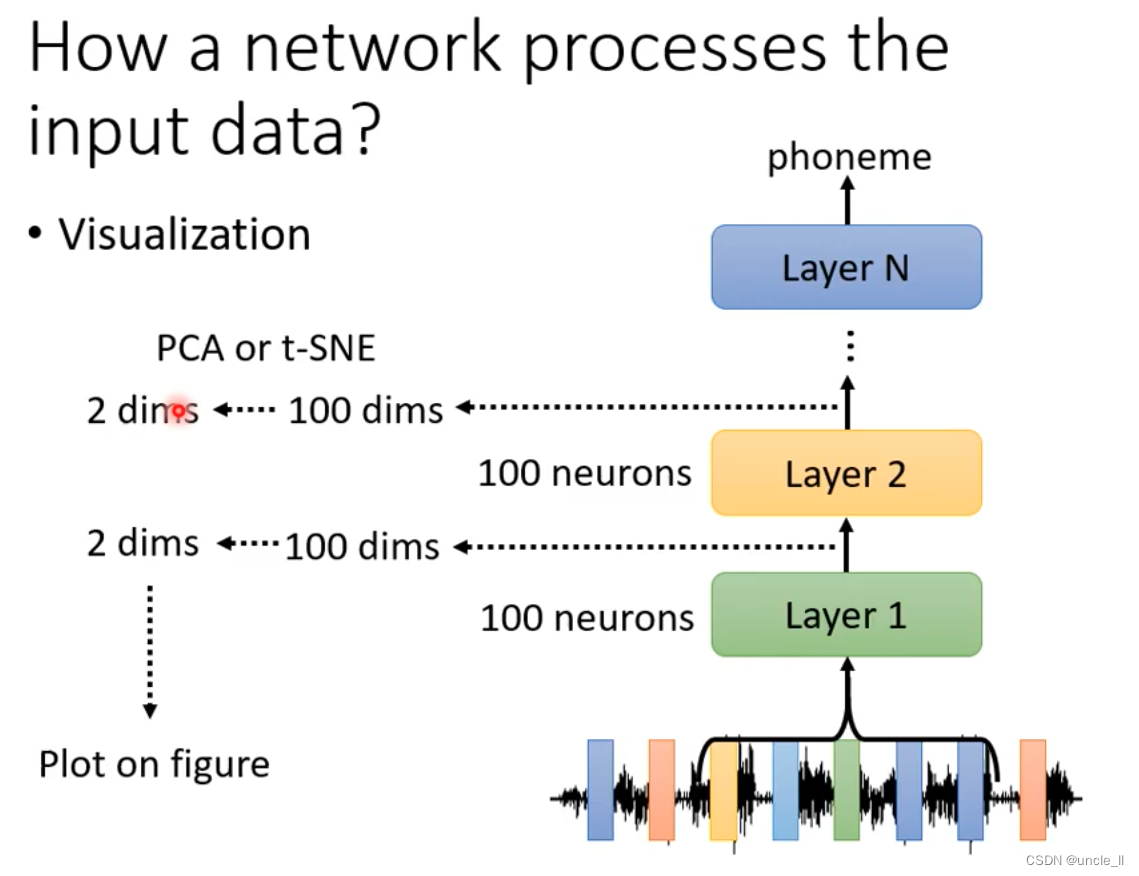

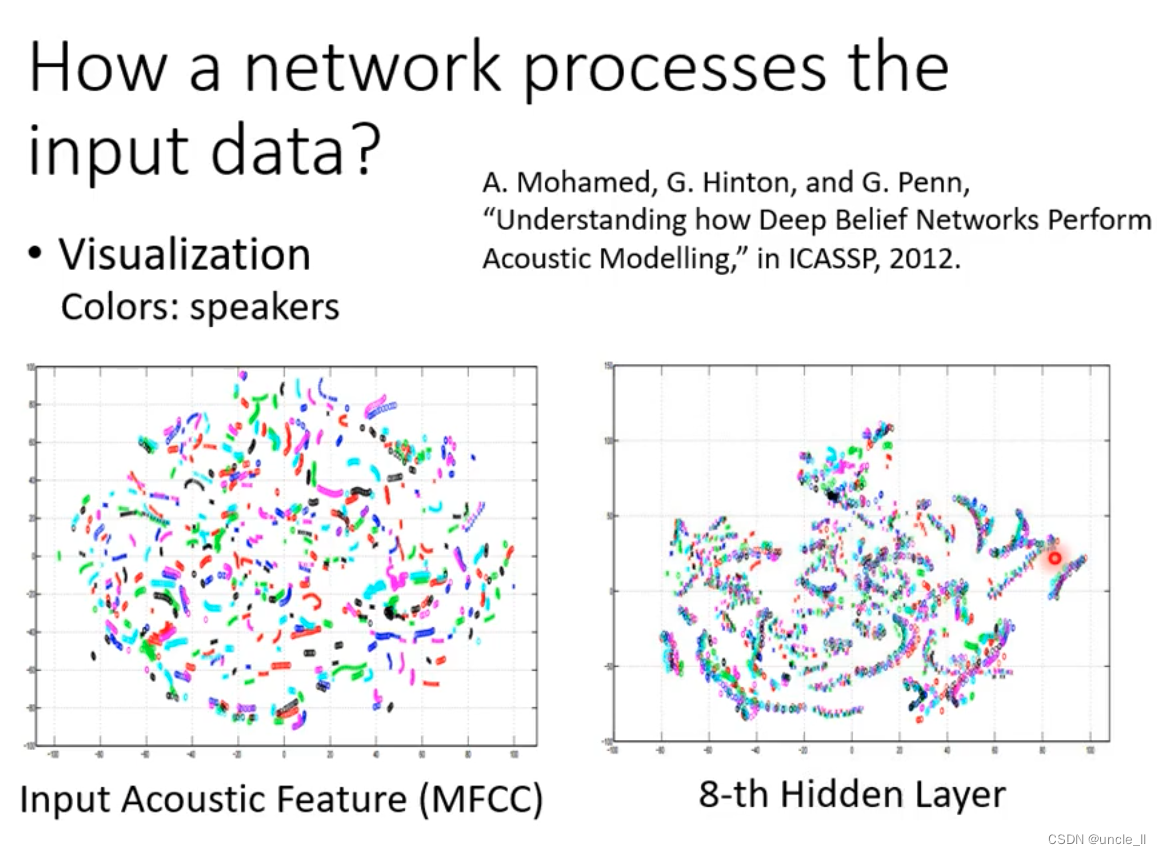

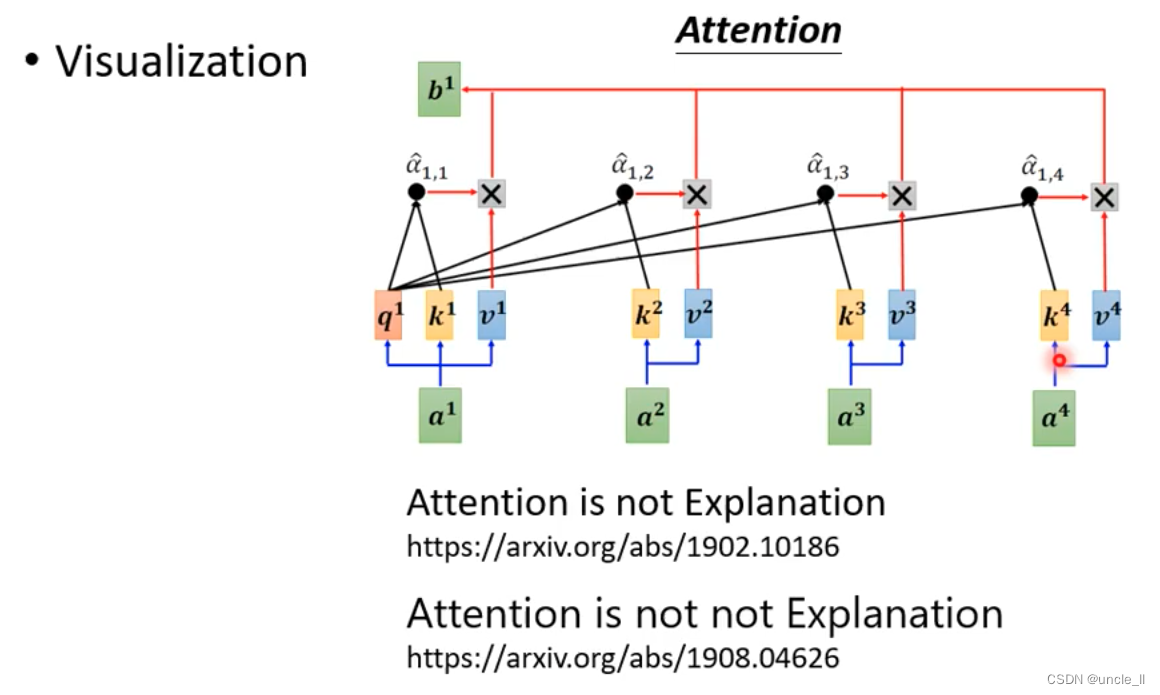

也可以看注意力部分的特征输出。

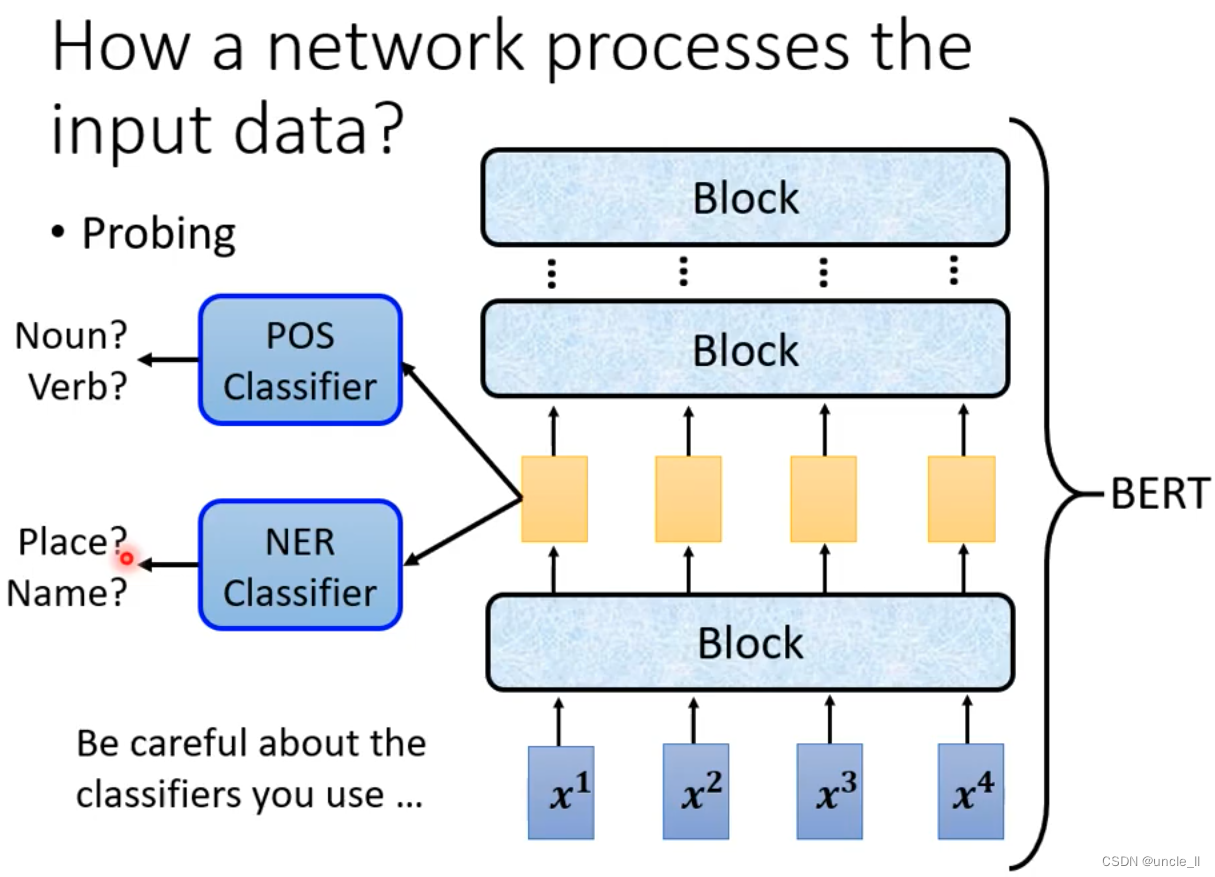

可以使用探针方式去查看想要看学习到的特征,要注意分类器的学习好坏,只有学习比较好的分类器能比较多表现出特征。

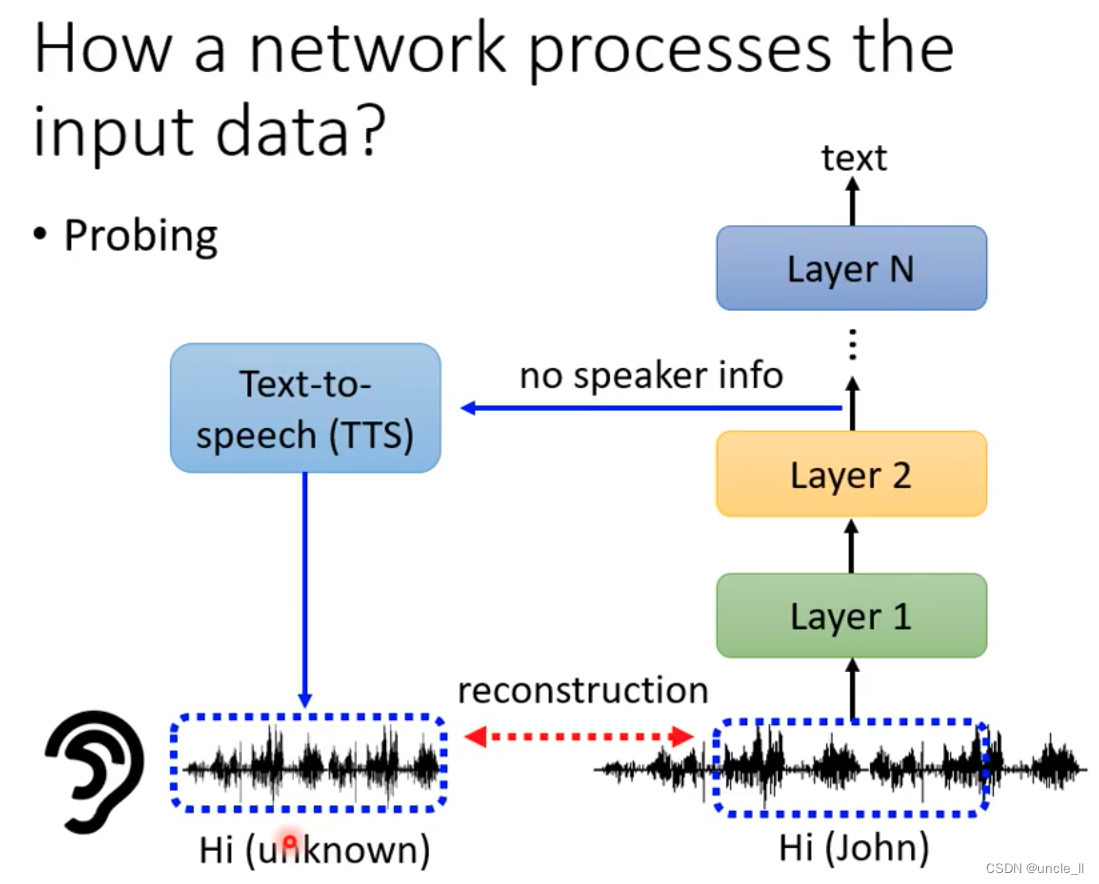

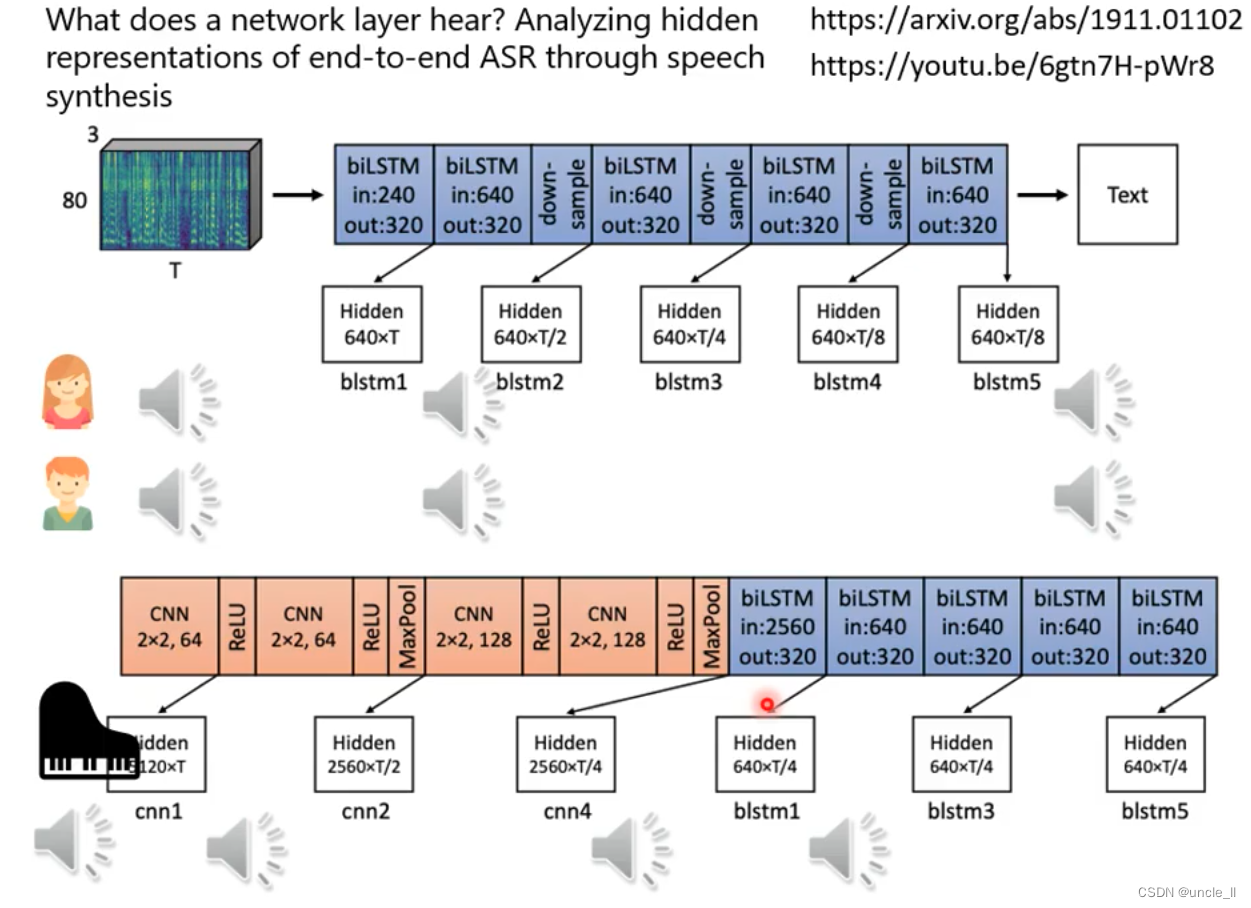

只保留了内容,而没有保留声音身份信息。

过滤掉女声男声,过滤掉杂音。

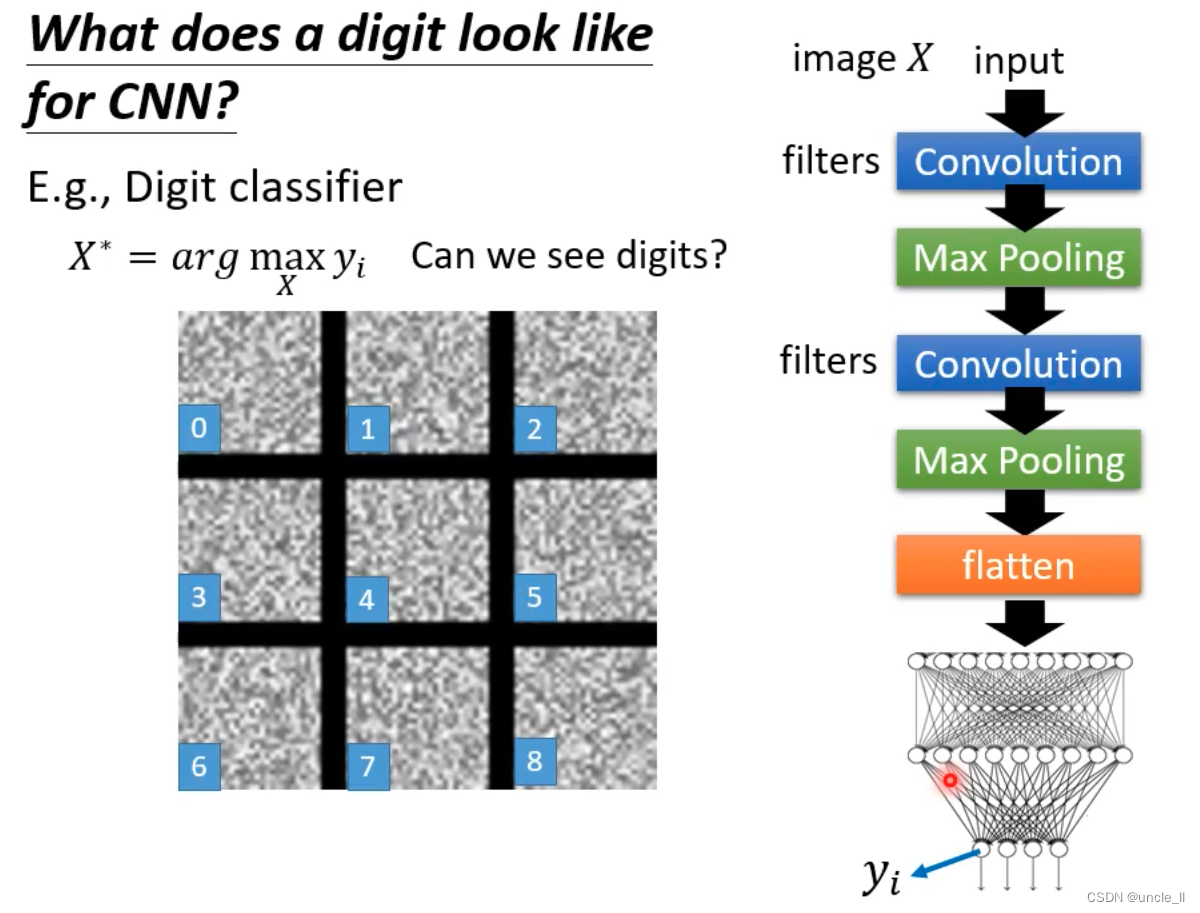

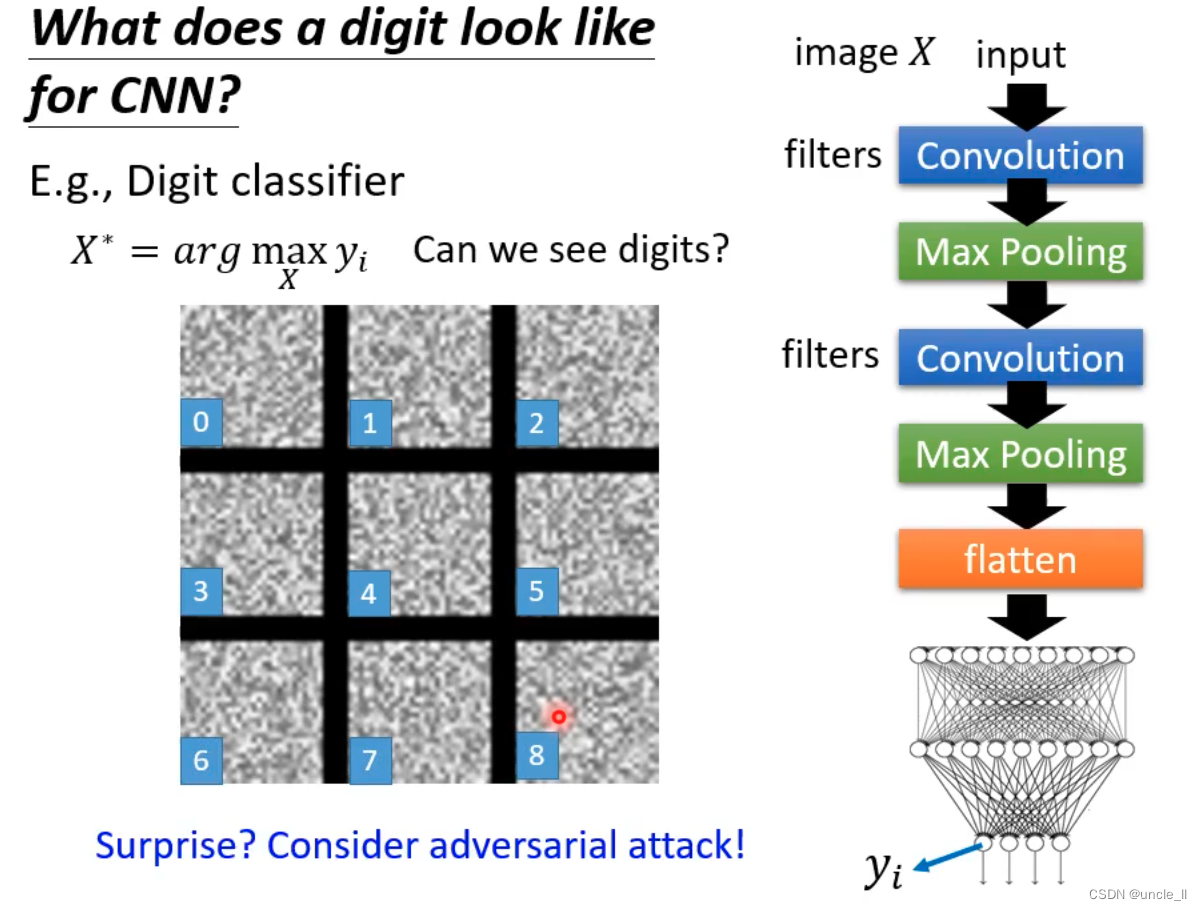

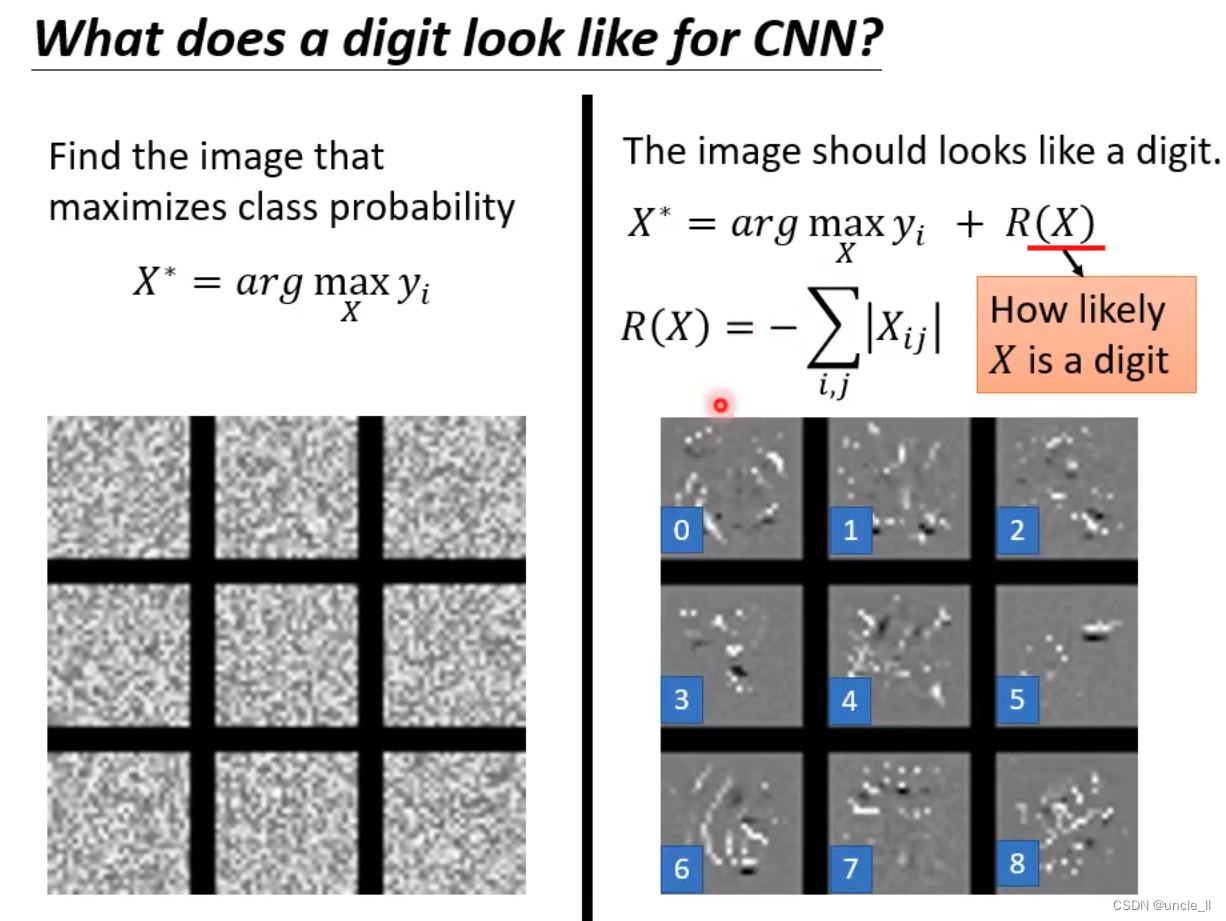

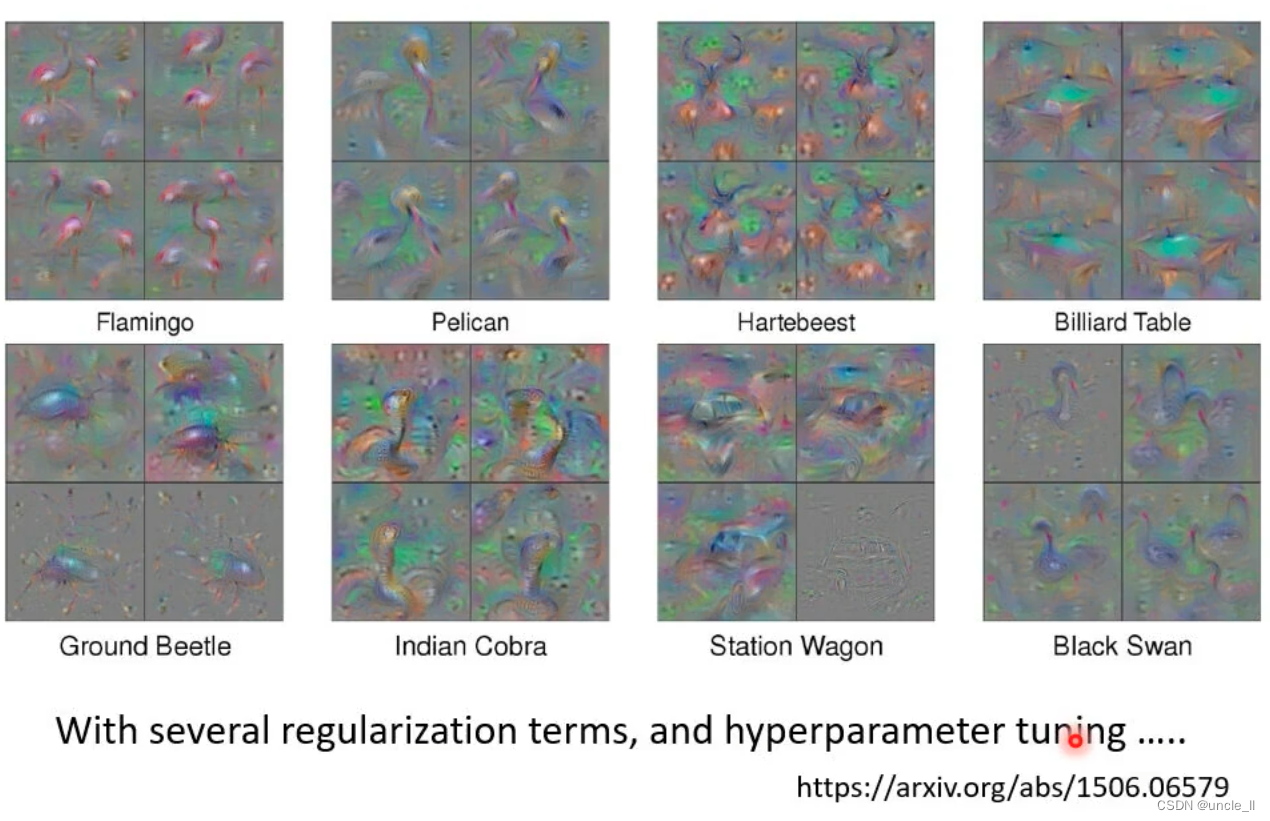

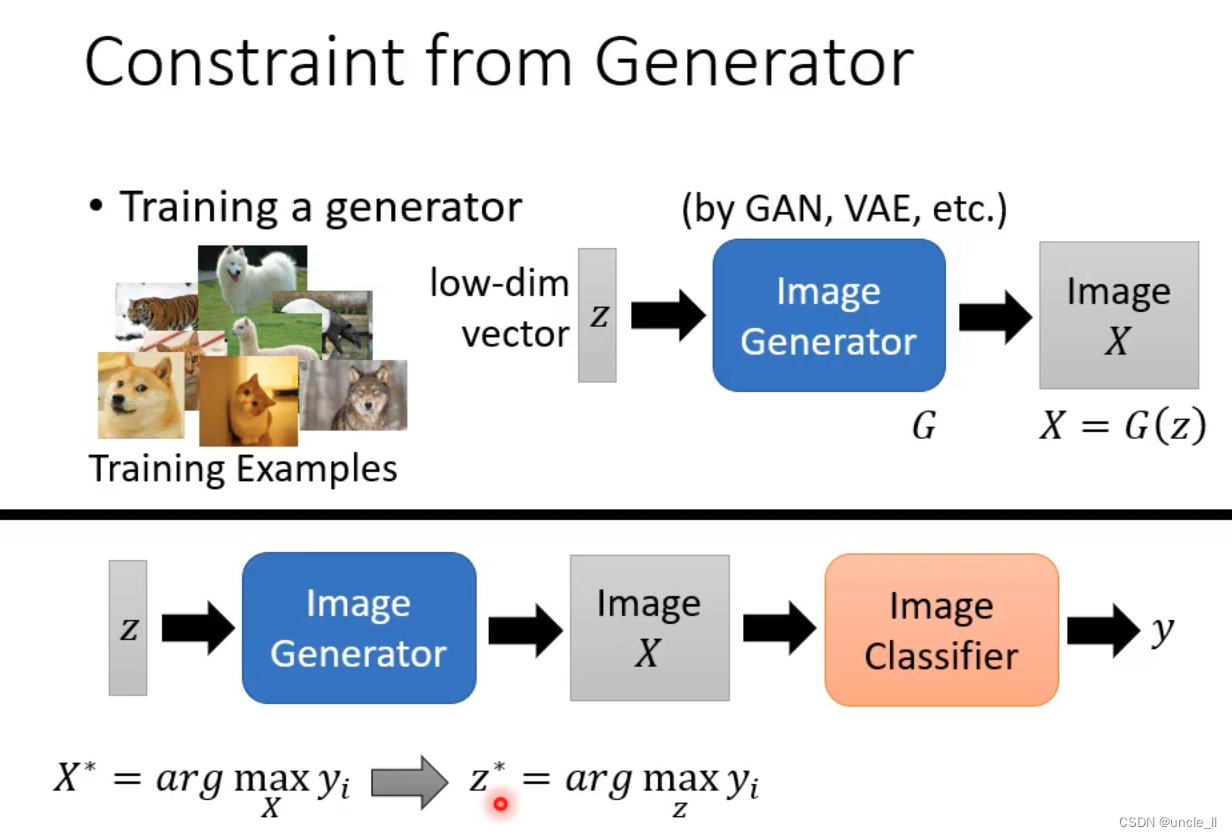

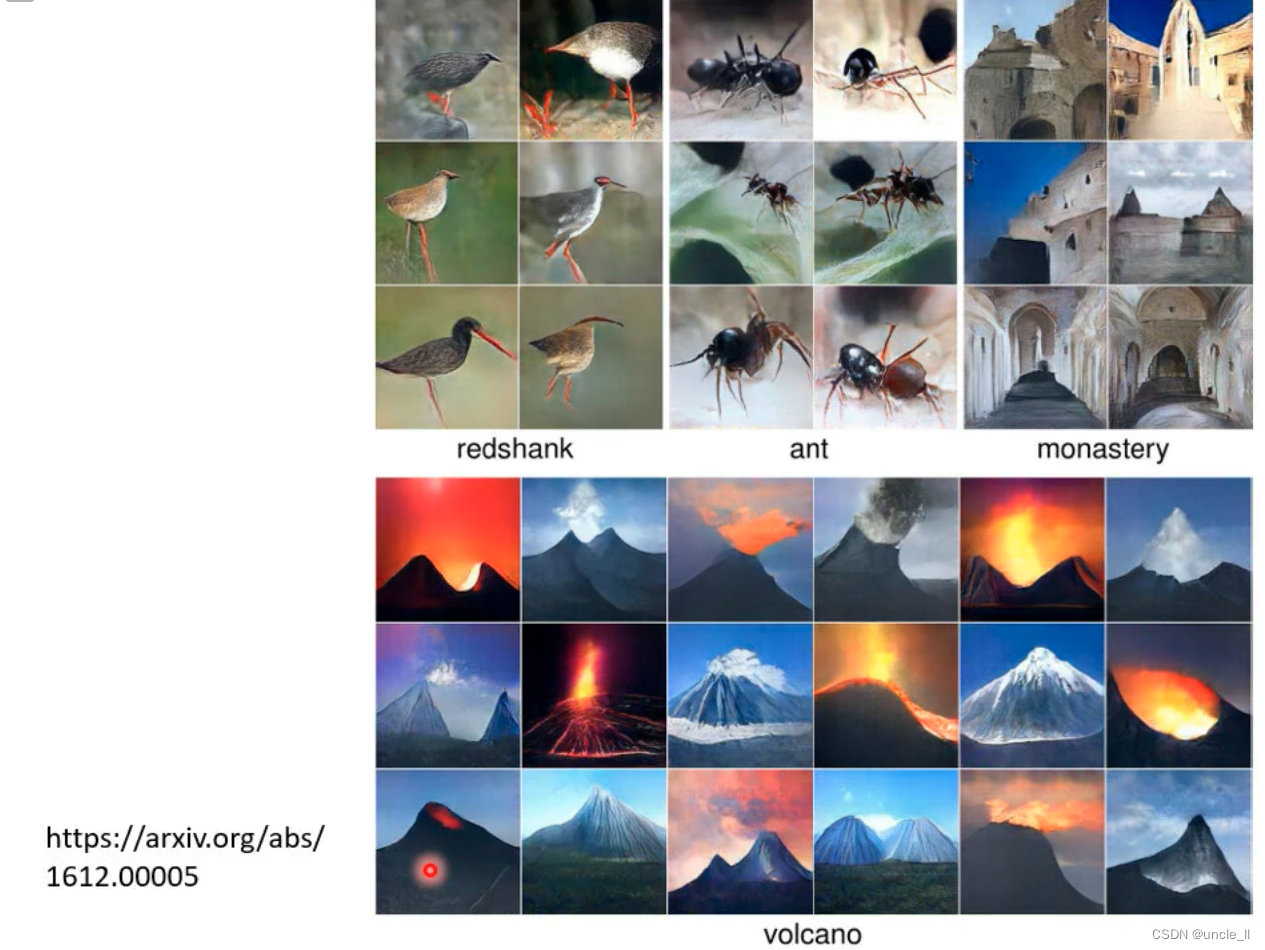

Global Explanation

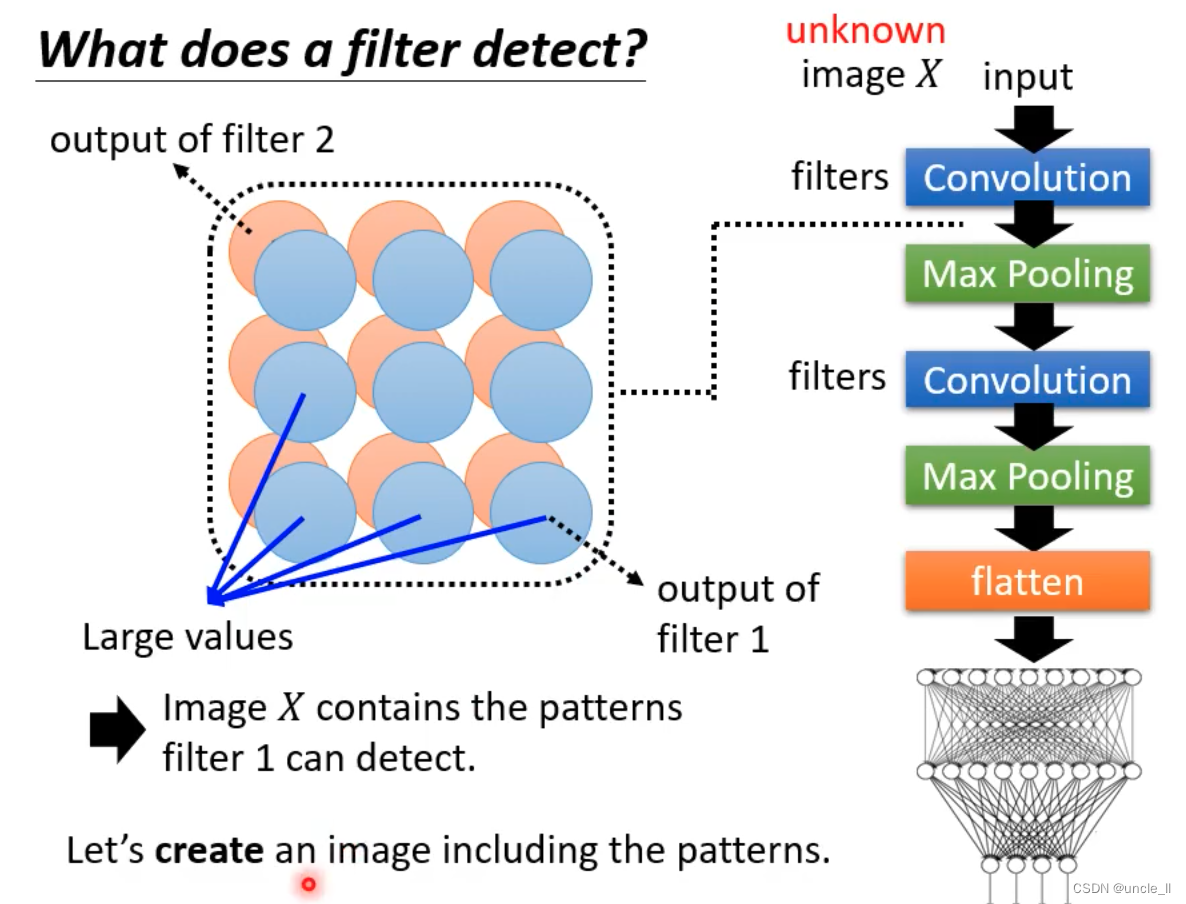

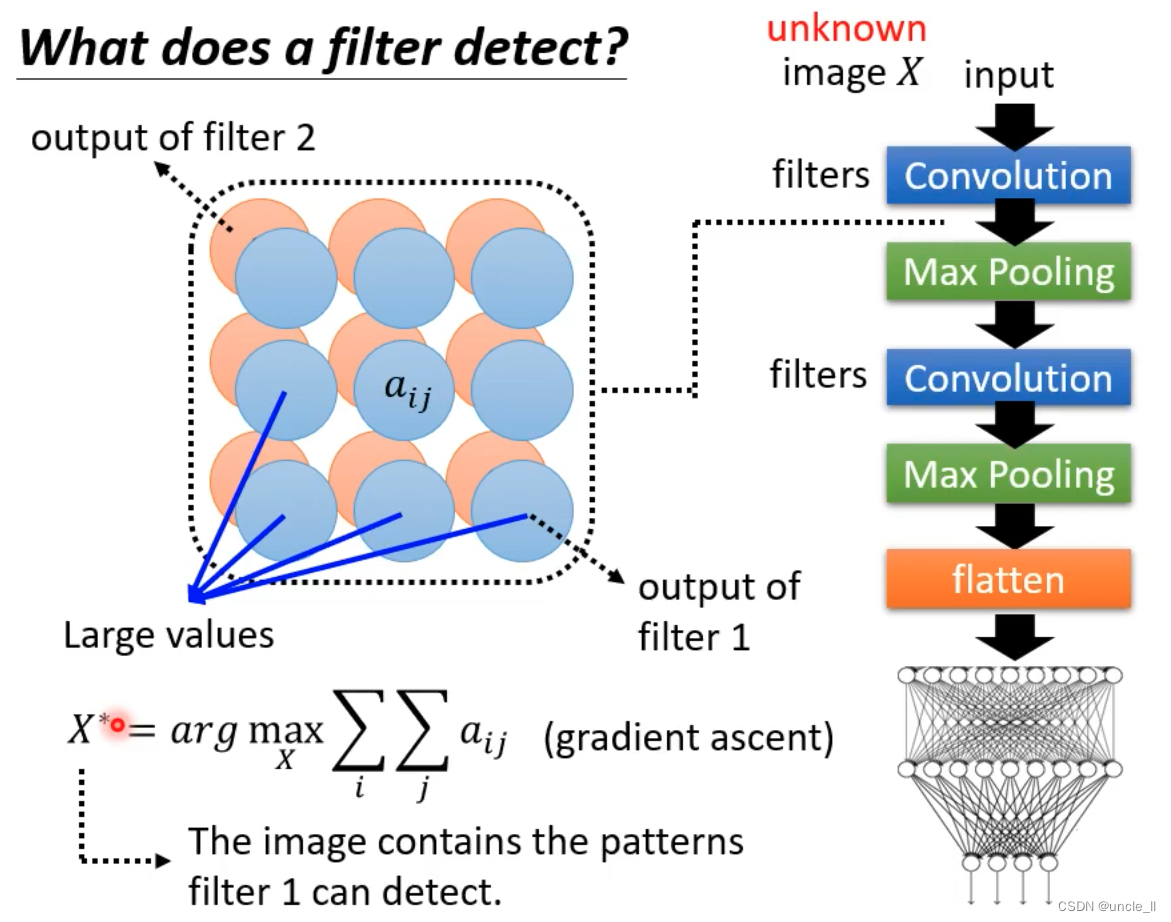

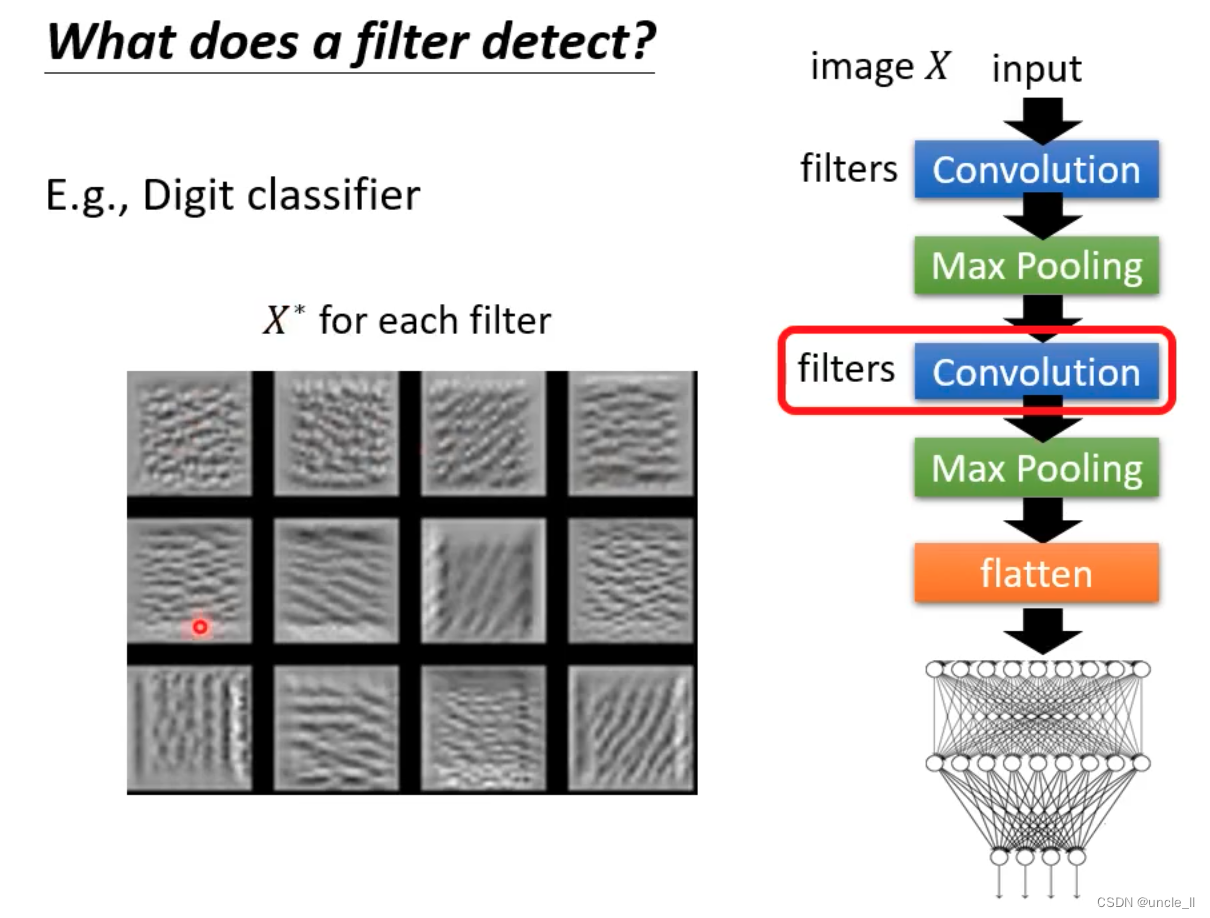

filter检测的内容不一样,某个笔画

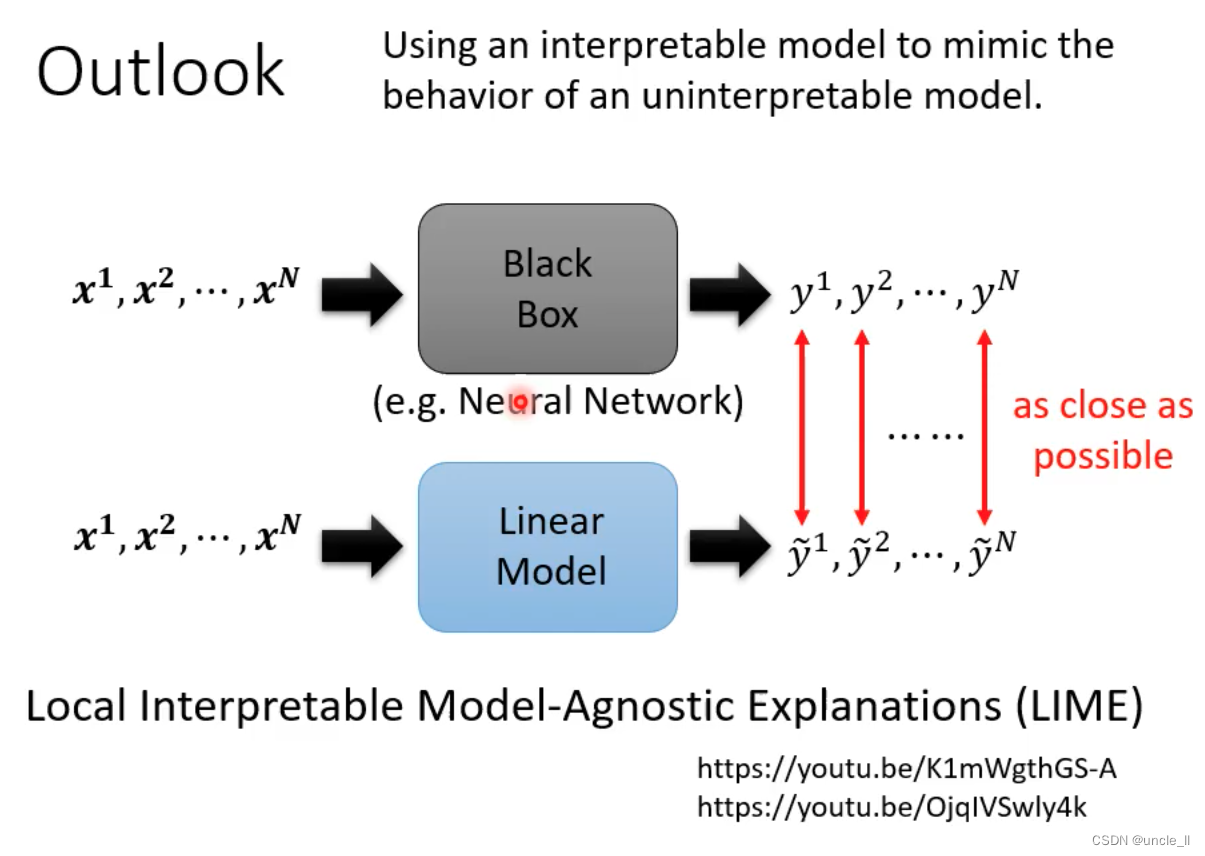

用小模型且可观察的模型去逼近复杂模型