逻辑回归(Logistic Regression, LR)模型是一个二分类模型,属于广义线性模型,它还有个名字叫做二项逻辑斯蒂(谛)回归(不知为什么加个斯蒂(谛)),虽然叫XX回归,但却不属于回归模型。

用概率的观点看待二分类问题,模型(这个模型是贝叶斯模型)的数学表示:P(Y|x)

类别y1的后验概率可以写成:

上下同除以

可进一步转换:取a

于是有:

可以看到a等于y1发生的概率与y2发生概率的比值(事件的几率)取对数,这里为什么取对数呢?……似乎为了引进sigmoid()函数(我曾经也被这样灌输过,那么为什么引进sigmoid()函数呢?………..),嗯,先放一放。

我们回过头来,根据朴素贝叶斯当y1类发生的概率大于y2类发生的概率时,为y1类,此时a>0(a

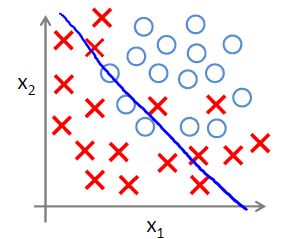

我们知道线性模型中,可分的超平面S:W*X+b=0,可以看作W*X,为直观感受,对二维平面的点进行分类,若W*X大于0,那么我们可以称为y1类,小于0,称为y2类,这是线性回归,

如果我们令a=W*X,这个模型正好可以满足,于是就把这个模型称为逻辑回归。

所以有:

在PRML书上也没具体说这个,直接把sigmoid引进作用在线性函数上,就称之为logistic回归,在《统计学习方法》上,直接来了定理,然后把对数几率作用在W*X上。在网上也看了好多资料,似乎也没讲清楚,都是引入sigmod()进来之后,再谈引入sigmod()函数的好处,不太严谨。

参考:《统计学习方法》,《模式识别与机器学习》