在surpervised question中

(x,y)表示一个训练样本。 x为features(特征)y为target(目标)

(xi,yi)表示训练集。上标i just an index into the training set

Hypothesis function(假设函数):

Hypothesis function : hθ(x) =θ0+θ1x.

Hypothesis function是关于变量x的函数

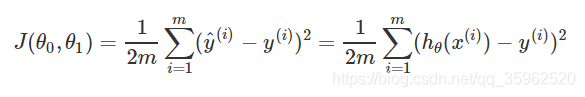

cost fuction(代价函数)

概况来讲,任何能够衡量模型预测出来的值h(θ)与真实值y之间的差异的函数都可以叫做代价函数C(θ),如果有多个样本,则可以将所有代价函数的取值求均值,记做J(θ)。

cost fuction是关于parameters的函数

平方误差代价函数是解决回归问题最常用的手段,具体定义如下:

找到是训练集中预测值和真实值的差的平方和最小的1/2M的θ0和θ1的值

假设有训练样本(x, y),模型为h,参数为θ0,θ1。hθ(xi) =θ0+θ1xi.

优化目标: 求使得J(θ0,θ1)最小的parameters:θ0,θ1。此时求得目标函数

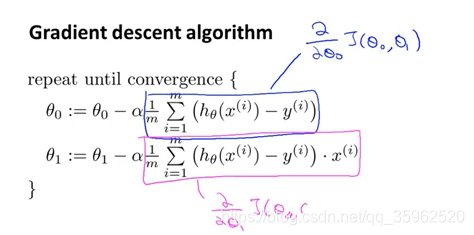

梯度下降法:(grandient descent)

给θ0,θ1赋予某一个初值进行出发 直到收敛于某一个局部最小解

算法过程:重复下列迭代

其中:=表示的是复制,α表示学习率(控制以多大的幅度更新参数)通俗讲,用于表示下降的步伐。

特别注意:θ0,θ1需要同时更新

α太小:需要进行多次梯度下降

α太大:可能越过最小点,导致无法收敛甚至发散

一个特点:在梯度下降法中,当我们接近局部最低点时,梯度下降法自动采取更小的幅度(曲线越来越平缓导致导数也越来越小)

线性回归算法:

(将梯度算法与代价函数相结合拟合线性函数)

求导:

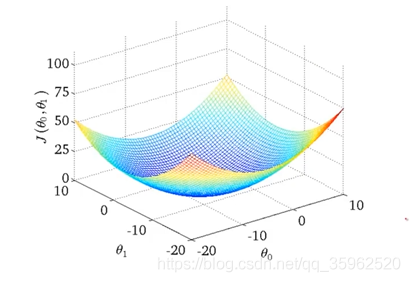

线性回归的代价函数总是像一个弓状函数如下所示。叫做凸函数(convex function)

此类函数没有局部最优解,只有一个全局最优。

”batch“gradient descent