参考:7月算法——邹博关于回归的讲义

1:线性回归

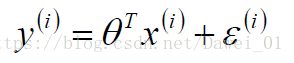

线性回归是求一个参数theata ,去拟合大部分样本,线性回归表达式:

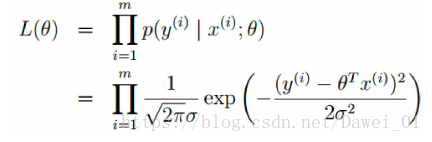

2:用极大似然估计解释最小二乘法:

函数值可以写为:

表示误差,根据中心极限定理,

是独立同分布的,服从均值为0,方差为某个定值的

^2的高斯分布。

那么,关于误差的似然函数公式为:

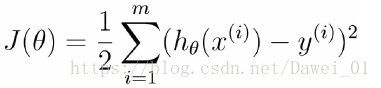

3:高斯的对数似然与最小二乘:

我们要最大似然,即求J(theata)最小:

对J求梯度,求解theata:

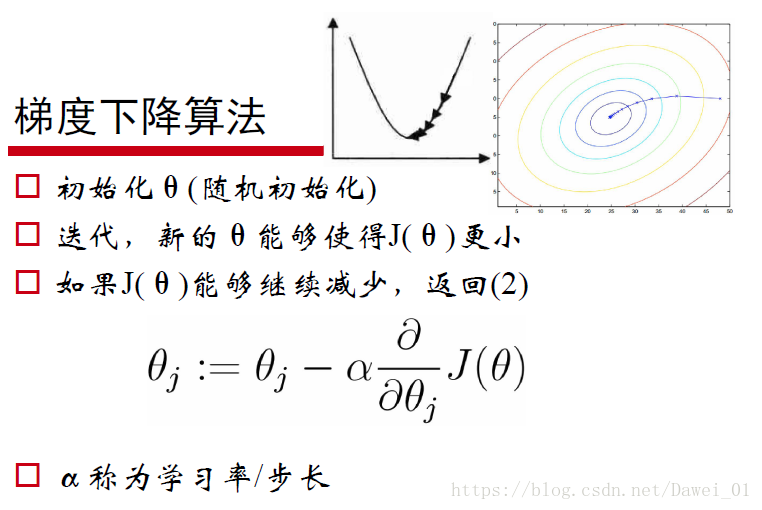

4:因为直接求均矩阵的逆在工程上开销比较大,我们实际代码中一般采用梯度下降算法求解theata的值,

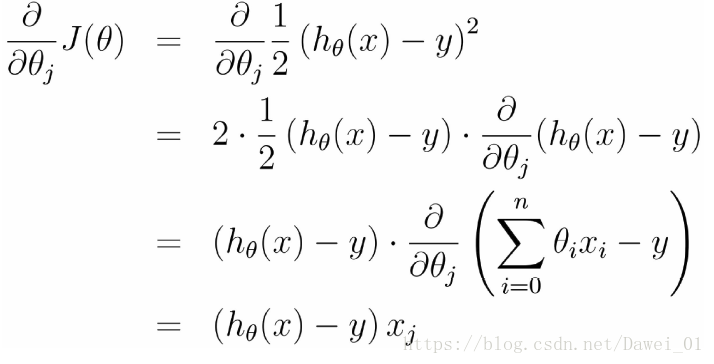

梯度方向计算:

5:Logistic 回归

5.1 logistic函数,也称为sigmid函数:

因此,logistic回归表达式为:

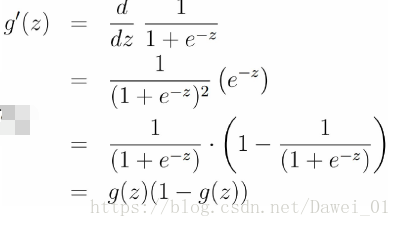

sigmid函数有一个特性,其导数g(z)=

5.2 logistic 参数估计

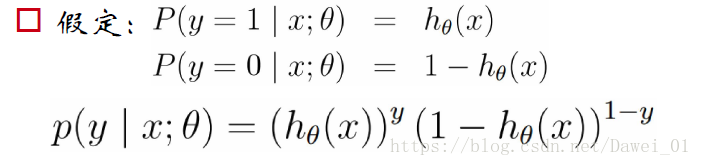

假定数据分布符合二项分布,

5.3 似然函数

5.4 梯度下降求解: