结巴分词的过程:

jieba分词的python 代码

结巴分词的准备工作

开发者首先根据大量的人民日报训练了得到了字典库、和Hmm中的转移概率矩阵和混淆矩阵。

1. 加载字典, 生成trie树

为什么要加载字典树呢,是因为如果没有字典树,那么扫描将会是一个庞大的工程,有了字典树就可以在该分支上扫描。例如扫描“中国人民银行”(正向最大匹配)先扫描6个字的字典库,找到了“中国人民银行”,然后再去掉一个字变成了“中国人民银”,假如没有字典树的话,就会把所有五个字的字典库搜索一遍。但是现在就不会了,只要把“中国人民”和“中国人民银行”之间的节点搜索一遍就行了,大大的节省了时间。有句话叫以空间换时间,最适合用来表达这个意思。

2. 给定待分词的句子, 使用正则获取连续的 中文字符和英文字符, 切分成 短语列表, 对每个短语使用DAG(查字典)和动态规划, 得到最大概率路径, 对DAG中那些没有在字典中查到的字, 组合成一个新的片段短语, 使用HMM模型进行分词, 也就是作者说的识别新词, 即识别字典外的新词.

本人理解:先进行扫描分词,然后切成很多的句子,每个句子再利用动态规划找出最大概率路径(消除歧义)。

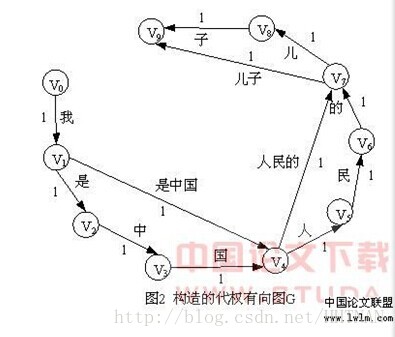

(1) 关于有向无环图(见下图):有方向没有回路。

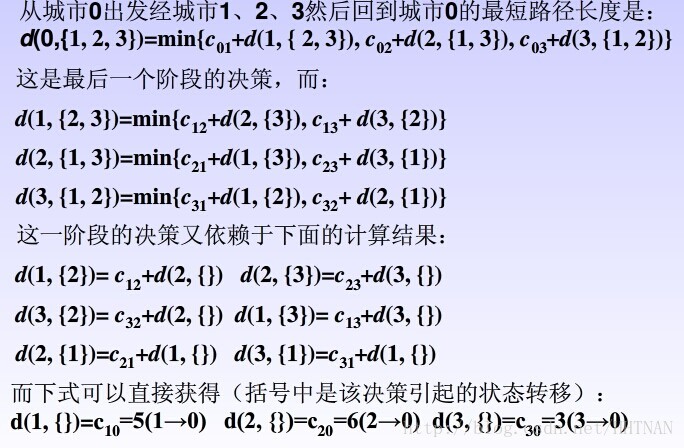

(2) 用动态规划查找最大概率路径问题理解

从上图可以看出切词之后,有多条路径,也就是说有歧义。这里采用动态规划的最优化搜索。

动态规划问题:

1 将原问题分解为若干个相互重叠的子问题

2分析问题是否满足最优性原理,找出动态规划函数的递推式;

3利用递推式自低向上计算,实现动态规划过程。