特征选择从多个特征中选出对学习有用的特征以实现降低维度,增加准确率的目的。

选择子集和对子集进行评价是重要的两步,本章主要介绍了过滤式选择,包裹式选择以及嵌入式选择等方法:

过滤式选择利用相关统计量在学习器之前直接对特征进行选;

包裹式选择利用,随机得到候选子集并带入学习器验证正确率,在学习器层面完成特征的选择;

嵌入式则直接将特征的选择嵌入目标函数,在对目标函数的学习过程中,完成对特征的选择。

ps.在嵌入式学习中,通过L1正则化的嵌入,说明了LASSO函数,并给出了近端梯度下降(PGD)的算法

稀疏学习是通过对应的稀疏表示来降低学习任务的难度,字典学习是一种典型方法。

通过建立一个常用字典表来将稠密表达稀疏化,需要完成对字典的学习以及对稀疏表示的学习,可以利用类似追赶法的思想,同时在对字典矩阵求解时,采用KSVD(逐列更新)在矩阵的列中同样实行类追赶法。

压缩感知:根据被压缩的信息来复原完整的信息

考虑到方程的欠定性,需要对方程实行稀疏化,求解其稀疏矩阵并转换成L1范数最小化问题

矩阵补全:如何通过局部信息复原全局信息

在保证原有信息的情况下,通过最小化最终矩阵的秩,实现复原

11.1 子集搜索与评价

相关特征:对当前的学习任务有用的特征;

无关特征:对当前的学习任务无用的特征;

冗余特征:可以被其他特诊表示的特征。

目标:找到相关特征构成的集合,实现降低维度,增加准确率的目的。

问题:如何去寻找最优的子集?如何评价子集的优良?

子集搜索:以迭代的方式,通过不断的增加(减少)新的特征来找到最优子集。

增加:已得到子集A,未处理子集B,AUB=全集 ,A∩B=∅,从B中依次尝试选出一个特征,加入A中得到C,对所有C进行对比,如果有C的效果大于A,那么就加进去,不断重复。

减少:已得到子集A,被舍弃子集B,AUB=全集 ,A∩B=∅,从A中去除某个特征得到C,如果C大于A,那么就去除,不断重复。

子集评价:评价当前选出的特征对于分类的作用。

纯度:信息熵,信息增益。。。

借鉴之处:子集搜索中的类似追赶法的思想。

11.2 过滤式选择:对特征直接进行选择,不考虑后续的学习器。

这个方法的计算花销比较小,但是结果可能不能很好的吻合实际的目标。

Relief(Relevant Feature)方法:设计一个相关统计量来实现对特征的选择

对每个实例x,都寻找一个同类最近样本(猜对样本)和一个异类最近样本(猜错样本),然后对其中某个属性,判断猜对样本与猜错样本和x在该属性上是否相同,异类的得分为负,最后如果得分为正,那么说明该属性对于分类是有利的。

11.3 包裹式选择:在最后的学习器中计算特征的有效性,让特征尽可能的符合所求的目标。

LVW(Las Vegas Wrapper):不断循环,在每轮循环中,随机产生子集,并在最终的目标学习器上进行验证,如果结果更好或者结果相当,但是特征更少,那么就保留。

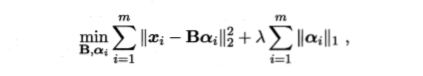

11.4 嵌入式与L1正则化:将对特征的选择直接嵌入目标表达式(通过正则表达式),在求解目标函数时完成特征的选择

相较于L2正则化,L1正则化更加的稀疏,同时L1正则化可以使用近端梯度下降求解

近端梯度下降(Proximal Gradient Descent,简称PGD):通过导数的概念,在满足L-Lispschitz条件下(导数的模不大于某个常数),利用泰勒展开以及导数的性质,找到近端的一个迭代变量对自变量进行不断迭代,趋近于函数的目标。

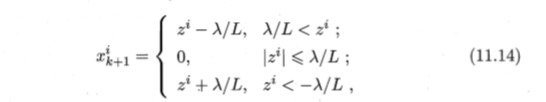

事实上,对于形如11.13的式子**(这个式子去掉arg称为LASSO)**都存在11.14的解

11.5 稀疏表示与字典学习

通过找到合适的字典,将样本转化为合适的稀疏表示形式,完成学习任务的简化。

其中B表示字典矩阵,一列为一个字母,一行为一个文档,而α是样本的稀疏表示,同时存在两个变量,可以利用类似追赶法。

(1)先固定B,对α进行学习,利用近端梯度下降法,可以完成

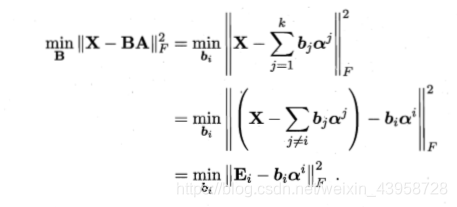

(2)固定α,对B进行学习,可以采用KSVD,对B按照列的顺序,先求其中一列,固定其他列。

则对E进行奇异值分解,取得最大奇异值对应的正交向量即可。但是考虑到α是稀疏表示的矩阵,biai相乘得到的是稀疏表示(只有一个元素),如果直接对E进行奇异值分解,那么得到的系数系数α的稀疏性可能被破坏,因此只E中与其中α非零的列的同列进行处理,再对后续区域进行补零操作。

11.6压缩感知:利用信号本身具有的稀疏性,从部分观测样本中回复原信号。

奈奎斯特采样定理:令采样频率达到模拟信号最高频率的两倍,则采样后的数字信号就保留了模拟信号的全部信息。

其中y表示最后得到信号的矩阵(n1),φ表示信号的测量矩阵(nm),x表示原信号的矩阵(m*1),其中m远大于n,因此这是一个欠定方程,无法轻易求出解,所以转换成 其中δ是某个线性的变化,而s表示的是一个稀疏矩阵,此时若满足一定的条件(限定等距性:输入和输出能量之比在一定范围内),则可将问题转换为最小化问题,变成LASSO的等价形式再通过近端梯度下降求解,整个方法称为“基寻踪去噪”。

应用:矩阵补全,通过已知信息完成对系数稀疏矩阵的补全

目标为得到的补全结果的秩尽可能低,同时维持已有信息不变,这个NP难问题的解决方法是将目标转换为矩阵的奇异值之和。