首先在命令行中以管理员的身份下载并安装requests库

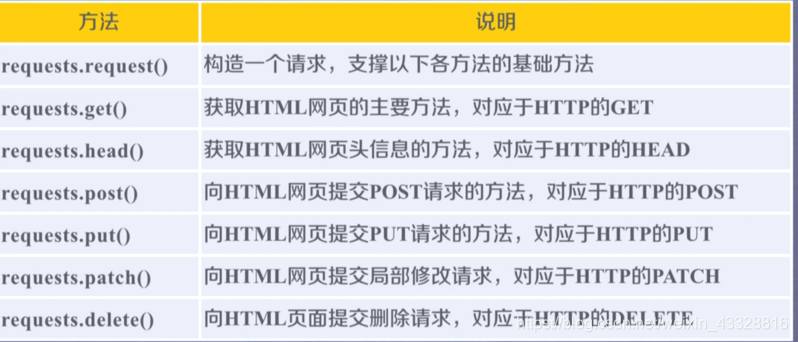

requests库的7个主要方法:

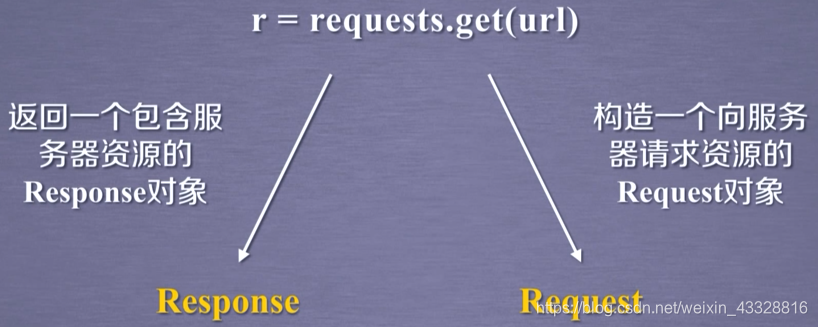

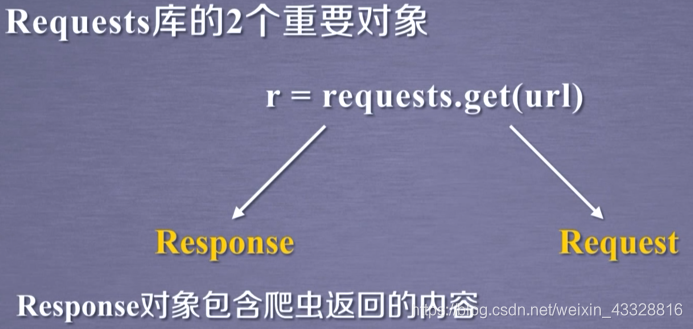

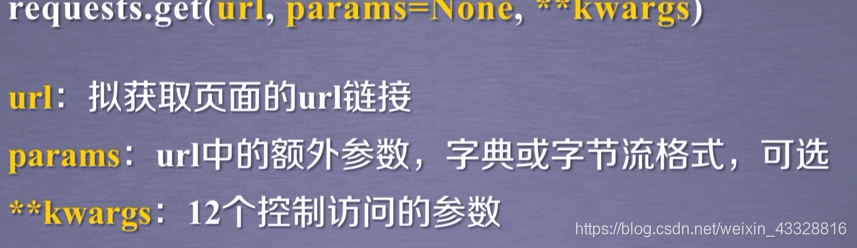

requests.get()方法及介绍

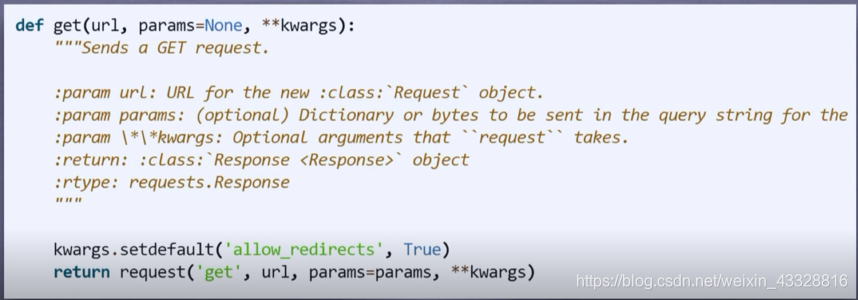

**request.get(url,params=None,kwargs)

url:获取页面的url链接

params:url中的额外参数,字典或字节流格式,可选

**kwargs:12个控制访问的参数

源代码:

requests库的各种函数均是通过调用request方法来实现的

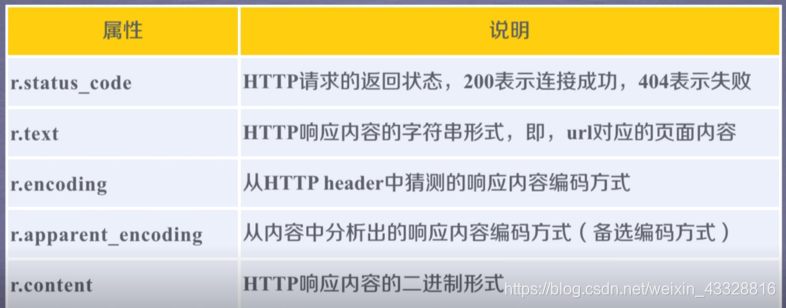

Response对象的属性:

不仅仅是404才算失败,只要不是200,均为失败

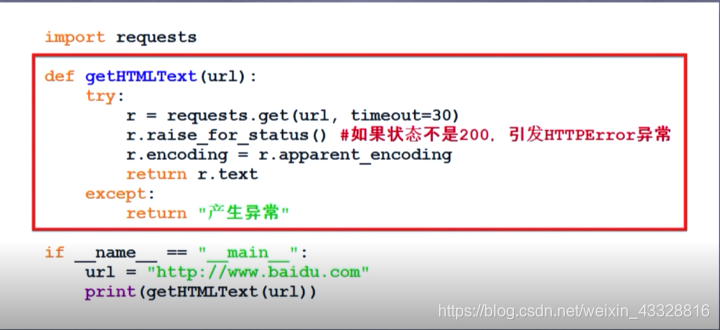

爬取网页的通用代码框架

Requests库的异常处理:

r.raie_for_status() 如果不是200,产生异常requests.HTTPError

判断返回respond类型r状态是否200

通用代码框架即为红色线内的内容:

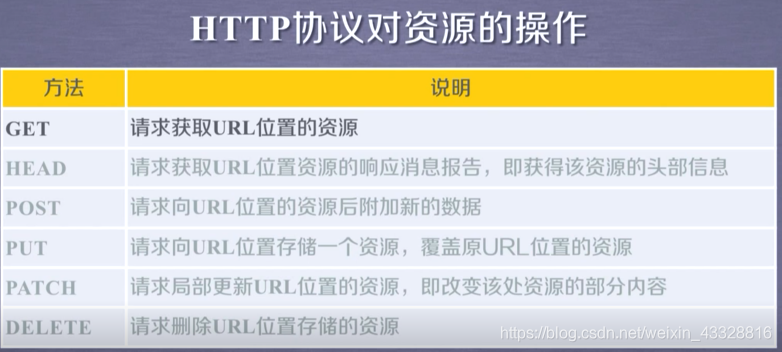

http协议以及requests库方法:

HTTP协议:

URL格式:http://host[:port][path]

host:合法的Internet主机域名或者ip地址

port:端口号,缺省端口为80

path:请求资源的路径

URL是通过HTTP协议存取资源的Internet路径,一个URL对应一个数据资源

HTTP协议方法和Requests库方法的功能是一致的,即一一对应。

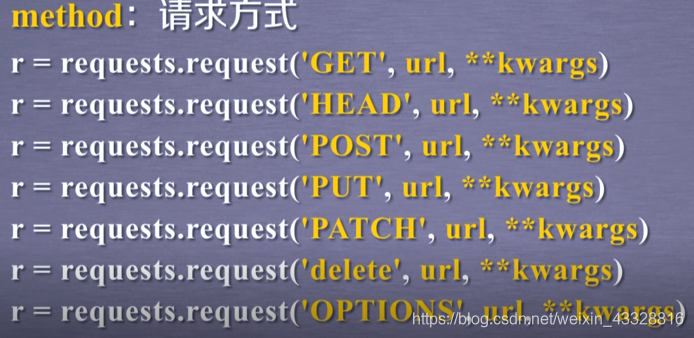

requests库的7个主要方法:

requests.request():构造一个请求,支撑以下各方法的基础

requests.get()获取HTML网页的主要方法,对应于http的get

requests.head() 获取HTML网页头信息的方法,对应于http的HEAD

requests.post()向HTML网页提交POST的请求方法,对应与http的POST

requests.put()向HTML网页提交PUT 请求方法,对应于http的PUT

requests.patch()向网页提交局部修改请求,对应于http的PATCH

requests.delete()向页面提交删除请求,对应与http的DELETE

request是所有方法的基础

requests.request(method,url,**kwargs)

method:请求页面的方式,对应于get/put/post等7种

url:获取页面的url链接

**kwargs:控制访问的参数,共13个

**kwargs:控制访问的参数,均为可选项

params:字典或者字节序列,作为参数增加到url中

data:字典、字节序列或者文件对象,作为request的内容

json:JSON格式的数据,作为request的内容

headers:字典,HTTP的定制头

cookies:字典或cookiejar,request中的cookie

auth:元组,支持HTTP认证功能

files:字典类型,传输文件

timeout:设定的超市时间,秒为单位

proxies:字典类型,设定访问代理服务器,可以增加登录认证,

allow_redirects:true/false,默认为true重新定制开关,

stream:true/false,默认为true获取内容立即 下载开关

verify:true/false,默认为true,认证SSL证书开关

cert:本地SSL证书路径

requests.head(url,kwargs)

∙ url: 拟获取页面的url链接 ∙kwargs: 12个控制访问的参数

requests.post(url,data=None, json=None, kwargs)

∙ url: 拟更新页面的url链接 ∙ data : 字典、字节序列或文件,Request的内容 ∙ json: JSON格式的数据,Request的内容 ∙kwargs: 12个控制访问的参数

requests.put(url,data=None, **kwargs)

∙ url: 拟更新页面的url链接 ∙ data : 字典、字节序列或文件,Request的内容 ∙ **kwargs: 12个控制访问的参数

requests.patch(url,data=None, **kwargs)

∙ url: 拟更新页面的url链接 ∙ data : 字典、字节序列或文件,Request的内容 ∙ **kwargs: 12个控制访问的参数

requests.delete(url,kwargs)

∙ url: 拟删除页面的url链接 ∙kwargs: 12个控制访问的参数

requests.get(url,params=None, kwargs)

∙ url: 拟获取页面的url链接 ∙ params: url中的额外参数,字典或字节流格式,可选 ∙kwargs: 12个控制访问的参数