LearnOpenGL学习笔记—高级光照 07:泛光

【项目地址:点击这里这里这里】

本节对应官网学习内容:泛光

结合英文原站,中文站,以及个人实践进行描述。

1 引入

由HDR的知识我们知道,因为监视器的亮度范围是有限的,所以明亮的光源和区域经常很难向观察者表达出来。

一种区分明亮光源的方式是使它们在监视器上发出光芒,光源的光芒向四周发散。这样观察者就会产生光源或亮区的确是强光区。

- 注:这个问题的提出简单来说是为了解决这样的问题:例如有一张在阳光下的白纸,白纸在监视器上显示出是出白色,而前方的太阳也是纯白色的,所以基本上白纸和太阳就是一样的了,给太阳加一个光晕,这样太阳看起来似乎就比白纸更亮了

光晕效果可以使用一个后处理特效泛光来实现。泛光使所有明亮区域产生光晕效果。下面是一个使用了和没有使用光晕的对比(图片生成自虚幻引擎):

Bloom使我们能够注意到一个明亮的物体真的有种明亮的感觉。

泛光可以极大提升场景中的光照效果,并提供了极大的效果提升,尽管做到这一切只需一点改变。

Bloom和HDR结合使用效果很好。

常见的一个误解是HDR和泛光是一样的,很多人认为两种技术是可以互换的。

但是它们是两种不同的技术,用于各自不同的目的上。

泛光可以使用默认的8位精确度的帧缓冲,也可以在不使用泛光效果的时候,使用HDR。

只不过在有了HDR之后再实现泛光就更简单了。

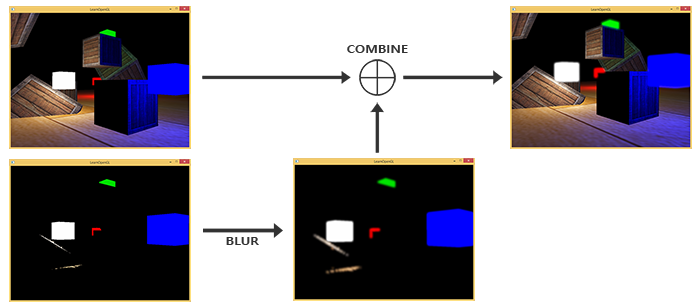

为实现泛光,我们像平时那样渲染一个有光场景,提取出场景的HDR颜色缓冲以及只有这个场景明亮区域可见的图片。

被提取的带有亮度的图片接着被模糊,结果被添加到HDR场景上面。

我们举个例子来来一步一步解释这个处理过程。

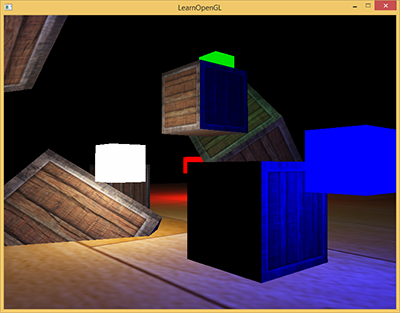

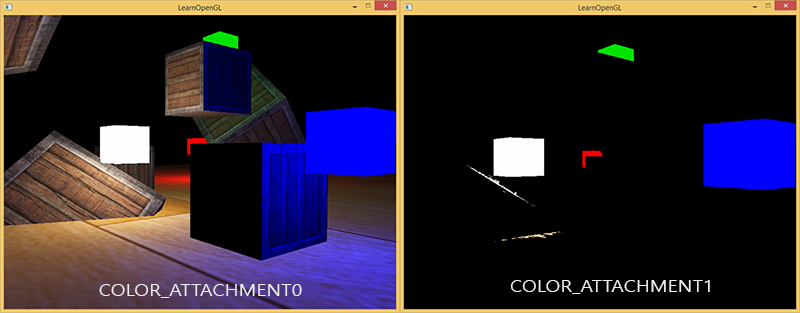

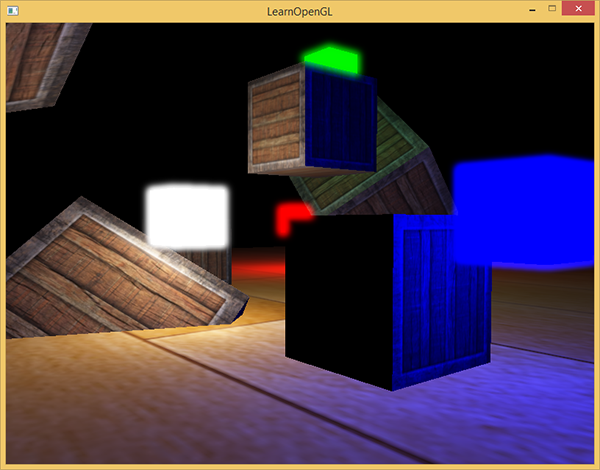

我们在场景中渲染一个带有4个立方体形式不同颜色的明亮的光源。

带有颜色的发光立方体的亮度在1.5到15.0之间。如果我们将其渲染至HDR颜色缓冲,场景看起来会是这样的:

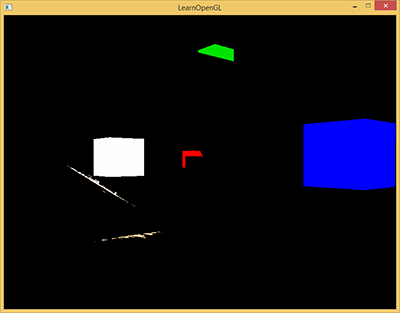

我们得到这个HDR颜色缓冲纹理,提取所有超出一定亮度的fragment。

这样我们就会获得一个只有fragment超过了一定阈限的颜色区域:

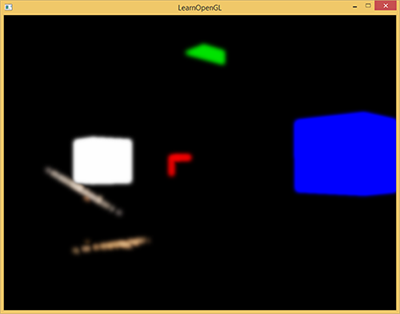

我们将这个超过一定亮度阈限的纹理进行模糊。泛光效果的强度很大程度上是由被模糊过滤器的范围和强度所决定。

最终的被模糊化的纹理就是我们用来获得发出光晕效果的东西。

这个已模糊的纹理要添加到原来的HDR场景纹理之上。

因为模糊过滤器的应用,明亮区域发出光晕,所以明亮区域在长和宽上都有所扩展。

泛光本身并不是个复杂的技术,但很难获得正确的效果。

它的品质很大程度上取决于所用的模糊过滤器的质量和类型。

简单地改改模糊过滤器就会极大的改变泛光效果的品质。

下面这几步就是泛光后处理特效的过程,它总结了实现泛光所需的步骤。

首先我们需要根据一定的阈限提取所有明亮的颜色。

2 提取亮色

第一步我们要从渲染出来的场景中提取两张图片。

我们可以渲染场景两次,每次使用一个不同的着色器渲染到不同的帧缓冲中,但我们可以使用一个叫做MRT(Multiple Render Targets,多渲染目标)的小技巧,这样我们就能指定多个片段着色器输出;有了它我们还能够在一个单独渲染处理中提取头两个图片。

在片段着色器的输出前,我们指定一个布局location标识符,这样我们便可控制一个片段着色器写入到哪个颜色缓冲:

layout (location = 0) out vec4 FragColor;

layout (location = 1) out vec4 BrightColor;

只有我们真的具有多个地方可写的时候这才能工作。

使用多个像素着色器输出的必要条件是,有多个颜色缓冲附加到了当前绑定的帧缓冲对象上。

从帧缓冲教程那里回忆起,当把一个纹理链接到帧缓冲的颜色缓冲上时,我们可以指定一个颜色附件。

直到现在,我们一直使用着GL_COLOR_ATTACHMENT0,但通过使用GL_COLOR_ATTACHMENT1,我们可以得到一个附加了两个颜色缓冲的帧缓冲对象:

// Set up floating point framebuffer to render scene to

GLuint hdrFBO;

glGenFramebuffers(1, &hdrFBO);

glBindFramebuffer(GL_FRAMEBUFFER, hdrFBO);

GLuint colorBuffers[2];

glGenTextures(2, colorBuffers);

for (GLuint i = 0; i < 2; i++)

{

glBindTexture(GL_TEXTURE_2D, colorBuffers[i]);

glTexImage2D(

GL_TEXTURE_2D, 0, GL_RGB16F, SCR_WIDTH, SCR_HEIGHT, 0, GL_RGB, GL_FLOAT, NULL

);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_CLAMP_TO_EDGE);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_CLAMP_TO_EDGE);

// attach texture to framebuffer

glFramebufferTexture2D(

GL_FRAMEBUFFER, GL_COLOR_ATTACHMENT0 + i, GL_TEXTURE_2D, colorBuffers[i], 0

);

}

我们需要显式告知OpenGL我们正在通过glDrawBuffers渲染到多个颜色缓冲,否则OpenGL只会渲染到帧缓冲的第一个颜色附件,而忽略所有其他的。

我们可以通过传递多个颜色附件的枚举来做这件事,我们以下面的操作进行渲染:

GLuint attachments[2] = {

GL_COLOR_ATTACHMENT0, GL_COLOR_ATTACHMENT1 };

glDrawBuffers(2, attachments);

当渲染到这个帧缓冲的时候,着色器使用一个布局location修饰符,fragment就会写入对应的颜色缓冲。

这样省去了我们为提取明亮区域的额外渲染步骤,因为我们现在可以直接从将被渲染的fragment提取出它们,我们用了灰度化的手段:

#version 330 core

layout (location = 0) out vec4 FragColor;

layout (location = 1) out vec4 BrightColor;

[...]

void main()

{

[...] // first do normal lighting calculations and output results

FragColor = vec4(lighting, 1.0f);

// Check whether fragment output is higher than threshold, if so output as brightness color

float brightness = dot(FragColor.rgb, vec3(0.2126, 0.7152, 0.0722));

if(brightness > 1.0)

BrightColor = vec4(FragColor.rgb, 1.0);

}

这里我们先正常计算光照,将其传递给第一个像素着色器的输出变量FragColor。

然后我们使用当前储存在FragColor的东西来决定它的亮度是否超过了一定阈限。我们通过恰当地将其转为灰度的方式计算一个fragment的亮度,如果它超过了一定阈限,我们就把颜色输出到第二个颜色缓冲,那里保存着所有亮部;渲染发光的立方体也是一样的。

这也说明了为什么泛光在HDR基础上能够运行得很好。

因为HDR中,我们可以将颜色值指定超过1.0这个默认的范围,我们能够得到对一个图像中的亮度的更好的控制权。

没有HDR我们必须将阈限设置为小于1.0的数,虽然可行,但是亮部很容易变得很多,这就导致光晕效果过重。

有了两个颜色缓冲,我们就有了一个正常场景的图像和一个提取出的亮区的图像;这些都在一个渲染步骤中完成。

有了一个提取出的亮区图像,我们现在就要把这个图像进行模糊处理。

我们可以使用帧缓冲教程后处理部分的那个简单的盒子过滤器,但不过我们最好还是使用一个更高级的更漂亮的模糊过滤器:高斯模糊(Gaussian blur)。

3 高斯模糊

在后处理教程那里,我们采用的模糊是一个图像中所有周围像素的均值,它的确为我们提供了一个简易实现的模糊,但是效果并不好。

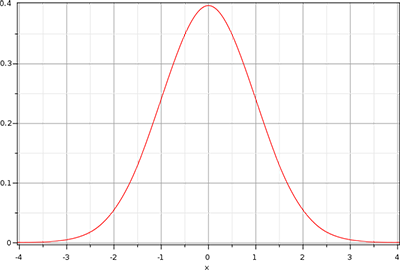

高斯模糊基于高斯曲线,高斯曲线通常被描述为一个钟形曲线,中间的值达到最大化,随着距离的增加,两边的值不断减少。

高斯分布也就是正态分布(Normal distribution)

高斯曲线在数学上有不同的形式,但是通常是这样的形状:

高斯曲线在它的中间处的面积最大,使用它的值作为权重使得近处的样本拥有最大的优先权。

比如,如果我们从fragment的32×32的四方形区域采样,这个权重随着和fragment的距离变大逐渐减小;通常这会得到更好更真实的模糊效果,这种模糊叫做高斯模糊。

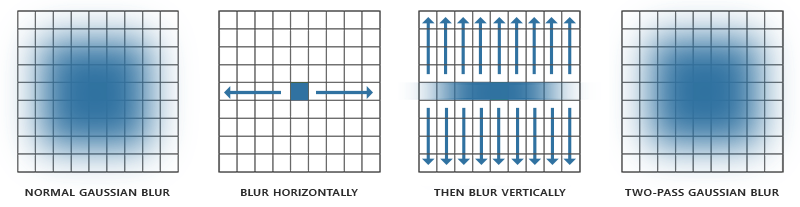

要实现高斯模糊过滤我们需要一个二维四方形作为权重,从这个二维高斯曲线方程中去获取它。然而这个过程有个问题,就是很快会消耗极大的性能。

以一个32×32的模糊kernel为例,我们必须对每个fragment从一个纹理中采样1024次!

幸运的是,高斯方程有个非常巧妙的特性,它允许我们把二维方程分解为两个更小的方程:一个描述水平权重,另一个描述垂直权重。

我们首先用水平权重在整个纹理上进行水平模糊,然后在经改变的纹理上进行垂直模糊。

利用这个特性,结果是一样的,但是可以节省难以置信的性能,因为我们现在只需做32+32次采样,不再是1024了!这叫做两步高斯模糊。

这意味着我们如果对一个图像进行模糊处理,至少需要两步,最好使用帧缓冲对象做这件事。

具体来说,我们将实现像乒乓球一样的帧缓冲来实现高斯模糊。

它的意思是,有一对儿帧缓冲,我们把另一个帧缓冲的颜色缓冲放进当前的帧缓冲的颜色缓冲中,使用不同的着色效果渲染指定的次数。

基本上就是不断地切换帧缓冲和纹理去绘制。

这样我们先在场景纹理的第一个缓冲中进行模糊,然后在把第一个帧缓冲的颜色缓冲放进第二个帧缓冲进行模糊,接着,将第二个帧缓冲的颜色缓冲放进第一个,循环往复。

3.1 高斯模糊着色器

在我们研究帧缓冲之前,先讨论高斯模糊的片段着色器:

这里我们使用一个比较小的高斯权重做例子,每次我们用它来指定当前fragment的水平或垂直样本的特定权重。

会发现我们基本上是将模糊过滤器根据我们在uniform变量horizontal设置的值分割为一个水平和一个垂直部分。通过用1.0除以纹理的大小(从textureSize得到一个vec2)得到一个纹理像素的实际大小,以此作为偏移距离的根据。

#version 330 core

out vec4 FragColor;

in vec2 TexCoords;

uniform sampler2D image;

uniform bool horizontal;

uniform float weight[5] = float[] (0.227027, 0.1945946, 0.1216216, 0.054054, 0.016216);

void main()

{

vec2 tex_offset = 1.0 / textureSize(image, 0); // gets size of single texel

vec3 result = texture(image, TexCoords).rgb * weight[0]; // current fragment's contribution

if(horizontal)

{

for(int i = 1; i < 5; ++i)

{

result += texture(image, TexCoords + vec2(tex_offset.x * i, 0.0)).rgb * weight[i];

result += texture(image, TexCoords - vec2(tex_offset.x * i, 0.0)).rgb * weight[i];

}

}

else

{

for(int i = 1; i < 5; ++i)

{

result += texture(image, TexCoords + vec2(0.0, tex_offset.y * i)).rgb * weight[i];

result += texture(image, TexCoords - vec2(0.0, tex_offset.y * i)).rgb * weight[i];

}

}

FragColor = vec4(result, 1.0);

}

我们为图像的模糊处理创建两个基本的帧缓冲,每个只有一个颜色缓冲纹理:

GLuint pingpongFBO[2];

GLuint pingpongBuffer[2];

glGenFramebuffers(2, pingpongFBO);

glGenTextures(2, pingpongBuffer);

for (GLuint i = 0; i < 2; i++)

{

glBindFramebuffer(GL_FRAMEBUFFER, pingpongFBO[i]);

glBindTexture(GL_TEXTURE_2D, pingpongBuffer[i]);

glTexImage2D(

GL_TEXTURE_2D, 0, GL_RGB16F, SCR_WIDTH, SCR_HEIGHT, 0, GL_RGB, GL_FLOAT, NULL

);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_CLAMP_TO_EDGE);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_CLAMP_TO_EDGE);

glFramebufferTexture2D(

GL_FRAMEBUFFER, GL_COLOR_ATTACHMENT0, GL_TEXTURE_2D, pingpongBuffer[i], 0

);

}

得到一个HDR纹理后,我们用提取出来的亮区纹理填充一个帧缓冲,然后对其模糊处理10次(垂直+水平,反复物刺):

GLboolean horizontal = true, first_iteration = true;

GLuint amount = 10;

shaderBlur.Use();

for (GLuint i = 0; i < amount; i++)

{

glBindFramebuffer(GL_FRAMEBUFFER, pingpongFBO[horizontal]);

glUniform1i(glGetUniformLocation(shaderBlur.Program, "horizontal"), horizontal);

glBindTexture(

GL_TEXTURE_2D, first_iteration ? colorBuffers[1] : pingpongBuffers[!horizontal]

);

RenderQuad();

horizontal = !horizontal;

if (first_iteration)

first_iteration = false;

}

glBindFramebuffer(GL_FRAMEBUFFER, 0);

每次循环我们根据我们打算渲染的是水平还是垂直来绑定两个缓冲其中之一,而将另一个绑定为纹理进行模糊。

第一次迭代,因为两个颜色缓冲都是空的所以我们随意绑定一个去进行模糊处理。

重复这个步骤10次,亮区图像就进行一个重复5次的高斯模糊了。

这样我们可以对任意图像进行任意次模糊处理;高斯模糊循环次数越多,模糊的强度越大。

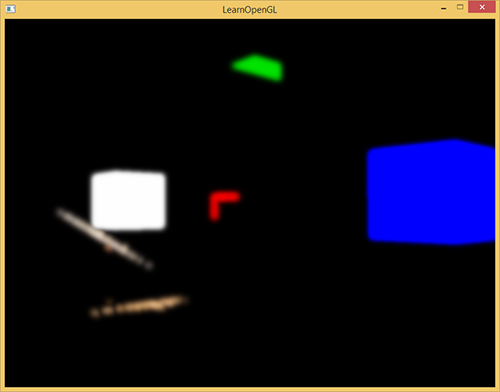

通过对提取亮区纹理进行5次模糊,我们就得到了一个正确的模糊的场景亮区图像。

泛光的最后一步是把模糊处理的图像和场景原来的HDR纹理进行结合。

4 把两个纹理混合

有了场景的HDR纹理和模糊处理的亮区纹理,我们只需把它们结合起来就能实现泛光或称光晕效果了。

最终的片段着色器(大部分和HDR教程用的差不多)要把两个纹理混合:

#version 330 core

out vec4 FragColor;

in vec2 TexCoords;

uniform sampler2D scene;

uniform sampler2D bloomBlur;

uniform float exposure;

void main()

{

const float gamma = 2.2;

vec3 hdrColor = texture(scene, TexCoords).rgb;

vec3 bloomColor = texture(bloomBlur, TexCoords).rgb;

hdrColor += bloomColor; // additive blending

// tone mapping

vec3 result = vec3(1.0) - exp(-hdrColor * exposure);

// also gamma correct while we're at it

result = pow(result, vec3(1.0 / gamma));

FragColor = vec4(result, 1.0f);

}

要注意的是我们要在应用色调映射之前添加泛光效果。这样添加的亮区的泛光,也会柔和转换为LDR,光照效果相对会更好。

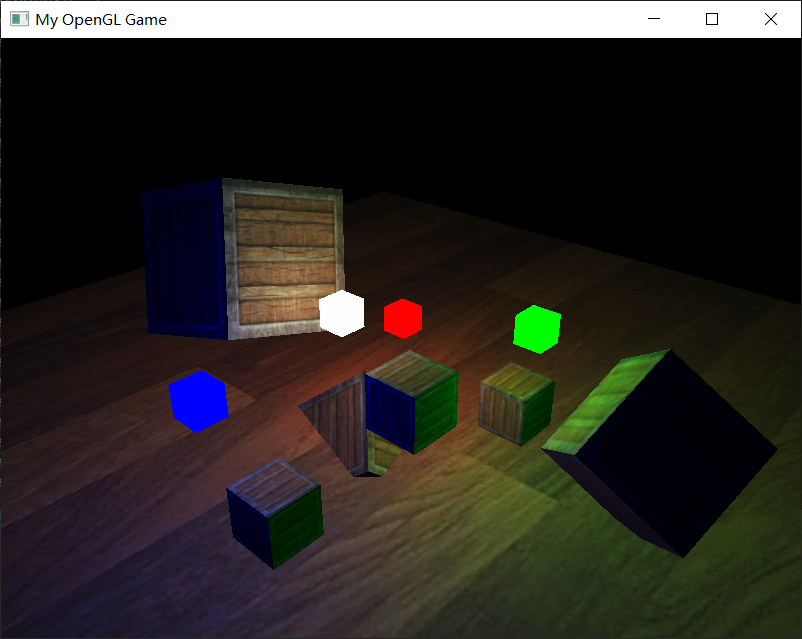

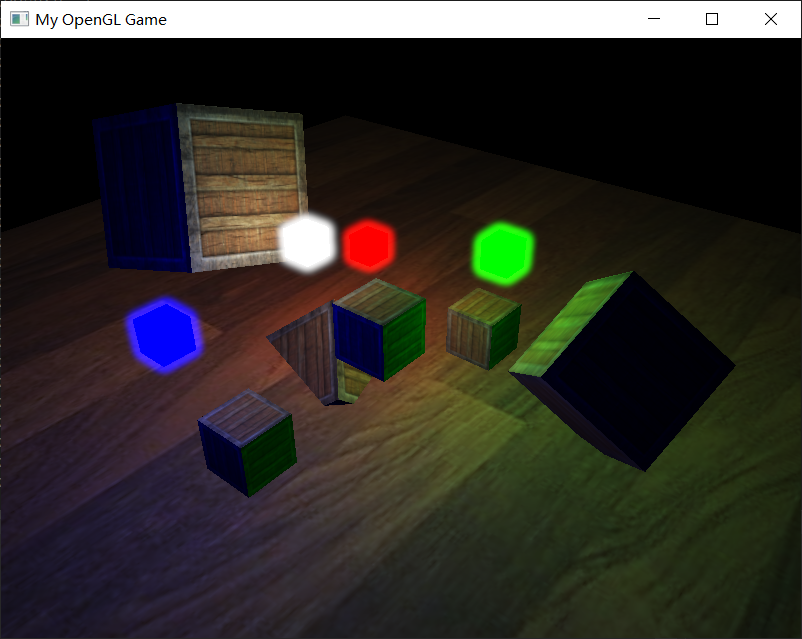

把两个纹理结合以后,场景亮区便有了合适的光晕特效:

有颜色的立方体看起来仿佛更亮,它向外发射光芒,的确是一个更好的视觉效果。这个场景比较简单,所以泛光效果不算十分令人瞩目,但在更好的场景中合理配置之后效果会有巨大的不同。

这个教程我们只是用了一个相对简单的高斯模糊过滤器,它在每个方向上只有5个样本。

通过沿着更大的半径或重复更多次数的模糊,进行采样我们就可以提升模糊的效果。

因为模糊的质量与泛光效果的质量正相关,提升模糊效果就能够提升泛光效果。

有些提升将模糊过滤器与不同大小的模糊kernel或采用多个高斯曲线来选择性地结合权重结合起来使用。

Efficient Gaussian blur with linear sampling非常详细地描述了高斯模糊,以及如何使用OpenGL的双线性纹理采样提升性能。

来自Kalogirou和EpicGames的附加资源讨论了如何通过提升高斯模糊来显著提升泛光效果。

下面我们来看看

5 Kalogirou的观点:关于缩小图像进行高斯模糊

上述我们的做法有个问题是过滤器的内核大小。

由于我们是在GPU上实时执行此操作,因此我们无法拥有任意数量的样本。

这会导致产生非常小的模糊的小内核。

我们在上面解决此问题的常见方法是重复模糊步骤几次,以扩大模糊范围。

Kalogirou认为这种泛光纹理不是很好的结果。

原因如下:

- 图像失去强度:几次模糊导致亮度减弱。

- 模糊的大小非常小:产生的光晕很小,并且仅在亮点周围只有几个像素的情况下受到限制,而当非常亮的点应该会产生较大的眩光和光晕。

首先想到的是通过增加内核大小来解决此问题。

增加内核大小后泛光的大小更大且可以接受,但是强度再次减弱。

我们需要的是保持较小内核的清晰度,同时还要使较大内核的范围广泛。

将通过添加几个不同内核大小的模糊图像来做到这一点。

作者提到在以5×5, 11×11, 21×21, 41×41为Kernel的高斯模糊之后,Bloom才有了一个不错的效果,不足之处就是性能影响有些大了,想要Bloom效果明显,需要以不同的Kernel尺寸进行多次高斯模糊,这个过程非常非常耗性能。

于是提出了另一种方案,降低原图的分辨率,降低一倍原图分辨率就相当于Kernel加大一倍,由于分辨率降低,速度更是进一步提高,最后多张分辨率不一的图片,使用双线性插值将其缩放为原始大小叠加起来,达到的效果跟在原图上以不同Kernel模糊出来的效果是差不多的。

关于双线性插值可以看这篇文章,可以看看

通过一个16×16个纹理采用5×5内核的结果,近似41×41滤波器,

通过在32×32纹理上应用5×5内核来近似21×21滤波器

通过在64×64纹理上应用5×5内核来近似11×11滤波器,

通过128×128纹理上应用5×5滤波器的内核。

这样,我们获得了添加到屏幕上的4个模糊纹理。

6 动手试试

我们不开启泛光,然后开启泛光

6.1 代码

6.1.1 bloom_basic.vert

#version 330 core

layout (location = 0) in vec3 aPos;

layout (location = 1) in vec3 aNormal;

layout (location = 2) in vec2 aTexCoords;

out VS_OUT {

vec3 FragPos;

vec3 Normal;

vec2 TexCoords;

} vs_out;

uniform mat4 projection;

uniform mat4 view;

uniform mat4 model;

void main()

{

vs_out.FragPos = vec3(model * vec4(aPos, 1.0));

vs_out.TexCoords = aTexCoords;

mat3 normalMatrix = transpose(inverse(mat3(model)));

vs_out.Normal = normalize(normalMatrix * aNormal);

gl_Position = projection * view * model * vec4(aPos, 1.0);

}

6.1.2 bloom_basic.frag

#version 330 core

layout (location = 0) out vec4 FragColor;

layout (location = 1) out vec4 BrightColor;

in VS_OUT {

vec3 FragPos;

vec3 Normal;

vec2 TexCoords;

} fs_in;

struct Light {

vec3 Position;

vec3 Color;

};

uniform Light lights[4];

uniform sampler2D diffuseTexture;

uniform vec3 viewPos;

void main()

{

vec3 color = texture(diffuseTexture, fs_in.TexCoords).rgb;

vec3 normal = normalize(fs_in.Normal);

// ambient

vec3 ambient = 0.0 * color;

// lighting

vec3 lighting = vec3(0.0);

vec3 viewDir = normalize(viewPos - fs_in.FragPos);

for(int i = 0; i < 4; i++)

{

// diffuse

vec3 lightDir = normalize(lights[i].Position - fs_in.FragPos);

float diff = max(dot(lightDir, normal), 0.0);

vec3 result = lights[i].Color * diff * color;

// attenuation (use quadratic as we have gamma correction)

float distance = length(fs_in.FragPos - lights[i].Position);

result *= 1.0 / (distance * distance);

lighting += result;

}

vec3 result = ambient + lighting;

// check whether result is higher than some threshold, if so, output as bloom threshold color

float brightness = dot(result, vec3(0.2126, 0.7152, 0.0722));

if(brightness > 1.0)

BrightColor = vec4(result, 1.0);

else

BrightColor = vec4(0.0, 0.0, 0.0, 1.0);

FragColor = vec4(result, 1.0);

}

6.1.3 bloom_blur.vert

#version 330 core

layout (location = 0) in vec3 aPos;

layout (location = 1) in vec2 aTexCoords;

out vec2 TexCoords;

void main()

{

TexCoords = aTexCoords;

gl_Position = vec4(aPos, 1.0);

}

6.1.4 bloom_blur.frag

#version 330 core

out vec4 FragColor;

in vec2 TexCoords;

uniform sampler2D image;

uniform bool horizontal;

uniform float weight[5] = float[] (0.2270270270, 0.1945945946, 0.1216216216, 0.0540540541, 0.0162162162);

void main()

{

vec2 tex_offset = 1.0 / textureSize(image, 0); // gets size of single texel

vec3 result = texture(image, TexCoords).rgb * weight[0];

if(horizontal)

{

for(int i = 1; i < 5; ++i)

{

result += texture(image, TexCoords + vec2(tex_offset.x * i, 0.0)).rgb * weight[i];

result += texture(image, TexCoords - vec2(tex_offset.x * i, 0.0)).rgb * weight[i];

}

}

else

{

for(int i = 1; i < 5; ++i)

{

result += texture(image, TexCoords + vec2(0.0, tex_offset.y * i)).rgb * weight[i];

result += texture(image, TexCoords - vec2(0.0, tex_offset.y * i)).rgb * weight[i];

}

}

FragColor = vec4(result, 1.0);

}

6.1.5 bloom_lightBox.frag

#version 330 core

layout (location = 0) out vec4 FragColor;

layout (location = 1) out vec4 BrightColor;

in VS_OUT {

vec3 FragPos;

vec3 Normal;

vec2 TexCoords;

} fs_in;

uniform vec3 lightColor;

void main()

{

FragColor = vec4(lightColor, 1.0);

float brightness = dot(FragColor.rgb, vec3(0.2126, 0.7152, 0.0722));

if(brightness > 1.0)

BrightColor = vec4(FragColor.rgb, 1.0);

else

BrightColor = vec4(0.0, 0.0, 0.0, 1.0);

}

6.1.6 bloom_final.vert

#version 330 core

layout (location = 0) in vec3 aPos;

layout (location = 1) in vec2 aTexCoords;

out vec2 TexCoords;

void main()

{

TexCoords = aTexCoords;

gl_Position = vec4(aPos, 1.0);

}

6.1.7 bloom_final.frag

#version 330 core

out vec4 FragColor;

in vec2 TexCoords;

uniform sampler2D scene;

uniform sampler2D bloomBlur;

uniform bool bloom;

uniform float exposure;

void main()

{

const float gamma = 2.2;

vec3 hdrColor = texture(scene, TexCoords).rgb;

vec3 bloomColor = texture(bloomBlur, TexCoords).rgb;

if(bloom)

hdrColor += bloomColor; // additive blending

// tone mapping

vec3 result = vec3(1.0) - exp(-hdrColor * exposure);

// also gamma correct while we're at it

result = pow(result, vec3(1.0 / gamma));

FragColor = vec4(result, 1.0);

}

6.1.8 main.cpp

#include <iostream>

#define GLEW_STATIC

#include <GL/glew.h>

#include <GLFW/glfw3.h>

#include "Shader.h"

#include "Camera.h"

#include <vector>

#define STB_IMAGE_IMPLEMENTATION

#include "stb_image.h"

#include <glm/glm.hpp>

#include <glm/gtc/matrix_transform.hpp>

#include <glm/gtc/type_ptr.hpp>

//鼠标移动镜头

void mouse_callback(GLFWwindow* window, double xpos, double ypos);

//滚轮缩放

void scroll_callback(GLFWwindow* window, double xoffset, double yoffset);

//检测输入

void processInput(GLFWwindow *window);

//导入图

unsigned int LoadImageToGPU(const char* filename, GLint internalFormat, GLenum format);

// Options

GLboolean hdr = true;

GLfloat exposure = 1.0f; // Change with j and k

bool bloom = true; // Change with 'Space'

bool bloomKeyPressed = false;

#pragma region Camera Declare

//建立camera

glm::vec3 cameraPos = glm::vec3(0.0f, 0.0f, 0.0f);

glm::vec3 cameraTarget = glm::vec3(0.0f, 0.0f, -1.0f);

glm::vec3 cameraUp = glm::vec3(0.0f, 1.0f, 0.0f);

Camera camera(cameraPos, cameraTarget, cameraUp);

#pragma endregion

#pragma region Input Declare

//移动用

float deltaTime = 0.0f; // 当前帧与上一帧的时间差

float lastFrame = 0.0f; // 上一帧的时间

void processInput(GLFWwindow* window) {

//看是不是按下esc键 然后退出

if (glfwGetKey(window, GLFW_KEY_ESCAPE) == GLFW_PRESS) {

glfwSetWindowShouldClose(window, true);

}

//更流畅点的摄像机系统

if (deltaTime != 0) {

camera.cameraPosSpeed = 5 * deltaTime;

}

//camera前后左右根据镜头方向移动

if (glfwGetKey(window, GLFW_KEY_W) == GLFW_PRESS)

camera.PosUpdateForward();

if (glfwGetKey(window, GLFW_KEY_S) == GLFW_PRESS)

camera.PosUpdateBackward();

if (glfwGetKey(window, GLFW_KEY_A) == GLFW_PRESS)

camera.PosUpdateLeft();

if (glfwGetKey(window, GLFW_KEY_D) == GLFW_PRESS)

camera.PosUpdateRight();

if (glfwGetKey(window, GLFW_KEY_Q) == GLFW_PRESS)

camera.PosUpdateUp();

if (glfwGetKey(window, GLFW_KEY_E) == GLFW_PRESS)

camera.PosUpdateDown();

if (glfwGetKey(window, GLFW_KEY_SPACE) == GLFW_PRESS)

{

bloom = !bloom;

}

// Change parallax height scale

if (glfwGetKey(window, GLFW_KEY_J) == GLFW_PRESS)

if (exposure > 0.0f)

exposure -= 0.001f;

else

exposure = 0.0f;

if (glfwGetKey(window, GLFW_KEY_K) == GLFW_PRESS)

exposure += 0.001f;

}

float lastX;

float lastY;

bool firstMouse = true;

//鼠标控制镜头方向

void mouse_callback(GLFWwindow* window, double xpos, double ypos) {

if (firstMouse == true)

{

lastX = xpos;

lastY = ypos;

firstMouse = false;

}

float deltaX, deltaY;

float sensitivity = 0.05f;

deltaX = (xpos - lastX)*sensitivity;

deltaY = (ypos - lastY)*sensitivity;

lastX = xpos;

lastY = ypos;

camera.ProcessMouseMovement(deltaX, deltaY);

};

//缩放

float fov = 45.0f;

void scroll_callback(GLFWwindow* window, double xoffset, double yoffset)

{

if (fov >= 1.0f && fov <= 45.0f)

fov -= yoffset;

if (fov <= 1.0f)

fov = 1.0f;

if (fov >= 45.0f)

fov = 45.0f;

}

#pragma endregion

unsigned int LoadImageToGPU(const char* filename, GLint internalFormat, GLenum format) {

unsigned int TexBuffer;

glGenTextures(1, &TexBuffer);

glBindTexture(GL_TEXTURE_2D, TexBuffer);

// 为当前绑定的纹理对象设置环绕、过滤方式

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR_MIPMAP_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

// 加载并生成纹理

int width, height, nrChannel;

unsigned char *data = stbi_load(filename, &width, &height, &nrChannel, 0);

if (data) {

glTexImage2D(GL_TEXTURE_2D, 0, internalFormat, width, height, 0, format, GL_UNSIGNED_BYTE, data);

glGenerateMipmap(GL_TEXTURE_2D);

}

else

{

printf("Failed to load texture");

}

glBindTexture(GL_TEXTURE_2D, 0);

stbi_image_free(data);

return TexBuffer;

}

// renderCube() renders a 1x1 3D cube in NDC.

// -------------------------------------------------

unsigned int cubeVAO = 0;

unsigned int cubeVBO = 0;

void renderCube()

{

// initialize (if necessary)

if (cubeVAO == 0)

{

float vertices[] = {

// back face

-1.0f, -1.0f, -1.0f, 0.0f, 0.0f, -1.0f, 0.0f, 0.0f, // bottom-left

1.0f, 1.0f, -1.0f, 0.0f, 0.0f, -1.0f, 1.0f, 1.0f, // top-right

1.0f, -1.0f, -1.0f, 0.0f, 0.0f, -1.0f, 1.0f, 0.0f, // bottom-right

1.0f, 1.0f, -1.0f, 0.0f, 0.0f, -1.0f, 1.0f, 1.0f, // top-right

-1.0f, -1.0f, -1.0f, 0.0f, 0.0f, -1.0f, 0.0f, 0.0f, // bottom-left

-1.0f, 1.0f, -1.0f, 0.0f, 0.0f, -1.0f, 0.0f, 1.0f, // top-left

// front face

-1.0f, -1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 0.0f, 0.0f, // bottom-left

1.0f, -1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 1.0f, 0.0f, // bottom-right

1.0f, 1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 1.0f, 1.0f, // top-right

1.0f, 1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 1.0f, 1.0f, // top-right

-1.0f, 1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 0.0f, 1.0f, // top-left

-1.0f, -1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 0.0f, 0.0f, // bottom-left

// left face

-1.0f, 1.0f, 1.0f, -1.0f, 0.0f, 0.0f, 1.0f, 0.0f, // top-right

-1.0f, 1.0f, -1.0f, -1.0f, 0.0f, 0.0f, 1.0f, 1.0f, // top-left

-1.0f, -1.0f, -1.0f, -1.0f, 0.0f, 0.0f, 0.0f, 1.0f, // bottom-left

-1.0f, -1.0f, -1.0f, -1.0f, 0.0f, 0.0f, 0.0f, 1.0f, // bottom-left

-1.0f, -1.0f, 1.0f, -1.0f, 0.0f, 0.0f, 0.0f, 0.0f, // bottom-right

-1.0f, 1.0f, 1.0f, -1.0f, 0.0f, 0.0f, 1.0f, 0.0f, // top-right

// right face

1.0f, 1.0f, 1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 0.0f, // top-left

1.0f, -1.0f, -1.0f, 1.0f, 0.0f, 0.0f, 0.0f, 1.0f, // bottom-right

1.0f, 1.0f, -1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 1.0f, // top-right

1.0f, -1.0f, -1.0f, 1.0f, 0.0f, 0.0f, 0.0f, 1.0f, // bottom-right

1.0f, 1.0f, 1.0f, 1.0f, 0.0f, 0.0f, 1.0f, 0.0f, // top-left

1.0f, -1.0f, 1.0f, 1.0f, 0.0f, 0.0f, 0.0f, 0.0f, // bottom-left

// bottom face

-1.0f, -1.0f, -1.0f, 0.0f, -1.0f, 0.0f, 0.0f, 1.0f, // top-right

1.0f, -1.0f, -1.0f, 0.0f, -1.0f, 0.0f, 1.0f, 1.0f, // top-left

1.0f, -1.0f, 1.0f, 0.0f, -1.0f, 0.0f, 1.0f, 0.0f, // bottom-left

1.0f, -1.0f, 1.0f, 0.0f, -1.0f, 0.0f, 1.0f, 0.0f, // bottom-left

-1.0f, -1.0f, 1.0f, 0.0f, -1.0f, 0.0f, 0.0f, 0.0f, // bottom-right

-1.0f, -1.0f, -1.0f, 0.0f, -1.0f, 0.0f, 0.0f, 1.0f, // top-right

// top face

-1.0f, 1.0f, -1.0f, 0.0f, 1.0f, 0.0f, 0.0f, 1.0f, // top-left

1.0f, 1.0f , 1.0f, 0.0f, 1.0f, 0.0f, 1.0f, 0.0f, // bottom-right

1.0f, 1.0f, -1.0f, 0.0f, 1.0f, 0.0f, 1.0f, 1.0f, // top-right

1.0f, 1.0f, 1.0f, 0.0f, 1.0f, 0.0f, 1.0f, 0.0f, // bottom-right

-1.0f, 1.0f, -1.0f, 0.0f, 1.0f, 0.0f, 0.0f, 1.0f, // top-left

-1.0f, 1.0f, 1.0f, 0.0f, 1.0f, 0.0f, 0.0f, 0.0f // bottom-left

};

glGenVertexArrays(1, &cubeVAO);

glGenBuffers(1, &cubeVBO);

// fill buffer

glBindBuffer(GL_ARRAY_BUFFER, cubeVBO);

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

// link vertex attributes

glBindVertexArray(cubeVAO);

glEnableVertexAttribArray(0);

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 8 * sizeof(float), (void*)0);

glEnableVertexAttribArray(1);

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, 8 * sizeof(float), (void*)(3 * sizeof(float)));

glEnableVertexAttribArray(2);

glVertexAttribPointer(2, 2, GL_FLOAT, GL_FALSE, 8 * sizeof(float), (void*)(6 * sizeof(float)));

glBindBuffer(GL_ARRAY_BUFFER, 0);

glBindVertexArray(0);

}

// render Cube

glBindVertexArray(cubeVAO);

glDrawArrays(GL_TRIANGLES, 0, 36);

glBindVertexArray(0);

}

// renderQuad() renders a 1x1 XY quad in NDC

// -----------------------------------------

unsigned int quadVAO = 0;

unsigned int quadVBO;

void renderQuad()

{

if (quadVAO == 0)

{

float quadVertices[] = {

// positions // texture Coords

-1.0f, 1.0f, 0.0f, 0.0f, 1.0f,

-1.0f, -1.0f, 0.0f, 0.0f, 0.0f,

1.0f, 1.0f, 0.0f, 1.0f, 1.0f,

1.0f, -1.0f, 0.0f, 1.0f, 0.0f,

};

// setup plane VAO

glGenVertexArrays(1, &quadVAO);

glGenBuffers(1, &quadVBO);

glBindVertexArray(quadVAO);

glBindBuffer(GL_ARRAY_BUFFER, quadVBO);

glBufferData(GL_ARRAY_BUFFER, sizeof(quadVertices), &quadVertices, GL_STATIC_DRAW);

glEnableVertexAttribArray(0);

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 5 * sizeof(float), (void*)0);

glEnableVertexAttribArray(1);

glVertexAttribPointer(1, 2, GL_FLOAT, GL_FALSE, 5 * sizeof(float), (void*)(3 * sizeof(float)));

}

glBindVertexArray(quadVAO);

glDrawArrays(GL_TRIANGLE_STRIP, 0, 4);

glBindVertexArray(0);

}

int main() {

#pragma region Open a Window

glfwInit();

glfwWindowHint(GLFW_CONTEXT_VERSION_MAJOR, 3);

glfwWindowHint(GLFW_CONTEXT_VERSION_MINOR, 3);

glfwWindowHint(GLFW_OPENGL_PROFILE, GLFW_OPENGL_CORE_PROFILE);

// Open GLFW Window

GLFWwindow* window = glfwCreateWindow(800, 600, "My OpenGL Game", NULL, NULL);

if (window == NULL)

{

printf("Open window failed.");

glfwTerminate();

return -1;

}

glfwMakeContextCurrent(window);

// 关闭鼠标显示

glfwSetInputMode(window, GLFW_CURSOR, GLFW_CURSOR_DISABLED);

// 回调函数监听鼠标

glfwSetCursorPosCallback(window, mouse_callback);

// 回调函数监听滚轮

glfwSetScrollCallback(window, scroll_callback);

// Init GLEW

glewExperimental = true;

if (glewInit() != GLEW_OK)

{

printf("Init GLEW failed.");

glfwTerminate();

return -1;

}

glEnable(GL_DEPTH_TEST);

glViewport(0, 0, 800, 600);

#pragma endregion

Shader* Shader_basic = new Shader("bloom_basic.vert", "bloom_basic.frag");

Shader* Shader_light = new Shader("bloom_basic.vert", "bloom_lightBox.frag");

Shader* Shader_blur = new Shader("bloom_blur.vert", "bloom_blur.frag");

Shader* Shader_final = new Shader("bloom_final.vert", "bloom_final.frag");

GLuint woodTexture = LoadImageToGPU("wood.jpg", GL_SRGB, GL_RGB);

GLuint containerTexture = LoadImageToGPU("container2.png", GL_SRGB_ALPHA, GL_RGBA);

// configure (floating point) framebuffers

// ---------------------------------------

unsigned int hdrFBO;

glGenFramebuffers(1, &hdrFBO);

glBindFramebuffer(GL_FRAMEBUFFER, hdrFBO);

// create 2 floating point color buffers (1 for normal rendering, other for brightness threshold values)

unsigned int colorBuffers[2];

glGenTextures(2, colorBuffers);

for (unsigned int i = 0; i < 2; i++)

{

glBindTexture(GL_TEXTURE_2D, colorBuffers[i]);

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGBA16F, 800, 600, 0, GL_RGBA, GL_FLOAT, NULL);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_CLAMP_TO_EDGE); // we clamp to the edge as the blur filter would otherwise sample repeated texture values!

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_CLAMP_TO_EDGE);

// attach texture to framebuffer

glFramebufferTexture2D(GL_FRAMEBUFFER, GL_COLOR_ATTACHMENT0 + i, GL_TEXTURE_2D, colorBuffers[i], 0);

}

// create and attach depth buffer (renderbuffer)

unsigned int rboDepth;

glGenRenderbuffers(1, &rboDepth);

glBindRenderbuffer(GL_RENDERBUFFER, rboDepth);

glRenderbufferStorage(GL_RENDERBUFFER, GL_DEPTH_COMPONENT, 800, 600);

glFramebufferRenderbuffer(GL_FRAMEBUFFER, GL_DEPTH_ATTACHMENT, GL_RENDERBUFFER, rboDepth);

// tell OpenGL which color attachments we'll use (of this framebuffer) for rendering

unsigned int attachments[2] = {

GL_COLOR_ATTACHMENT0, GL_COLOR_ATTACHMENT1 };

glDrawBuffers(2, attachments);

// finally check if framebuffer is complete

if (glCheckFramebufferStatus(GL_FRAMEBUFFER) != GL_FRAMEBUFFER_COMPLETE)

std::cout << "Framebuffer not complete!" << std::endl;

glBindFramebuffer(GL_FRAMEBUFFER, 0);

// ping-pong-framebuffer for blurring

unsigned int pingpongFBO[2];

unsigned int pingpongColorbuffers[2];

glGenFramebuffers(2, pingpongFBO);

glGenTextures(2, pingpongColorbuffers);

for (unsigned int i = 0; i < 2; i++)

{

glBindFramebuffer(GL_FRAMEBUFFER, pingpongFBO[i]);

glBindTexture(GL_TEXTURE_2D, pingpongColorbuffers[i]);

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGBA16F, 800, 600, 0, GL_RGBA, GL_FLOAT, NULL);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_CLAMP_TO_EDGE); // we clamp to the edge as the blur filter would otherwise sample repeated texture values!

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_CLAMP_TO_EDGE);

glFramebufferTexture2D(GL_FRAMEBUFFER, GL_COLOR_ATTACHMENT0, GL_TEXTURE_2D, pingpongColorbuffers[i], 0);

// also check if framebuffers are complete (no need for depth buffer)

if (glCheckFramebufferStatus(GL_FRAMEBUFFER) != GL_FRAMEBUFFER_COMPLETE)

std::cout << "Framebuffer not complete!" << std::endl;

}

// lighting info

// -------------

// positions

std::vector<glm::vec3> lightPositions;

lightPositions.push_back(glm::vec3(0.0f, 2.5f, 1.5f));

lightPositions.push_back(glm::vec3(-2.0f, 1.5f, 2.0f));

lightPositions.push_back(glm::vec3(3.0f, 2.5f, 1.0f));

lightPositions.push_back(glm::vec3(-1.8f, 2.4f, -1.0f));

// colors

std::vector<glm::vec3> lightColors;

lightColors.push_back(glm::vec3(5.0f, 5.0f, 5.0f));

lightColors.push_back(glm::vec3(10.0f, 0.0f, 0.0f));

lightColors.push_back(glm::vec3(0.0f, 0.0f, 15.0f));

lightColors.push_back(glm::vec3(0.0f, 15.0f, 0.0f));

Shader_basic->use();

glUniform1i(glGetUniformLocation(Shader_basic->ID, "diffuseTexture"), 0);

Shader_blur->use();

glUniform1i(glGetUniformLocation(Shader_blur->ID, "image"), 0);

Shader_final->use();

glUniform1i(glGetUniformLocation(Shader_final->ID, "scene"), 0);

glUniform1i(glGetUniformLocation(Shader_final->ID, "bloomBlur"), 1);

while (!glfwWindowShouldClose(window))

{

// Set frame time

GLfloat currentFrame = glfwGetTime();

deltaTime = currentFrame - lastFrame;

lastFrame = currentFrame;

// Check and call events

processInput(window);

// render

// ------

glClearColor(0.0f, 0.0f, 0.0f, 1.0f);

glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT);

// 1. render scene into floating point framebuffer

// -----------------------------------------------

glBindFramebuffer(GL_FRAMEBUFFER, hdrFBO);

glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT);

glm::mat4 projection = glm::perspective(glm::radians(fov), (float)800 / (float)600, 0.1f, 100.0f);

glm::mat4 view = camera.GetViewMatrix();

glm::mat4 model = glm::mat4(1.0f);

Shader_basic->use();

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "projection"), 1, GL_FALSE, glm::value_ptr(projection));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "view"), 1, GL_FALSE, glm::value_ptr(view));

glActiveTexture(GL_TEXTURE0);

glBindTexture(GL_TEXTURE_2D, woodTexture);

// set lighting uniforms

for (unsigned int i = 0; i < lightPositions.size(); i++)

{

glUniform3fv(glGetUniformLocation(Shader_basic->ID, ("lights[" + std::to_string(i) + "].Position").c_str()), 1, &lightPositions[i][0]);

glUniform3fv(glGetUniformLocation(Shader_basic->ID, ("lights[" + std::to_string(i) + "].Color").c_str()), 1, &lightColors[i][0]);

}

glUniform3f(glGetUniformLocation(Shader_basic->ID, "viewPos"), camera.Position.x, camera.Position.y, camera.Position.z);

// create one large cube that acts as the floor

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(0.0f, -1.0f, 0.0));

model = glm::scale(model, glm::vec3(12.5f, 0.5f, 12.5f));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

renderCube();

// then create multiple cubes as the scenery

glBindTexture(GL_TEXTURE_2D, containerTexture);

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(0.0f, 1.5f, 0.0));

model = glm::scale(model, glm::vec3(0.5f));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

renderCube();

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(2.0f, 0.0f, 1.0));

model = glm::scale(model, glm::vec3(0.5f));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

renderCube();

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(-1.0f, -1.0f, 2.0));

model = glm::rotate(model, glm::radians(60.0f), glm::normalize(glm::vec3(1.0, 0.0, 1.0)));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

renderCube();

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(0.0f, 2.7f, 4.0));

model = glm::rotate(model, glm::radians(23.0f), glm::normalize(glm::vec3(1.0, 0.0, 1.0)));

model = glm::scale(model, glm::vec3(1.25));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

renderCube();

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(-2.0f, 1.0f, -3.0));

model = glm::rotate(model, glm::radians(124.0f), glm::normalize(glm::vec3(1.0, 0.0, 1.0)));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

renderCube();

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(-3.0f, 0.0f, 0.0));

model = glm::scale(model, glm::vec3(0.5f));

glUniformMatrix4fv(glGetUniformLocation(Shader_basic->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

renderCube();

// finally show all the light sources as bright cubes

Shader_light->use();

glUniformMatrix4fv(glGetUniformLocation(Shader_light->ID, "projection"), 1, GL_FALSE, glm::value_ptr(projection));

glUniformMatrix4fv(glGetUniformLocation(Shader_light->ID, "view"), 1, GL_FALSE, glm::value_ptr(view));

for (unsigned int i = 0; i < lightPositions.size(); i++)

{

model = glm::mat4(1.0f);

model = glm::translate(model, glm::vec3(lightPositions[i]));

model = glm::scale(model, glm::vec3(0.25f));

glUniformMatrix4fv(glGetUniformLocation(Shader_light->ID, "model"), 1, GL_FALSE, glm::value_ptr(model));

glUniform3fv(glGetUniformLocation(Shader_light->ID, "lightColor"), 1, &lightColors[i][0]);

renderCube();

}

glBindFramebuffer(GL_FRAMEBUFFER, 0);

// 2. blur bright fragments with two-pass Gaussian Blur

// --------------------------------------------------

bool horizontal = true, first_iteration = true;

unsigned int amount = 10;

Shader_blur->use();

for (unsigned int i = 0; i < amount; i++)

{

glBindFramebuffer(GL_FRAMEBUFFER, pingpongFBO[horizontal]);

glUniform1i(glGetUniformLocation(Shader_blur->ID, "horizontal"), horizontal);

glBindTexture(GL_TEXTURE_2D, first_iteration ? colorBuffers[1] : pingpongColorbuffers[!horizontal]); // bind texture of other framebuffer (or scene if first iteration)

renderQuad();

horizontal = !horizontal;

if (first_iteration)

first_iteration = false;

}

glBindFramebuffer(GL_FRAMEBUFFER, 0);

// 3. now render floating point color buffer to 2D quad and tonemap HDR colors to default framebuffer's (clamped) color range

// --------------------------------------------------------------------------------------------------------------------------

glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT);

Shader_final->use();

glActiveTexture(GL_TEXTURE0);

glBindTexture(GL_TEXTURE_2D, colorBuffers[0]);

glActiveTexture(GL_TEXTURE1);

glBindTexture(GL_TEXTURE_2D, pingpongColorbuffers[!horizontal]);

glUniform1i(glGetUniformLocation(Shader_final->ID, "bloom"), bloom);

glUniform1f(glGetUniformLocation(Shader_final->ID, "exposure"), exposure);

renderQuad();

std::cout << "bloom: " << (bloom ? "on" : "off") << "| exposure: " << exposure << std::endl;

// glfw: swap buffers and poll IO events (keys pressed/released, mouse moved etc.)

// -------------------------------------------------------------------------------

glfwSwapBuffers(window);

glfwPollEvents();

}

glfwTerminate();

return 0;

}