一)简介

之前的VGG继承了LeNet以及AlexNet的一些框架结构,通过小卷积核+高深度,提高了模型效果,并强调了深度的重要意义。在LSVRC14的第一名,胜过VGG模型,就是代号为Inception的另一种网络结构模型,其特点是提高了网络内部计算资源的利用率,在增加网络深度、广度(通道数)的同时,保持了计算量不变或减少。在LSVRC14上提交应用的一个特例,被称为GoogLeNet(致敬LeNet),是一个22层深的网络,但参数仅为AlexNet的1/12。

二)GoogLeNet介绍

2.1)NIN简介

NIN(Network in Network)是GoogLeNet的基础。之前的LeNet、AlexNet、VGGNet在设计上具有共同之处:先使用卷积层对图像提取特征,在用全连接层进行回归分类,除了ReLU激活函数、Dropout的引进外,主要在中间层的宽度、深度上进行提高。而NIN提出了另一种思路,串联多个卷积层、全连接层,先构成小的模块化小网络,以此为基础来构建一个深层网络。

论文:https://arxiv.org/pdf/1312.4400.pdf

mlpconv层和1x1卷积

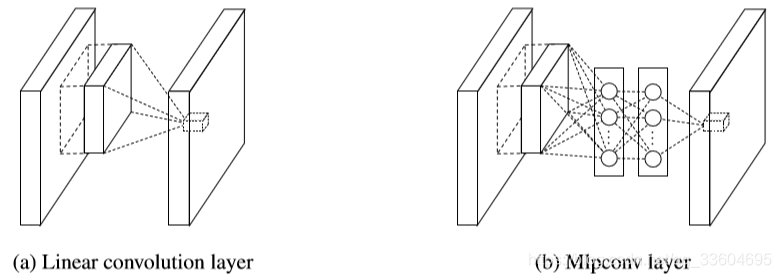

CNN高层特征一般是低层特征通过某种运算组合得到的。作者就根据这个想法,提出在每个局部感受野中进行更加复杂的运算,提出了mlp卷积层,来替代传统的卷积层。mlp卷积层层实际上是卷积加传统的mlp,因为convolution是线性的,而mlp是非线性的,所以两者的组合能够得到更高的抽象特征,泛化能力更强。下图为传统卷积层和mlp卷积层的对比。

另外,mlp卷积层中的“全连接层”,实际上是核为1x1尺寸的卷积层。关于1x1卷积的意义,主要有以下两点。

1)实现跨通道的交互和信息整合:1x1卷积相当于对多通道feature map进行线性组合,提高了网络的表达能力;

2)进行卷积核通道数的降维:相比于全连接层,1×1卷积后可以降低输入的通道数,卷积核参数、运算复杂度也随之下降。

全局均值池化(global average pooling)

论文提出使用全局平均池化操作,取代最后的全连接层。全连接层参数多且易过拟合,影响模型的泛化能力,而使用全局平均池化能够减小以上弊端。全局平均池化的概念很简单,根据分类任务的类别,产生对应数目的feature map,对每个feature map的数值求平均作为某类别的置信度,即每个feature map相当于一个输出特征,再进行softmax分类即可。其优点可以总结如下:

1)相比全连接,参数减少,并减轻了过拟合的影响;

2)输出更符合卷积结构,特征图直接映射到类别特征,简化结构;

3)空间信息进行求和平均,因而对输入的空间变换更具有稳定性。

2.2)GoogLeNet

引用:https://my.oschina.net/u/876354/blog/1637819

https://blog.csdn.net/u012426298/article/details/80854852