PCA与Kernel PCA介绍与对比

1. 理论介绍

PCA是常用的提取数据的手段,其功能为提取主成分(主要信息),摒弃冗余信息(次要信息),从而得到压缩后的数据,实现维度的下降。

其设想通过投影矩阵将高维信息转换到另一个坐标系下,并通过平移将数据均值变为零。PCA认为,在变换过后的数据中,在某一维度上,数据分布的更分散,则认为对数据点分布情况的解释力就更强。故在PCA中,通过方差来衡量数据样本在各个方向上投影的分布情况,进而对有效的低维方向进行选择。

KernelPCA是PCA的一个改进版,它将非线性可分的数据转换到一个适合对齐进行线性分类的新的低维子空间上,核PCA可以通过非线性映射将数据转换到一个高维空间中,在高维空间中使用PCA将其映射到另一个低维空间中,并通过线性分类器对样本进行划分。

核函数:通过两个向量点积来度量向量间相似度的函数。常用函数有:多项式核、双曲正切核、径向基和函数(RBF)(高斯核函数)等。

2. 技术实现

在实现中,PCA利用其投影后求方差的原理,建立矩阵关系:

即最终把问题简化为求variance最大值的问题,即

利用拉格朗日乘数法,则求

则有

所以这里,问题转化为求最大特征值的问题,其投影矩阵也由特征向量求得。

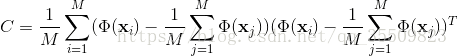

在KernelPCA中,这个问题同样是求特征向量的问题,只不过目标矩阵是经过核变换之后的协方差矩阵,即

与前相同,这个问题解决的实质还是要求C矩阵的特征向量,但对C求特征向量的过程较为复杂,经过了几次矩阵变化,先求得与核变换有关的矩阵K 的特征向量a,再通过变换方程与a的点乘得到协方差矩阵的特征向量v。

具体推法:https://blog.csdn.net/zhangping1987/article/details/30492433

3. 实验比较

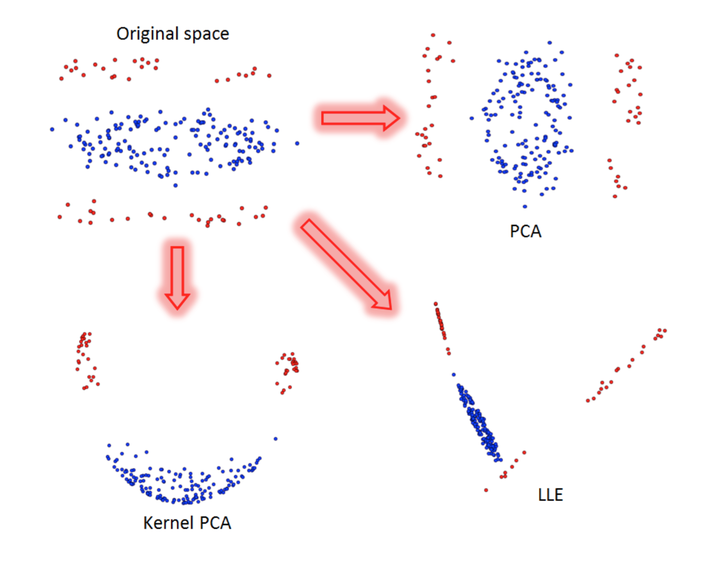

下图是一个二维到二维的映射,可以看出,对于传统的PCA来说,同维的映射只是变换了方向的旋转,而对于KPCA来说,因为加入了核变换,产生了低维到高维的映射后,再降维到低维,这种过程加入了非线性的变换,进而产生了不一样的效果。