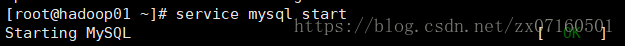

1.启动mysql(作为hive的数据库,没有的话可以不用启动)

执行service mysql start

验证service mysql status

2.启动hdfs ha集群

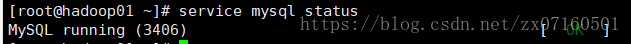

(1)启动zookeeper

启动 (每个节点都要执行)zkServer.sh start

验证 是否启动成功(每个节点都要执行)zkServer.sh status

(2)启动journalnode服务(单个启动、多个进程启动)

./sbin/hadoop-daemon.sh start journalnode

hadoop01 ./sbin/hadoop-daemons.sh start journalnode

(3)挑选两个namenode之中的一台来格式化,然后并且启动

hadoop01 hdfs namenode -format

hadoop-daemon.sh start namenode

(4)在另外一台namenode的机子上拉取元数据(也可以使用复制)

hadoop02 hdfs namenode -bootstrapStandby

(5)格式化zkfc

hadoop01 hdfs zkfc -formatZK

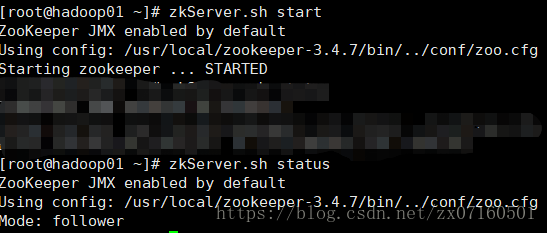

(6)hadoop01上执行start-dfs.sh

(7)验证

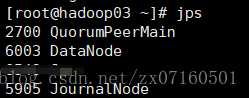

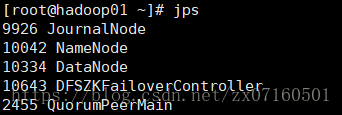

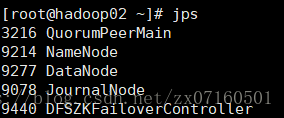

①对应进程是否启动

hadoop01:

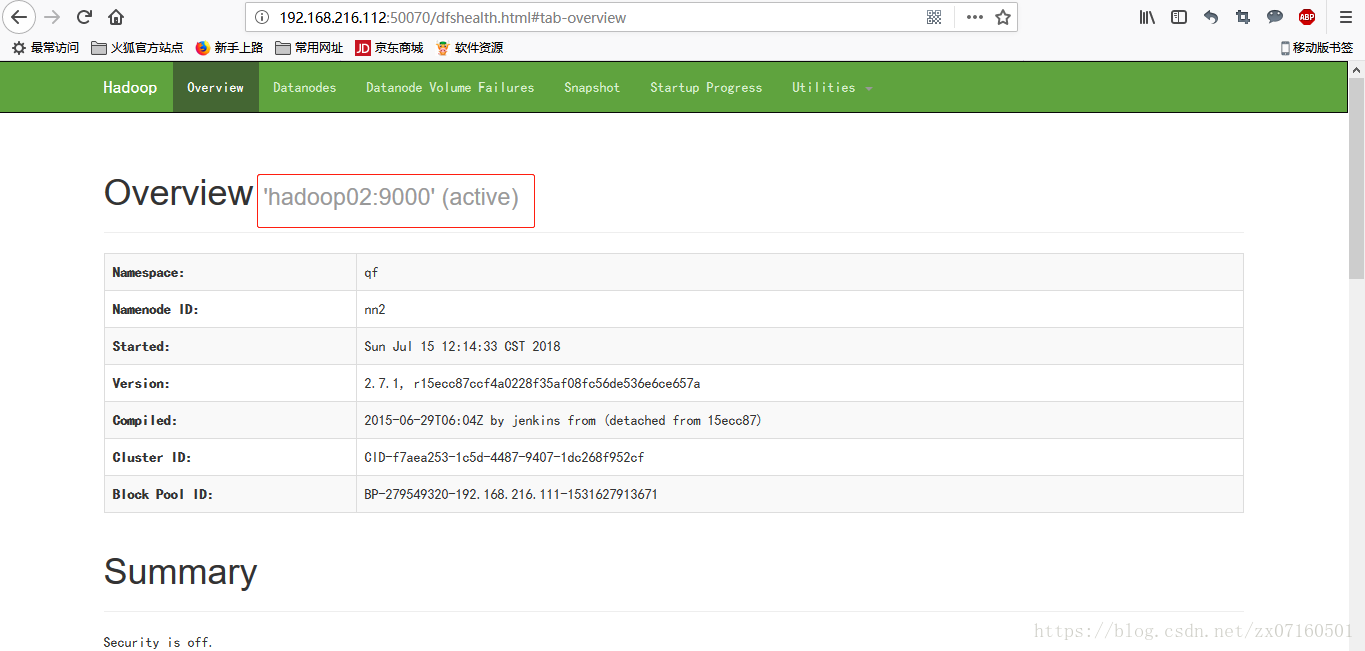

②web ui是否正常

hadoop02节点处于工作状态

hadoop01节点处于standby状态

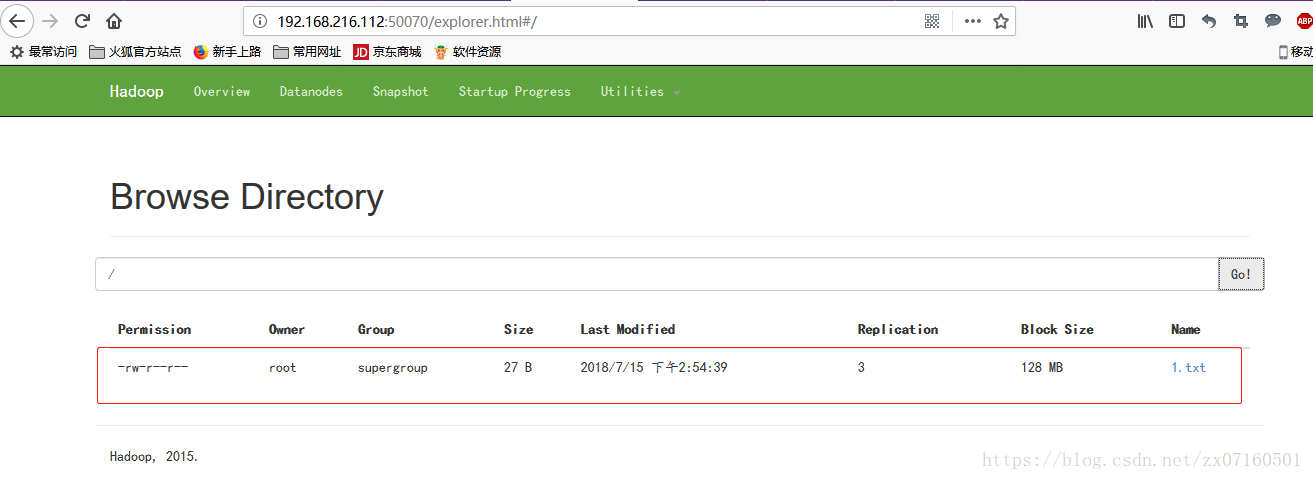

③hdfs读文件(必须在工作状态的节点上)

④关闭active的节点,测试standby节点是否正常

hadoop02节点:

hadoop01节点:

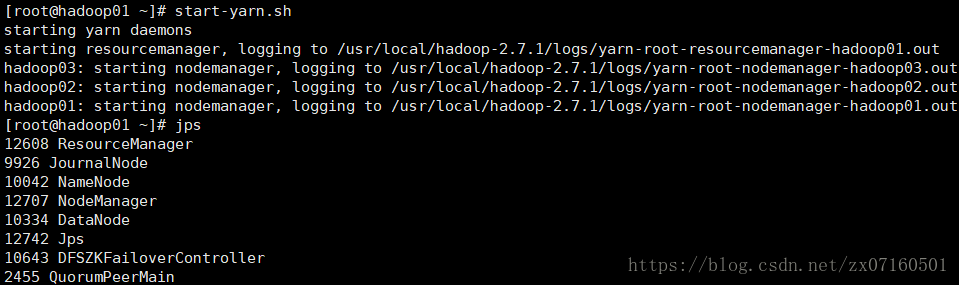

3.启动yarn ha集群

①hadoop01启动start-yarn.sh

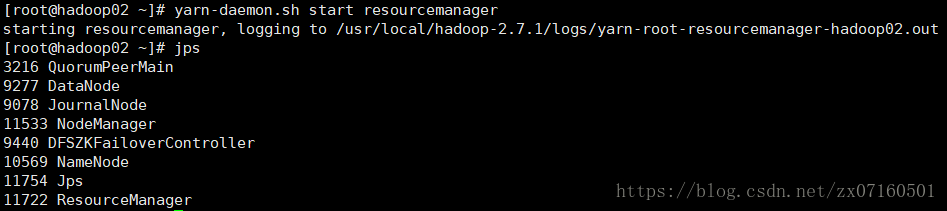

②hadoop02手动启动ResourceManager yarn-daemon.sh start resourceManager

③验证测试

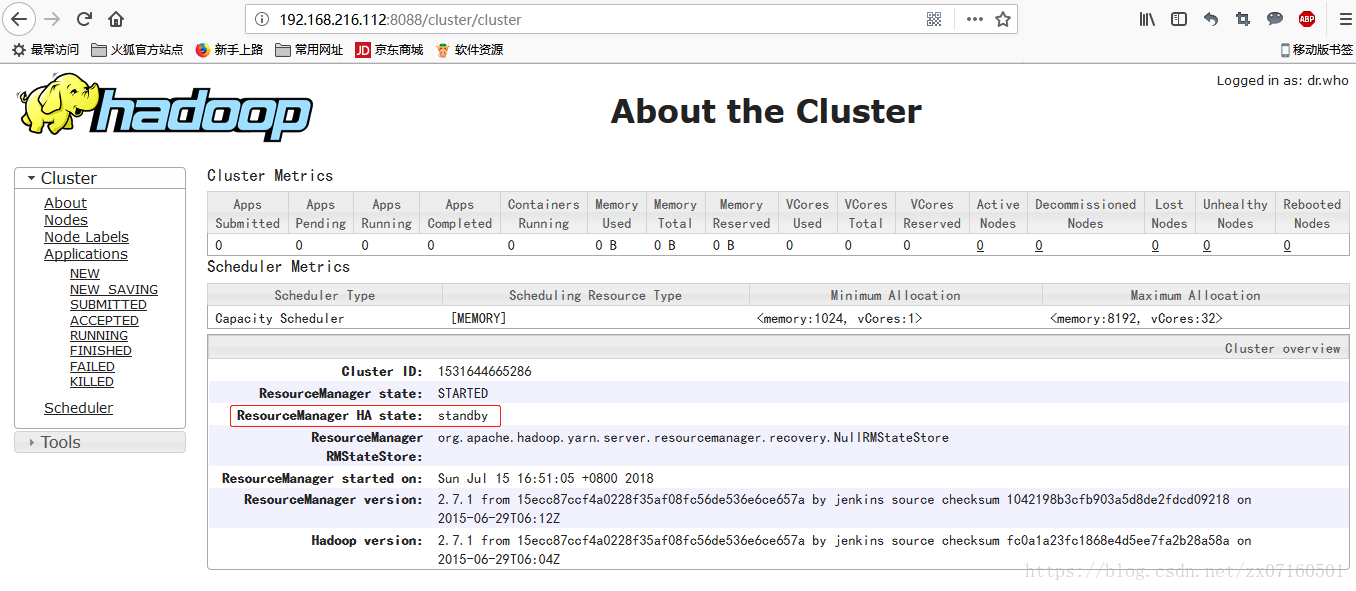

web ui界面

hadoop01 active:

hadoop02 standby:

这样就成功启动。

启动过程中可能会出现refuse connection,可以尝试关闭虚拟机的防火墙等。