参考书籍:李航.统计学习方法

视频资料:张志华.上海交通大学.机器学习

李航.统计学习方法主要介绍在离散的情况下EM算法的推导,张志华则介绍了连续情况下的EM算法推导,下面笔记则是将两者结合起来。

1、定义

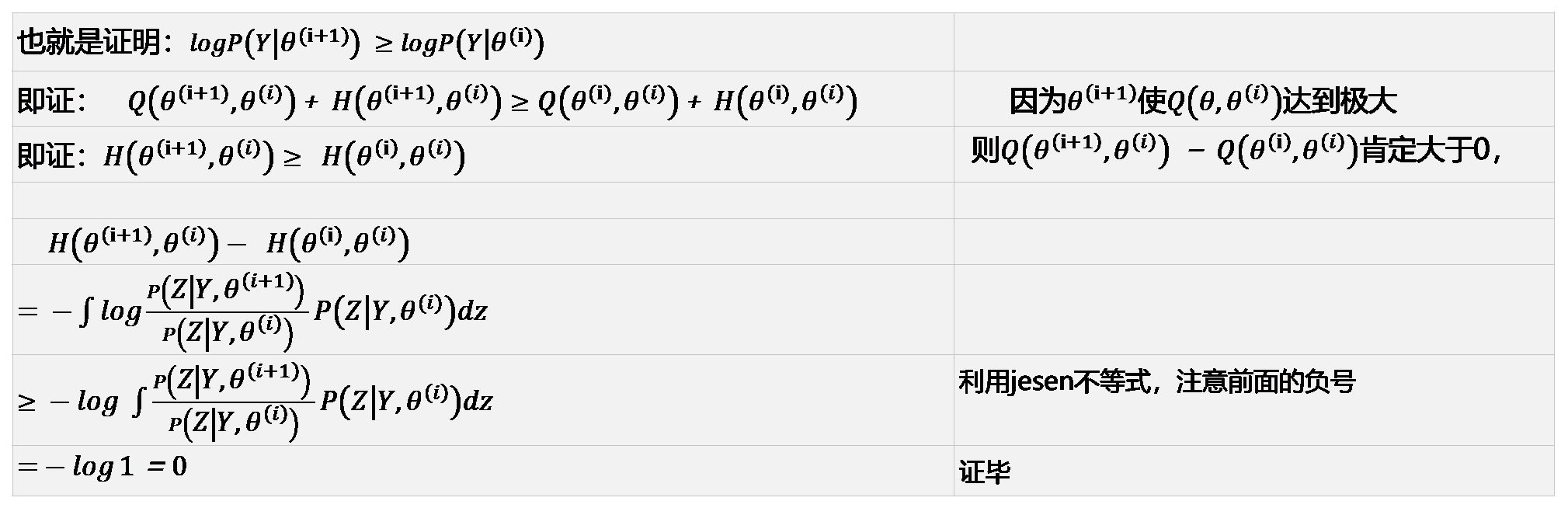

EM算法是求解含有隐变量概率模型的极大似然估计(或极大后验概率)的迭代方法。

2、目标函数

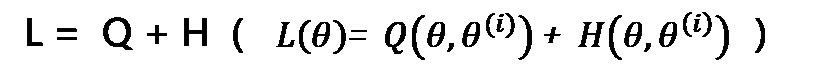

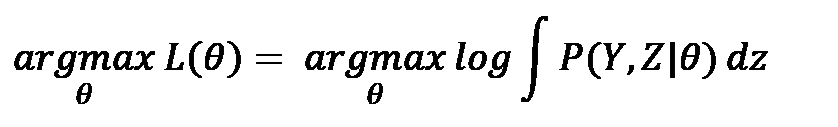

理论的目标函数:

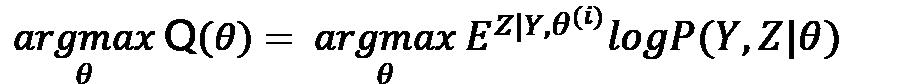

实际求解的目标函数:

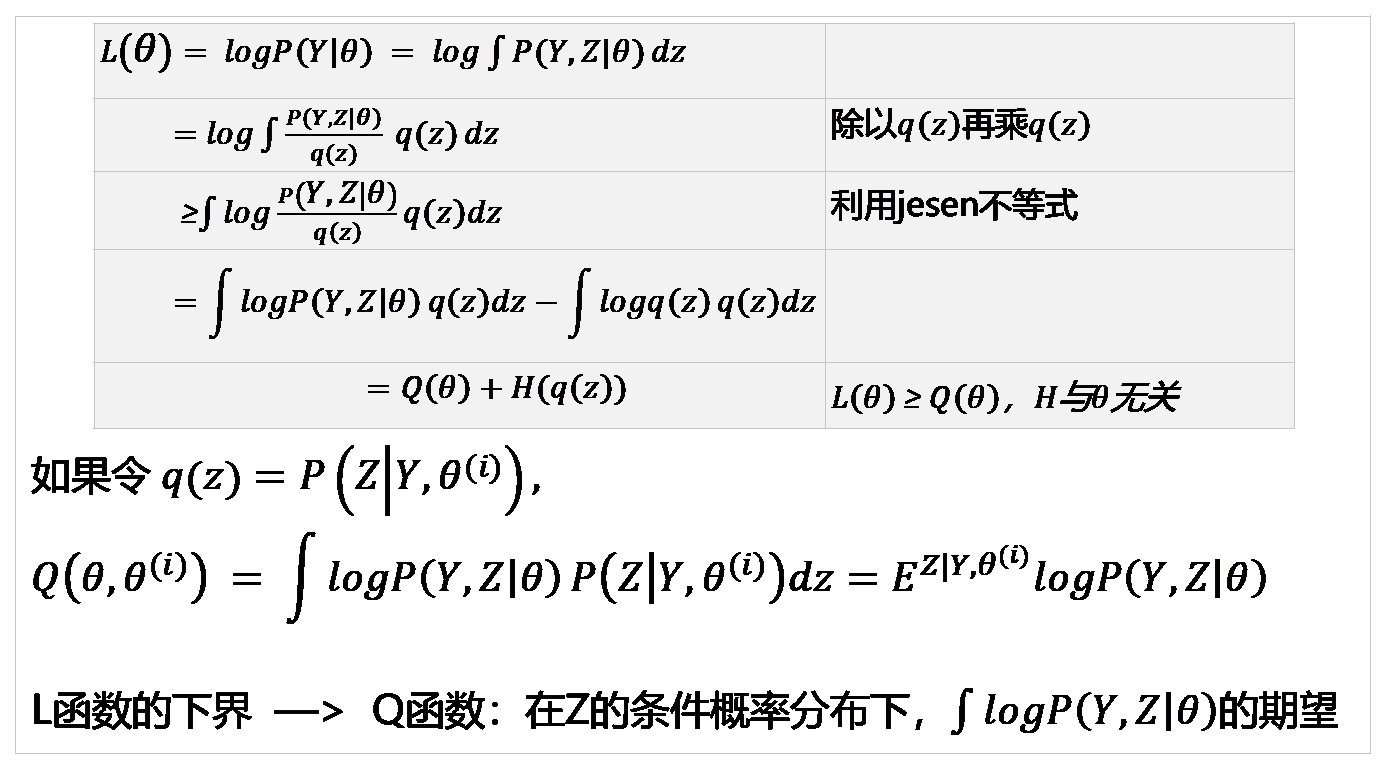

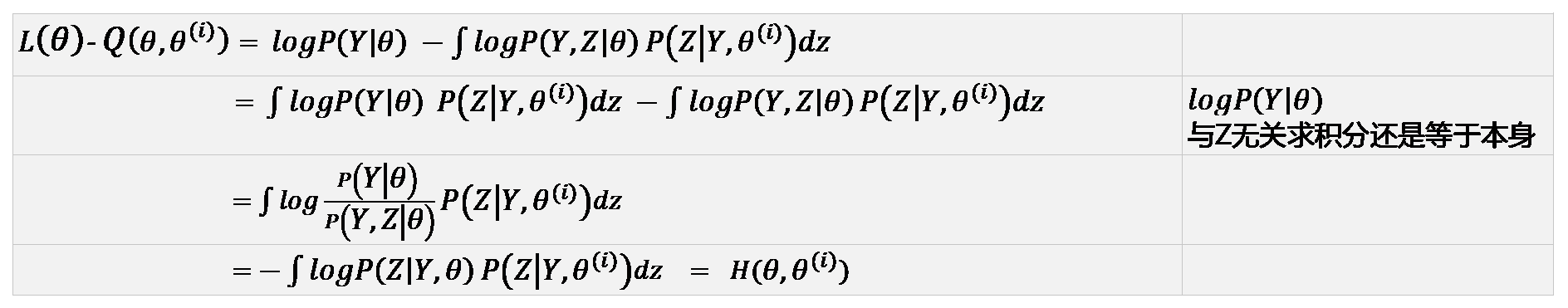

推导:

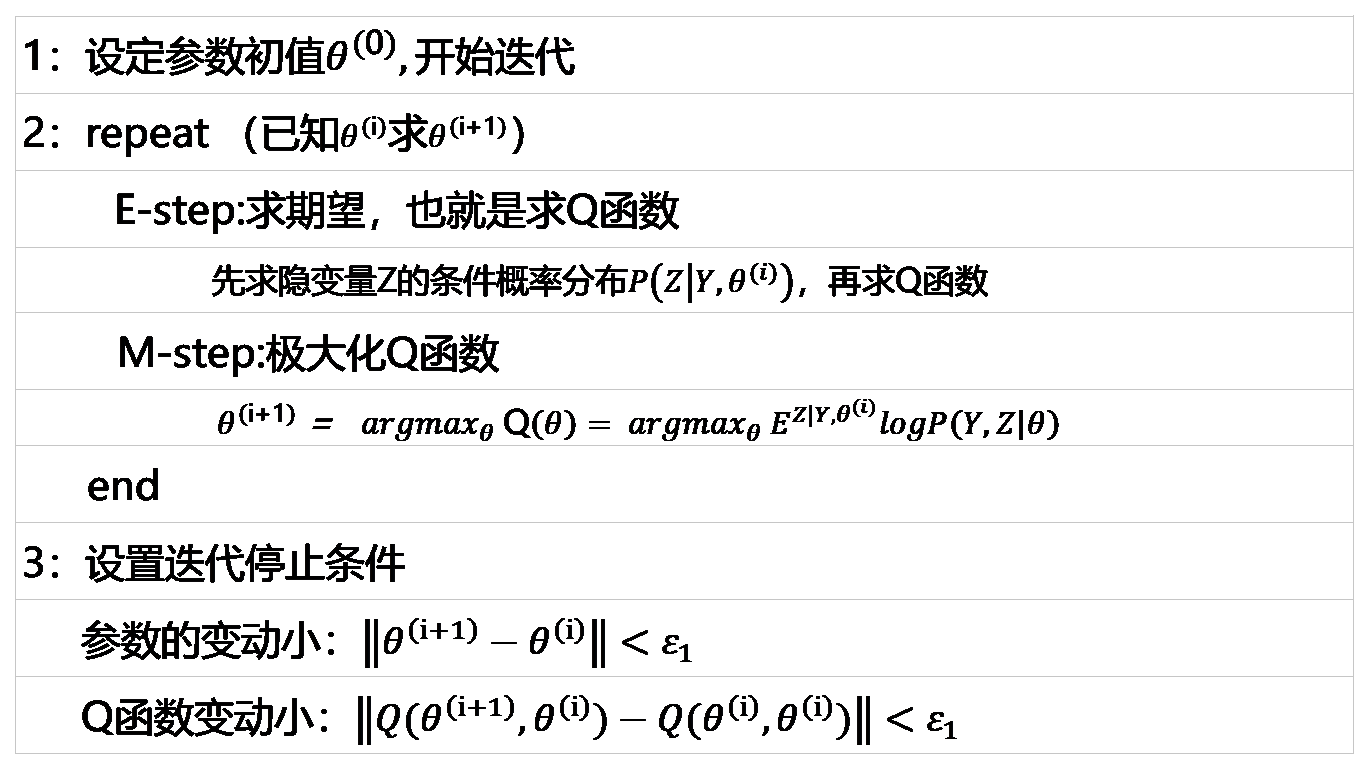

3、步骤

输入:观测变量数据,隐变量数据Z,联合分布,条件分布

输出:参数模型

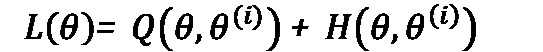

4、EM算法收敛性证明

单调有界即收敛

证明单调性之前,首先证明

(此部分和统计学习方法有差异,主要根据张志华老师视频得来,该解释结合EM算法的推广更为合理)

最终得

(1) 证明观测数据似然函数为单调增函数,也就是证L函数是单调增函数

(2)只要有上界,则收敛

5、改进(or推广)

GEM算法(以后补充)

6、算法的时间和空间复杂度

(以后补充)

7、问题

1)有上界,EM算法才收敛,并且不一定收敛到全局最优

2)对数似然函数的收敛与参数序列的收敛不一致,上面仅证明了对数似然函数序列的收敛。(详细看《统计学习方法》)

解决办法:选择不同初值进行迭代,比较不同结果取最好的值。

8、应用

- 高斯混合聚类模型(GMM)

- 朴素贝叶斯法的非监督学习模型

- 隐马尔科夫的非监督学习模型