版权声明:转载请注明出处,谢谢。 https://blog.csdn.net/NNNNNNNNNNNNY/article/details/70194432

CNN网络的经典结构是: 输入层—>(卷积层+—>池化层?)+—>全连接层+

(其中+表示至少匹配1次,?表示匹配0次或1次)

全卷积神经网络Fully Convolutional Network (FCN)

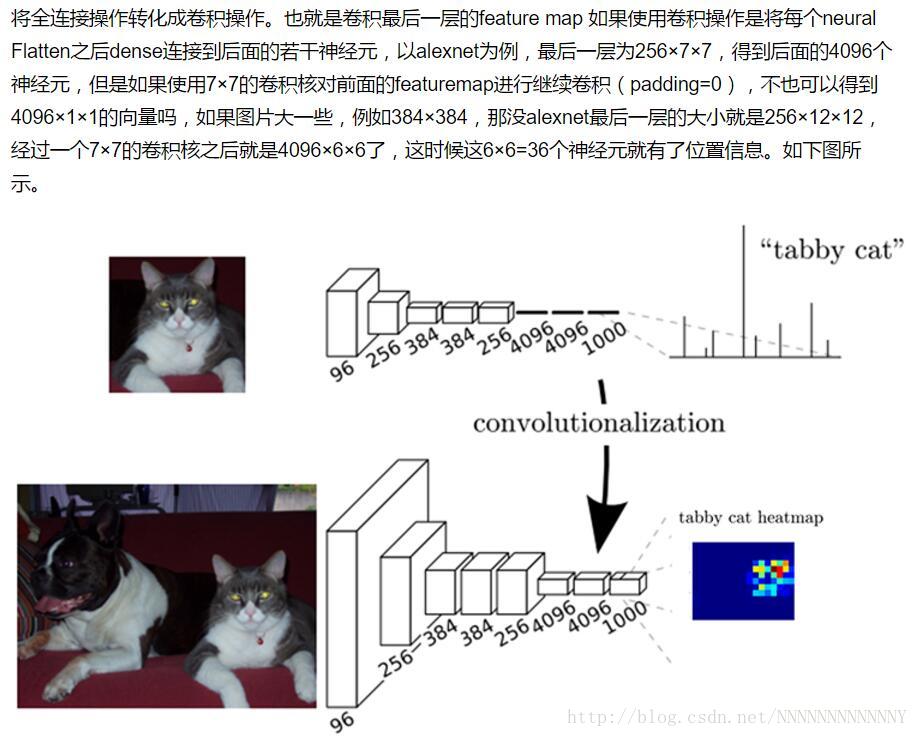

全卷积神经网络即把CNN网络最后的全连接层替换为卷积层。为什么这么做?换句话说这样会带来什么好处呢?

首先,说一下卷积层和全连接层的区别:卷积层为局部连接;而全连接层则使用图像的全局信息。可以想象一下,最大的局部是不是就等于全局了?这首先说明全连接层使用卷积层来替代的可行性。

然后,究竟使用卷积层代替全连接层会带来什么好处呢?答案:可以让卷积网络在一张更大的输入图片上滑动,得到每个区域的输出(这样就突破了输入尺寸的限制)。论文里Fully Convolutional Networks for Semantic Segmentation介绍的很清楚,解读如下:

需要说明的是这一特性不仅可用于语义分割,在物体分类、目标检测中都可以使用。

参考:

How does the conversion of last layers of CNN from fully connected to fully convolutional allow it to process images of different size?

CS231n课程笔记翻译:卷积神经网络笔记

论文笔记–Fully Convolutional Networks for Semantic Segmentation