版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/xiaomifanhxx/article/details/86666118

这段时间,特别懵懵懂懂,每天跑网络但是不知道为什么这样做,总感觉是个黑盒子,想要慢慢把它原理弄清楚。

1、为什么梯度下降可以达到全局最优点?为什么朝着梯度的反方向下降是正确的方向?

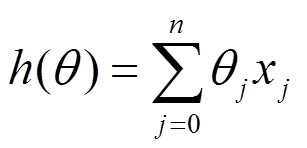

拿一个回归函数以及目标函数为例:

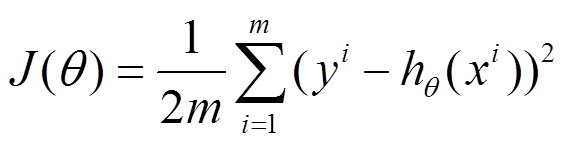

以均方误差作为目标函数(损失函数)

我们的目的是将损失函数的损失降到最低,这意味着我们的回归精度得到了提高。由拉格朗日中值定理

我们可以得到要使比f(x0)要小,我们就要使得

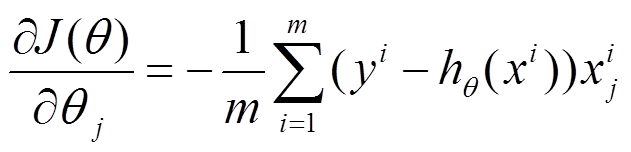

为负值并且越大越好。随即,我们对损失函数进行求导:

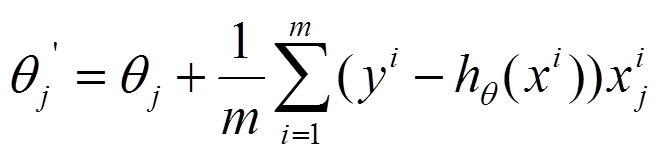

参数沿着导数的方向移动,

是梯度,沿着梯度的反方向下降是收敛最快的方向,因此沿着梯度的反方向下降会使得损失值变小,使得精度提高。