版权声明:如使用此博客内容,请经过作者同意,谢谢 https://blog.csdn.net/qq_40994943/article/details/85126310

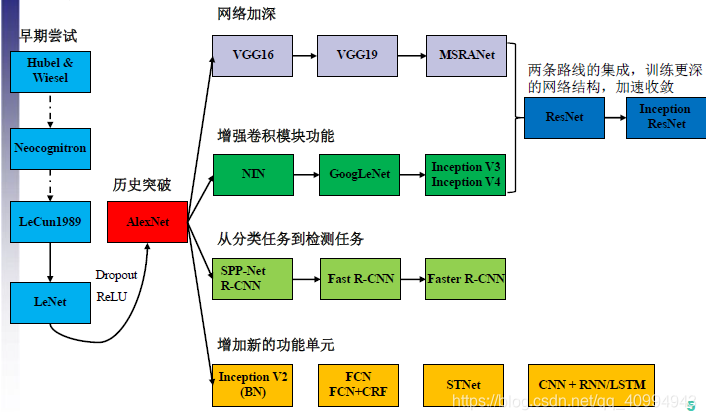

总体趋势图

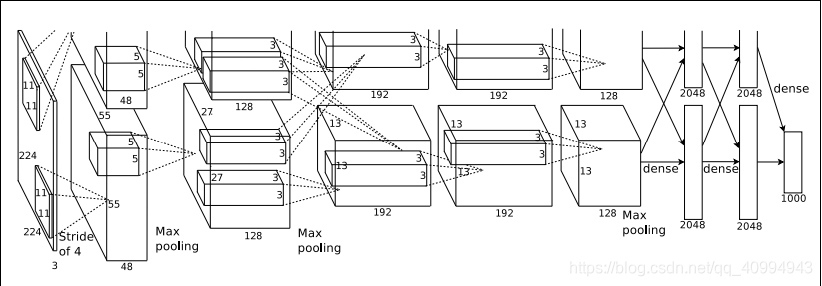

1.alexnet:

优点:

1.使用了relu,并验证在较深的网络中解决了sigmod会产生梯度弥散问题

2.在最后全连接层使用了dropout避免了过拟合

3.使用最大池化,避免平均池化的模糊化效果,并提出让步长比池化核的尺寸小,这样池化层的输出之间会有重叠覆盖,提升特征丰富性

4.提出了lrn(归一化)层

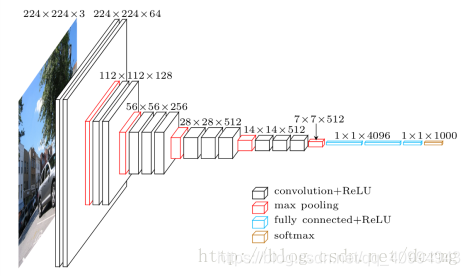

2.vggnet(16,19)

优点:用两个3乘3卷积层代替1个5乘5卷积层,特征学习能力更强

总结观点:LRN层作用不大,越深的网络越好,1乘1卷积核也是有效的,但是没有3乘3好,大一些的卷积核可以学习更大空间特征

3.inception(v1,v2,v3,v4)

v1(googlenet):inception module

v2:

加入了BN层,使每一层的输出都规范化到一个N(0, 1);学习VGG用2个3x3的conv替代inception模块中的5x5,既降低了参数数量,也加速计算;去除dropout并减轻L2正则

v3:

优化inception module

v4:

结合resnet,得到一个Inception-ResNet v2网络

refer to博客