arXiv-2018

TECH REPORT

部分整理参考 YOLO:YOLOv1,YOLOv2,YOLOv3,TinyYOLO,YOLOv4,YOLOv5详解

文章目录

1 Advantages / Contributions

COCO 数据集上,at 320 × 320 YOLOv3 runs in 22 ms at 28.2 mAP, as accurate as SSD but three times faster

2 Method

2.1 Bounding Box Prediction

bbox 的监督用的是 squared error loss,预测 offset t _ t\_ t_

预测 objectness score 用的是 logistic regression 分类器

与 GT IoU 最大的 prior box 的标签 objectness score 为 1,每个 GT 只指定一个 box prior

没有和 GT 配对的 prior box 只有 objectness loss,没有 coordinate 和 class prediction loss

2.2 Class Prediction

multi-label classification

分类器没有用 softmax,而是 independent logistic classification,loss 为 binary cross-entropy

2.3 Predictions Across Scales

每个 scale 预测

N × N × [ 3 ∗ ( 4 + 1 + 80 ) ] N × N × [3 * (4+1+80)] N×N×[3∗(4+1+80)]

- 3,每个 cell 3 个 priors

- 4 bounding box offsets

- 1 objectness prediction

- 80 class predictions

每种尺度预测 3 个 box, anchor 的设计方式仍然使用聚类,9 clusters 分布在 3 个 scale 上

(10 ×13); (16 × 30); (33 × 23); (30 × 61); (62 × 45); (59 × 119); (116 × 90); (156 × 198); (373 × 326)

图片来自 一文看懂YOLO v3

YOLOv3 只会对 1 个 prior 进行操作,也就是那个最佳 prior。而 logistic 回归就是用来从 9 个 anchor priors 中找到 objectness score(目标存在可能性得分)最高的那一个

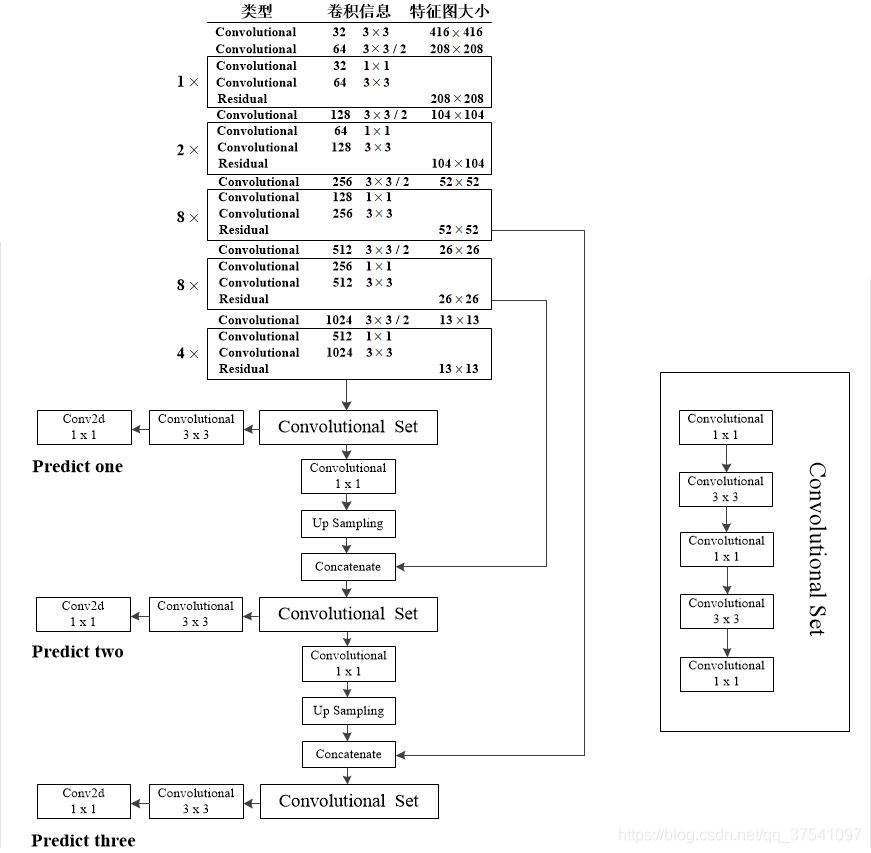

2.4 Feature Extractor

Darknet-53

跑分类时结构如下:

注意没有 pooling 操作哟

Table 2,在 Titan X 上 256×256 single crop 的结果

用于 detection 的结构如下:

图片来源 YOLO v3网络结构分析

3 Experiments

COCO 数据集

Table 3 AP.5 还行,AP 还是不够看的

随着IOU的增大,性能下降,说明 YOLOv3 不能很好地与ground truth切合

Figure 3 AP.5 还有一战之力

4 Rebuttal

Reviewer #2 diss 图1 图3 坐标原点非 0,作者画了个图 4

Reviewer #4 说作者 diss mAP 的理由不充分

作者来了个图 5

A miss-classified example is much more obvious than a bounding box that is slightly shifted

VOC metric 阈值给的低是因为 IOU threshold was ”set deliberately low to account for inaccuracies in bounding boxes in the ground truth data“

COCO 可以标的更准(跑过都知道,哈哈),但 mAP 过于关注 location,其实 classification 也蛮重要! 图 5 两个检测器算 mAP(每类根据每个 bb 的 score 排序,画 PR曲线,算面积,类平均) 一摸一样,但是效果显然 detector1 好

5 补充

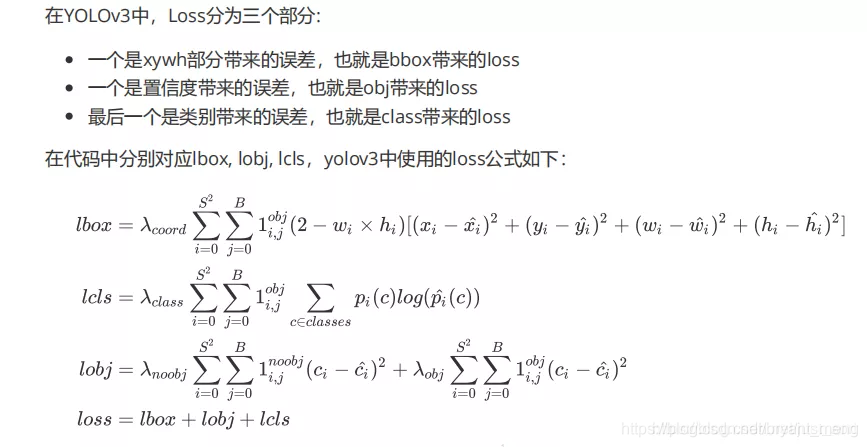

- Loss 来自 你对YOLOV3损失函数真的理解正确了吗?