本文是接着上一篇深度学习之 8 深度模型优化与正则化2_水w的博客-CSDN博客

目录

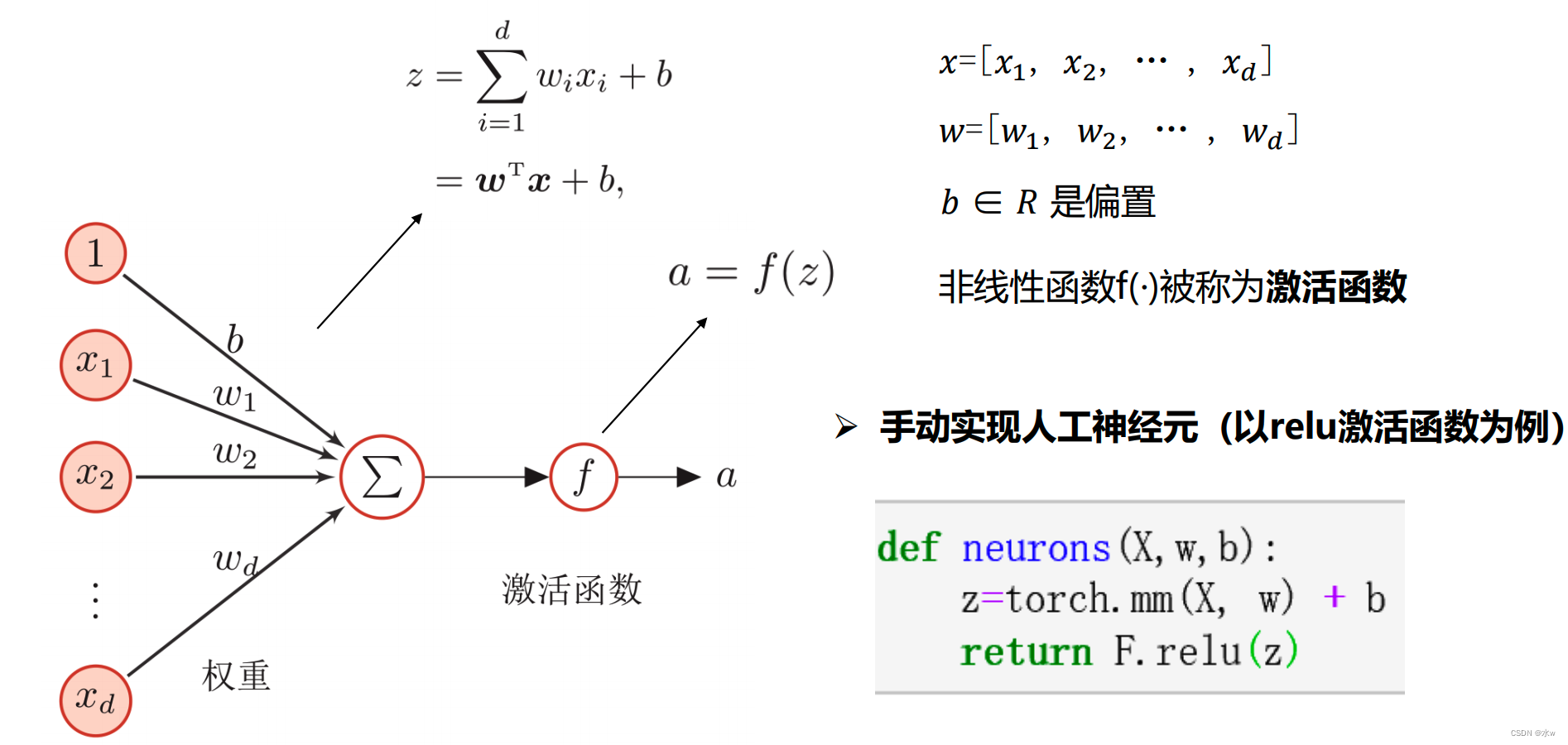

人工神经元

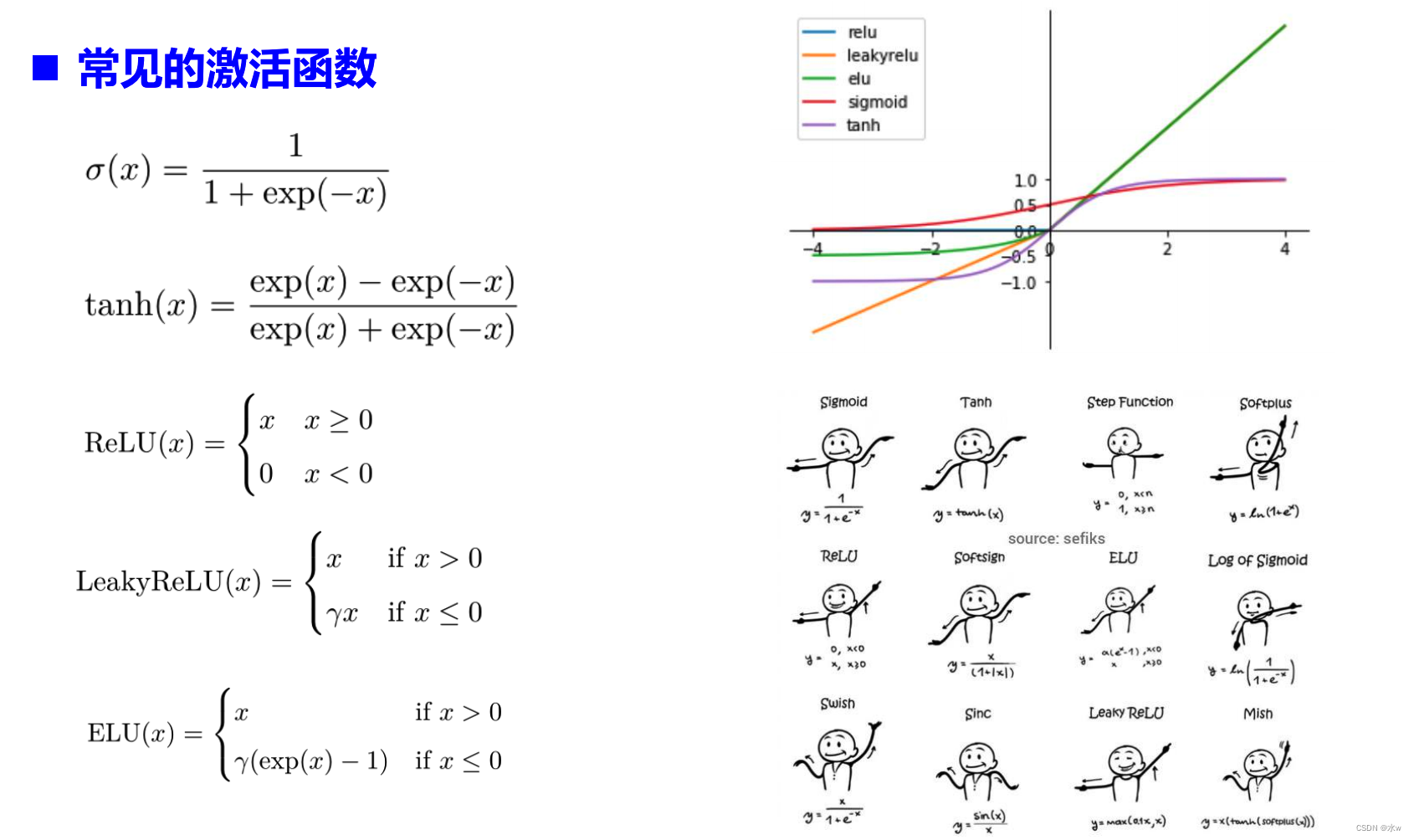

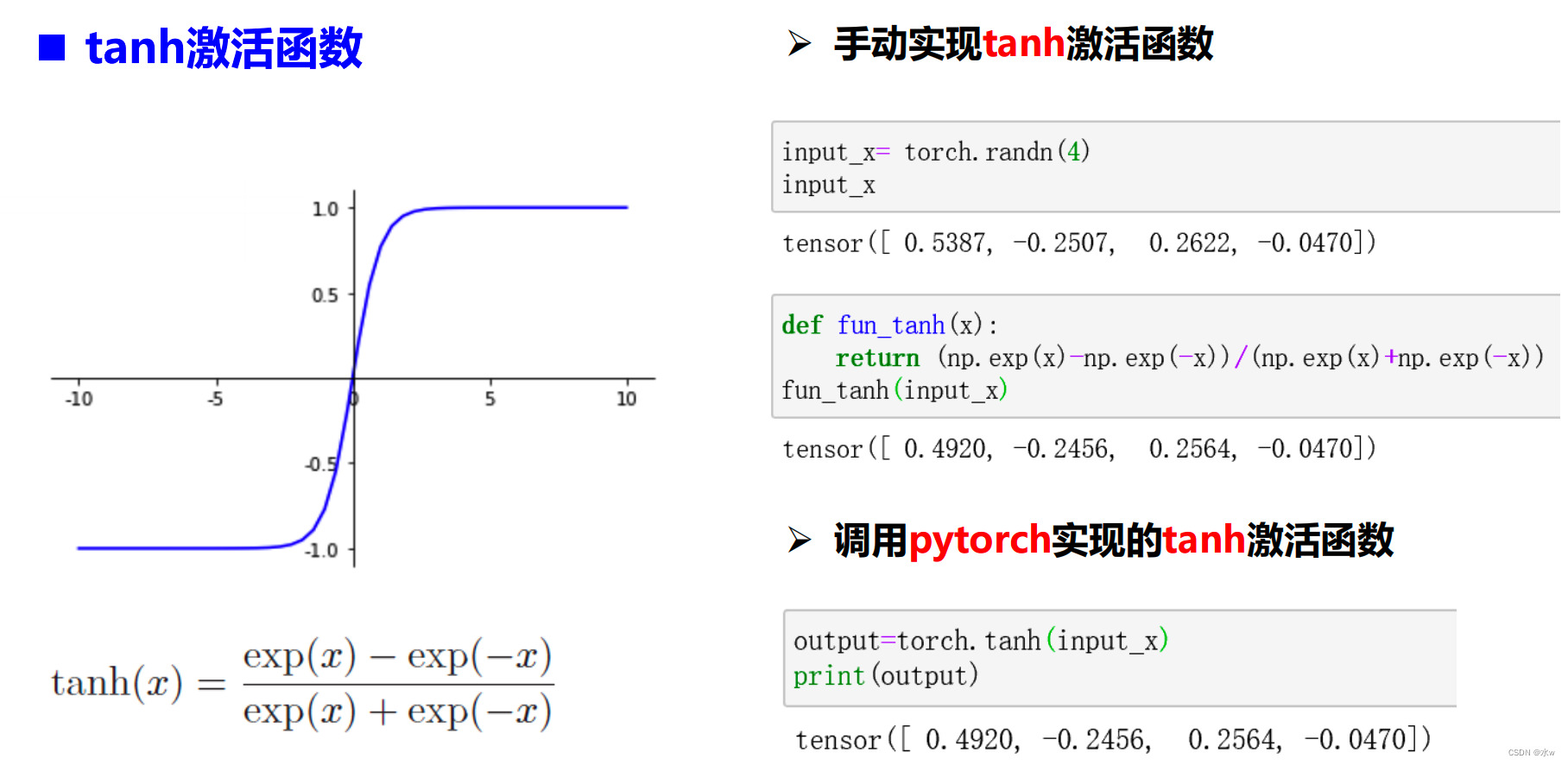

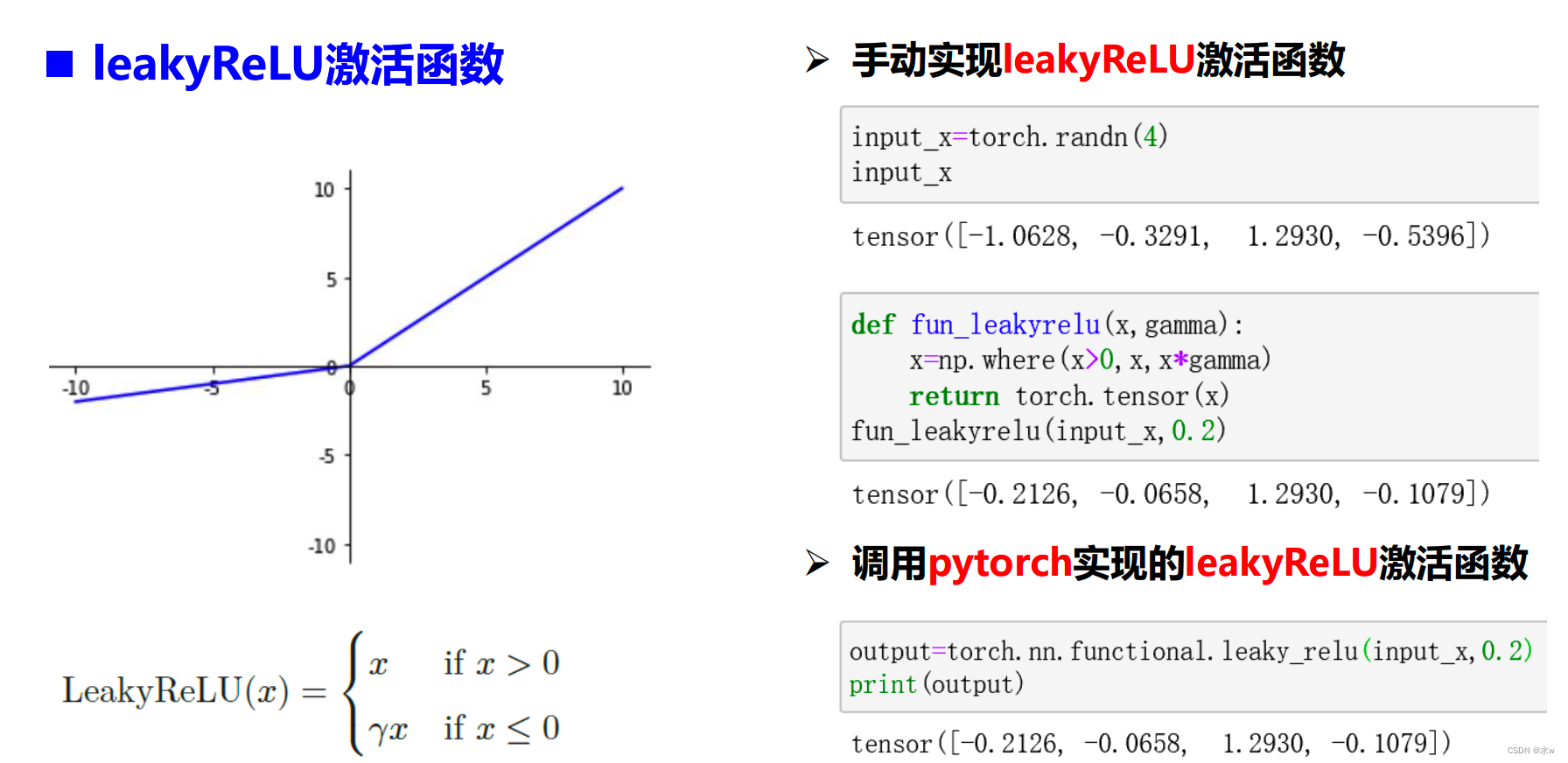

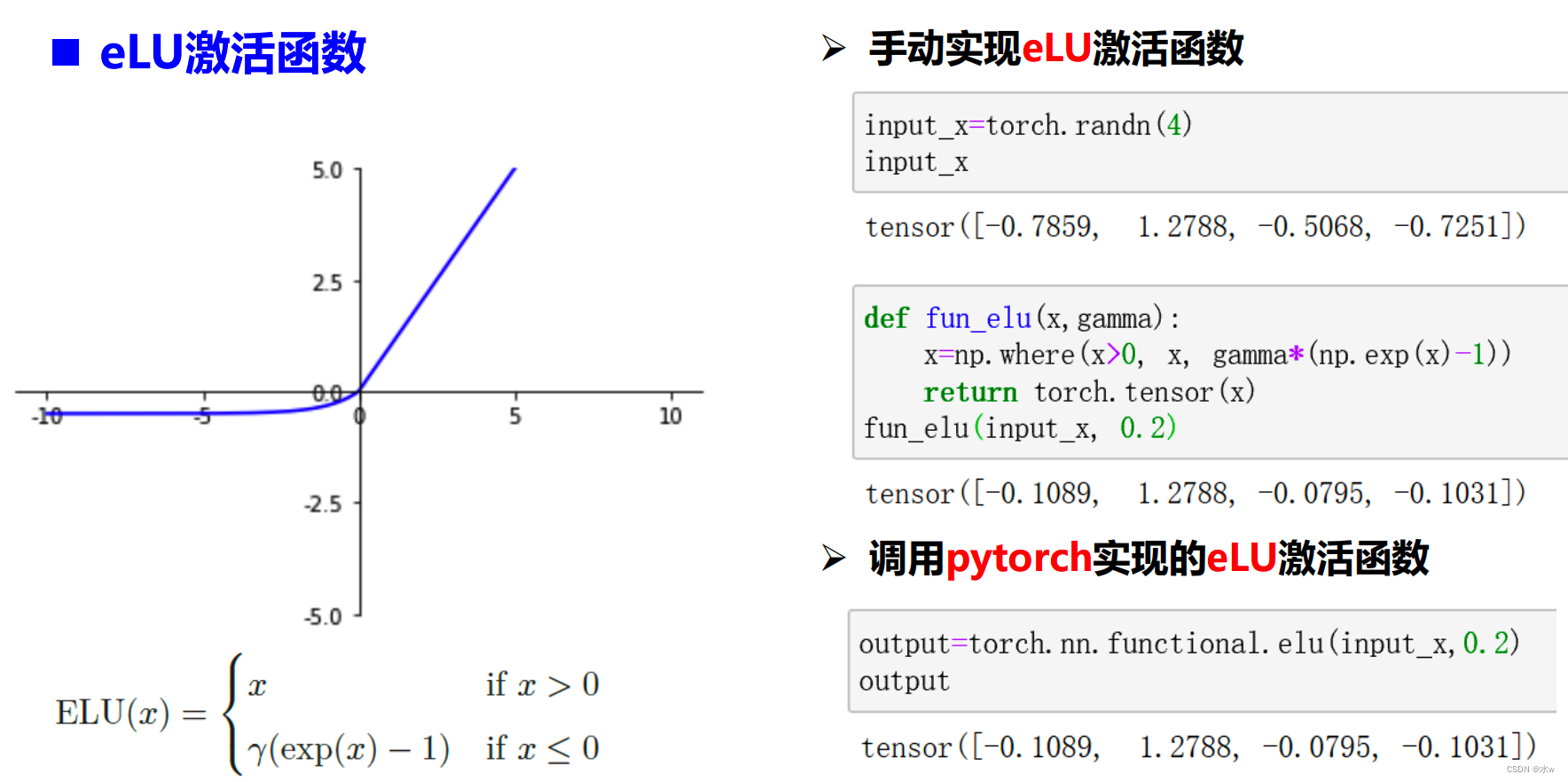

激活函数

◼ 如何选择激活函数

通常来说,很少会把各种激活函数串起来在一个网络中使用的。

如果使用 ReLU ,那么一定要小心设置 learning rate ,而且要注意不要让网络出现很

多“ dead ”神经元,如果这个问题不好解决,那么可以试试 LeakyReLU 、PReLU。

最好不要用 sigmoid ,可以试试 tanh ,不过预期它的效果会比不上 ReLU。

根据具体的模型,进行具体的分析和选择

前馈神经网络的组成

优化器的使用

常用的优化器:SGD、AdaGrad、RMSProp等

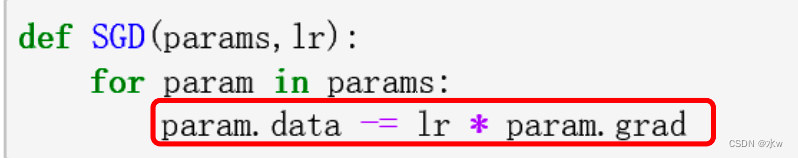

➢ 手动实现SGD

➢ pytorch如何使用SGD。torch.optim实现了各种优化算法

其他优化器的使用可以参考pytorch官方文档。