OpenLLMetry 简介

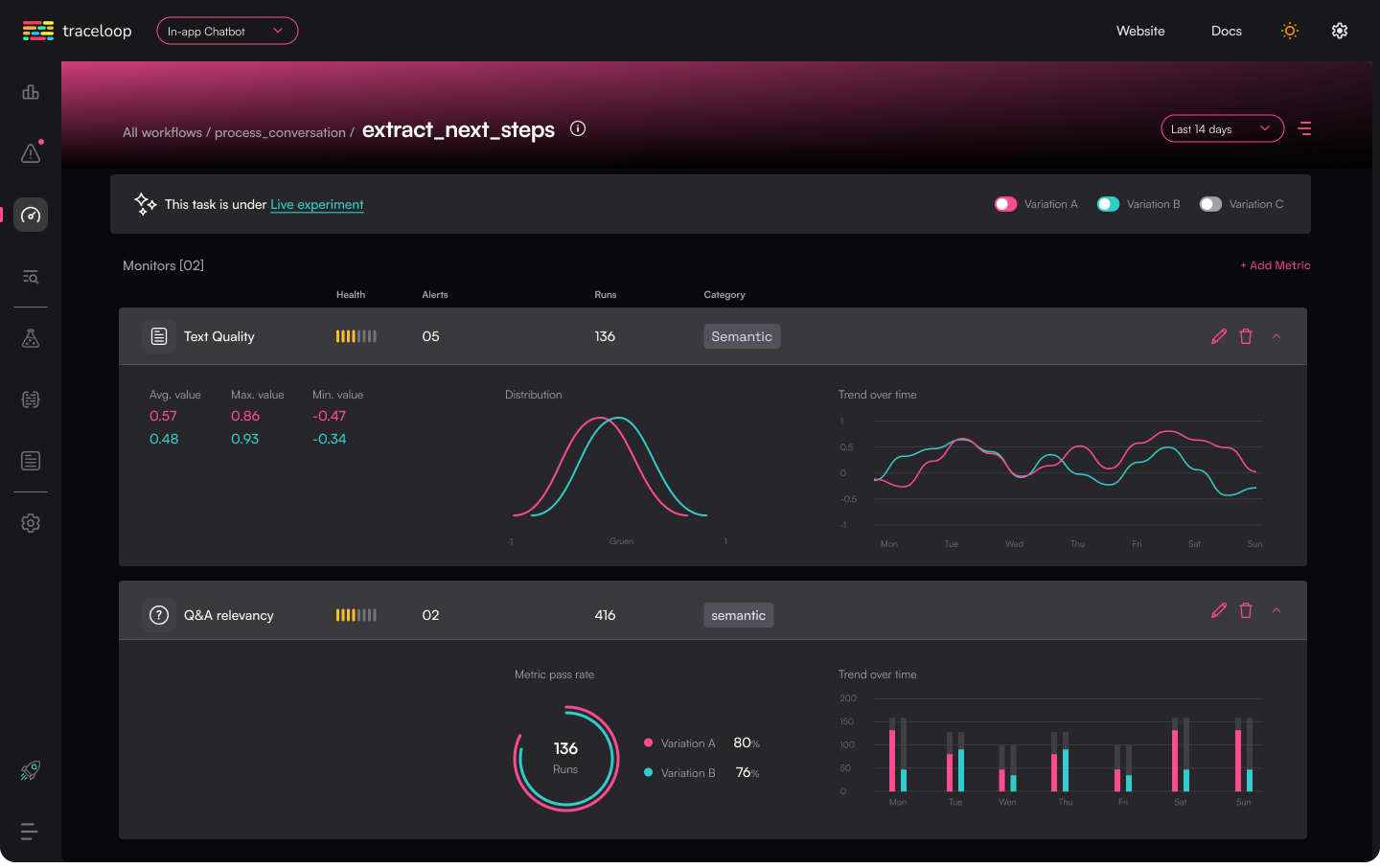

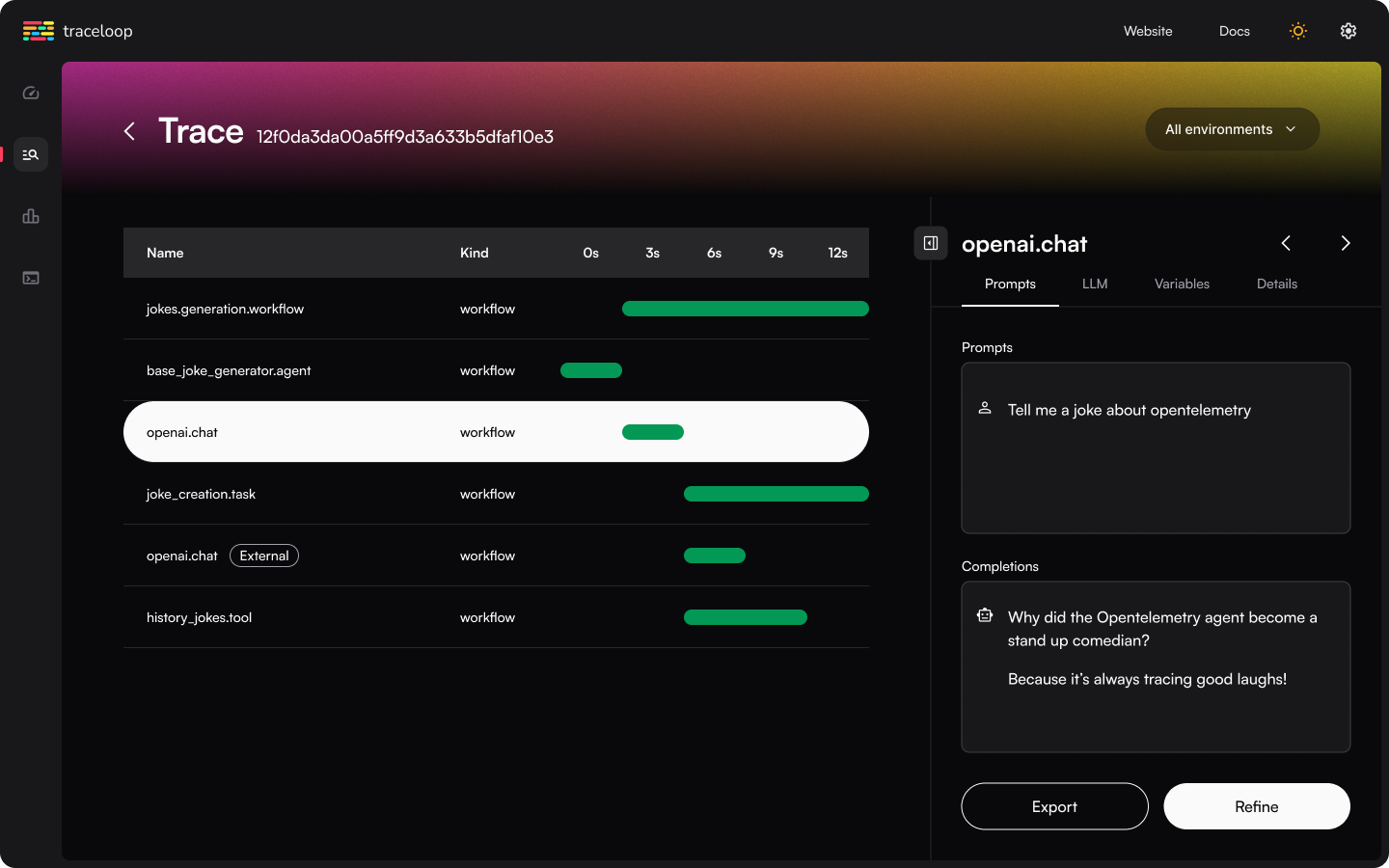

OpenLLMetry[1] 是一个基于OpenTelemetry的开源可观测性工具,专为LLM(Large Language Models,大型语言模型)应用设计。 它提供了一套扩展,可以帮助开发者全面监控和管理他们的LLM应用。

项目特点

主要特点

-

基于OpenTelemetry:利用OpenTelemetry的底层能力,可以轻松连接到现有的可观测性解决方案,如Datadog、Honeycomb等。

-

易于集成:提供SDK,简化了与OpenLLMetry的集成过程,同时输出标准OpenTelemetry数据。

-

支持多种目的地:支持多种观测数据目的地,包括Traceloop、Dynatrace、Datadog、New Relic等。

-

自定义扩展:除了OpenTelemetry的标准监控外,还提供了针对LLM提供商和向量数据库的自定义扩展。

使用场景

OpenLLMetry适用于需要监控和管理大型语言模型应用的场景,尤其是在需要深入了解模型性能和行为的场合。它可以帮助开发者追踪和优化模型的调用,以及监控与模型交互的API和数据库。

项目使用

Traceloop支持Python、JavaScript / TypeScript,Go和Ruby处于Beta阶段,Java和Elixir正在开发中。以下是Python SDK的基本安装和使用。

安装与使用

-

安装SDK:

pip install traceloop-sdk

-

在代码中初始化Traceloop:

from traceloop.sdk import Traceloop

Traceloop.init()

如果需要立即查看追踪结果,可以禁用批处理发送:

Traceloop.init(disable_batch=True)

工作流装饰器

使用OpenLLMetry提供的装饰器来注释你的代码中的工作流。这有助于在Traceloop仪表板上追踪和监控工作流的执行。

from traceloop.sdk.decorators import workflow

@workflow(name="suggest_answers")

def suggest_answers(question: str):

...

@aworkflow(name="summarize")

async def summarize(long_text: str):

...

项目资源

-

官方文档[2]

-

Demo地址[3]

-

安装指南[4]

-

集成指南[5]

-

Slack社区[6]

-

Twitter[7]

注:本文内容仅供参考,具体项目特性请参照官方 GitHub 页面的最新说明。

欢迎关注&点赞&在看,感谢你的阅读~

资源列表

[1]

Github地址: https://github.com/traceloop/openllmetry

[2]

官方文档: https://traceloop.com/docs/openllmetry/introduction

[3]

Demo地址: https://app.traceloop.com

[4]

安装指南: https://traceloop.com/docs/openllmetry/getting-started-python

[5]

集成指南: https://traceloop.com/docs/openllmetry/integrations/introduction

[6]

Slack社区: https://traceloop.com/slack

[7]

Twitter: https://twitter.com/traceloopdev