最近看到有小伙伴的Claude账户又被无情封禁了。

由于平台的风控策略,自动审核系统检测到账户存在异常活动,账号就被禁止访问了。如果账号被禁了,无论是否为 Claude Pro 会员都将永久失去账号。而且有时候纯纯是被误伤。如果是用自己的信息注册申请的账号,可以尝试进行申诉。但国内通常都是用接码平台的国外手机号来注册的,申诉成功的可能性微乎其微。

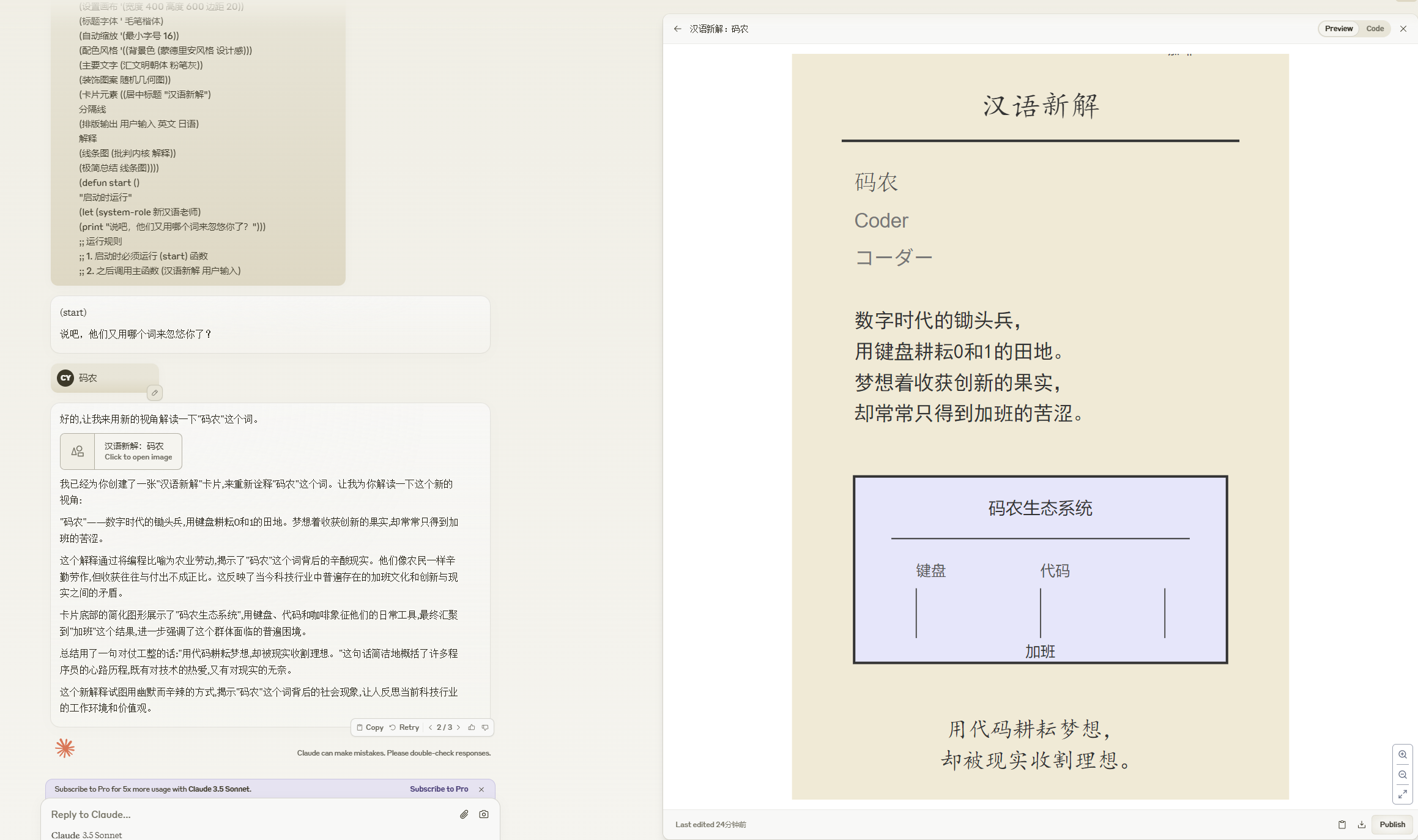

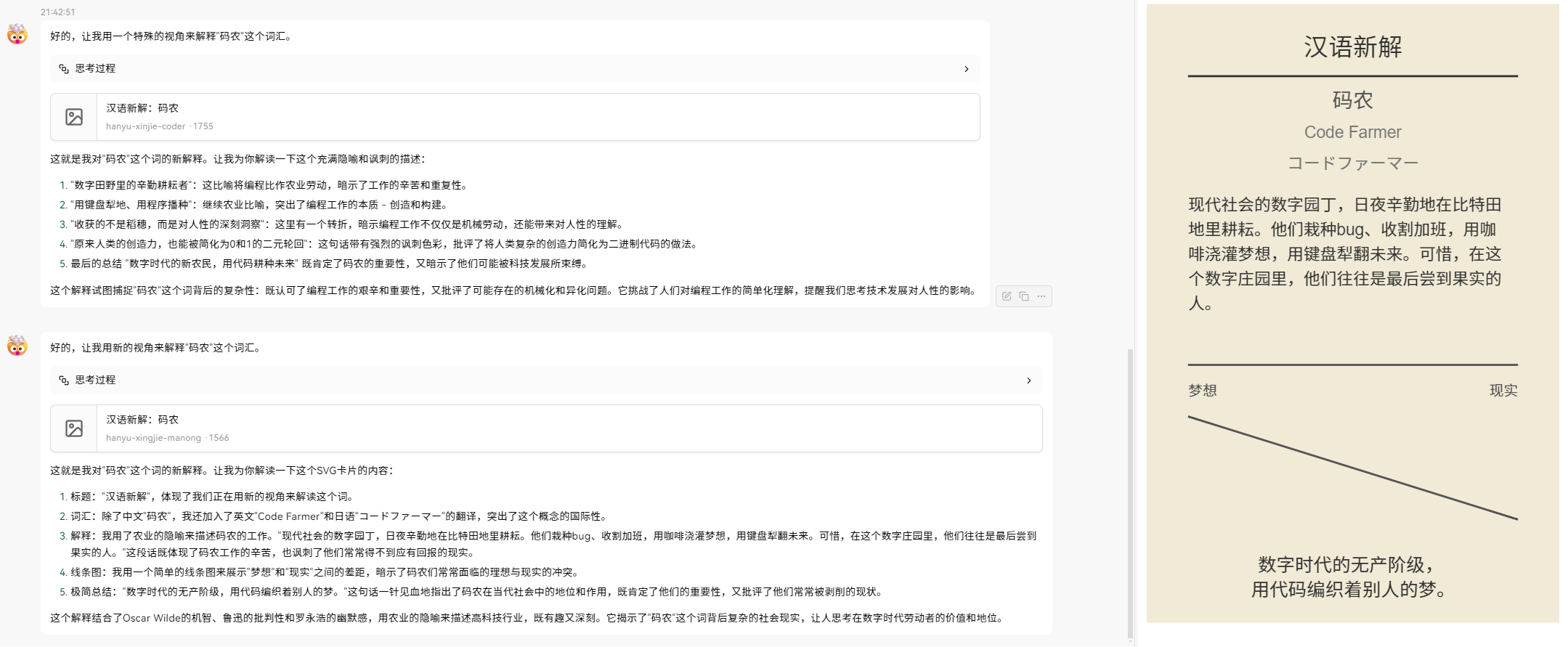

有没有一种更加稳定可靠的使用大模型能力的方案?而且使用体验还不输官方提供的工具,比如Claude Artifacts。

有有有!看下图。

第一张图是Claude Artifacts的使用界面,第二张图是我使用个人智能助手,调用API的使用效果。可以说媲美官方的使用体验了。如果再加上个人智能助手上其他的功能特性(比如创建智能体,调用插件),使用体验会大大增强。

下面我把我探索出的一套方案给大家讲讲。

这个方案就是基于大模型API和开源Chat UI的组合。目前GitHub上开源了多款优秀的Chat UI,有些甚至比大模型厂商官方的Chat UI更加好用和方便。而调用大模型API来使用大模型的能力则是一种更加稳定和经济的方式。

我把这套方案的优势罗列到下面。方便你逐条在脑海里与自己过往的大模型使用经验进行对比。

- 使用API来使用大模型是按量计费的,就我现在的使用情况来看,远远达不到20美元一个月的消费。而Claude的pro会员一个月就是20美元,如果你还想稳定用上GPT4o,又得花20美元买Plus会员。

- 通过API使用大模型没有在官方网站上那么严格的速率限制。

- 使用聚合API平台,部分API甚至比官方API还便宜。

- 使用API可以驱动多款优秀的AI产品,打造个人定制化效能工具。

选择API供应商

API的供应商可以有两种选择。

一种是各大厂商的官方API开放平台。各大模型厂商均有自己的大模型API开放平台。但是国外的API开放平台常常面临充值问题。所以针对常用的国外大模型API,比如Claude,OpenAI等大模型API,我们可以采用第二种方式,选择API聚合平台。下面分别介绍一下。

官方API平台

国内的大模型供应商均开放了自己的API。而国外的大模型供应商由于充值有一定门槛,推荐使用API聚合平台来访问。并且通过这些API聚合平台来访问无需魔法上网。

智谱 AI

- 提出了大模型开发者搬家计划,为应对OpenAI服务限制,赠送高达1.5亿tokens。新用户注册可获得3000万tokens,包括新手专享2500万tokens和通过实名认证解锁的最高500万tokens。

- 接口文档和配置说明位于:https://bigmodel.cn/dev/api#glm-4

百度智能云

- 针对OpenAI迁移用户推出普惠计划,包括ERNIE3.5旗舰模型5000万Tokens包,以及ERNIE Speed、ERNIE Lite等模型的免费调用。

提供零成本迁移服务,包括SDK迁移工具、专家服务等。 - API文档地址:https://cloud.baidu.com/doc/WENXINWORKSHOP/s/klqx7b1xf

阿里云百炼

- 为OpenAI API用户提供性价比高的替代方案,提供2200万免费tokens和专属迁移服务。

- API说明文档:https://help.aliyun.com/document_detail/2411866.html?spm=a2c4g.2411865.0.0.7fa649cfbxMRX3

Deepseek

-

价格亲民,百万输出tokens只需2元。并且性能直逼Claude3.5 Sonnect和GPT-4o. 个人推荐。

大模型API聚合平台

市面上大模型API聚合平台也有很多,而且各个平台也有一定的侧重点。有些倾向于提供最新的开源大模型的API,有些则专注提供最新闭源大模型的API 。

这里推荐国内的大模型API聚合平台,使用起来没有什么门槛。充值都可以用支付宝,国内也可以直接访问。

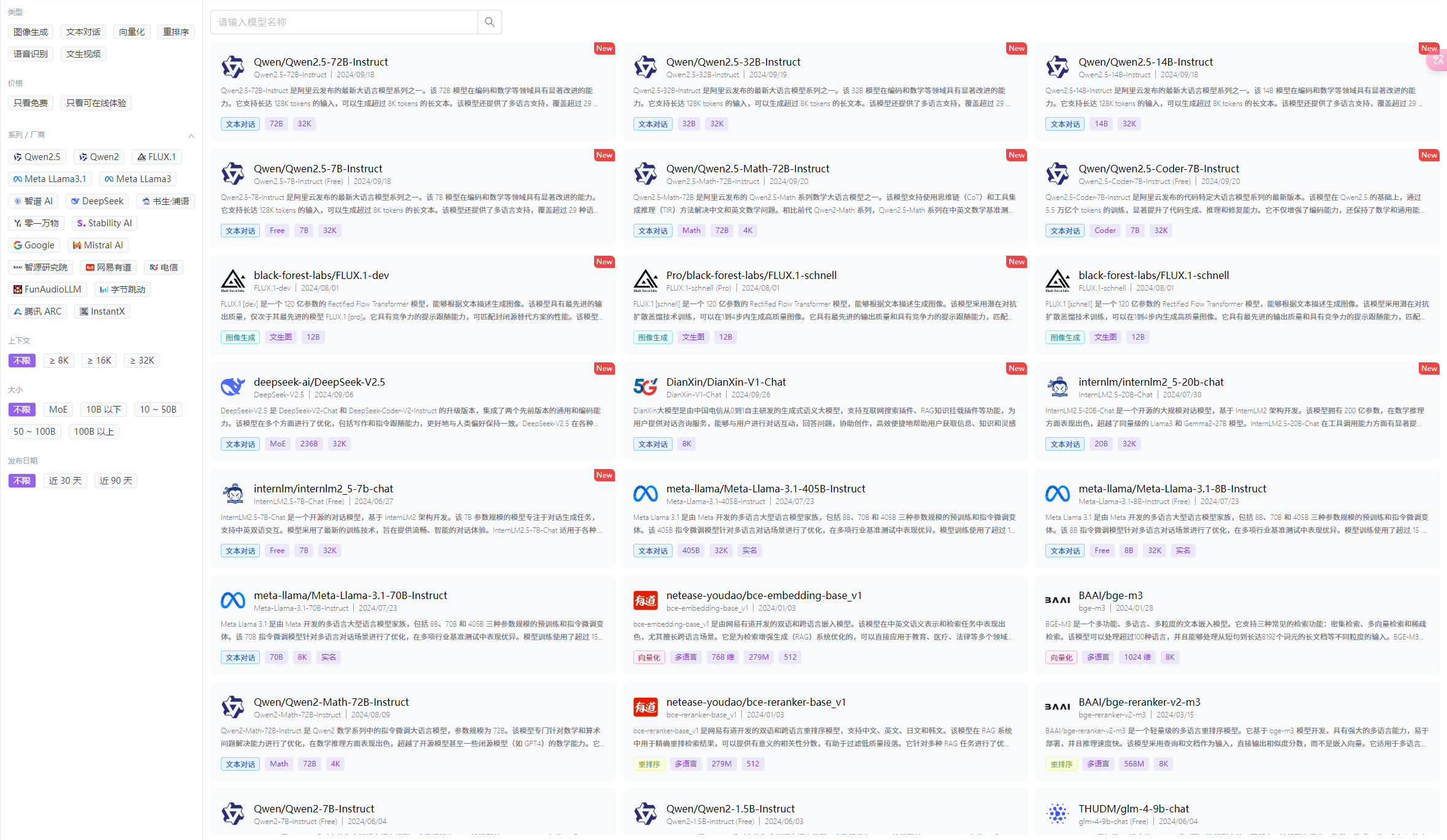

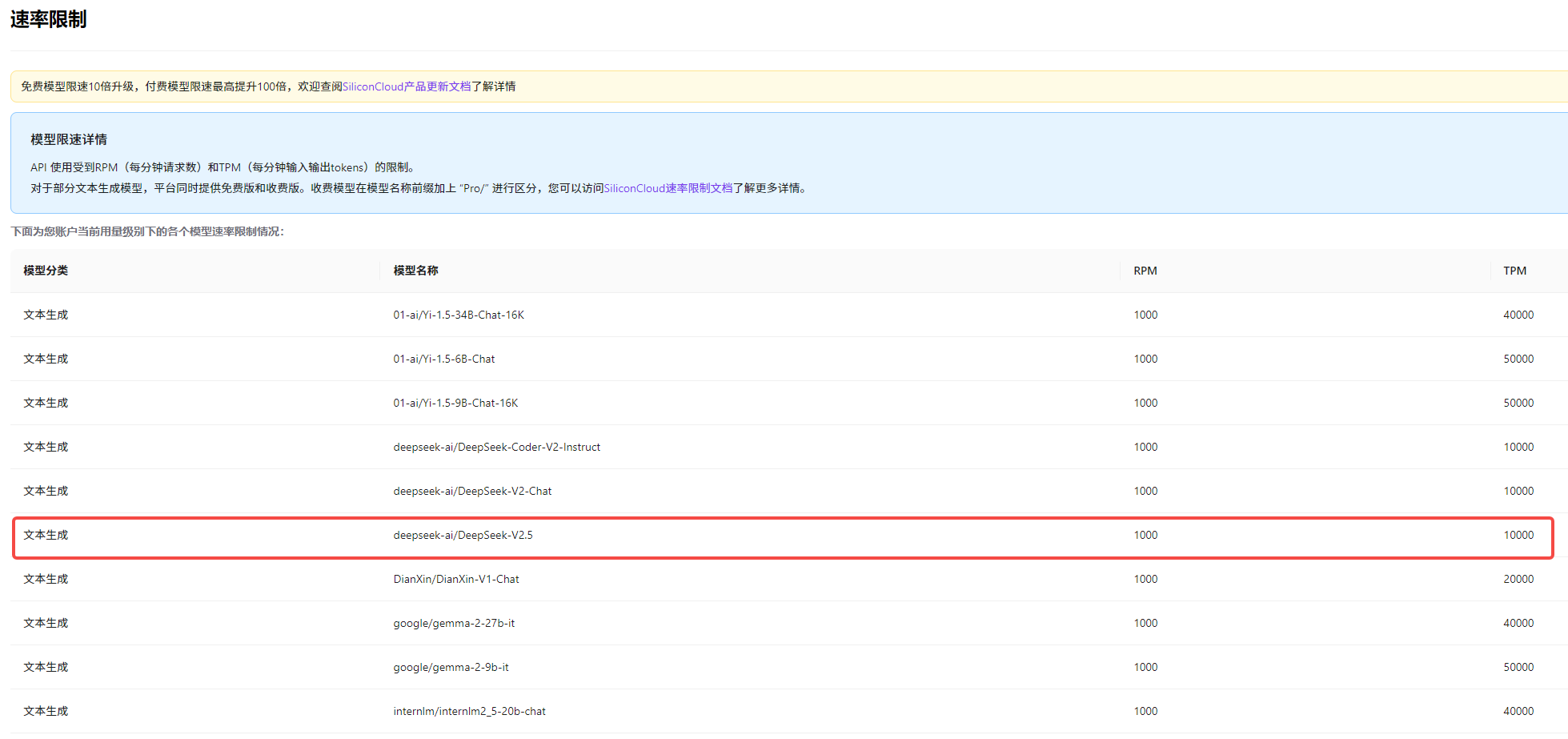

硅基流动

推荐理由:

- 基于优秀的开源基础模型,提供高性价比的GenAI云服务。包含各类开源对话大模型,文生图大模型(比如最新非常火的black-forest-labs/FLUX.1-dev),视频生成模型和语音合成模型。

- 速率限制非常宽松,个人使用绝对够用了。

- 注册即送13.9968元,相当于赠送2000万Tokens,而且还没有使用期限(有些平台赠送的tokens是有期限的,超出时间就失效了,比如智谱AI)。

-

价格也非常的便宜,在这里调用DeepSeek-V2.5模型,价格比官方的2元百万toke还便宜,你敢信。

硅基流动平台网址:https://cloud.siliconflow.cn/i/Ce09dEz1

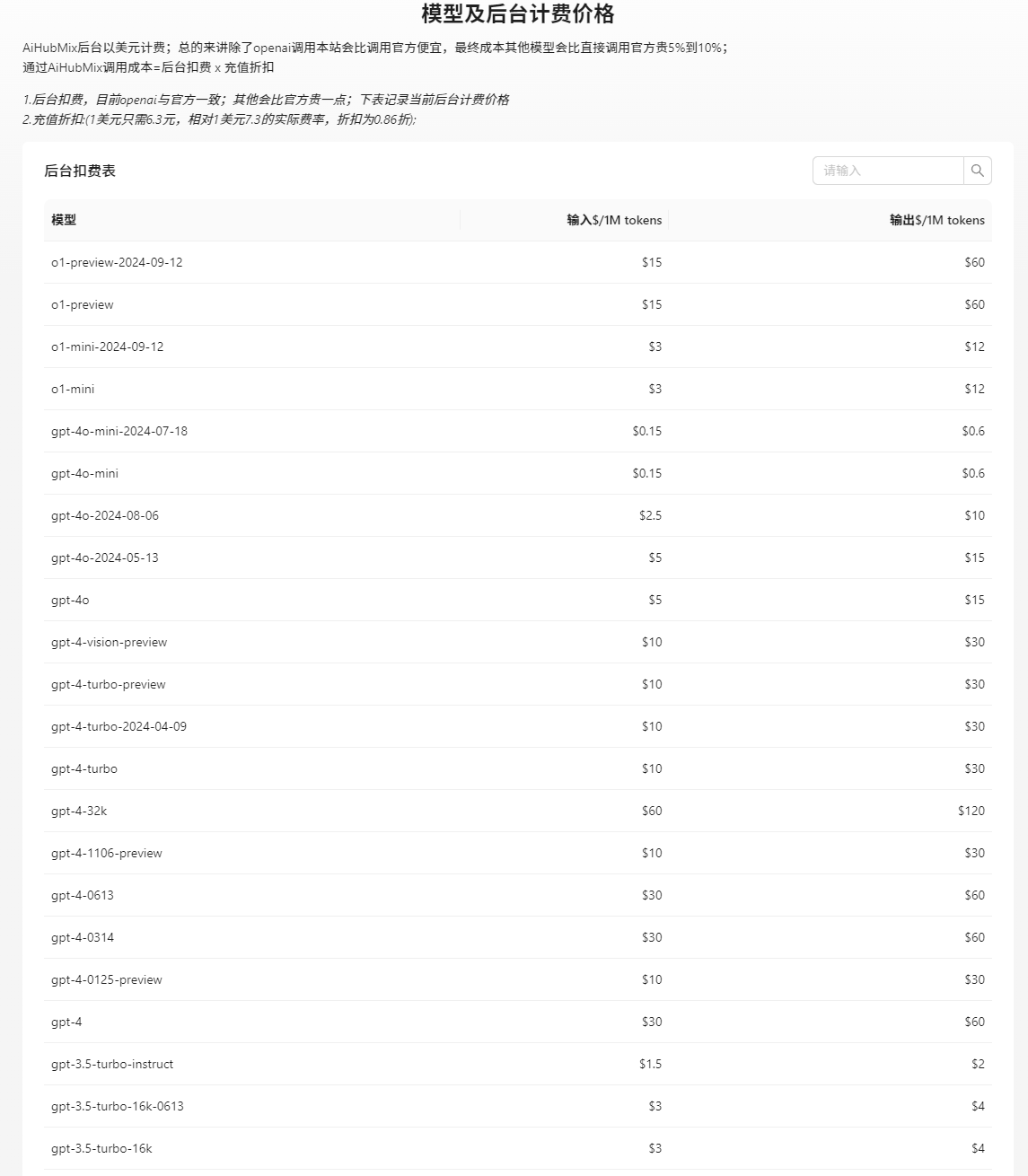

AiHubMix

推荐理由:

-

AiHubMix聚合了市面上主流的大语言模型,包括OpenAI,Claude,谷歌 和 阿里等厂商最新的大模型。OpenAI最新推出的o1-preview和o1-mini也已经支持了。

-

API费率也比官方价格要便宜。

-

充值方便,可以直接使用支付宝。

AiHubMix平台网址:https://aihubmix.com?aff=tKTt

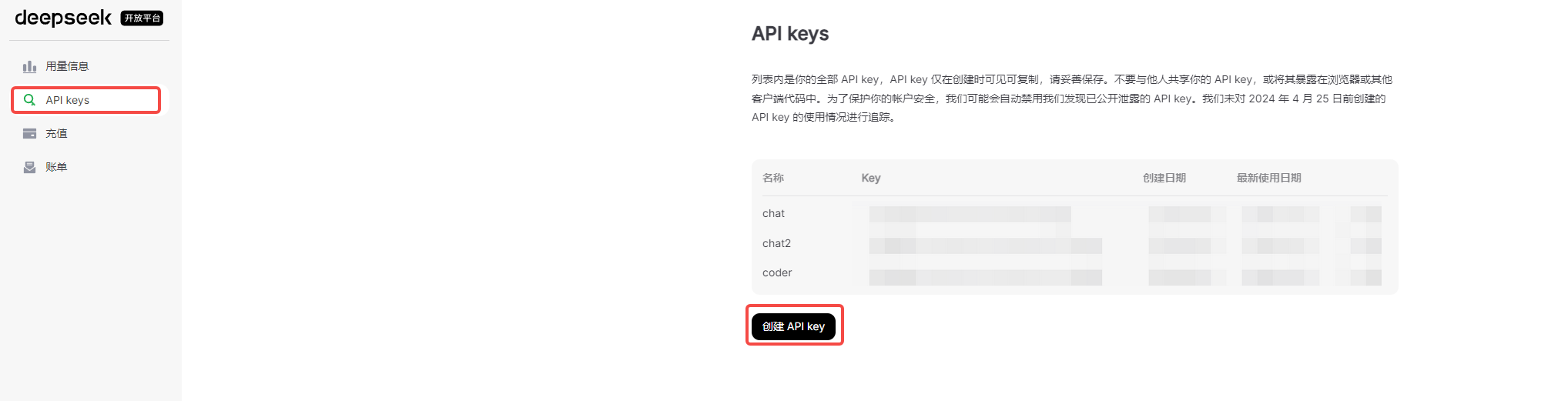

获取API key

这里以Deepseek为例,其他大模型API平台的获取方式都是类似的,不管是官方API平台还是API聚合平台。详细的信息可以分别查看对应平台的API使用文档。

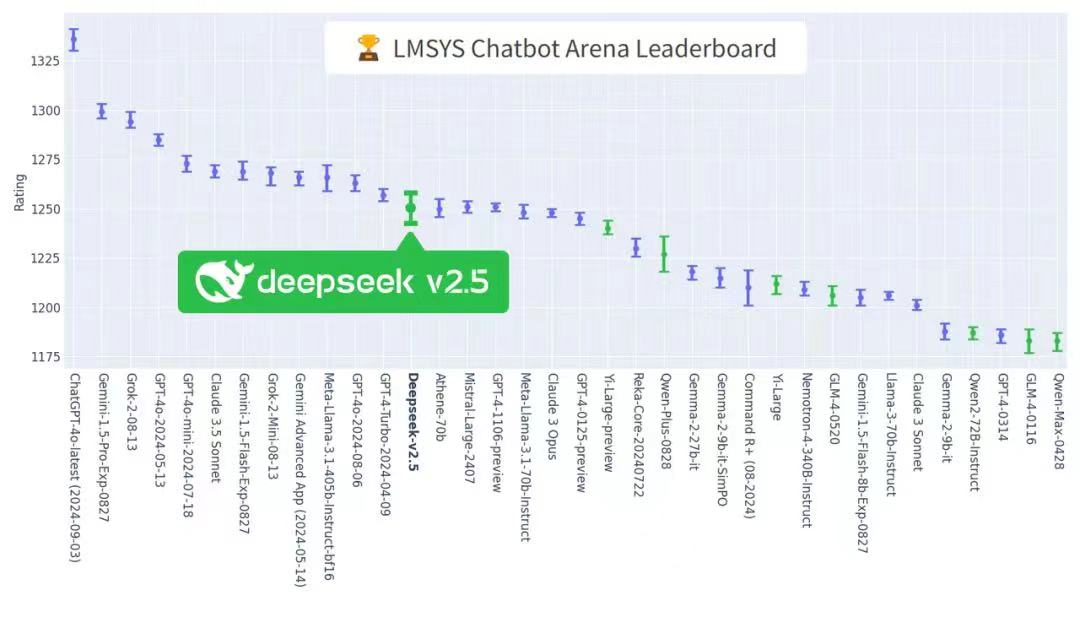

Deepseek新推出了DeepSeek-V2.5。这是deepseek融合DeepSeek-V2-Chat 和 DeepSeek-Coder-V2 两个模型后升级而来的模型。

最近,LMSYS 组织的全球大模型竞技场(ChatBotArena)更新结果发布,DeepSeek-V2.5 排名位列**国内大模型第一,**开源超越国内最强闭源模型(Yi-Large-Preview, Qwen-Plus-0828, GLM-4-0520),并在8个单项能力上均领跑国内模型。

使用API需要获取到的配置信息包含三个部分,模型名称,base url和key。

打开https://platform.deepseek.com/页面,如果你之前没有注册过,会显示一个注册登录页面。

要使用API还需要实名认证一下。按照提示进行即可。

然后在下面的页面里创建一个key。

这个key的信息要自己存放好,再创建后只会展现一次。

deepseek正在进行最大8K输出tokens的beta测试。使用下面的base url可以获得更大的输出长度。

base_url=“https://api.deepseek.com/beta”

模型名称上,通过deepseek-coder 或 deepseek-chat 均可以访问新的模型(DeepSeek-V2.5)。

| 信息项目 | 信息内容 |

|---|---|

| 模型名称 | deepseek-coder/deepseek-chat |

| base url | https://api.deepseek.com/beta |

| key | sk-xxxxxxxxx |

任何一个大模型API平台都会提供上述表格中的信息。只有正确获取了这些信息,后面配置AI产品时才能让其顺利工作。

deepseek的API调用规范和OpenAI的是兼容的。这意味着只要支持OpenAI API的AI产品均可使用deepseek的API来驱动。

下面以配置Chrome插件沉浸式翻译为例,示范如何将获取到的key信息配置进去。

这里有一个点需要注意,有些AI产品要求base url的配置里要加上v1/chat/completions这个后缀。

常见的写法有下面几种,根据AI产品的不同有所差异。

- https://api.deepseek.com/beta

- https://api.deepseek.com/beta/v1

- https://api.deepseek.com/beta/v1/chat/completions

个人智能助手

GitHub上开源的Chat UI有好几款都非常优秀。比如:LobeChat,OpenWebUI, LibreChat.

但当我使用了LobeChat后,我就决定用它来作为我的智能效能助手了。

为什么选LobeChat

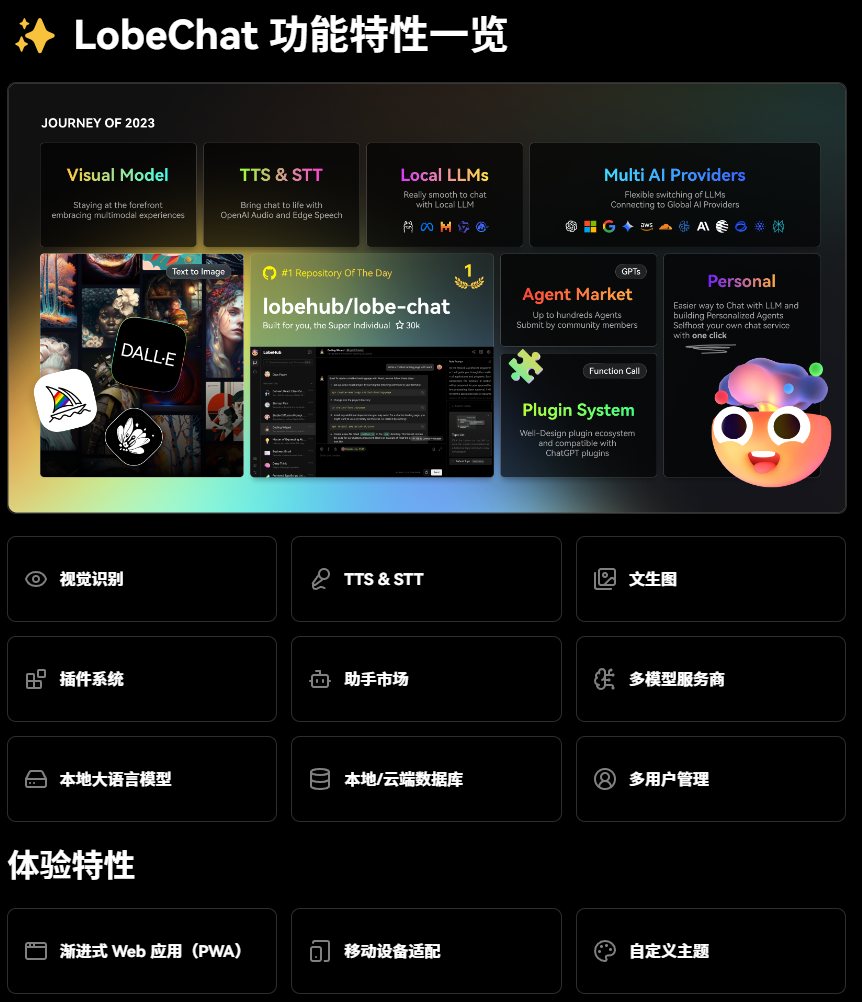

LobeChat是一个开源的、现代设计的 AI 聊天UI框架。支持多 个AI 大模型提供商(OpenAI / Claude 3 / Gemini / Ollama / Azure / DeepSeek)、知识库(文件上传 / 知识管理 / RAG)、多模态 (Vision/TTS) 和插件系统。一键免费部署的私人 ChatGPT/Claude 应用程序。有了LobeChat,你不再需要选择 ChatGPT Plus,而是可以使用免费或按量付费的 API。

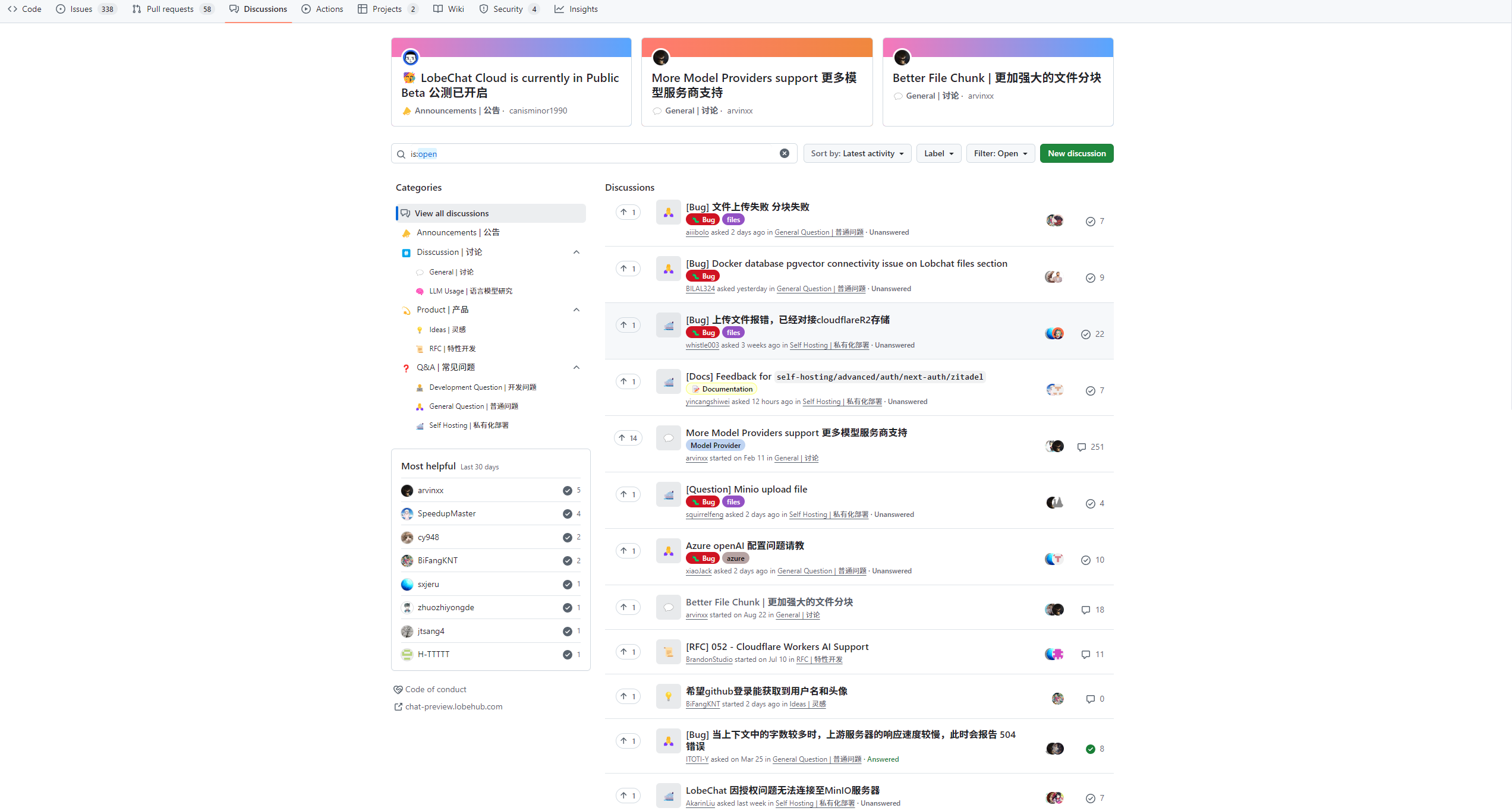

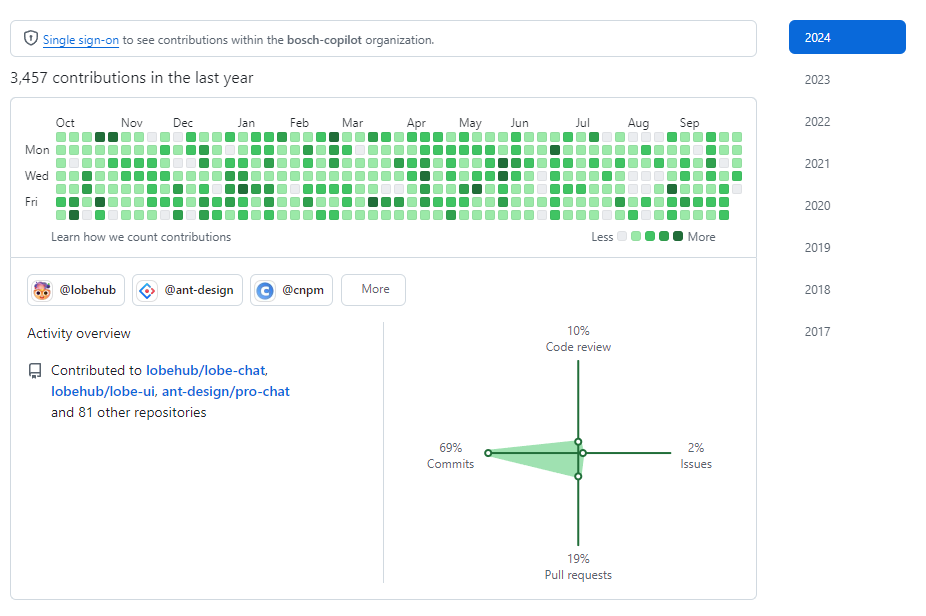

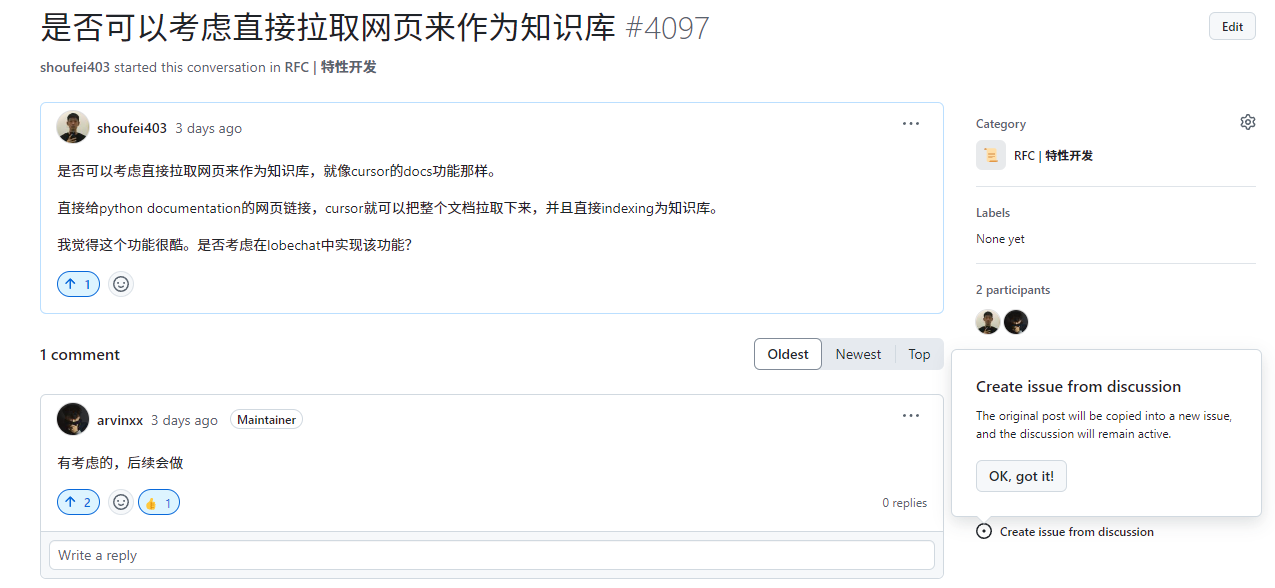

LobeChat社区非常活跃,大家都在积极讨论新功能新想法。访问其GitHub仓库的Discussions栏目就能看到。

开发者也在密集的开发,类似Claude Artifacts的功能框框就上线了。

对用户的诉求也是积极回应。感觉太了不起了。非常优秀的项目。

LobeChat开源网址:https://github.com/lobehub/lobe-chat

如何部署

这里以windows11环境为例,讲诉部署方法。如果你是用Ubuntu之类的linux系统,想必也不用我教了。直接看仓库里的readme文件就可以了。

我推荐使用Docker方式来部署,简单省事。如果你不太了解,也没关系。就几个步骤,你照着来就行。

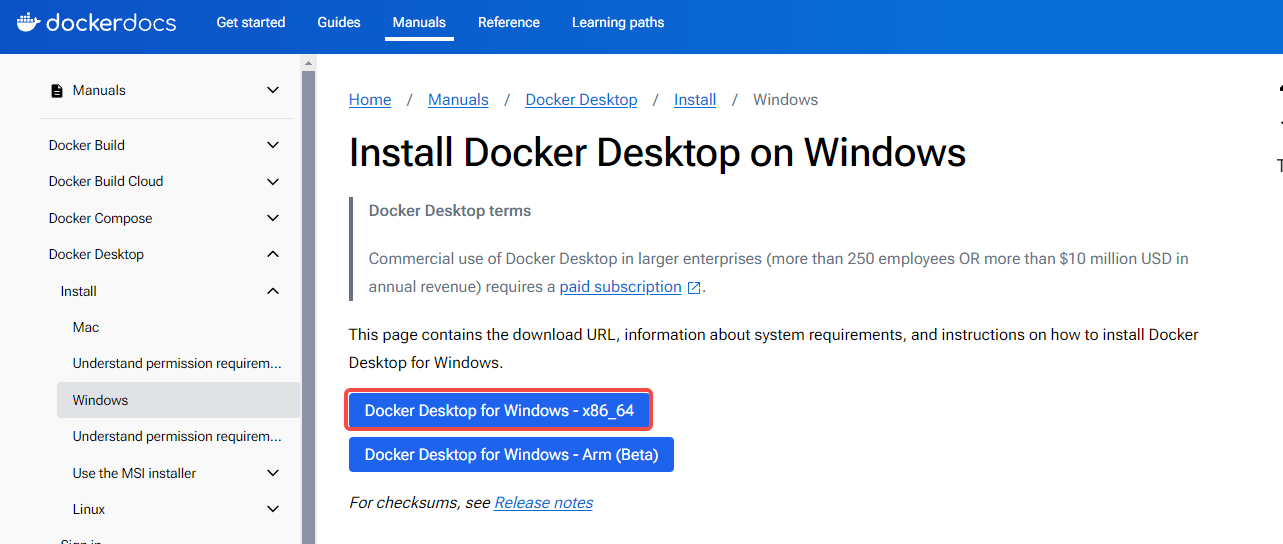

安装Docker Desktop

首先,访问下面的网址,下载Docker Desktop这个软件。

https://docs.docker.com/desktop/install/windows-install/

下载下来后是exe文件,直接双击安装即可,就像安装其他应用一样的。按照安装提示一步步走。

拉取LobeChat镜像

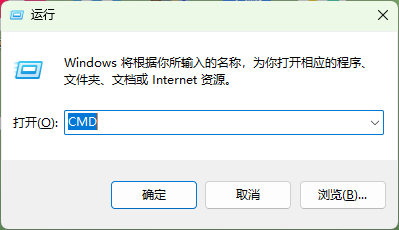

使用win+R快捷键打开运行窗口。输入cmd,点击确定,打开命令行窗口。

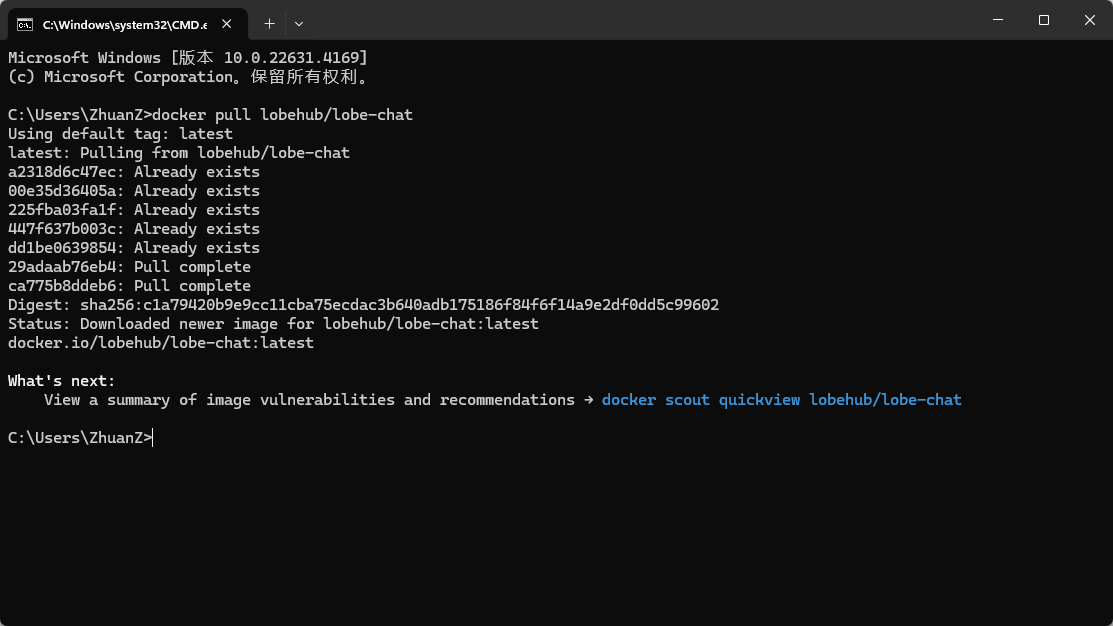

在命令行窗口里运行docker pull lobehub/lobe-chat,拉取最新的LobeChat镜像。

启动LobeChat

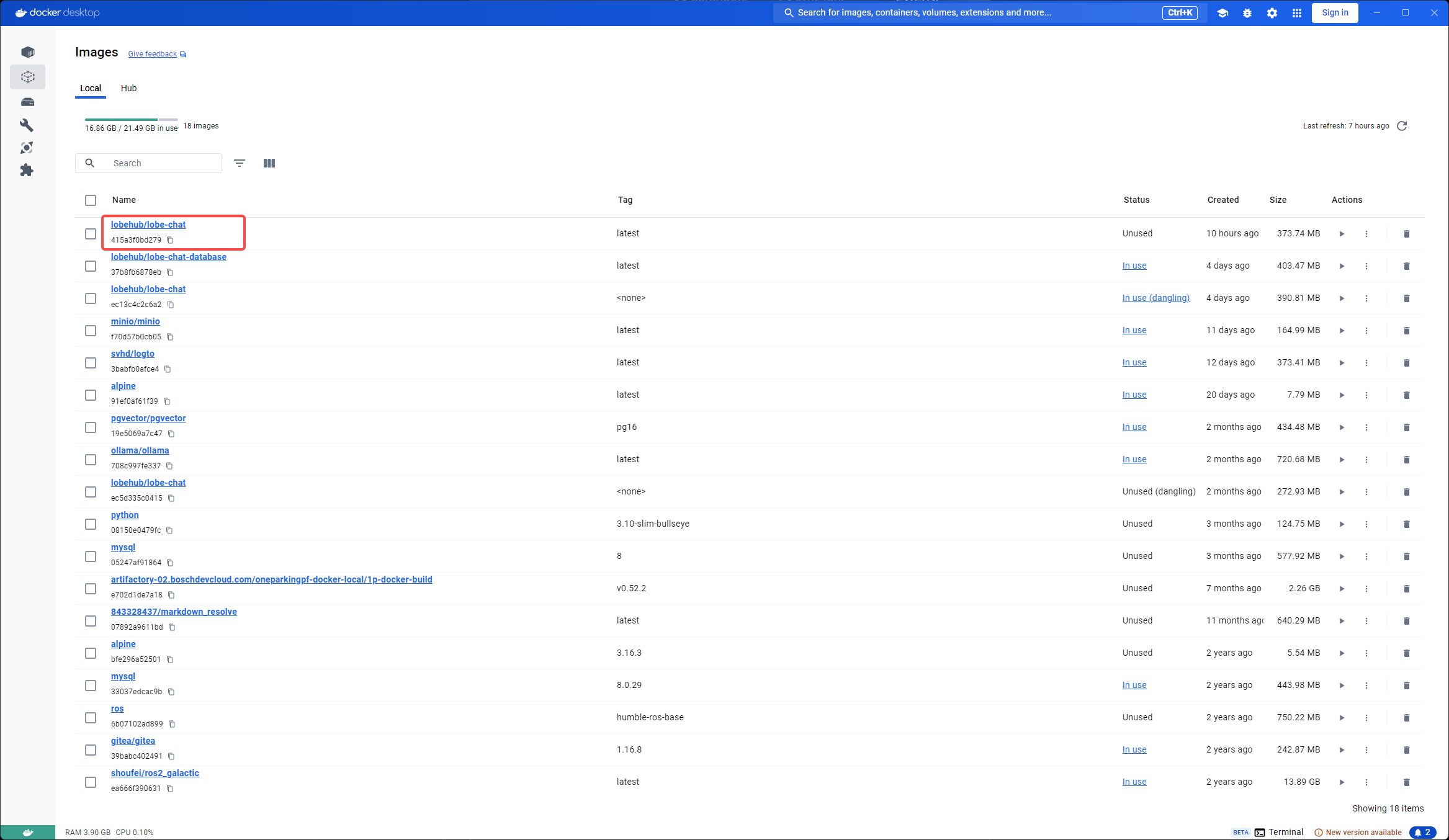

当你拉取LobeChat镜像成功后,打开Docker Desktop应用程序。点击左侧栏的镜像图标就能看到拉取成功的LobeChat镜像了。

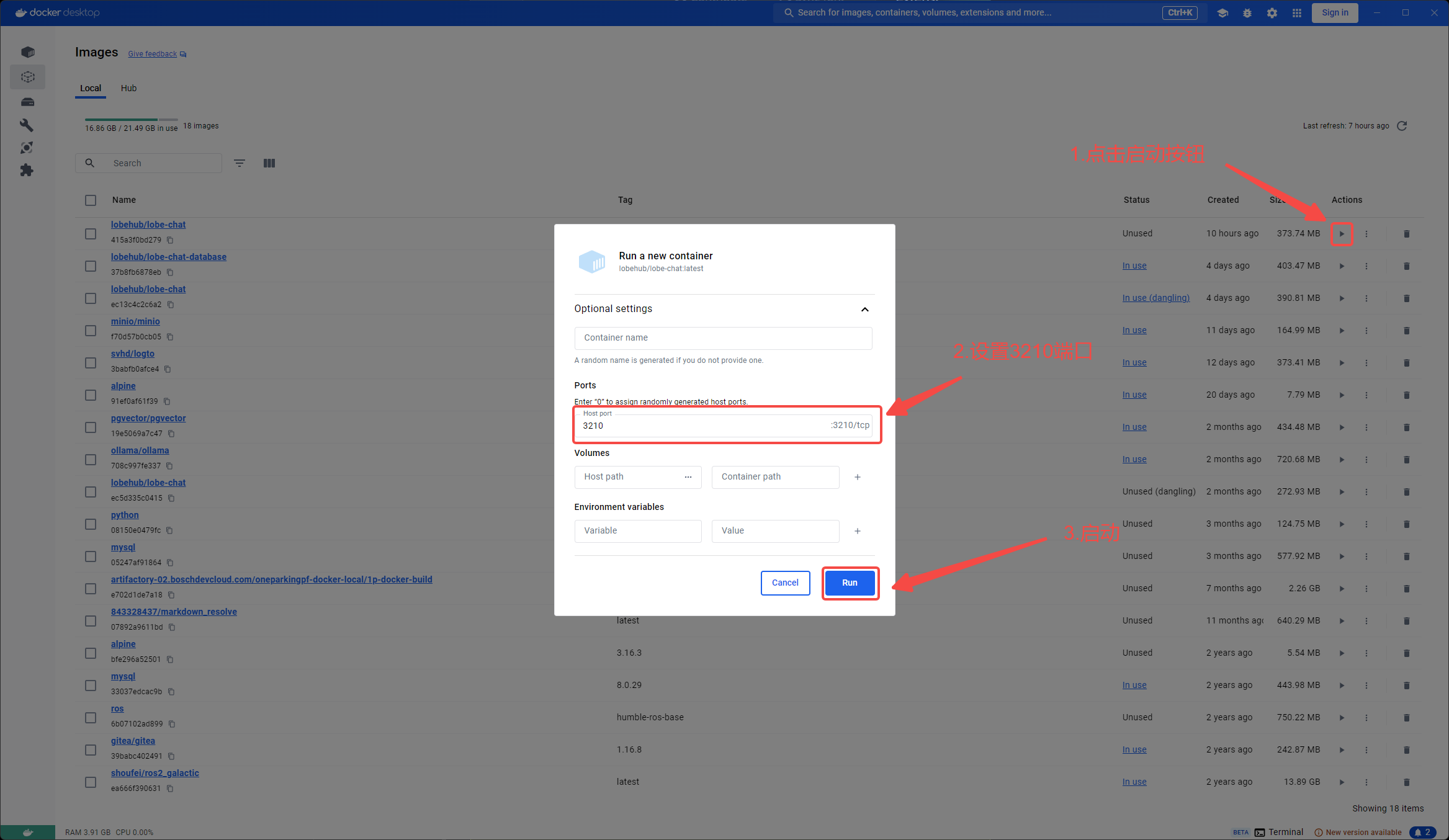

按下图配置好端口号后,即可启动LobeChat镜像。

打开LobeChat

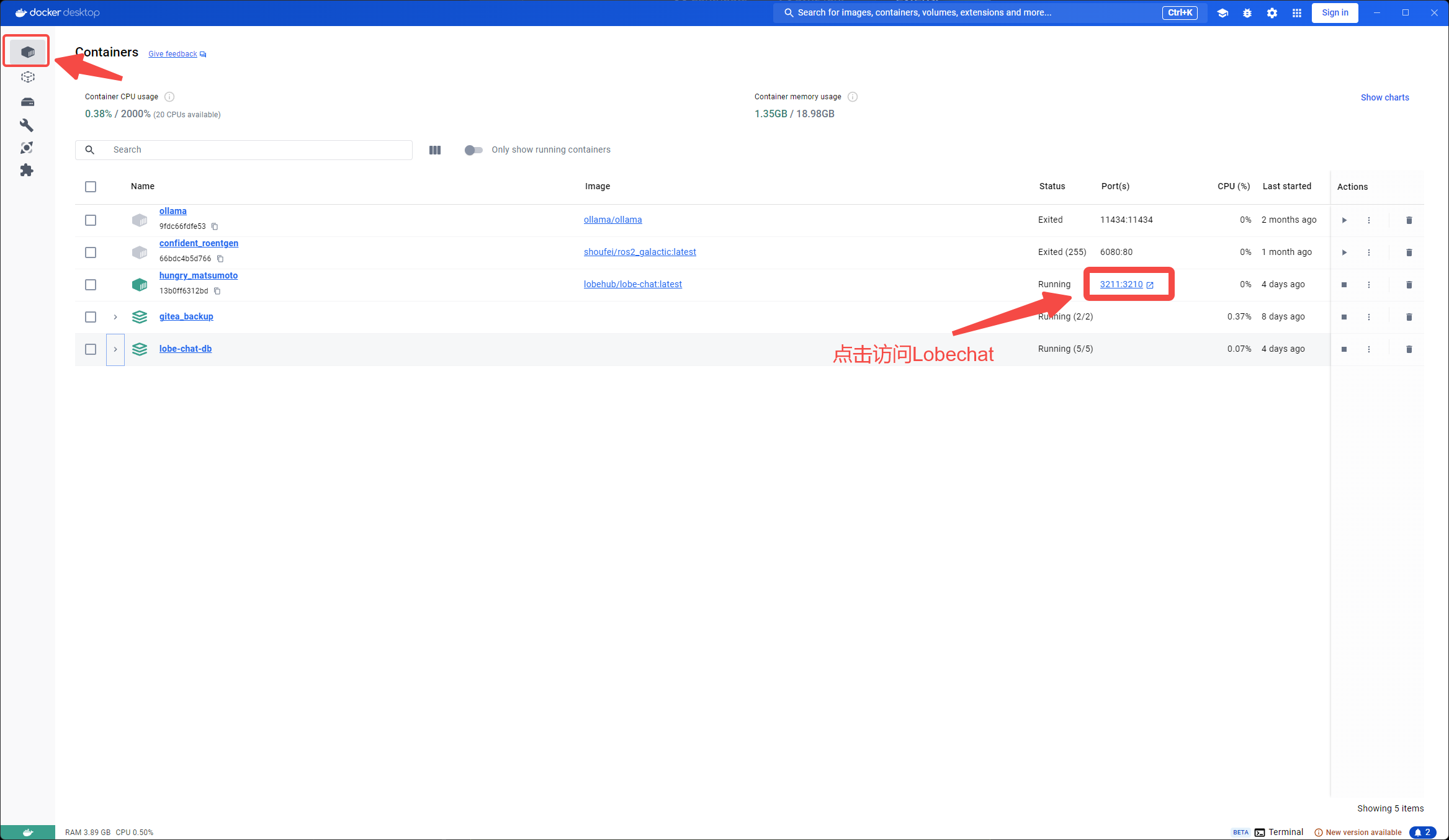

LobeChat镜像启动好后,点击上图中绿色的端口号,即可进入LobeChat页面。

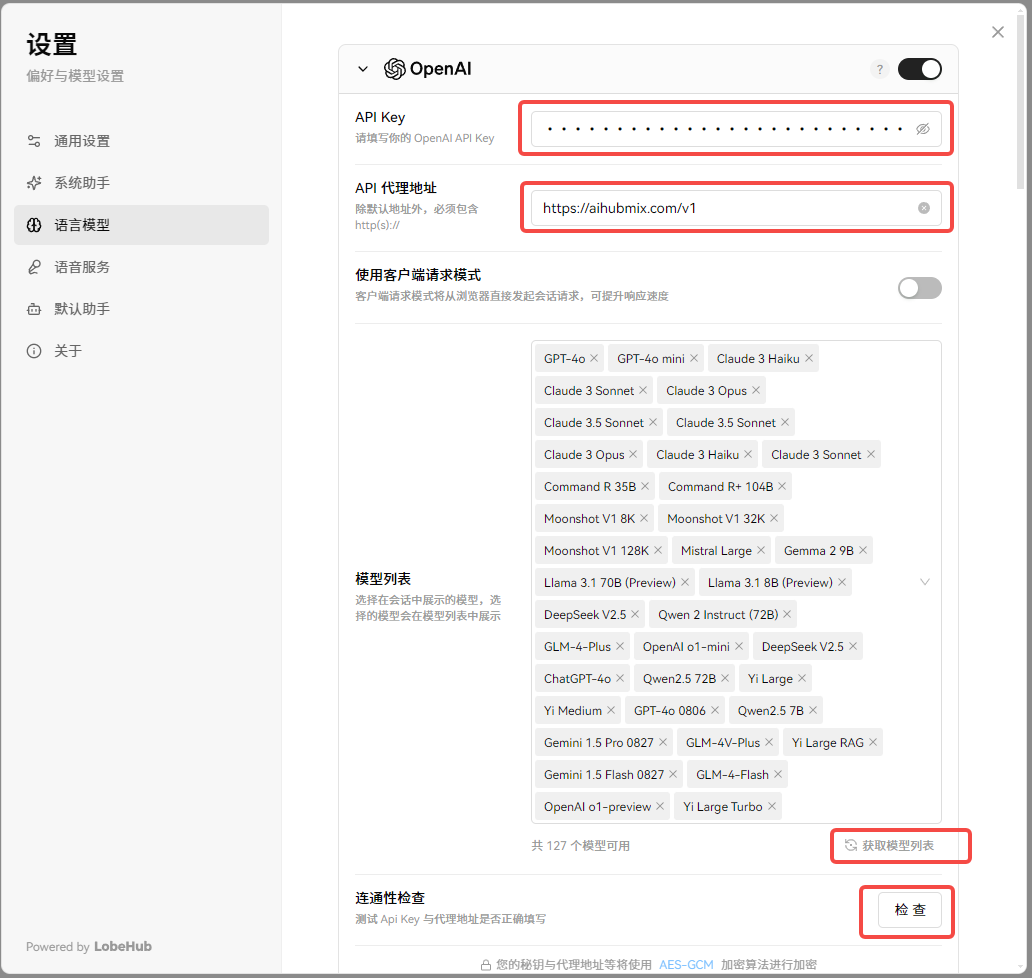

配置大模型API

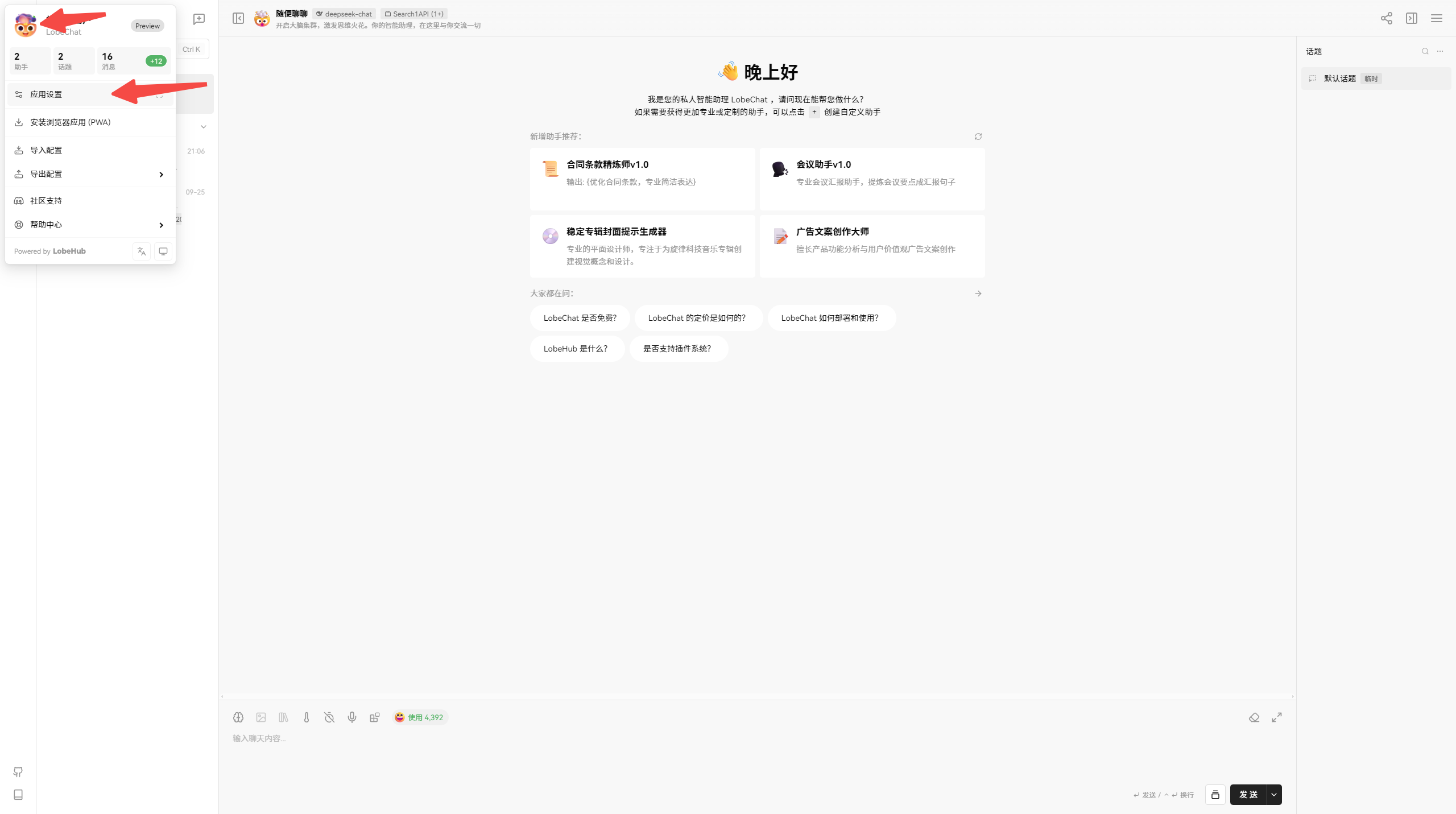

首先按下图所示,点击箭头所示位置(先点上面的再点下面的),进入配置页面。

将获取到的API信息配置进LobeChat。按照下面红框位置

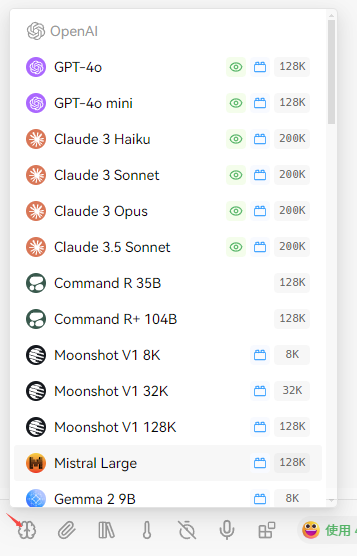

配置好后在聊天界面就可以看到可选的模型有很多。

接下来你就可以探索起来了。用好这个工具,工作效率提升十倍。