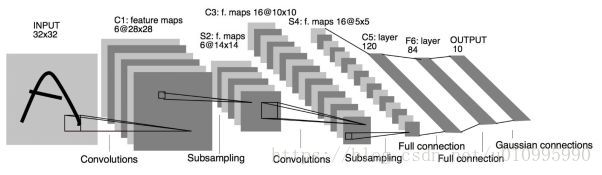

全连接层(fully connected layers,FC),在整个卷积神经网络中起到”分类器”作用。如果说卷积层、池化层和激活函数层等操作是将原始数据映射到隐层特征空间的话,全连接层则起到”将学到的分布式特征表示”映射到样本标记空间的作用。

同时由于全连接层参数冗余(仅全连接层的参数就可占整个网络参数80%左右),近期一些性能优异的网络模型如ResNet和GoogLeNet等均用全局平均池化(global average pooling GAP)取代FC来融合学到的深度特征,最后仍用softmax等损失函数作为网络目标函数来指导学习过程。需要指出的是,用GAP替代FC的网络通常有较好的预测性能。

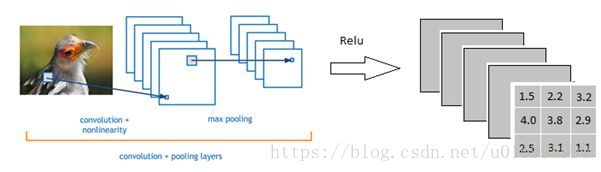

假设一个图片经过cnn、maxpool、relu层后结果如下:

那么接下来就到达全连接层。

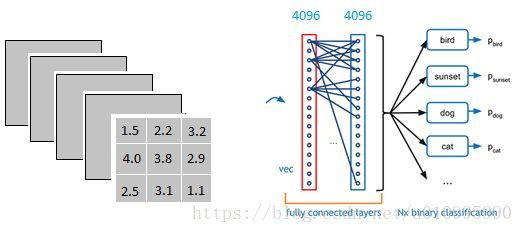

如下图:

以上图为例,我们仔细看上图全连接层的结构,全连接层中的每一层是由许多神经元组成的(1*4096)的平铺结构,上图不明显,我们再看下图:

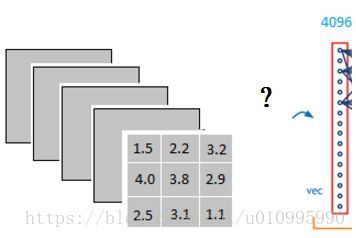

首先我们的第一个问题就是:他是怎么样把3*3*5的输出,转换成了1*4096的形式的。

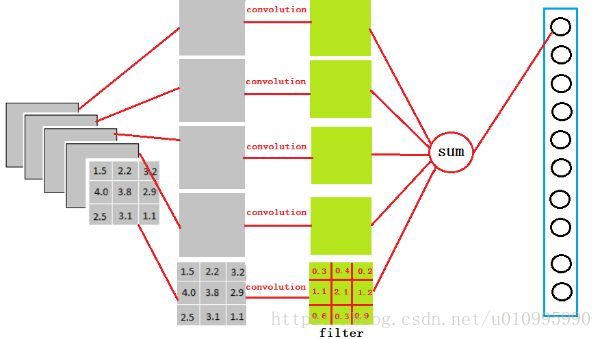

我们可以理解为是在中间做了一个卷积:

如上图,我们用一个3*3*5的filter(卷积核)去卷积激活函数的输出,得到的结果就是一个fully connected layer的一个神经元的输出,这个输出就是一个值。

因为我们有4096个神经元,我们实际就是用一个3*3*5*4096的卷积层去卷积来实现的

多层的全连接层可以如下实现:

参考地址:https://zhuanlan.zhihu.com/p/33841176

参考地址:https://www.zhihu.com/question/41037974