tar -zxvf hadoop-2.9.2.tar.gz

修改/opt/hadoop-2.9.2/etc/hadoop/hadoop-env.sh指定JAVA_HOME

修改/opt/hadoop-2.9.2/etc/hadoop/core-site.xml

<configuration>

<!-- 指定HDFS老大(namenode)的通信地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://0.0.0.0:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储路径 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop-2.9.2/temp</value>

</property>

</configuration>

修改/opt/hadoop-2.9.2/etc/hadoop/hdfs-site.xml

<configuration>

<!--hdfs副本数量-->

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>第一次启动得先格式化

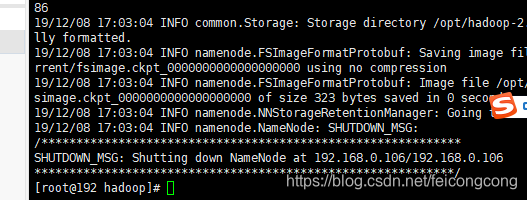

/opt/hadoop-2.9.2/bin/hdfs namenode -format

启动hdfs

/opt/hadoop-2.9.2/sbin/start-dfs.sh

jps命令测试

停止hdfs

/opt/hadoop-2.9.2/sbin/stop-dfs.sh

预览 http://xx.xx.xx.xx/50070

centos7.x

#关闭防火墙

systemctl stop firewalld.service

#关闭防火墙,并设置为开机不自启

systemctl disable firewalld.service

#查防火墙是否开机自启

systemctl list-unit-files |grep fire1、HDFS页面:50070

2、YARN的管理界面:8088

3、HistoryServer的管理界面:19888

4、Zookeeper的服务端口号:2181

5、Mysql的服务端口号:3306

6、Hive.server1=10000

7、Kafka的服务端口号:9092

8、azkaban界面:8443

9、Hbase界面:16010,60010

10、Spark的界面:8080

11、Spark的URL:7077