摘要

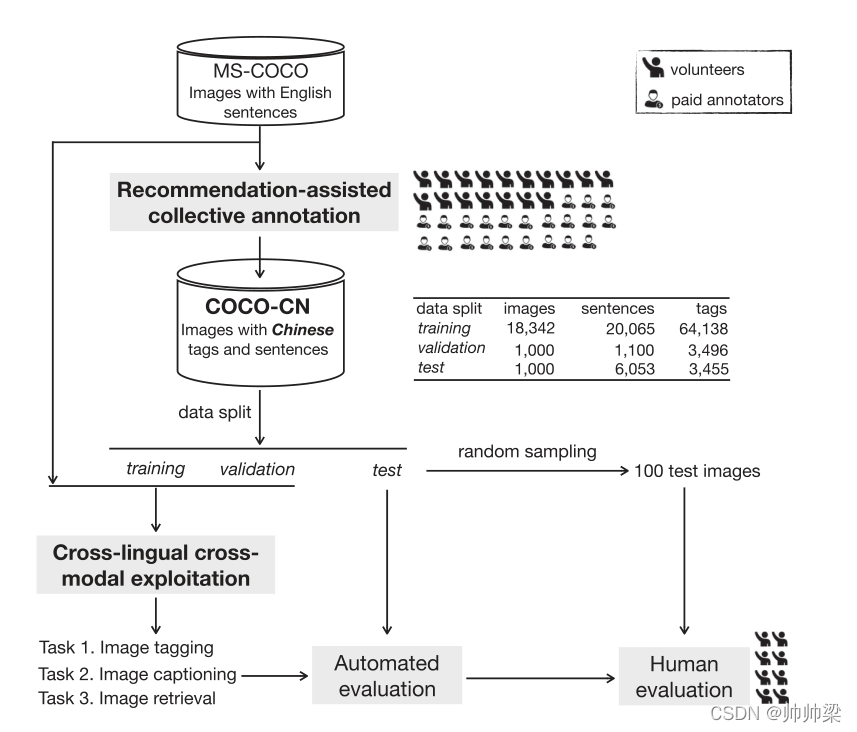

本文从数据和基线方法两方面对跨语言图像标注和检索做出了贡献。我们提出了一种新的中文句子和标记丰富MS-COCO的数据集coco - cn。为了有效的标注获取,我们开发了一个推荐辅助的集体标注系统,自动为标注者提供与图片内容相关的几个标签和句子。COCO-CN拥有20 342幅图像,27 218个中文句子,70 993个标签,是目前最大的汉英图像标注数据库,为跨语言图像标注、字幕标注和检索提供了统一的、具有挑战性的平台。我们从跨语言资源中开发概念简单而有效的学习方法。在这三个任务上的大量实验证明了所提出的数据集和方法的可行性。

介绍

多媒体内容的自动化描述,无论是图像还是视频,是多媒体分析和检索的核心主题之一。长期以来,人们对多媒体描述的努力将描述形式局限于单个单词[1],例如:例如,汽车、道路和人,这是因为低级特征和高级语义之间存在语义差异。直到最近,我们才看到在生成类似自然语言的描述方面取得了显著的进展。比如,汽车在公路上飞驰,周围有很多人,这不仅表明了特定概念的存在,也表明了它们之间的互动。虽然这些进步当然可以归功于技术突破,主要是深度学习,但标记良好的数据集的重要性不应被低估。例如用于视觉类识别的ImageNet[3],用于图像标签的NUS-WIDE[4],用于图像标题的MS-COCO[5],以及最近用于跨媒体检索的Twitter100k[6],等等。注意,这些数据集的注释都是用英语编写的。为了促进研究超越单语设置,本文提出了一个新的数据集coco - cn。它扩展了MS-COCO,使用手工书写的中文句子和标签,见表一。

新数据集扩展了DSMS-COCO[5],并附带了手动版权中文证书和标签。论文中的文字为英译,为非中文读者提供

尽管多媒体标注和检索在跨语言设置中的重要性在早期就已被认识到,但直到最近才引起越来越多的关注。跨语言图像标注对于研究如何利用源语言标注的数据来获得目标语言的图像标注模型具有重要意义。因此,即使在缺乏该语言的训练示例的情况下,也为普通用户提供了以一种母语自动标记其图像的可能性。例如,在《[10]》中,宫崎骏和清水开发了一种迁移学习策略,使用训练有素的英语字幕模型来初始化日语字幕模型的视觉嵌入矩阵。

Tsutsui和Crandall提出在一个网络中生成多语言句子,使用人工标记来控制语言[8]。Lanet .展示了利用英语资源训练图像字幕模型生成流利中文句子[14]的可能性。利用图像作为边信息可以提高多模态机器翻译的效率。跨语言应用程序对于世界上大多数不会说英语的人来说是至关重要的。

为了支持这一研究方向,已经开发了几个带有非英语注释的图像数据集。根据应用的不同,这些数据集的目标语言也不同,包括用于多模式机器翻译的德语[9]、[11],用于图像检索的德语和法语[12],用于跨语言文档检索的日语[16]和图像字幕[10]、[17],以及用于图像字幕[14]、[18]、[19]的汉语。除了IAPR TC-12[7]和AIC-ICC[19],这些数据集都是建立在现有英语数据集的基础上,其中MS-COCO是最受欢迎的选择。

尽管取得了令人鼓舞的进展,但在数据集和方法方面,我们发现目前的研究存在两个不足。虽然汉语是世界上使用最多的语言,但现有的汉语数据集要么规模较小(Flickr8kCN[18]),要么在描述人类活动和单语(ai - icc[19])方面存在很大偏差。在方法方面,关于跨语言图像标注的文献还很少。

ImageCLEF系列最初是为跨语言目的而设置的,实际上已经变成了单语言[20]。在过去的五年里,唯一发表的工作1是Weiet al.[13],作者假设在他们的目标语言中没有可用的训练图像。在线图像标签服务Clarifai[21]能够预测多种语言的标签。但非英语标签似乎只是对预测的英语标签进行简单的机器翻译。如何有效地进行跨语图像标注尚不清楚。

关于跨语言图像字幕的研究报告一致指出,在训练目标语言的图像字幕模型时,机器翻译的句子不如人工书写的句子[10],[14],[17],[18]有效。

没有人试图回答机器翻译的数据是否和以何种方式可以与目标语言的人工编写的句子一起有效地利用,以获得更好的性能。为了匹配两种不同语言的图像和句子,Gella等人提出了一种神经模型,以图像为枢轴[22]学习多语言多模态表示。该模型的一个缺点是,它需要许多三联体进行训练,其中每个图像都与双语描述相关。跨语言图像检索不仅需要查询与图像之间的跨模态匹配,还需要同一查询与图像关联的描述之间的跨语言匹配,而且需要使用另一种语言进行匹配。

针对以上两个不足,本文在以下三个方面做出了贡献:

- 我们提出了一个扩展MSCOCO的新数据集coco - cn,该数据集包含了人工书写的中文句子和标记。因此,它不同于之前的MS-COCO的跨语言努力,目标是日语[10],[17],德语[11]或法语[12]。COCO-CN是中国最大的跨语言图像标注和检索数据集。COCO-CN的发展及其在各种任务中的应用如图1所示。数据和代码可在https://github.com/li-xirong/coco-cn获得。

- 针对COCO-CN的构建,开发了一种新型的推荐辅助标注系统。虽然在图像自动标记[23]-[25]和标题检索[26]-[28]方面已经取得了很大的进展,但这些技术能否用于辅助数据集的构建还有待探索。新系统允许我们评估探索减少注释工作量的最新技术的可能性。此外,随着源代码的发布,该系统为那些对构建类似数据集感兴趣的同行提供了一个很好的起点。

- 我们展示了COCO-CN在三项任务中的适用性,即跨语言图像标记、字幕和检索,以及它相对于其他数据集的优势。 此外,我们开发了专门用于跨语言环境的模型,即用于标记的级联MLP、用于字幕的顺序学习以及用于检索的增强Word2VisualV ECP。虽然概念上很简单,但这些模型有效地从双语资源中学习,从而提高了跨语言环境中的最新水平。

COCO-CN的发展及其在三项任务中的应用。

COCO-CN结构

图像内容的复杂性使得写一个流畅的句子来完整描述一个图像并非易事。例如,在表I的第一行中考虑图像。场景的要点是一名男子在户外放风筝。如果一个人试图覆盖整个上下文,例如天空、云、河、树和草地,这将是一个冗长的句子,读起来并不流畅。所以我们收集标签来补充自然语言描述。

- A. Recommendation-Assisted集体注释

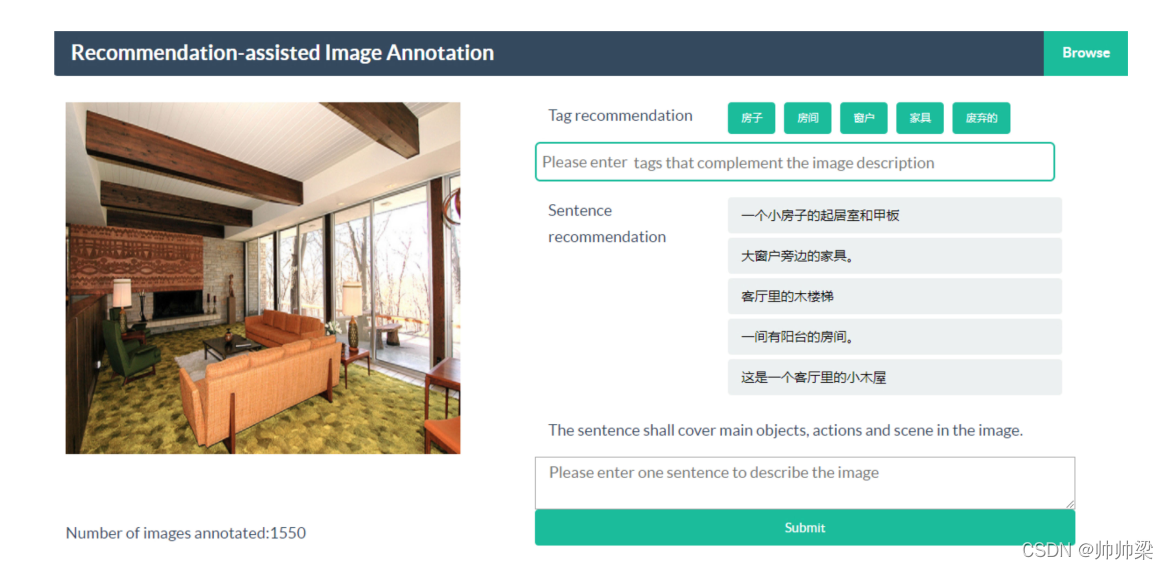

- 1)用户界面 : 为了方便用户参与,我们开发了一个基于网络的图像注释系统,允许用户远程独立地对图像进行注释。图2提供了系统的快照,

- 2)中文句子推荐:给定一幅要标注的图像,我们的句子推荐模块从一个庞大的中文句子库中检索最可能相关的句子。通过对MS-COCO英语句子进行机器翻译,得到包含120k个句子的pool。Liet .对两种公共机器翻译服务进行了实证比较。,谷歌和百度,报告了百度在将英文图像描述翻译成中文[18]时的更好的性能。所以我们使用百度翻译。

假设每幅图像都与5个机器翻译的句子相关联,一个简单的策略就是让注释者选择最合适的句子,并根据他们的需要进行编辑。我们不选择这一策略是出于以下考虑。首先,我们鼓励注释者在得到帮助时,从他们(个人)的角度描述图像,而不是仅仅做出一个好的翻译。从带有未对齐双语描述的图像学习更具挑战性,但也更实用。其次,我们希望保持系统的灵活性,以处理没有任何描述的新图像。最后但并非最不重要的是,证明人工标注的句子检索的可用性。

对于句子检索,我们采用Word2VisualVec(W2VV),它在多个数据集上展示了最先进的性能。W2VV设计用于仅从(英语)文本输入预测深层视觉特征。 具体地说,从给定文本到视觉特征向量的映射是通过首先将文本编码为固定长度向量来实现的。然后,向量通过多层感知器(MLP)生成视觉特征向量。

因此,给定图像和给定句子之间的交叉模态相关性被计算为视觉特征空间中的余弦相似度。虽然W2VV最初是为检索英文字幕而开发的,但通过将其基于英文的编码层替换为基于中文的编码层,可以很容易地扩展到中文场景。训练W2VV的中文版本需要使用成对的图像和中文句子。为此,我们将120k个句子随机分成两个不相关的子集,其中90%用于训练,10%用于验证。

我们训练了一个W2VV模型,该模型使用基于字包的编码,并预测2048 dim ResNet152特征。 如图2所示,对于给定的图像,我们动态计算其与池中每个句子的相关性,并将检索到的前5个句子推荐给注释者。

- 3) 中文标签推荐: 我们的标签推荐模块是基于视觉内容预测多个中文标签。由于MS-COCO图像非常多样化,因此需要大量的词汇。我们需要一个大规模的训练集,其中每个图像都有多个中文标签。因为这样的数据集不是公开可用的,所以我们考虑与不同语言的用户标记相关联的Flickr图像。然而,我们观察到使用中文标签的Flickr图片的数量远远少于使用英文标签的Flickr图片。这与[32]是一致的,Koochaliet .在[32]中报告说大部分的Flickr标记都是英文的。我们也注意到中文标签的质量要低得多。因此,我们使用Flickr图片,但手动将标签词汇从英语翻译成汉语。特别是我们采用了[23]提供的100万张Flickr图片。

为了构建中文标签词汇表,我们首先对1M集合中的所有英文标签按使用它们进行图像标签的不同用户数量降序排序。我们手动浏览排序的标签列表,逐个进行手动翻译。不包括与特定对象、场景或事件对应的标签。注意,同义词是分组的。例如,’ car ', ’ auto ‘和’ automobile ‘都被翻译成中文”汽车。因此,带有‘car’、‘auto’或‘automobile’的图像被认为是汽车的积极训练例子。一个有多重含义的单词被翻译成一系列的中文单词。例如,’ glass '被映射到{ 玻璃,玻璃杯,眼镜}。我们让注释器决定哪一种翻译是最合适的。最终我们获得了1951个班级的汉语词汇,涵盖了2085个英语单词和2367个汉语单词。

因为Flickr数据是有噪声的[1],[23],[33],我们用以下的经验法则去噪。我们从构造的词汇表中删除过度标记的图像(与超过20个标记相关)和包含少于两个标记的图像。这将产生一组800k的训练图像。对于图像表示,我们采用了一个预先训练的GoogLeNet模型[34],将其pool5层的输出作为1,024微光的视觉特征。在800k图像上训练一个网络结构为1024-1024-2048-1951的MLP。将MLP模型预测的前5个中文标签呈现给每个标注器。

-

B. COCO-CN注释过程

通过将标注任务分发到特定的众包平台,收集MS-COCO、STAIR字幕、Flickr8k-CN、AIC-ICC等现有数据集的句子。然而,如何衡量并控制众包句子的质量仍是一个未解决的问题。以MS-COCO为例。在手工翻译过程中,我们发现很多句子的错别字和拼写错误。、“准备击球”、“脸上挂着微笑的儿子”、“带条纹[尾巴]的飞机”、“站在棕榈树旁的长颈鹿”。为了收集高质量的注解,我们并没有完全依靠众包。我们的标注团队由17名志愿者(实验室工作人员和研究生)和22名本系付费本科生组成。

在他们开始之前,团队接受了以下指导方针的指导。句子应涵盖给定图像中的主要对象、动作和场景。注释器被要求提供至少一个标签来补充图像描述。为了更好地理解这些指南,我们提供了一些标签好的/不好的示例。在质量控制方面,由论文作者组成的检查委员会定期对由不同的注释者进行的一小部分注释结果进行人工检查。对不合格结果负责的注释者将被放入一个观察列表,并被告知审查和重新编辑他们的注释。进入观察列表三次的注释者将被排除在团队之外,他/她的注释也将被删除。

为了有效地获取标注数据,我们的目标是有更多的标注图像,而不是每幅图像收集更多的句子。该策略受到了[28]的启发,作者的经验表明,给定相同数量的图像-句子对进行训练,图像越多,交叉模态匹配模型就越好。为此,我们通过随机打乱MS-COCO图像,为每个注释器生成一个唯一的图像列表。因此,两个标注器标注同一图像的概率很低。

- C.数据分析

1)进展概述:我们共有20342张图片,共标注了22218句句子和70,993个标签。注意,我们没有提前选择这2万张图片。它们是通过手工注释获得的。由于图像是随机分配给每个注释器的,所以COCO-CN中的20k张图像实际上是MS-COCO的一个具有代表性的子集。此外,我们有5000个MS-COCO英文句子手工翻译成中文,用于评估图像字幕(c.f. IV -C节)。这使得手工书写的中文句子数量增加到了27218句。不同于英文句子中由空格分隔的单词,中文句子没有标记作为单词边界。在进一步分析之前,它必须被分割成一系列有意义的单词。我们使用BosonNLP工具箱[35]进行句子切分和词性标注。句子和标签的基本统计情况见表三。每张图像平均标注者数为1.1,而每个人平均标注的图像数为521.6

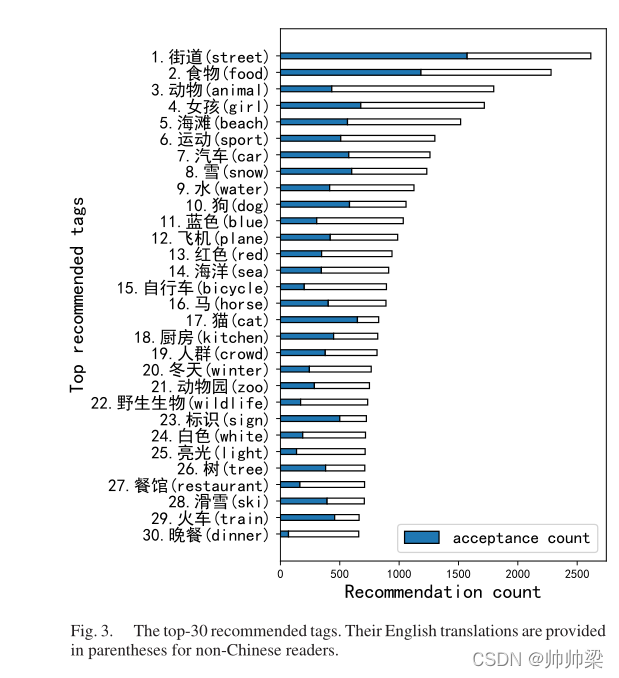

前30名推荐标签。其英文译本以括号形式提供给非中文读者。

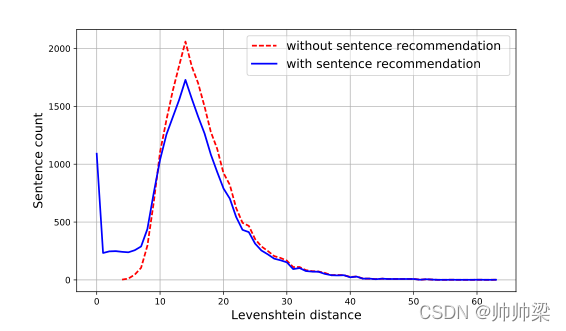

图4显示了有推荐和没有推荐的距离分布曲线。这些结果表明句子推荐在一定程度上减少了标注工作量。然而,句子推荐不如标签推荐有效。

应用

- A . Common Setup

数据分区: 1000/1000/18342

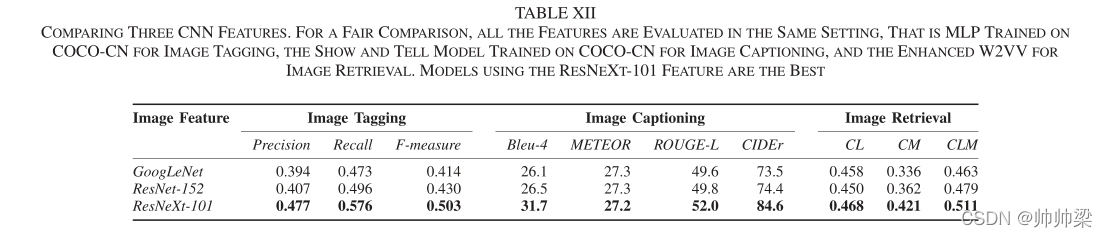

图像特征: 使用最先进的ResNeXt-101模型

- B. 任务一:跨语言图像标记

利用COCO-CN的中文标注和MS-COCO的英文标注构建了一种基于中文标注的图像标注模型。

- 1) Setup:Tagging model

为了从跨语言资源中学习,我们提出级联MLP。如图5所示,模型由两个mlp组成。第一个MLP是在MS-COCO上训练的英语标签预测。根据名词、动词和形容词的出现频率按降序排列,从原始MS-COCO标题构建了包含512个英语标签的词汇表。因此,这个MLP本质上是将给定图像的视觉特征转换为512个模糊语义特征,每个维度对应一个特定的英语标签。视觉和语义特征被连接起来,形成第二个MLP的语义增强输入。该MLP使用COCO-CN进行训练,以预测每个中文标签与给定图像相关的概率。如图5所示,每个MLP有一个由1024个神经元组成的隐藏层。为了增加模型的非线性,在模型后加上整流线性单元(ReLU)。由于一个图像可以被多个标签描述,我们使用sigmoid(而不是常用的用于视觉识别的softmax)作为两个输出层的激活函数。损失函数是二元交叉熵。在训练过程中,我们使用一种常见的退出技巧(速率为0.5)来降低过拟合的风险。

跨语言图像标记的级联MLP。我们训练第一个预测英语标签的MLP。该MLP的输出与图像CNN特征连接,形成第二个MLP的输入,该MLP预测中文标签。

Baselines。为了证明所提出模型的有效性,我们考虑以下四种备选方案。

- COCO-MT。利用从MS-COCO的机器翻译中文句子中提取的标签训练一个MLP。除去COCO-CN验证和测试集覆盖的2k张图像,COCO-MT有121287张训练图像。

- COCO-CN。MLP只在COCO-CN上接受训练。

- Clarifai。一个在线图像标签服务[21],预测给定的图像多达200个标签,包括中文。自从在ImageNet 2013年的图像分类大赛中赢得前五名以来,该服务一直是市场的领先者,并可通过其API访问。

4)Multi-task MLP。在COCOCN上训练一个多任务的MLP,并配以双语注释,实现中英文标签的同时预测。该模型为图5的非级联版本,其中,在训练过程中,中英文二元交叉熵损失之和被最小化。

Multi-task MLP : We report the popular Precision, Recall and F-measure at top 5.

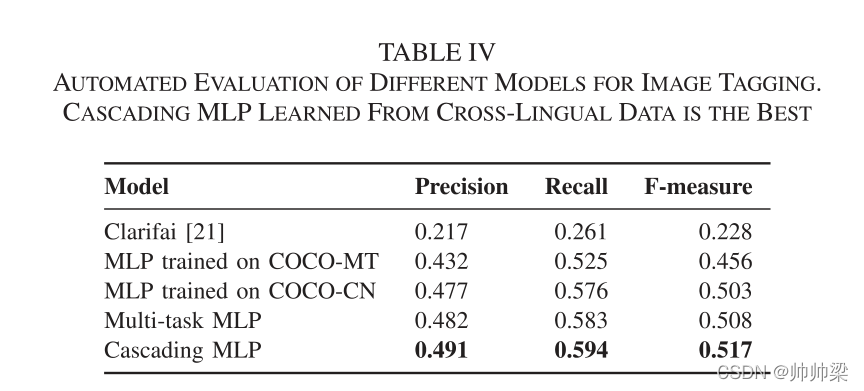

- 2)结果:自动评估:表四为五种标签模型的自动评价结果。级联MLP的性能是最高的。虽然COCO-MT的训练图像数是COCO-CN的6.6倍,但在COCO-CN上训练的MLP表现明显优于COCO-MT。这一结果说明了高质量标注对训练的重要性。一些图像标记结果如表7所示。在第一行中,在COCO-CN上训练的MLP没有预测到标签伞,而在第二行中,在COCO-MT上训练的MLP没有预测到标签键盘。从两个互补的数据集学习,级联MLP在一般情况下可以更好地预测。

自动测试图像标签的不同模型。从跨语言数据中学习的级联MLP

多任务MLP优于COCOCN训练的MLP,表明多任务正则化具有积极的作用。尽管如此,它还是不如级联MLP有效。此外,与多任务MLP相比,级联MLP通过顺序学习两个单语言MLP,不需要对每个训练图像对齐双语标注,因此更灵活地利用部分标注但更大的训练数据。因此,级联架构更适合从非对齐的跨语言资源中学习。

我们还在Flickr8k-CN上比较了多任务MLP和级联MLP,结果表明后者更好。

Human evaluation.

一些标签和标题的结果不同的模型。括号内的文本为英文翻译,供非中文读者阅读

- C. Task II: Cross-Lingual Image Captioning

我们进行了以下实验,比较在不同数据集上训练的模型。

测试集设置:5+1个

字幕模式: 我们采用了Show and Tell网络[38],最初是为英文字幕生成而开发的,后来发现对中文字幕生成非常有效[14],[18],[19]。该网络通过结合基于CNN的图像编码器和基于LSTM的句子解码器来计算给定输入图像的句子的后验概率。因此,用产生最大概率的句子对图像进行标注。LSTM的大小,即。,其隐向量维数经验设为512。

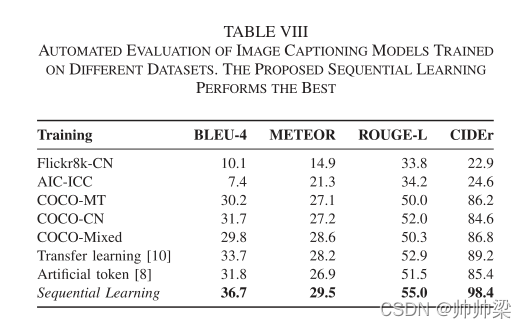

训练策略:如上所述,已经存在用于中文图像字幕的Flickr8K-CN[18]和AIC-ICC[19]。另一种替代方法是COCO-MT,它是MS-COCO的机器翻译版本。我们将COCO-CN与这三个数据集进行比较。为了进行公平的比较,Show和Tell模型是使用每个数据集单独训练的。该模型使用标准监督学习训练,以最小化交叉熵损失。初始学习速率设定为0.0005,每三个epoch衰减一次,衰减系数为0.8。

虽然COCO-MT中的机器翻译句子往往包含语法错误,不能很自然地阅读,但这个数据集有更大的词汇量(有10144个单词至少出现5次)用于训练。为了有效地利用COCO-MT的大规模特性和COCO-CN的高质量特性,我们引入了等量学习策略,利用两个数据集的联合词汇表,我们首先使用COCO-MT训练字幕模型。经过30个epoch之后,我们选择在COCO-CN验证集中拥有最高CIDEr分数的模型。我们继续使用COCO-CN对该模型进行训练,学习率为0.00005。顺序学习在某种程度上类似于微调,其重点是适当使用机器翻译和手工编写的训练句子。从这个观点来看,顺序学习本身并不新鲜。相反,与现有的作品[8],[10]相比,它提供了一种新的、更有效的方式来开发跨语言资源。

Baselines:据我们所知,迁移学习模型[10]和人工标记模型[8]是目前仅有的两种针对跨语言资源学习的替代方法,它们最初都是为了生成日语字幕而提出的。在我们的实现中,前者使用经过训练的英文字幕模型中的对应文本初始化中文字幕模型的视觉嵌入矩阵,而后者则从手动书写的中文字幕和原始的MS-COCO英文字幕中学习双语模型。此外,可以考虑将COCO-MT和COCO-CN简单地混合使用,并在一个阶段中用于训练图像字幕模型。我们将这种策略称为COCO-Mixed,这是研究顺序学习策略是否真的重要的必要基线。

评估标准: 我们使用标准的自动评价指标来评价字幕质量,即BLEU, METEOR, ROUGE-L和CIDEr。

-

- Results: Automated evaluation

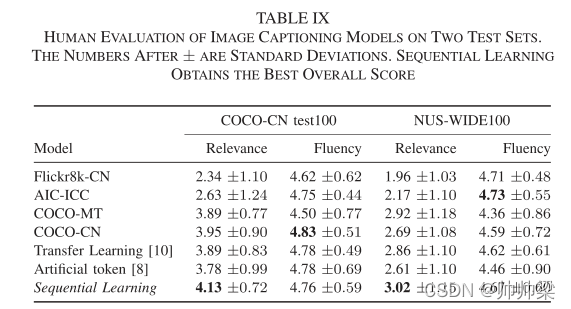

Human evaluation.:

COCO-CN由以汉语为母语的人精心编写的句子,涵盖了各种各样的视觉内容,适合于通用的中文图像字幕。顺序学习允许我们有效地利用手工注释。虽然顺序学习在COCO-CN测试100上的流畅性得分为4.76,低于COCO-CN测试100的流畅性得分,也低于AICICC在NUS-WIDE100上的流畅性得分,但在自动评价和人工评价方面,顺序学习的相关度得分都是最高的,说明生成的标题是最具描述性的。

表七显示了不同模型生成的标题示例。以第二行为例。手写的句子是(一只黑猫躺在笔记本电脑上)。ai - icc模型预测(有一个女人坐在房间里的椅子上看着电脑),显示出该模型在描述人类行为方面有很强的偏见。与将图像描述为(一只猫躺在笔记本电脑上)的COCO-CN模型相比,COCO-Mixed和顺序学习通过预测(黑猫)更具有描述性。结果表明了跨语言资源学习的好处。此外,与COCO-Mixed使用的动词(sit)相比,顺序学习使用的动词(lying)在汉语中更加精确和生动。

- D. Task III: Cross-Lingual Image Retrieval

1)设置 : COCO-CN的双语属性支持跨语言图像检索。在本文中,我们考虑以下设置。给定一个中文句子作为查询,目标是在一组图像中找到与查询最匹配的图像。每幅图都用一个英语句子来描述。 跨语言图像检索与单语图像检索不同,前者不仅要考察视觉和文本模式之间的相似性,而且还要考察两种不同语言呈现的文本之间的相似性。为了实现该任务,需要通过跨模态、跨语言表征学习,在一个公共空间内有效地表示汉语查询、图像及其英语描述。因此,这项任务比它的单语对手更有研究兴趣。虽然跨模态匹配是众所周知的困难,但通过跨语言匹配进行图像检索也具有挑战性。即使汉语和英语的句子是用来描述同一种形象的,它们也是由不同的主体独立书写的,想必他们有着不同的教育和文化背景。所以它们在语义上不一定是一致的。一种理想的方法应该是利用查询和给定图像之间的交叉模态匹配,以及查询和给定图像的英文描述之间的交叉语言匹配。

Test set: 1000

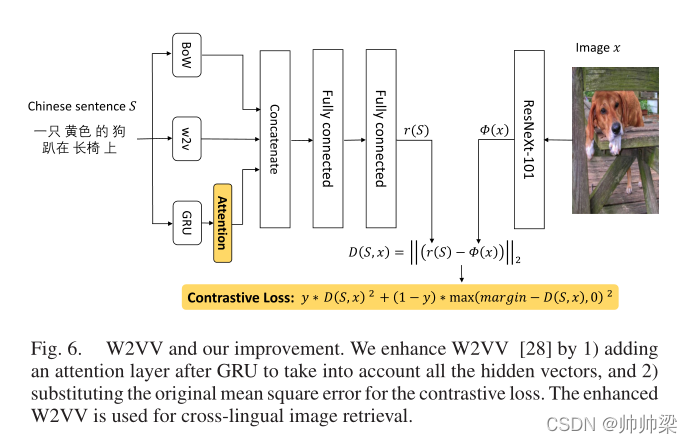

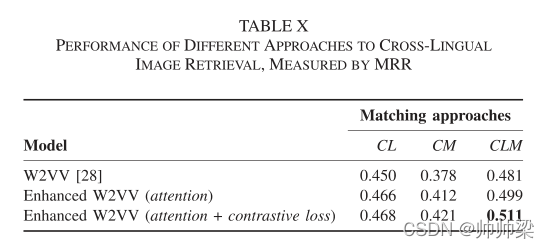

Retrieval models. : 我们看到了三种方法。中文查询和英文描述之间的跨语言(CL)匹配,忽略视觉内容。二、查询与图像之间的交叉模态(CM)匹配,忽略英文描述。第三,结合前两种方法的跨语言和模态(CLM)匹配。先前用于句子推荐的W2VV可以将给定的句子投影到一个视觉特征空间中。将不同语言的句子投射到相同的视觉特征空间可以实现跨语言和跨模态匹配。因此,我们采用W2VV作为统一的解决方案。

用三种策略并行向量化输入句子:词袋(BoW)、Word2V ec (w2v)和门控循环单元(GRU)网络,如图6所示。对于基于GRU的矢量化,W2VV在最后一个时间步使用了隐藏向量,现在我们知道它是过紧的,用来表示整个句子[15],[39]。以疑问句“”(三个装面条、蔬菜和水果的塑料饭盒)为例。虽然该查询需要多个对象共同存在,如(塑料午餐盒)、(面条)、(蔬菜)和(水果),但W2VV倾向于过分强调查询的结尾部分,即水果。此外,W2VV是使用均方误差(Mean Squared Error, MSE)进行训练的。不相关的图像和句子。基于这两个观察结果,我们对编码模块和W2VV的损耗进行了如下的增强。

方法是:1)在GRU后增加一个注意层来考虑所有的隐向量;

2)用原均方误差代替对比损失。增强的W2VV用于跨语言图像检索。

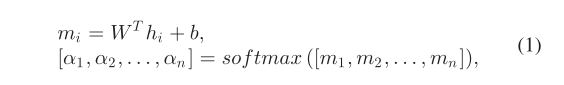

首先,我们通过引入软注意机制[39]来改进其GRU部分。如图6所示,将注意层置于GRU之后,将所有时间步长的隐向量相加,并为每个向量分配自适应权值。更正式地说,设hi为时间步长i的隐藏向量 ,i= 1,…,n是最大时间步长。

其次,为了利用许多负对,我们用MSE损失代替对比损失[40]。给定一个image和一个sentenceS,我们使用一个二元变量来表示它们的相关性,例如,y= 1如果它们是相关的,否则为0。新的损失是

最小化等式2意味着最小化(最大化)相关(负)对之间的距离

我们使用COCO-CN训练我们的中文模型,将给定的中文句子转换为ResNeXt-101功能。以类似的方式,我们的模型的英文版本使用来自同一训练集的图像进行训练,但使用MS-COCO句子。中文句子和英文句子之间的跨语言(CL)相似性计算为其ResNeXt-101特征之间的余弦相似性。同样,计算汉语句子和图像之间的跨模态(CM)相似性。

给出一个中文查询,根据其英文句子与该查询的CL相似性降序排列图像,实现跨语言匹配的图像检索。然后,通过交叉模态匹配进行图像检索,根据图像与查询的CM相似度降序排序。最后,对于跨语言和模态(CLM)匹配的图像检索,查询与给定图像之间的相似度计算为CL和CM相似度的凸组合。在验证集上优化组合权重。

Evaluation criterion : 对于每个查询,已知只有一个与查询相关的图像。因此,我们报告在相关项目被发现的Mean Reciprocal Rank(MRR)。更高的MRR意味着更好的性能

2) Results: 表X显示了不同方法的性能。增强的W2VV优于原W2VV,证明了在新环境下联合使用注意机制和对比损失的有效性。用CM进行图像检索比用CL进行图像检索效果差。采用CLM匹配获得最佳性能,MRR值最高,为0.511。这比原来的W2VV相对提高了6.2%

表十一给出了一些定性结果。增强型W2VV能够更好地对需要同时出现多个可视概念的相对复杂的查询进行建模。注意第二行中的异常,查询的结束部分,即红色环。(red ring),更重要。在这种情况下,W2VV的缺点是过分强调结尾部分。

基于跨语言和模态(clm)的图像检索增强w2vv与原始w2vv。括号内文本为英文翻译,供非中文读者阅读,不用于图像检索。虽然w2vv倾向于过分强调句子的结尾词,但通过注意力机制增强的w2vv可以更好地模拟整个句子

结论

COCO-CN的开发表明,我们的推荐辅助标注系统有助于减轻标注人员的工作量。特别是,54%的推荐标签被注释者接受。句子推荐也很有用,尽管不如标签推荐有效。

COCO-CN丰富了MS-COCO,不仅仅是在语言上。与80个MS-COCO对象类相比,有585个新概念。平均一个COCO-CN句子会带来45.3%的MS-COCO句子机器翻译未覆盖的关键词。虽然它的图像数量似乎很少,但它丰富的视觉内容与高质量的注释相关联,使该数据集优于Flickr8k-CN和AIC-ICC。NUS-WIDE是一个流行的多标签数据集,每个图像有81个标签和2.4个标签,与之相比,COCO-CN提供了655个标签,每个图像有4.4个标签。COCO-CN拥有丰富的双语标签和(不对齐的)双语句子,是社区独有的,为跨语言方向推进图像标注和检索提供了统一且具有挑战性的平台。

尽管测试集的基本事实是不完整的,但它足以得出关于哪个模型更适合跨语言图像标注的定性结论。级联MLP的表现优于单语言资源训练的MLP、双语言资源训练的多任务MLP和Clarifai(一个商业图像标记服务)。我们的顺序学习策略,虽然是一种常见的实践,因此在单语环境中并不新鲜,但它是第一个成功地将机器翻译和手工注释结合在一起的跨语言图像字幕的解决方案。增强的W2VV为跨语言图像检索建立了新的基线。COCO-CN提供了这些良好的基线方法,为未来跨语言多媒体任务的研究开辟了有趣的途径。

补充

图像特征的选择。如表十二所示,对于使用ResNeXt-101特性的所有三个任务模型,与使用GoogLeNet或ResNet-152特性的对应任务模型相比,表现最好。

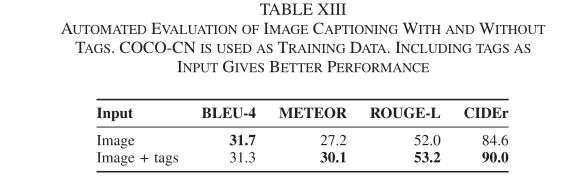

图像字幕与标签。正如我们在表二中总结的,COCO-CN的一个新特性是除了句子描述外,还对图像进行了标记注释。我们进行了一个额外的实验,称为带有标记的图像标题,以证明标记可以补充图像标题任务。之前在COCO-CN上训练的图像标题模型被重新用作基线。为了构造给定图像的多模态输入,我们用一个词袋(BoW)特征向量表示与该图像关联的标签。每个维度对应一个特定的标记,如果标记存在,则将其值设置为1,否则设置为0。多模态输入由ResNeXt-101特征和BoW特征连接而成。如表13所示,带有标签的图像标题性能更好。