文章目录

1. DeepSeek-R1全版本及硬件要求

| 模型版本 | 内存需求 | 显存需求 | 适用场景 |

|---|---|---|---|

| 1.5B | ≥8GB | 无需独立显卡 | 低配设备,仅支持文本基础问答, 例如办公电脑 |

| 7B/8B | ≥16GB | ≥8GB(推荐NVIDIA 3060+) | 主流配置,支持代码生成/复杂推理, 例如办公室专用主机 |

| 14B | ≥32GB | ≥16GB(推荐NVIDIA 4090) | 高性能需求,支持长文本/多轮对话, 例如小企业专用服务器 |

| 32B/70B/671B | ≥64GB | ≥24GB专业显卡 | 企业级服务器,需专业运维, 例如大公司专用服务器 |

2. 安装Ollama

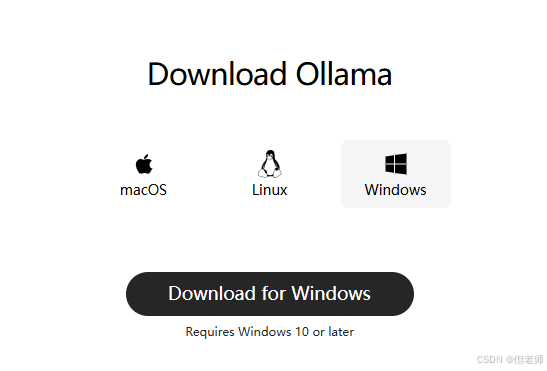

2.1 官方下载(不推荐)

访问Ollama官网 -> 点击 Download for Windows(745MB,支持Win10/11 64位) -> 双击安装包安装

2.2 国内镜像加速(推荐)

2.3 验证安装

# 以管理员身份打开PowerShell

ollama --version

# 显示类似"ollama version 0.5.7"即成功

如果没安装成功会显示如下

# 以管理员身份打开PowerShell

ollama --version

'ollama' 不是内部或外部命令,也不是可运行的程序或批处理文件。

3. DeepSeek模型部署

3.1 拉取模型

根据硬件配置选择版本:

ollama run deepseek-r1:1.5b

首次运行会自动下载模型(约1.1G), 若下载中断可重新执行命令(支持断点续传)

3.2 测试运行

在交互界面输入测试指令:

>>> 用Python实现快速排序

若模型返回完整代码即部署成功

注意, 模型安装好最开始是使用cmd界面运行的, 非常丑陋, 所以我们需要部署可视化.

4. Open WebUI可视化部署

说明: Open WebUI是基于Python的, 所以只需要在Python环境下安装包即可

4.1 安装包

pip install open-webui -i https://mirrors.aliyun.com/pypi/simple/

4.2 启动服务

open-webui serve

4.3 访问界面

浏览器打开 http://localhost:8080,完成以下配置:

- 注册管理员账号

- 进入 Settings → Model,确认模型路径为

deepseek-r1:7b - 开始对话

5. 结论

本地部署DeepSeek适合对数据隐私、高频调用、离线能力或深度定制有强需求的场景,尤其推荐金融、医疗、科研机构及技术实力较强的企业采用。

而中小型企业或轻量级需求者,云端服务仍是更经济便捷的选择

6. 实际参数参考

6.1 我的电脑配置

办公电脑, CPU和显卡都是很差的那种

6.2 我的版本选择

deepseek-r1:1.5b

- 为什么选择最低配版本?

:因为7b我都带不动

6.3 实际运行效果

- 卡不卡

极度卡顿, 只要有任何一个人问问题, 我的CPU立马爆满, 回答速度也非常慢, 经常卡顿十几分钟

- 无法联网问题

该问题可以通过使用ChatBox解决, 因为它已经配置好了

但是如果你安装的是Open WebUI, 那将会变成一个非常棘手的问题, 因为你需要另外再配置一套搜索服务, 搞不好还得花钱

- 同事如何使用

如果你部署的是Open WebUI, 那么你同事直接打开浏览器, 输入地址就可以访问, 而且界面还挺好看很专业

如果你选择了ChatBox, 那你同事也需要安装ChatBox来使用了