非常重要的一个并发集合-ConcurrentHashMap

上一篇看这里:JAVA并发编程-5-AQS的实现原理

一、线程安全的Map

HashMap多线程情况下会导致HashMap的Entry链表形成环形数据结构,一旦形成环形数据结构,Entry的next节点永远不为空,就会产生死循环获取Entry。

HashTable使用synchronized来保证线程安全,但在线程竞争激烈的情况下HashTable的效率非常低下。因为当一个线程访问HashTable的同步方法,其他线程也访问HashTable的同步方法时,会进入阻塞或轮询状态。如线程1使用put进行元素添加,线程2不但不能使用put方法添加元素,也不能使用get方法来获取元素,所以竞争越激烈效率越低。

而ConcurrentHashMap在保证线程安全的前提下使用分段锁的思想进一步提高了效率。

二、jdk1.7中的实现

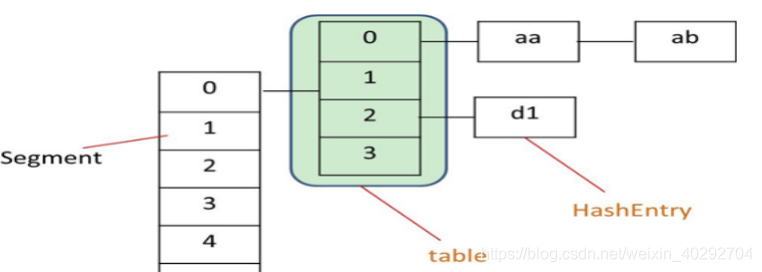

1、数据结构

ConcurrentHashMap是由Segment数组结构和HashEntry数组结构组成。Segment实际继承自可重入锁(ReentrantLock),在ConcurrentHashMap里扮演锁的角色;HashEntry则用于存储键值对数据。一个ConcurrentHashMap里包含一个Segment数组,每个Segment里包含一个HashEntry数组,我们称之为table,每个HashEntry是一个链表结构的元素。

ConcurrentHashMap允许多个修改操作并发进行,其关键在于使用了锁分离技术。它使用了多个锁来控制对hash表的不同部分进行的修改。内部使用段(Segment)来表示这些不同的部分,每个段其实就是一个小的hash table,只要多个修改操作发生在不同的段上,它们就可以并发进行。##

2、初始化过程

初始化有三个参数:

- initialCapacity:初始容量大小 ,默认16

- loadFactor:扩容因子,默认0.75,当一个Segment存储的元素数量大于initialCapacity* loadFactor时,该Segment会进行一次扩容。

- concurrencyLevel: 并发度,默认16。并发度可以理解为程序运行时能够同时更新ConccurentHashMap且不产生锁竞争的最大线程数,实际上就是ConcurrentHashMap中的分段锁个数,即Segment[]的数组长度。如果并发度设置的过小,会带来严重的锁竞争问题;如果并发度设置的过大,原本位于同一个Segment内的访问会扩散到不同的Segment中,CPU cache命中率会下降,从而引起程序性能下降。

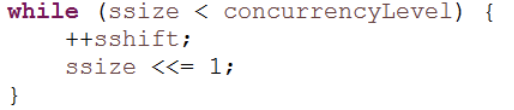

来看一下初始化过程中重要的几段代码:

1、

通过位运算保证Segment数组的大小,一定为2的幂,例如用户设置并发度为17,则实际Segment数组大小则为32

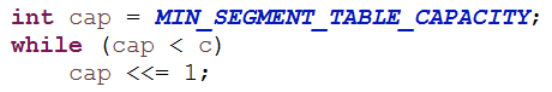

2、

保证每个Segment中tabel数组的大小,一定为2的幂,初始化的三个参数取默认值时,table数组大小为2

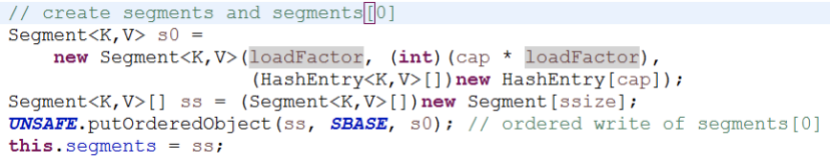

3、

初始化Segment数组,并实际只填充Segment数组的第0个元素。

4、

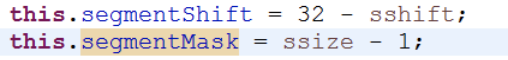

用于定位元素所在segment。segmentShift表示偏移位数,我们知道int类型的数字在变大的过程中,低位总是比高位先填满的,为保证元素在segment级别分布的尽量均匀,计算元素所在segment时,总是取hash值的高位进行计算。segmentMask作用就是为了利用位运算中取模的操作: a % (Math.pow(2,n)) 等价于 a&( Math.pow(2,n)-1)

2、快速定位元素

对于某个元素而言,一定是放在某个segment元素的某个table元素中的:

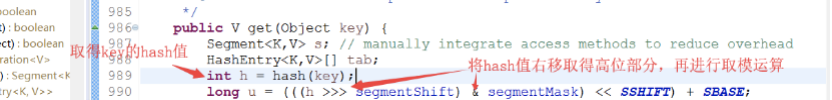

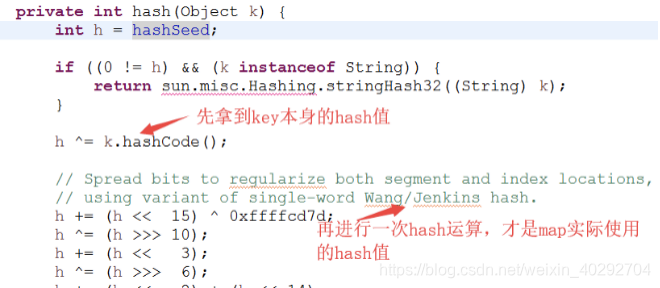

定位segment:取得key的hashcode值进行一次再散列(通过Wang/Jenkins算法),拿到再散列值后,以再散列值的高位进行取模得到当前元素在哪个segment上。

**定位table:**同样是取得key的再散列值以后,用再散列值的全部和table的长度进行取模,得到当前元素在table的哪个元素上。

3、get()方法

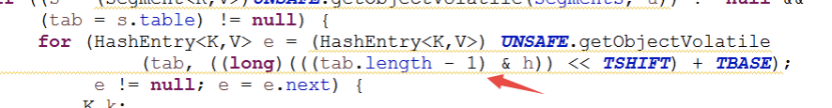

定位segment和定位table后,依次扫描这个table元素下的的链表,要么找到元素,要么返回null。

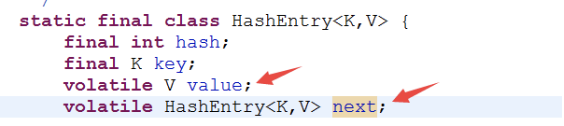

用于存储键值对数据的HashEntry,在设计上它的成员变量value等都是volatile类型的,这样就保证别的线程对value值的修改,get方法可以马上看到。

4、put()方法

1、首先定位segment,当这个segment在map初始化后,还为null,由ensureSegment方法负责填充这个segment。

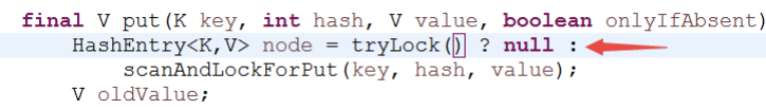

2、对Segment 加锁

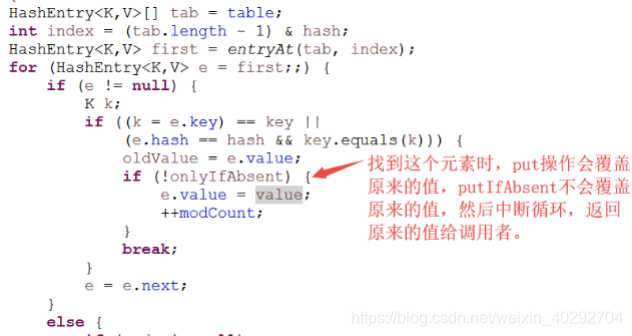

3、定位所在的table元素,并扫描table下的链表,找到时:

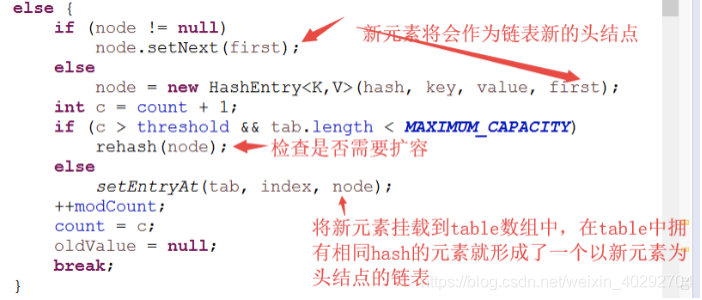

没有找到时:

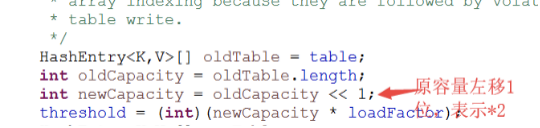

5、扩容操作

Segment 不扩容,扩容下面的table数组,每次都是将数组翻倍。

将数组size翻倍带来的好处是可以快速定位和减少重排次数。大家可以自己分析下。

6、size()方法

size的时候进行两次不加锁的统计,两次一致直接返回结果,不一致,重新加锁再次统计

7、弱一致性

get方法和containsKey方法都是通过对链表遍历判断是否存在key相同的节点以及获得该节点的value。但由于遍历过程中其他线程可能对链表结构做了调整,因此get和containsKey返回的可能是过时的数据,这一点是ConcurrentHashMap在弱一致性上的体现。

三、jdk1.8中的实现

1、与1.7相比的重大变化

1、取消了segment数组,直接用table保存数据,锁的粒度更小,减少并发冲突的概率。

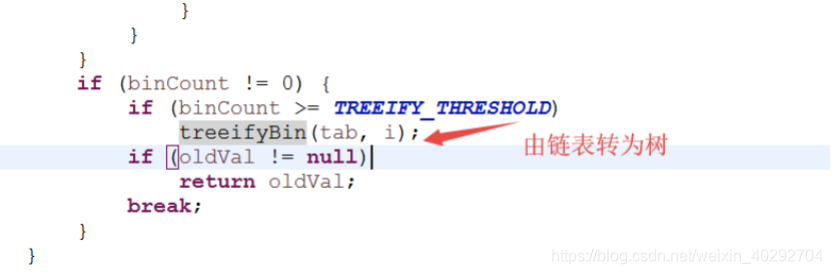

2、存储数据时采用了链表+红黑树的形式,纯链表的形式时间复杂度为O(n),红黑树则为O(logn),性能提升很大。什么时候链表转红黑树?当key值相等的元素形成的链表中元素个数超过8个的时候。

2、数据结构和关键变量

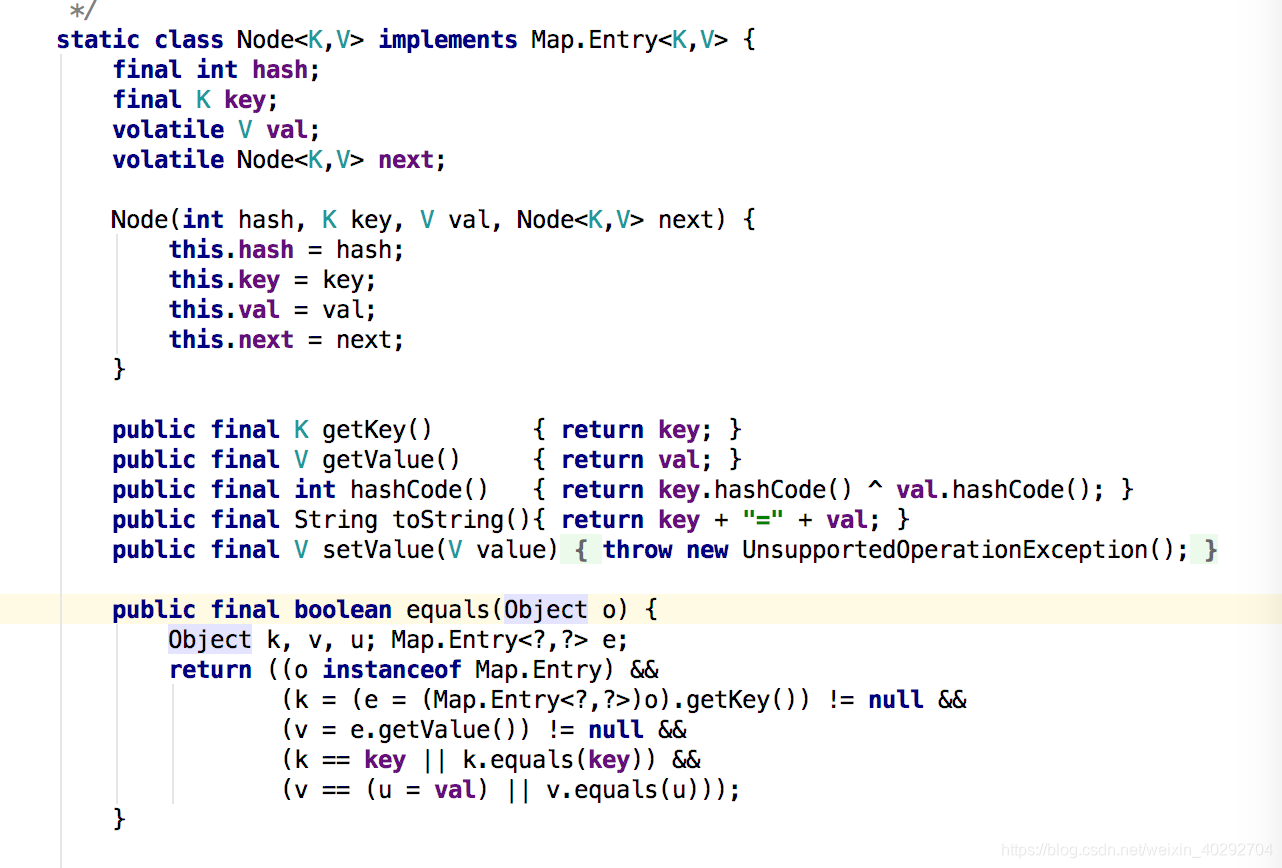

1、Node类存放实际的key和value值。

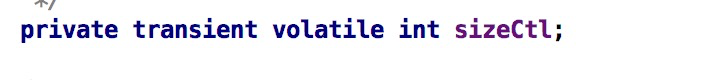

2、变量sizeCtl:

2、变量sizeCtl:

负数:表示进行初始化或者扩容,-1表示正在初始化,-N,表示有N-1个线程正在进行扩容

正数:0 表示还没有被初始化,>0的数,初始化或者是下一次进行扩容的阈值

3、TreeNode 用在红黑树,表示树的节点, TreeBin是实际放在table数组中的,代表了这个红黑树的根。

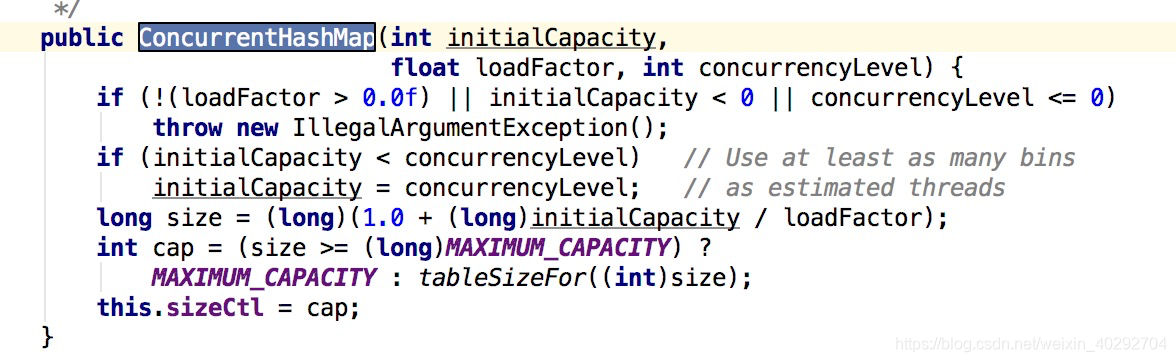

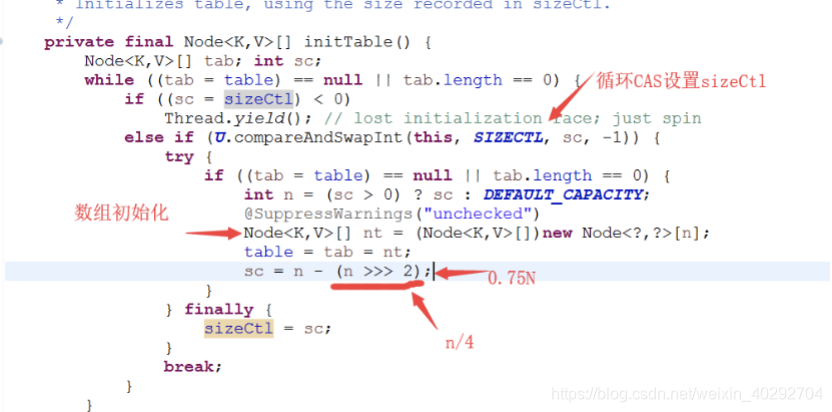

3、初始化

只是给成员变量赋值,put时进行实际数组的填充

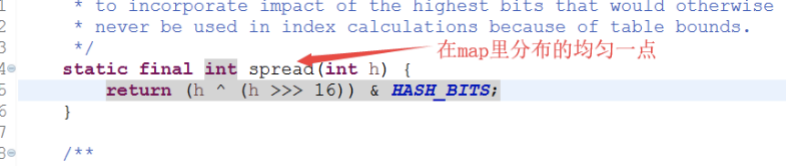

4、快速定位元素

通过2次散列来快速定位元素:

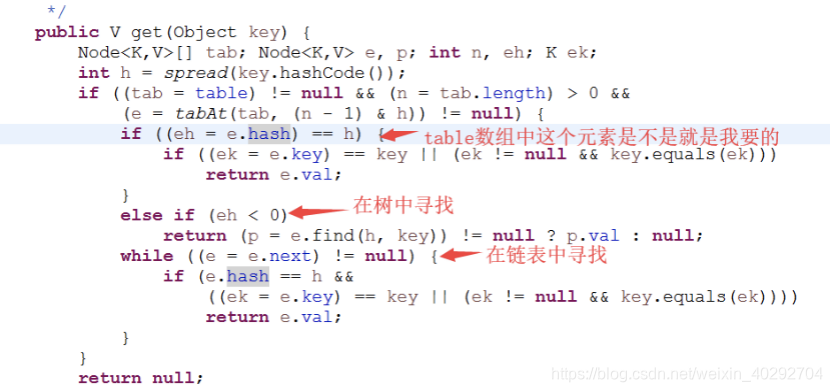

5、get()方法

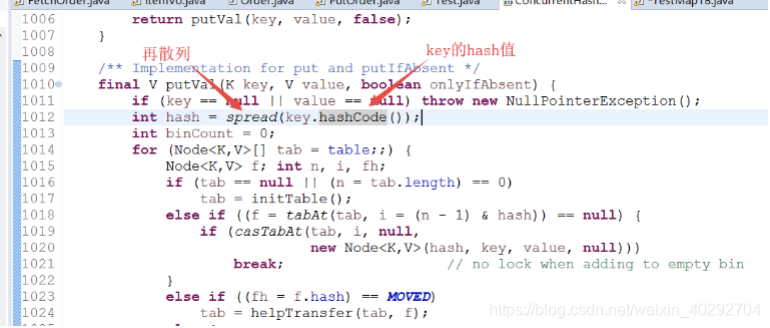

6、put()方法

数组的实际初始化:

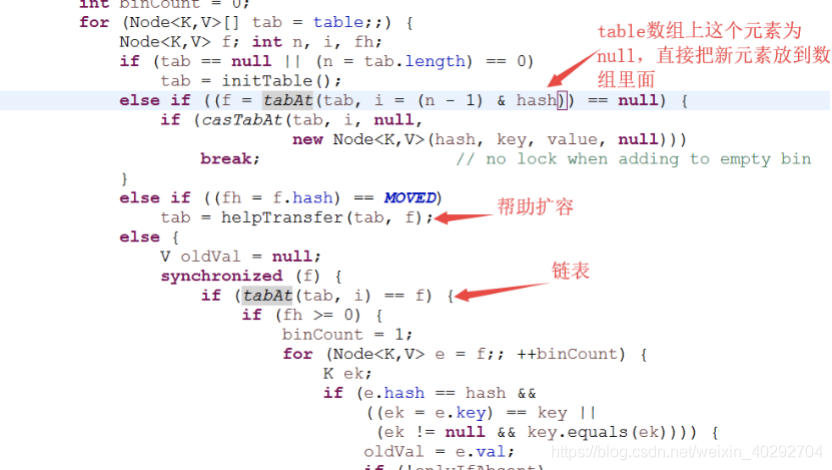

put过程:

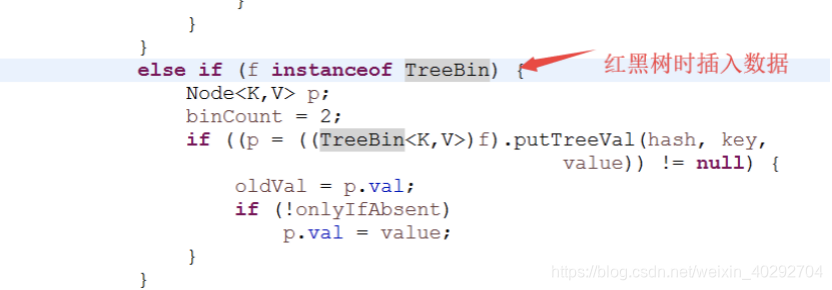

红黑树时插入数据:

由链表变为红黑树:

7、扩容方法

transfer()方法进行实际的扩容操作,table大小也是翻倍的形式。另外有一个并发扩容的机制,上面代码也可以看到,当put的线程发现当前对象正在扩容时,会去帮助扩容。

8、size()方法和弱一致性

size()方法调用了sumCount

final long sumCount() {

CounterCell[] as = counterCells; CounterCell a;

long sum = baseCount;

if (as != null) {

for (int i = 0; i < as.length; ++i) {

if ((a = as[i]) != null)

sum += a.value;

}

}

return sum;

}

这其中的baseCount是在put过程中进行的累加, CounterCell[] as是还没有来得及进行累加的数量。

由于弱一致性,并发情况下,as数组循环结束又有线程put值,所以估计的是大概数量,不是精确数量。

jdk1.8中的ConcurrentHashMap也表现为弱一致性。

下一篇:JAVA并发编程-7-并发容器