视觉 SLAM 基本介绍

SLAM 是同步定位与地图构建 (Simultaneous Localization And Mapping) 的缩写,最早由 Hugh Durrant-Whyte 和 John J.Leonard 提出。SLAM 主要用于解决移动机器人在未知环境中运行时定位导航与地图构建的问题。视觉 SLAM 是指以视觉传感器为主的 SLAM 技术,也是最常见的一种 SLAM 技术。

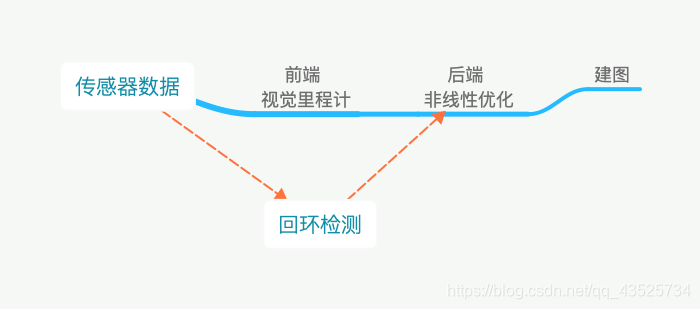

视觉 SLAM 的路程分成以下几步:

1、读取传感器信息。

2、视觉里程计(VO)

估算相邻图像之间相机的运动,以及局部地图。

3、后端优化(Optimization)

后端接受不同时刻视觉里程计测量的相机位姿,以及回环检测的信息。

4、回环检测(Loop Closure)

回环检测判断机器人是否或者曾经到达过先前的位置。如果检测到回环,它会把信息提供给后端进行处理。

5、建图(Mapping),根据估计出的轨迹建立与任务要求的对应的地图。

简单来说,视觉 SLAM 框架包括前台跟踪(Tracking)和后台建图(Mapping)线程:前台根据传感器输入的数据,实时地跟踪和估计相机的位姿,后台则对地图进行局部或全局的优化,并进行回环检测,消除误差累积。系统实时地输出每个时刻设备的位姿和三维地图。

视觉 SLAM 的传感器主要是摄像机,分为单目摄像机、双目摄像机和多目摄像机。广义上的视觉 SLAM 是指以视觉传感器为主、其它传感器(例如 IMU 、GPS 、深度摄像机等)为辅的技术。相比于其它技术(如结构光、TOF 相比),不受光照、复杂背景等环境因素影响,成本低、小尺度场景下定位精度高、无需提前布置场景。

视觉 SLAM 典型应用

太空探测

SLAM 实际上是一个典型的军转民用的技术,2003 年发射的美国“机遇号”与“勇气号”火星探测车,以及 2011 年发射的“好奇号”火星车均配备了双目立体导航相机,通过序列图像视觉测程方法修正了航迹推算方法的定位误差,并为探测车提供了安全避障与路径规划所需的基础地图结果,在探测车穿越崎岖困难区域时提供了高精度定位与制图结果。

室内定位导航

目前的室内定位主要是通过在室内中布设 WiFi 或蓝牙基站,依据接收机接收的多基站无线信号的强度分布来估计当前的室内位置。但目前而言,实现精度不高,存在后续维护等问题,比如 WiFi 的定位精度在 5 米左右,对室内来说不够用,信号强度还受到室内环境变化的影响。相比无线信号,室内视觉图像信息丰富、直观,在无线信号无法覆盖的区域,视觉 SLAM 能够进行自主定位导航,不受外部基站布设限制,具备更强的环境适用性。苹果曾申请的室内导航专利中显示:“可以通过很多方法收集定位信息——包括 GPS 、加速器、计步器等。”不难联想到其中可能使用了惯性导航技术,早在 2016 年,苹果收购了 AR 增强现实初创企业 Flyby Media ,获得了“基于视觉基础的惯性导航”的专利。

无人机

无人机具有小型化,可远距离操作等优点,广泛应用于城市救灾、森林防火、地理勘测等场景。红外或激光测距是目前应用最为广泛的无人机探测技术,但是由于它在逆光时会受到强太阳光的干扰,用于自动避障的功能并不是很合适;而双目视觉则不会收到太大的外界干扰,视觉 SLAM 技术的迅速发展又为飞行器的自主导航提供了新的技术支撑,采用「双目+结构光+惯导」方案的小觅双目摄像头搭载在无人机上,利用视觉 SLAM 技术,可实现无人机的空中避障与路径自主规划,使无人机在室内外,黑暗环境中都可以作业,大大提升了无人机在复杂环境下的生存与自主作业能力。

视觉 SLAM 发展趋势

多传感器融合

单一传感器都有它的优缺点,不能适用所有的场景,比如视觉传感器在大多数纹理丰富的场景中效果很好,但遇上纹理较少的物体基本不可行,而通过多个传感器的融合可以达到理想的定位效果。所以最好的方法是将多种传感器数据融合起来,进行优势互补,从而实现一个低成本、高稳定性的 SLAM 解决方案。

随着万物互联的物联网时代的到来,AI 面临着全新的发展机遇,视觉 SLAM 作为计算机视觉领域的关键技术,将拥有更为广阔的行业前景,未来会在机器人自主导航、无人机等领域发挥重要的作用,为各个行业应用场景中提升效能。