目录

主页:晴天

进度:第四部分【机器学习算法】

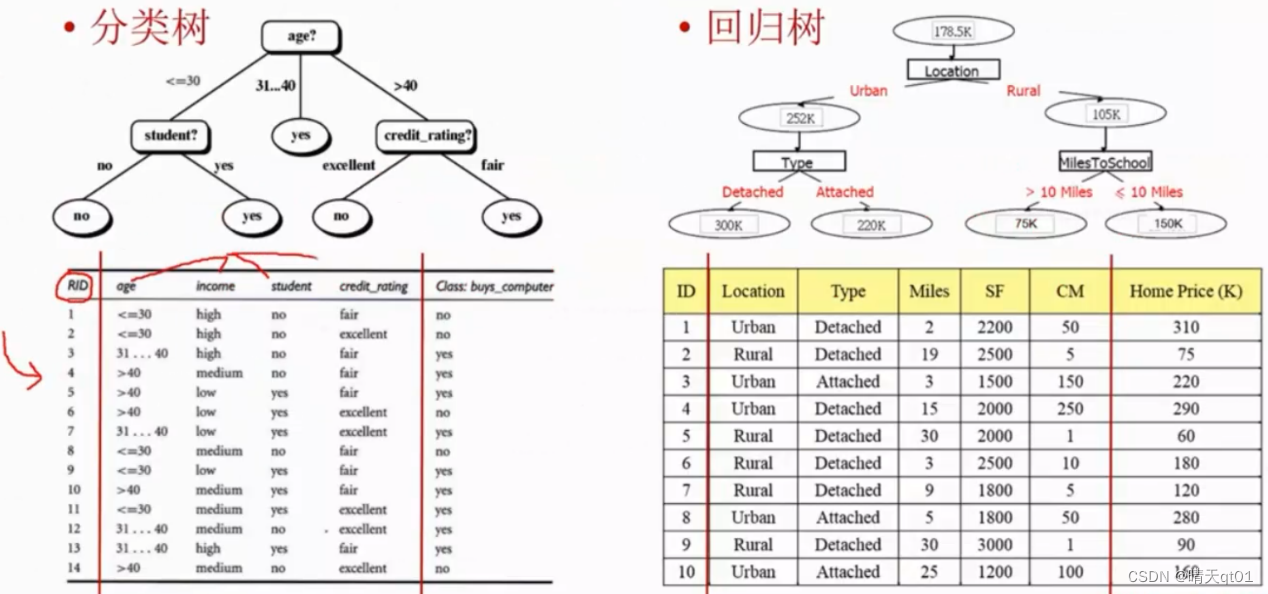

决策树(分类树及回归树)分类树和回归树的基本原理:

分类树与回归树简介

结果字段来看,分类树必须是类别型的字段。回归树则是数值型的字段

他们的形态很像。建构的过程也很类似,只不过目标不同。

分类树一般能得到比较精准的结果,而且解读性比较高。

分类树一般有C5.0,CART,CHAID,etc

其中C5.0是由ID3进化而来

ID3-C4.5-C5.0

J.RQuinlan它不断的修正,然后得到C4.5,才可以套用到企业的商业模式中去。1993推出了一本书(C4.5,Programma for machine Learning)

C5.0就变成了一个商业的软件,现在好像是开源了。这个算法非常重要。

CART的算法也非常重要

决策树这些都由上往下产生的分类树和回归树。

建立树的步骤

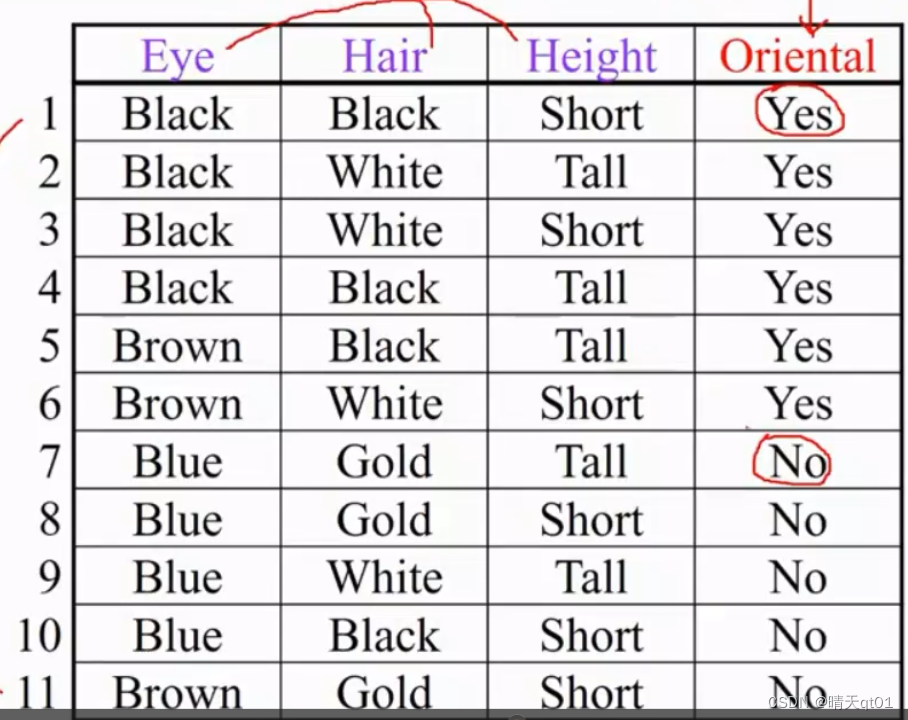

案例说明:

首先,我们要建立分类树,要把所有的训练数据集合放入根节点。

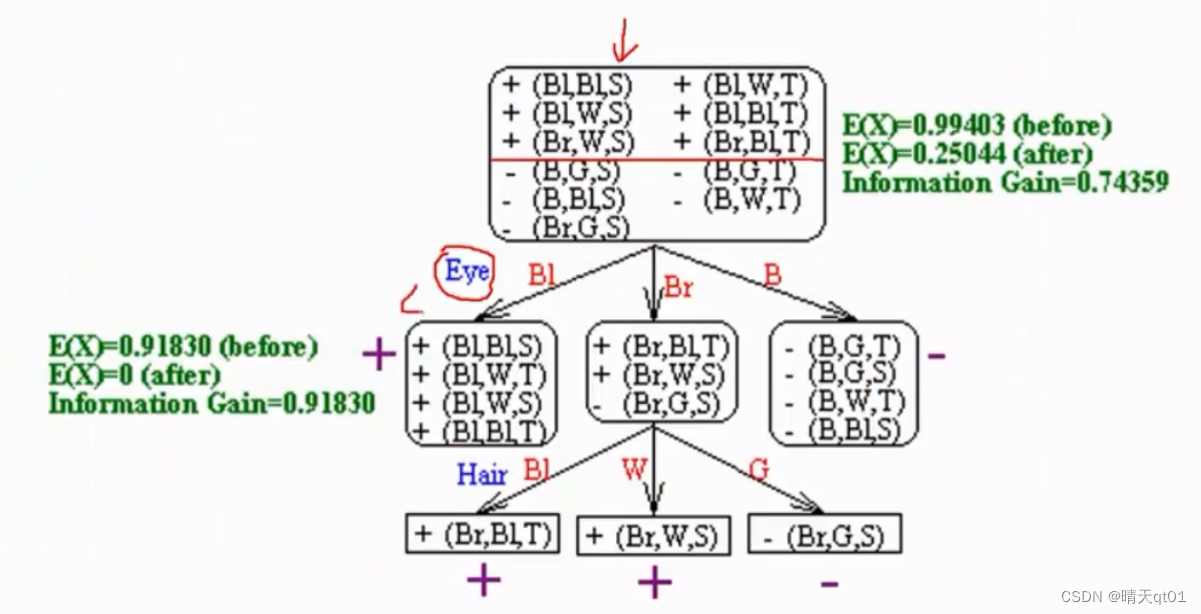

第二步,我们要切割我们的数据集,根据我们选定的字段进行切割。第一笔分类树用眼睛颜色进行切割。我们同样也可以通过身高进行切割,那么我们应该选择哪个字段呢。

第三步,我们希望分类正确率最高。

希望大多的训练范例属于单一类别。

基本原理如下

比如,我们在根节点就进行预测,那么我们的正确率最高只能达到6/11,错误率是5/11

如果我们利用眼睛颜色,我们发现我们两个部分错误率是0中间的部分错误率是1/11.整体误差。眼睛这个信息程度对我们的重要性。帮我们解决了4/11

如果我们利用眼睛颜色,我们最少一共会猜错5/11,所以身高这个信息,对我们几乎没有帮助,不如眼睛这个信息程度。

分类树的切割方法是递回的切割方法,如果没法做到百分之百,就要继续切割。

第四步,剪枝。避免你的分类树,过拟合你的数据Tree Pruning(Overfitting Problem)这个步骤,是为了让你的数据不至于在训练数据时准确率很高,但是测试数据准确率却很低。

就像这个决策树,在眼睛为第一字段进行分类时,只有一笔会出现错误,但是因为这一笔错误,我们要再次拿一个字段进行切割。其实它是没有说服力的

就好像AB两种产品,我去问了一个路人,路人说A好喝。我们就说百分百都喜欢A

所以这个决策树虽然准确率达到百分百了,但是其实只是测试集准确率。我们就可以吧用头发作为字段切割这个分支可以剪掉,当然问卷量够多就不用剪掉。

而且你无法保证你的数据都是正确的,可能会有很多噪音在里面(noise)所以我们不要求训练集数全对。要求测试集准确率高才是我们的目标。

这里只是我们的案例,使用用准确率作为决策指标,其实ID3和C4.5,C5.0是用的其他公式来筛选字段。这个部分下次在和大家讲。

决策树后续内容

ID3分类树算法

-ID3的字段选择方法、ID3算法的一些问题。

不考虑剪枝。

C4.5分类树算法

-C4.5的字段选择方法,C4.5的数值型字段处理方式、C4.5的剪枝(避免过拟合)作法

CART分类树算法

-CART分类树的字段选择方法、CART分类树的剪枝作法。

CHAID分类树算法

-CHAID的字段选择方式

Cart字段回归树算法

CART回归树的字段选择方式、如何利用模型树来提升CART回归树的效能

PRISM决策规则算法

如何使用分类树来进行分类预测、分类树与分类规则间的关系

PRISM决策规则的产生方式。