什么是word2vec ?

Word2vec,是为一群用来产生词向量的相关模型。

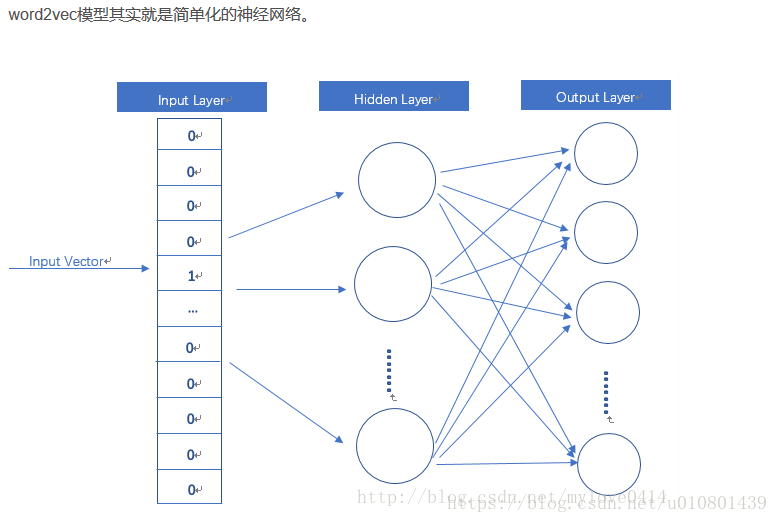

这些模型为浅而双层的神经网络,用来训练以重新建构语言学之词文本。网络以词表现,并且需猜测相邻位置的输入词,在word2vec中词袋模型假设下,词的顺序是不重要的。训练完成之后,word2vec模型可用来映射每个词到一个向量,可用来表示词对词之间的关系,该向量为神经网络之隐藏层。

word2vec的作用是什么?

word2vec也叫word embeddings,中文名“词向量”。

作用就是将自然语言中的字词转为计算机可以理解的稠密向量(Dense Vector)在word2vec出现之前,自然语言处理经常把字词转为离散的单独的符号,也就是One-Hot Encoder(独热编码)。

word2vec的是怎么个工作模式?

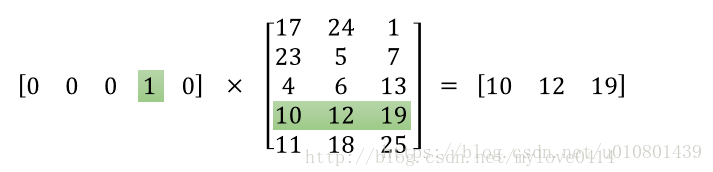

输入是One-Hot Vector,Hidden Layer没有激活函数,也就是线性的单元。Output Layer维度跟Input Layer的维度一样,用的是Softmax回归。我们要获取的dense vector其实就是Hidden Layer的输出单元。有的地方定为Input Layer和Hidden Layer之间的权重,其实说的是一回事。